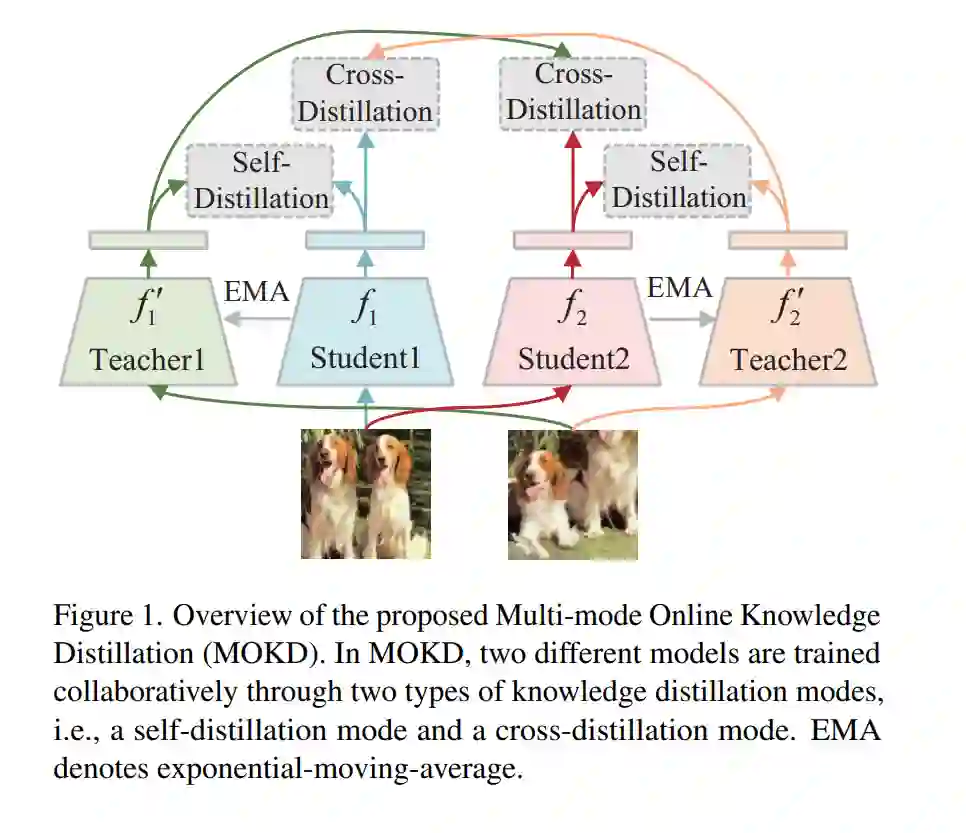

自监督学习(SSL)在视觉表示学习方面取得了显著进展。一些研究将SSL与知识蒸馏(SSL- KD)相结合,以提高小型模型的表示学习性能。本文提出一种多模态在线知识蒸馏方法(MOKD)来增强自监督视觉表示学习。与现有的SSL-KD方法将知识从静态的预训练教师迁移到学生不同,在MOKD中,两个不同的模型以自监督方式进行协作学习。具体而言,MOKD由两种蒸馏模式组成:自蒸馏模式和交叉蒸馏模式。其中,自蒸馏独立地对每个模型进行自监督学习,而交叉蒸馏实现不同模型之间的知识交互。在交叉蒸馏中,提出一种交叉注意力特征搜索策略,以增强不同模型之间的语义特征对齐。因此,两个模型可以相互吸收知识以提高其表示学习性能。在不同的主干和数据集上的广泛实验结果表明,两个异构模型可以从MOKD中受益,并优于其独立训练的基线。此外,MOKD也优于现有的SSL-KD方法在学生模型和教师模型。

https://www.zhuanzhi.ai/paper/6589b817e4f5f6365ba27bc85aac2ae4

成为VIP会员查看完整内容

相关内容

CVPR 2023大会将于 6 月 18 日至 22 日在温哥华会议中心举行。CVPR是IEEE Conference on Computer Vision and Pattern Recognition的缩写,即IEEE国际计算机视觉与模式识别会议。该会议是由IEEE举办的计算机视觉和模式识别领域的顶级会议,会议的主要内容是计算机视觉与模式识别技术。

CVPR 2023 共收到 9155 份提交,比去年增加了 12%,创下新纪录,今年接收了 2360 篇论文,接收率为 25.78%。作为对比,去年有 8100 多篇有效投稿,大会接收了 2067 篇,接收率为 25%。

Arxiv

26+阅读 · 2020年12月29日