转载机器之心报道 编辑:Panda、蛋酱

近日,一篇关于自动化 AI 研究的论文引爆了社交网络,原因是该论文得出了一个让很多人都倍感惊讶的结论:LLM 生成的想法比专家级人类研究者给出的想法更加新颖!

我们都知道通过调节 LLM 的温度值确实可以调整它们的随机性和创造性,但在科学研究方面比人类还懂创新?这还是超乎了很多人的想象 —— 至少很多人没想到这会来得这么快。难道 AI 科学家真的要来了?

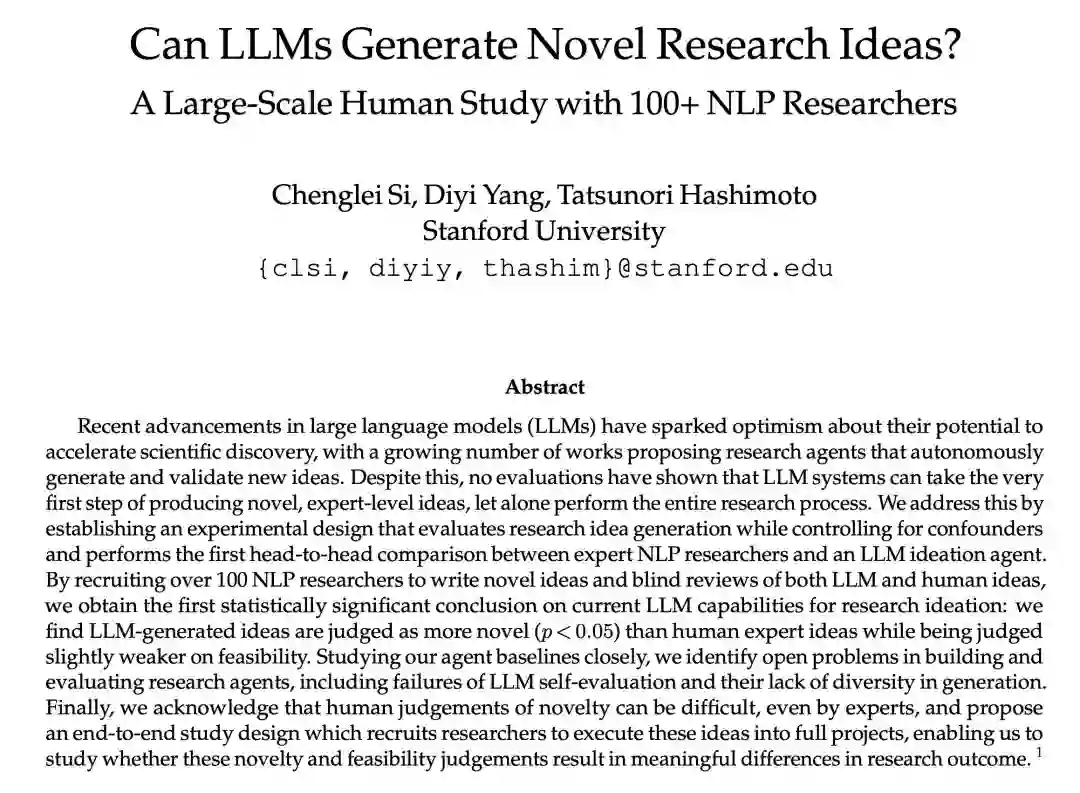

那么,这项来自斯坦福大学的研究究竟得出了什么样的结论呢?

论文地址:https://arxiv.org/abs/2409.04109 * 调查链接:https://tinyurl.com/execution-study * 项目地址:https://github.com/NoviScl/AI-Researcher

LLM 能生成新颖的研究思路吗?

为了准确地对比 LLM 与人类在科研思路创新方面的能力,斯坦福大学的这个研究团队招募了 104 位 NLP 研究者,让其中 49 位写下创新研究想法,然后再让 79 位专家对 LLM 和人类给出的思路进行盲测。请注意,其中有 24 位人类专家既写了想法,也参与了盲测,当然他们并不评估自己写的内容。

模型(或者按该团队的说法:思路生成智能体)方面,该团队使用了 claude-3-5-sonnet-20240620 作为骨干模型。具体来说,给定一个研究主题(比如:可以提升 LLM 事实性并降低其幻觉的提示方法),让 LLM 生成一系列对 Semantic Scholar API 的函数调用。这个论文检索动作空间包括 {KeywordQuery (keywords), PaperQuery (paperId), GetReferences (paperId)} 。每个动作生成都基于之前的动作和已执行的结果。

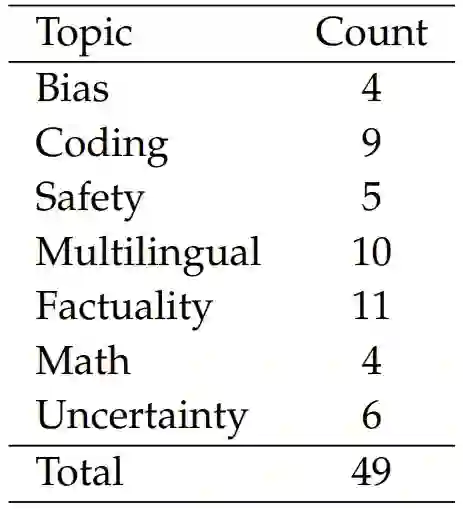

该研究使用的研究主题有 7 个:偏见、编程、安全性、多语言、事实性、数学和不确定性。下表是各个主题的想法数量:

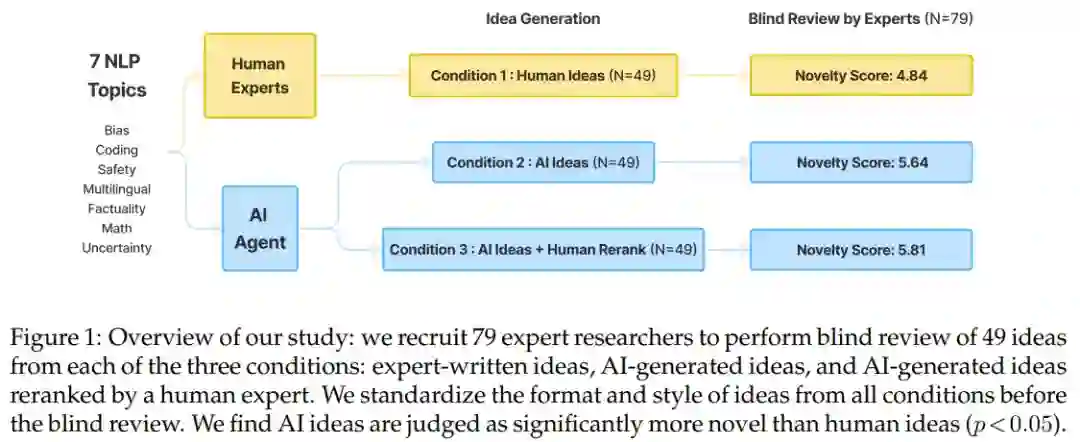

研究过程如下图所示:

这里我们不细说其详细的设置和评估过程,详见原论文。总结起来就是比较人类专家与 AI 智能体生成的科研思路的新颖程度。我们直接来看结论。

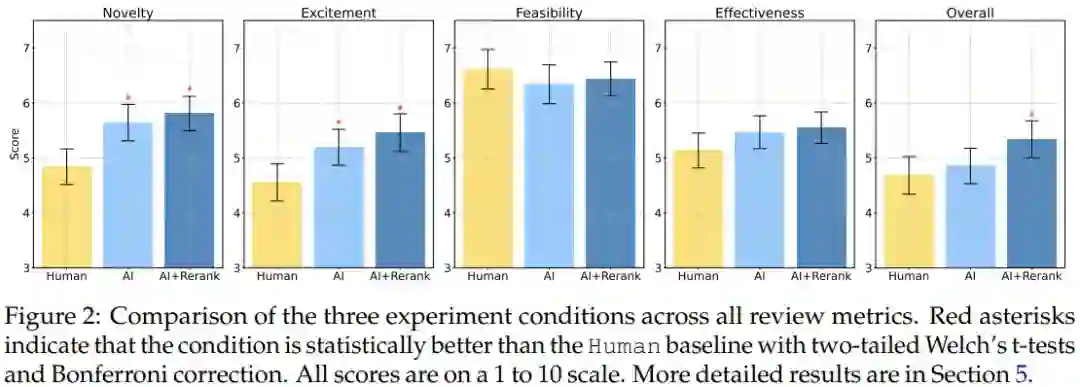

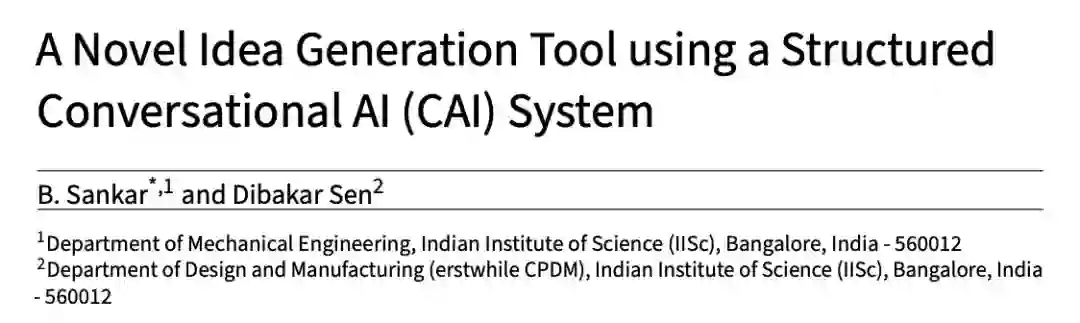

根据该团队思路评分(Idea Ranking)规则,他们对人类和 AI 提出科研思路进行了打分,见图 2 和表 7:

其中 Human Ideas 是指招募的专家研究者提出的思路,而 AI Ideas 则是 LLM 智能体给出的排名第一的思路。AI Ideas + Human Rerank 是指由 AI 生成思路但由本研究一作 Chenglei Si 手动从排名靠前的思路中选择他认为最好的一个。

可以看到,在新颖度方面,不管是 AI Ideas 还是 AI+Rerank,都显著优于 Human Ideas(p < 0.01)。在激动人心(excitement)分数上,AI 生成的思路的优势更是明显(p<0.05)。并且 AI Ideas + Human Rerank 的整体分数也优于人类(p<0.05)。不过 AI 生成的思路在另外两方面(可行性和有效性)与人类的差别不大。

当然,我们也能看出,这项调查研究有一些明显的局限,比如其调查范围较小,样本量太少了,评价很主观。另外作者也指出人类研究者可能会「藏私」,可能并不会分享自己的最佳想法。

不管怎样,这项研究证明了一点:让 AI 参与到科学研究中多半是有利的。尤其是当你灵感枯竭、思维阻塞时,问一问 LLM 或许就能有意想不到的收获。

生成创新想法的 AI 工具,正在不断涌现

实际上,已经有研究团队在打造专用于此类任务的 AI 工具了。比如近日一位专注于开发 LLM 应用的研究者 Shubham Saboo 就在社交网络分享了使用 Cursor 构建一个多智能体 AI 研究者的过程。他表示整个过程用时不到 5 分钟!参见如下视频:

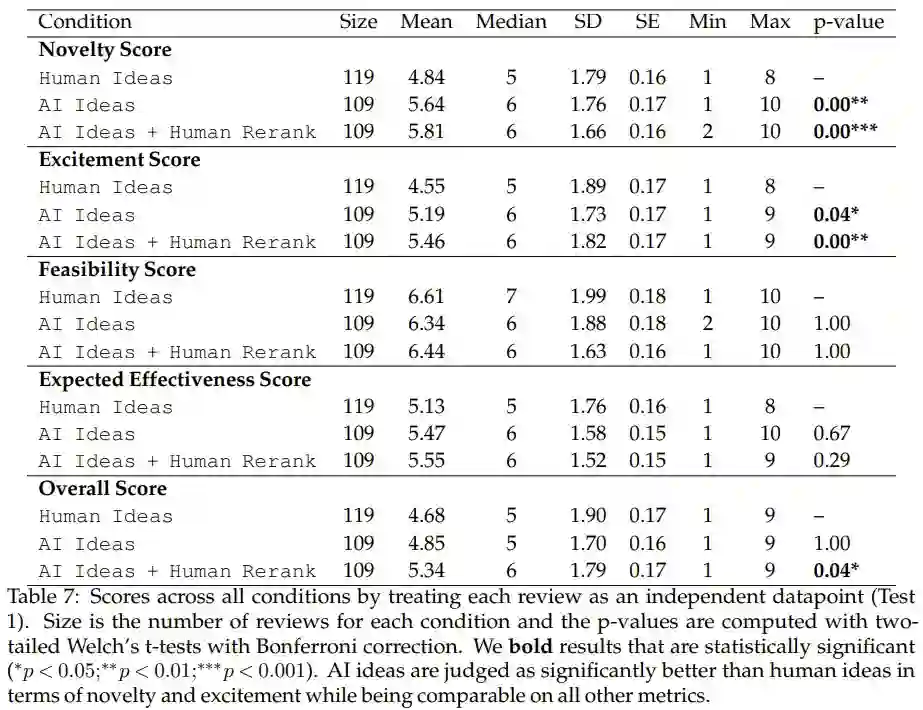

也有人分享了自己的一项相关研究,表示可以使用 LLM 和因果图谱自动生成心理学假设,并生成比 GPT-4 和博士生表现都好:

近日,印度科学学院(Indian Institute of Science,IISc)的研究者发现,AI 在设计创意方面也比人类更有想法。具体来说,AI 可通过一种新的人工智能会话式「主动构思」(Active Ideation)界面来生成新创意。作为一种创意构思生成工具,它可帮助新手设计师缓解一部分的初始延迟和构思瓶颈。

论文标题:A Novel Idea Generation Tool using a Structured Conversational AI (CAI) System * 论文地址:https://arxiv.org/pdf/2409.05747

具体来说,这是一种动态、交互、上下文响应式方法,通过大型语言模型(LLM)主动参与,为不同的设计问题生成多个潜在创意陈述。论文称之为「主动构思场景」,它有助于促进基于对话的持续互动、对上下文敏感的对话以及多产的构思生成。

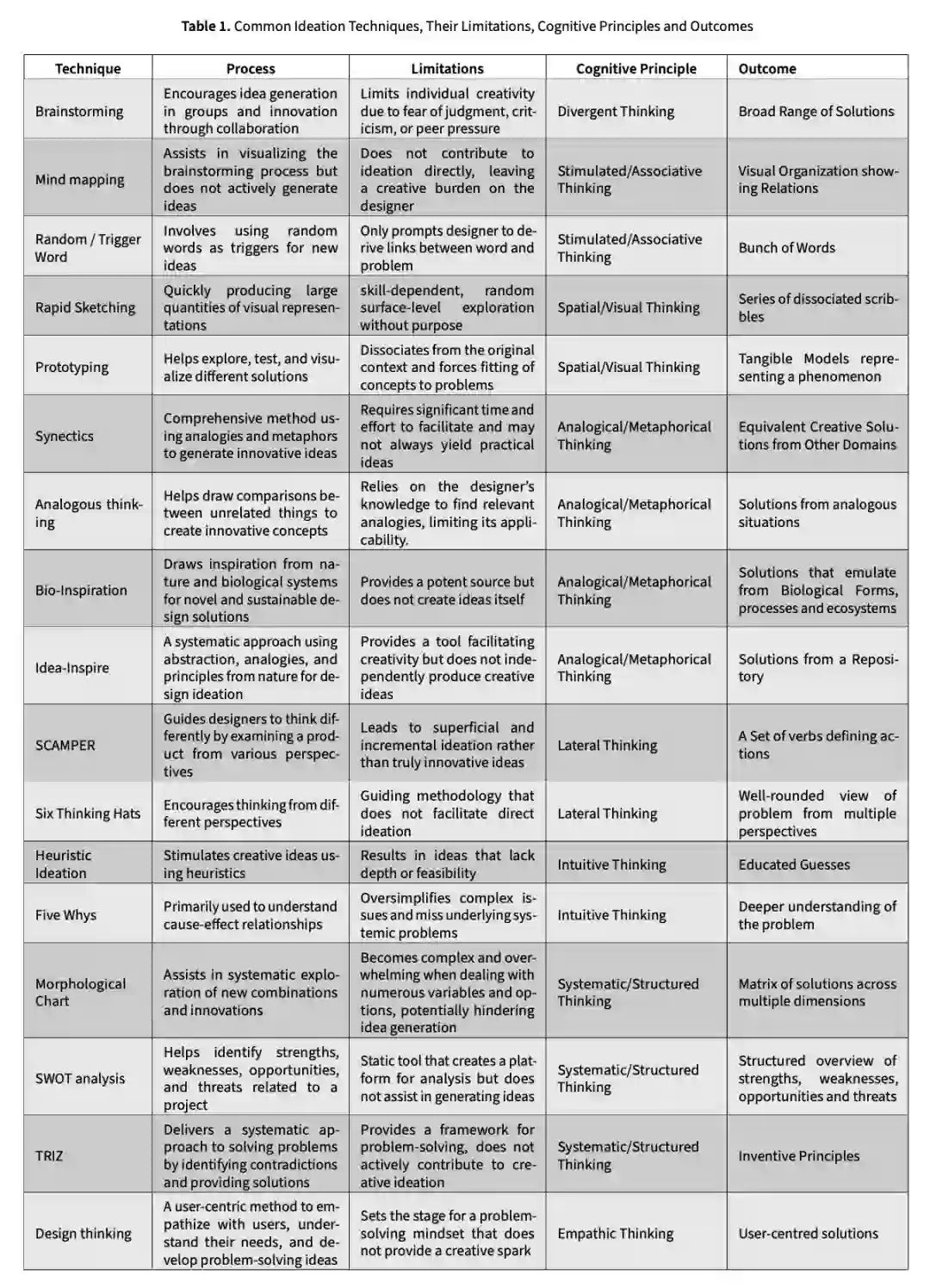

在当前的很多研究设计中,从书面信息到基于关键词的在线资源检索的转变至关重要。这强调了文本在转变思维模式和通过发展高级设计语言促进系统化构思方面的重要性。下表 1 总结了最常用的传统构思技术、其过程、局限性、涉及的认知原则以及在产生创意方面的预期结果。

虽然这些传统方法已被广泛使用,但它们往往无法为新手设计师提供积极的支持。在产生新颖想法的过程中,原创性和多样性主要依赖于设计者。这一空白标志着将人工智能与构思相结合的潜力。

这篇论文就深入探讨了对话式人工智能(CAI)系统的设计、开发和潜在使用案例,重点是比较基于 CAI 的构思工具与传统方法的效率。

有两个有趣的特点使 CAI 系统看起来很智能:(a) 能够就给定主题生成智力上可接受的文章,(b) 能够在先前交互的基础上生成对后续询问的回复。这使得交互成为关于特定主题的连贯对话。因此,如果特征(a)是对一个观点的描述,那么特征(b)就可以被构建为对该观点的阐述和澄清。

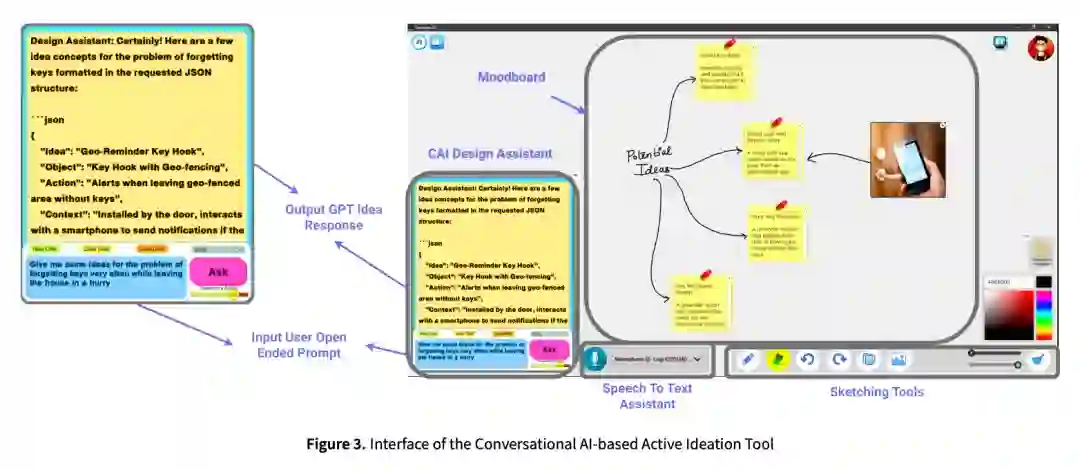

如图 3 所示,这项研究设计并开发了一个主动构思界面,使用了生成式预训练 Transformer(GPT)对话式人工智能系统,该系统嵌入了一个交互式情绪板(moodboard)。GPT 为自然语言交互提供了基础,使其能够根据用户输入做出响应并生成创意陈述,情绪板提供了一种快速记录这些想法的手段。因此,该界面为设计师提供了一个对话式的直观平台,由 GPT 驱动创意生成。

由于本研究调查的是建议的基于 CAI 的构思界面对新手设计师的潜在益处,因此招募了 30 名产品设计研究生(下图),分为 A 和 B 两组。

论文对这 30 名新手设计师进行了试点研究,让他们使用传统方法和基于 CAI 的新界面,针对给定问题产生创意。然后,让专家小组使用流畅性、新颖性和多样性等关键参数对结果进行了定性比较。

研究结果表明,本文所提出的 AI 工具在生成多产、多样和新颖的想法方面非常有效。通过在每个构思阶段加入提示设计的结构化对话风格,使界面更加统一,更方便设计者使用。结果发现,这种结构化 CAI 界面所产生的反应更加简洁,并与随后的设计阶段(即构思阶段)保持一致。

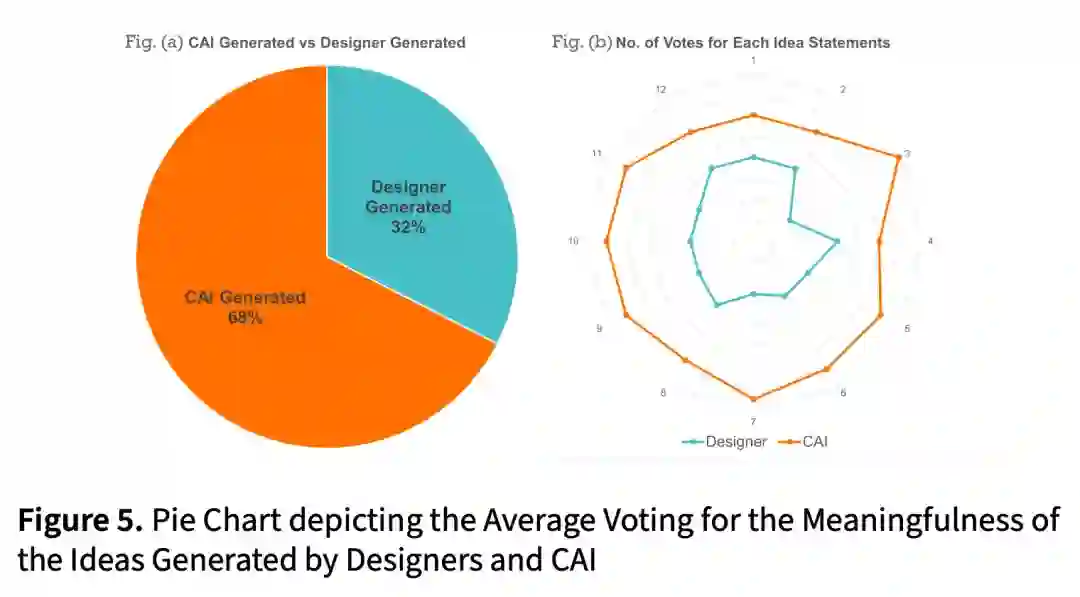

从图 5(a)中可以看出,68% 的专家认为 GPT 产生的想法更有意义。此外,图 5 (b) 显示,GPT 生成的语句的得票率始终高于设计者生成的想法。

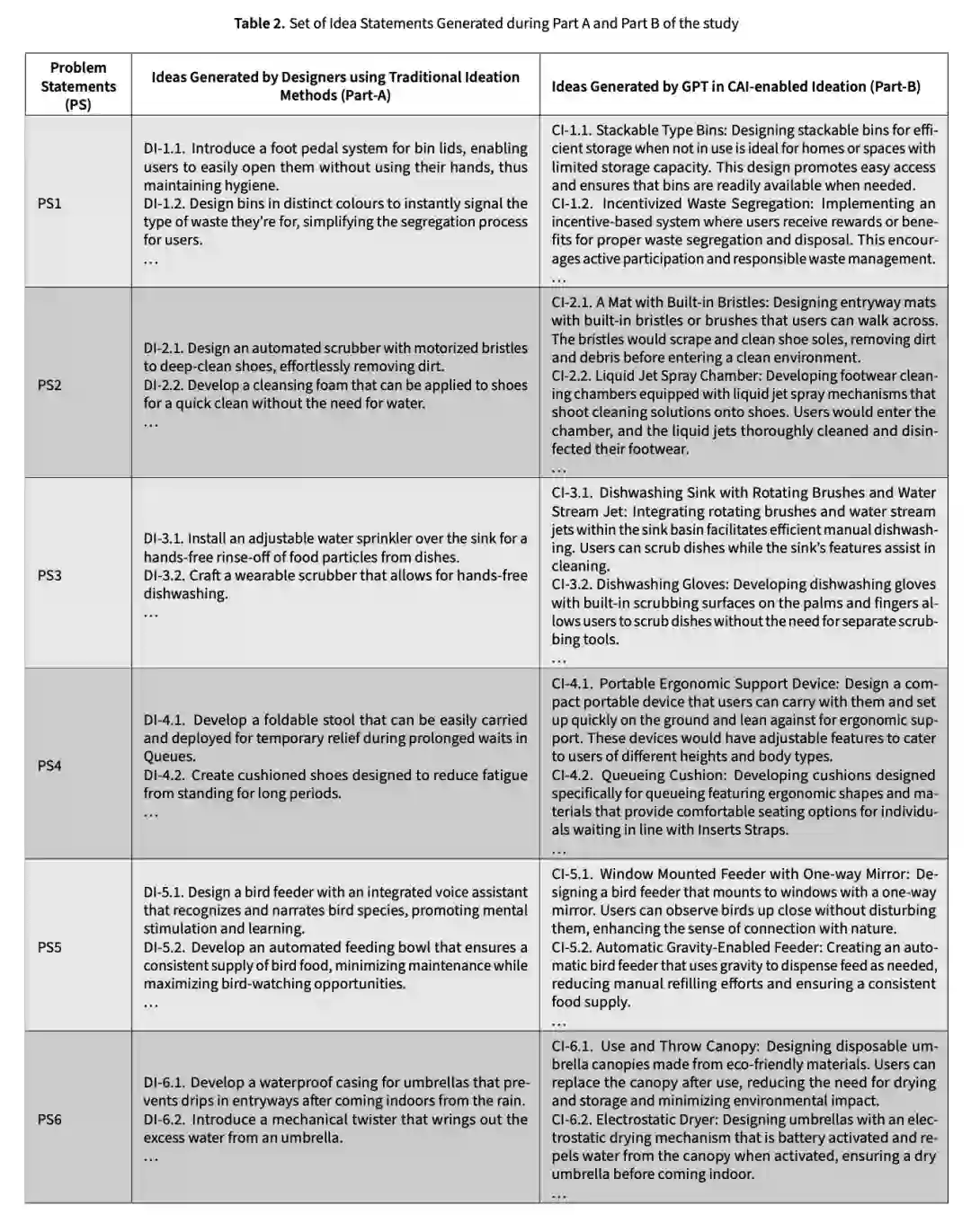

下表是 A 和 B 两组的想法陈述对比:

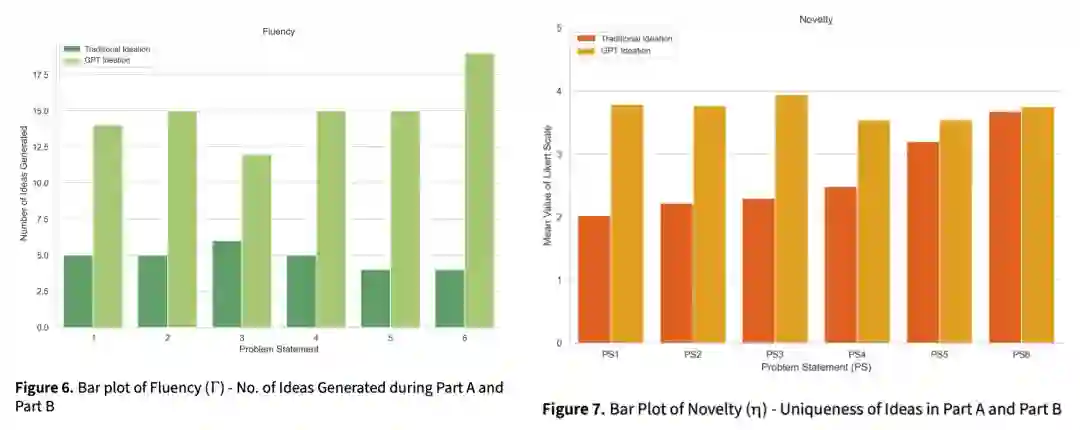

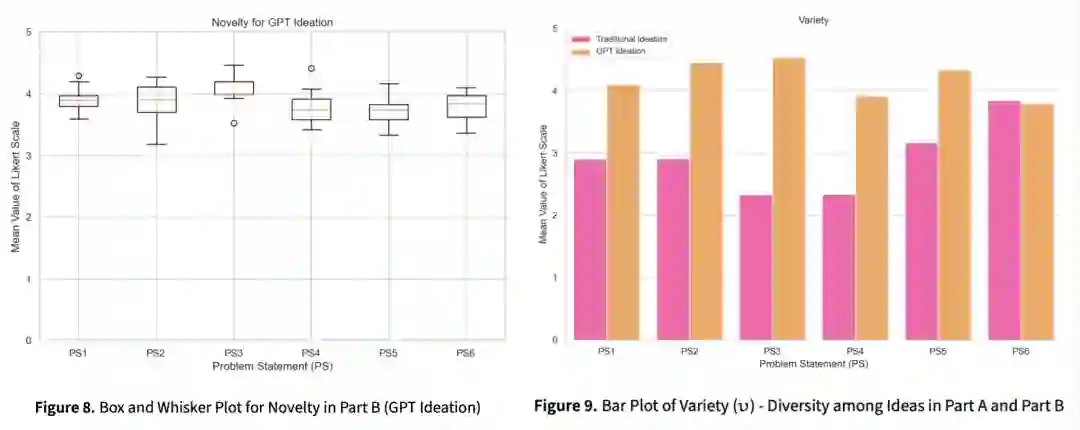

以下是不同维度下,人类与 GPT 构思的评估结果对比:

更多研究细节,可查看原论文。

结语

创新,长久以来被视为人类不可被机器触及的领地,然而,LLM 所展现的「幻觉」现象却悄然打开了这扇门,揭示了创新机制可能并非我们想象中那般高不可攀。

近期在 AI 创造性研究领域的突破,预示着 AI 在创意之路上或将迎来前所未有的广阔天地。展望未来,或许在不远的将来,我们将见证 AI 科学家、AI 导演、AI 设计师们纷纷挥洒创意,它们的作品将点亮 AI 应用的崭新篇章。