深度学习模型

·

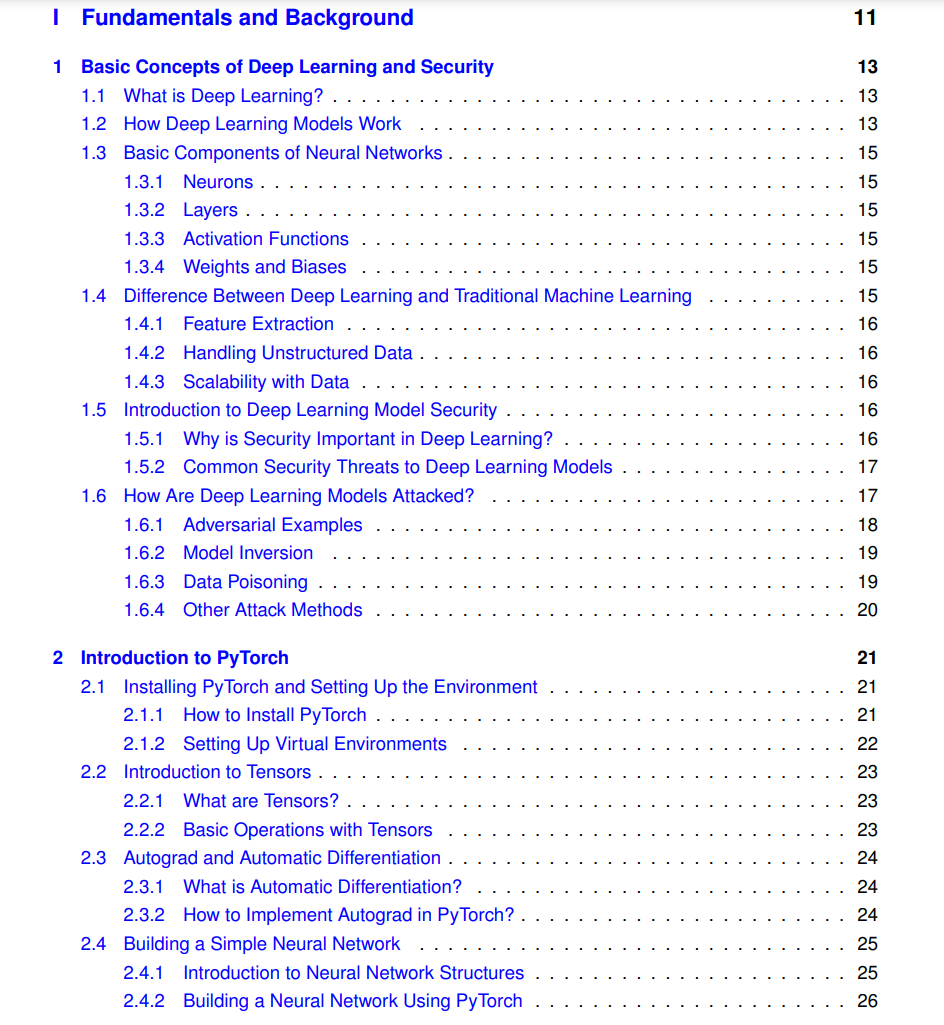

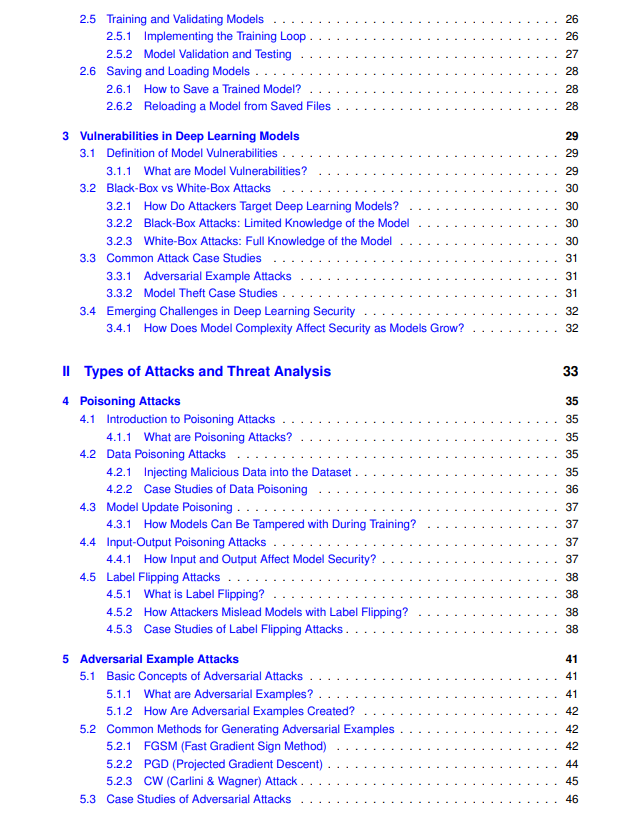

深度学习已经彻底改变了人工智能应用,但也面临着一系列关键的安全挑战,包括对抗攻击、数据投毒、模型盗窃和隐私泄露。本文综述了这些漏洞,详细介绍了它们的机制及其对模型完整性和保密性的影响。探讨了包括对抗样本、标签翻转和后门攻击在内的实际攻击方式,并分析了如对抗训练、差分隐私和联邦学习等防御方法,阐明了它们的优缺点。此外,文章还介绍了对比学习和自监督学习等先进方法,用于增强模型的鲁棒性。最后,综述对未来的发展方向进行了展望,强调了自动化防御、零信任架构以及大规模AI模型的安全挑战。在此背景下,开发可靠的深度学习系统需要在性能和安全性之间找到平衡。https://www.zhuanzhi.ai/paper/d849ea56b2212133880006d061c7f9d5

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日