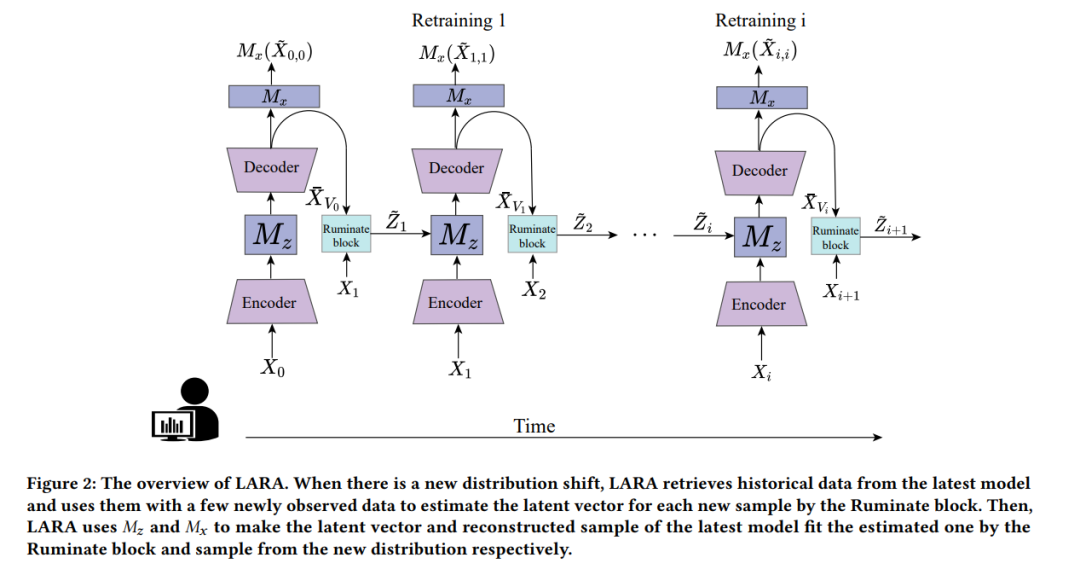

目前大多数异常检测模型都假定正常模式一直保持不变。然而,Web服务的正常模式经常发生剧烈变化。在旧分布数据上训练的模型在这些变化后已经过时。每次重新训练整个模型都是昂贵的。此外,在正常模式发生变化的初期,新分布的观察数据不足。使用有限数据重新训练大型神经网络模型容易出现过拟合。因此,我们提出了一种基于深度变分自编码器的轻量级防过拟合重新训练方法(LARA)用于时间序列异常检测。本工作旨在做出三个新颖的贡献:1)重新训练过程被形式化为一个凸问题,可以快速收敛并防止过拟合;2)设计了一个反思块,利用历史数据而无需存储它们;3)在数学上和实验上证明,当微调潜在向量和重构数据时,线性形式可以实现地面真实值和微调值之间的最小调整误差。此外,我们进行了许多实验来验证,即使使用来自新分布的43个时间槽的数据重新训练LARA,其在与使用充分数据训练的最先进的异常检测模型进行比较时也能实现竞争性的F1分数。此外,我们验证了它的轻量级开销。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日