本研究提出分层多智能体强化学习框架,用于分析异构智能体参与的仿真空战场景,旨在通过预设模拟识别促成任务成功的有效行动方案(CoA),从而低成本、低风险探索现实防务场景。在此背景下应用深度强化学习面临特定挑战,包括复杂飞行动力学、多智能体系统状态与动作空间指数级扩展,以及实时单元控制与前瞻规划融合能力。为解决这些问题,决策过程被分解为双层抽象:底层策略控制单个单元,高层指挥官策略发布与总体任务目标匹配的宏观指令。该分层结构通过利用智能体策略对称性及控制与指挥任务分离,显著优化训练流程。底层策略通过渐进复杂度的课程学习训练单兵作战控制能力,高层指挥官则在预训练控制策略基础上学习任务目标分配。实证验证证实了该框架的优越性。

本研究探索深度强化学习(RL)作为低成本、低风险空战场景模拟分析方法的可行性。RL在各类环境中展现的行动方案发现能力构成研究动机,涵盖棋类博弈[1]、街机游戏实时控制[2]以及现代兵棋推演[3]等融合控制与战略决策的场景。空战场景中应用RL存在多重挑战:仿真场景结构特性(如单元复杂飞行动力学、联合状态动作空间规模)、规划深度、随机性与信息不完备性等。战略博弈与防务场景的决策树(即潜在行动方案集合)规模远超常规搜索能力边界。此外,现实作战需同步协调单元机动与战略布局及全局任务规划,整合部队层级实时控制与指挥官层级任务规划的联合训练极具挑战性,因二者对系统需求、算法架构及训练配置存在本质差异。

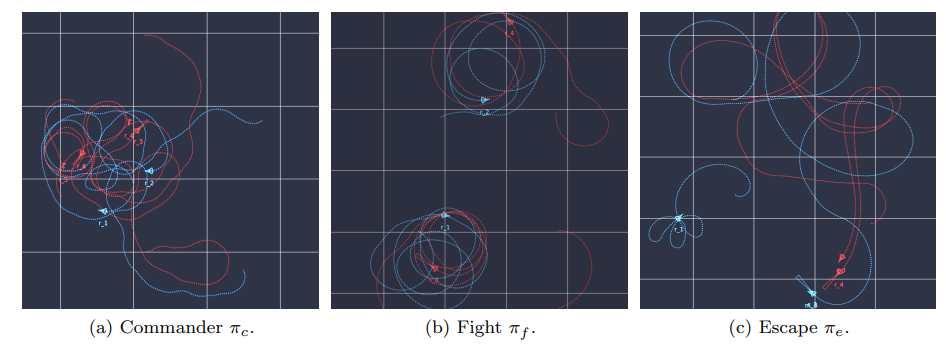

为应对挑战并复现现实防务行动,本研究构建分层多智能体强化学习(MARL)框架分析异构智能体空战仿真场景。该方法将决策过程解耦为双层结构:底层策略负责单元实时控制,高层策略依据全局任务目标生成宏观指令。底层策略通过预设场景(如攻击/规避)训练,场景目标由指令标识符标记。为增强鲁棒性与学习效率,采用渐进复杂度场景课程学习与联盟自博弈机制。高层策略学习基于动态任务目标为下属智能体分配合适标识符。战略规划权责上移至高层指挥官,底层执行单元自主完成控制任务。该架构通过底层策略对称性利用与信息流定向传输,大幅简化策略训练过程,并实现控制与指挥的清晰分离,支持任务定制化训练方案。

本研究核心贡献包括:(1)开发轻量化环境平台,快速模拟智能体核心动力学与交互行为。通过固定飞行高度将运动约束至2D空间,仍能精确捕捉智能体交互与机动特征。(2)采用课程学习虚构自博弈机制,通过渐进复杂度提升作战效能。(3)设计集成注意力机制、循环单元与参数共享的神经网络架构,联合训练底层控制策略与高层指挥官策略。(4)针对深度学习系统黑箱特性与科学评估风险,通过分层组件解析实现决策可解释性。

第2节综述前沿进展并阐明本研究对现有文献的拓展;第3节介绍飞行器模拟器基础特性与MARL原理;第4节阐述空战对抗场景及训练流程;第5节呈现实验结果;第6节讨论结论与未来研究方向。