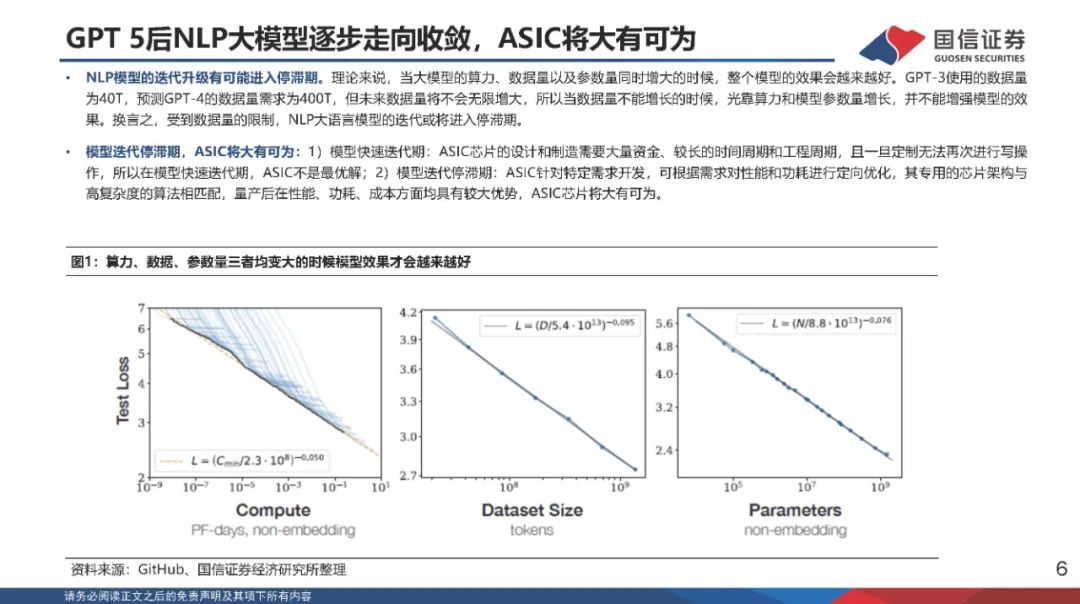

GPT5后NLP大模型逐步走向收敛,ASIC将大有可为。理论来说,当大模型的算力、数据量以及参数量同时增大的时候,整个模型的效果会越来越好。GPT-3使用的数据量为40T,预测GPT-4的数据量需求为400T,但未来数据量将不会无限增大,所以当数据量不能增长的时候,光靠算力和模型参数量增长,并不能增强模型的效果。换言之,受到数据量的限制,NLP大语言模型的迭代或将进入停滞期。在模型迭代停滞期,若应用爆发,则ASIC芯片的优势就显现出来。ASIC针对特定需求开发,可根据需求对性能和功耗进行定向优化,其专用的芯片架构与高复杂度的算法相匹配,量产后在性能、功耗、成本方面均具有较大优势,ASIC芯片将大有可为。

头部厂商纷纷切入AIASIC领域,技术路径不同。谷歌15年发布第一代TPU(ASIC)产品,TPU产品持续迭代升级;英特尔19年收购人工智能芯片公司HabanaLabs,22年发布AIASIC芯片Gaudi2,性能表现出色;IBM研究院22年底发布AIASIC芯片AIU,有望23年上市;三星第一代AIASIC芯片WarboyNPU芯片已于近日量产。头部厂商纷纷切入AIASIC领域,看好ASIC在人工智能领域的长期成长性。 谷歌:谷歌为AIASIC芯片的先驱,于15年发布第一代TPU(ASIC)产品,大幅提升AI推理的性能;17年发布TPUv2,在芯片设计层面,进行大规模架构更新,使其同时具备AI推理和AI训练的能力;谷歌TPU产品持续迭代升级,21年发布TPUv4,采用7nm工艺,峰值算力达275TFLOPS,性能表现全球领先。 英特尔:19年底收购以色列人工智能芯片公司HabanaLabs,22年发布Gaudi2ASIC芯片。从架构来看,Gaudi架构拥有双计算引擎(MME和TPC),可以实现MME和TPC并行计算,大幅提升计算效率;同时,其将RDMA技术应用于芯片互联,大幅提升AI集群的并行处理能力;从性能来看,Gaudi2在ResNET-50、BERT、BERTPhase-1、BERTPhase-2模型的训练吞吐量优于英伟达A100,性能表现优异。