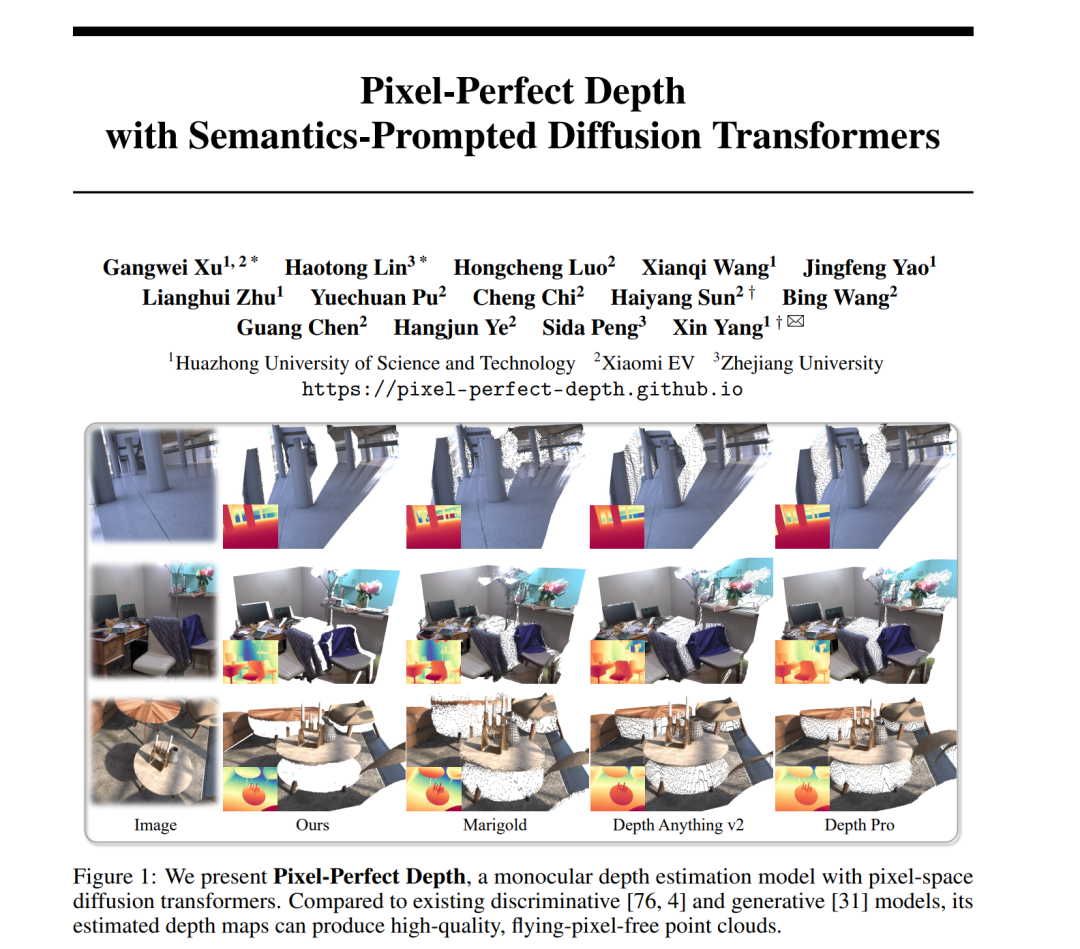

本文提出了 Pixel-Perfect Depth,一种基于像素空间扩散生成(pixel-space diffusion generation)的单目深度估计模型,能够从预测的深度图中生成高质量、**无飞点(flying pixels)**的点云。当前的生成式深度估计模型通常在

Stable Diffusion 基础上进行微调,尽管取得了显著性能,但它们需要借助 变分自编码器(VAE) 将深度图压缩到潜空间中,这一过程不可避免地会在边缘与细节处引入飞点伪影。 为解决这一问题,我们的模型直接在像素空间中执行扩散生成,从根本上避免了由 VAE 压缩引起的伪影。针对像素空间生成所带来的高计算复杂度,我们提出了两项创新设计:

语义提示扩散 Transformer(Semantics-Prompted Diffusion Transformers, SP-DiT):将视觉基础模型(Vision Foundation Models)提取的语义表征融入 DiT 架构,用于引导扩散过程,从而在提升细粒度视觉细节的同时保持全局语义一致性;

级联式 DiT 设计(Cascade DiT Design):通过逐步增加 token 数量的方式,进一步提高生成的效率与精度。

在五个主流基准测试中,Pixel-Perfect Depth 在所有已发表的生成式模型中取得了最优性能,并在**边缘感知点云评估(edge-aware point cloud evaluation)**上显著超越其他方法。

成为VIP会员查看完整内容

相关内容

Arxiv

20+阅读 · 2023年3月21日