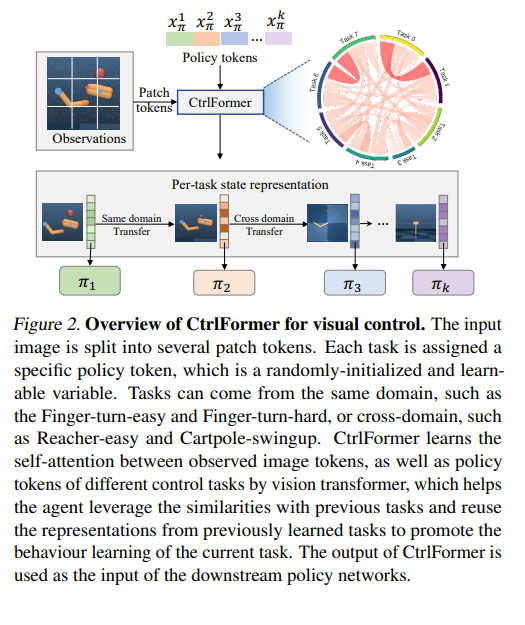

Transformer在学习视觉和语言表示方面取得了巨大的成功,这在各种下游任务中都是通用的。在视觉控制中,学习可在不同控制任务间迁移的可迁移状态表示对于减少训练样本的大小具有重要意义。然而,将Transformer移植到采样高效的视觉控制仍然是一个具有挑战性和未解决的问题。为此,我们提出了一种新颖的控制Transformer(CtrlFormer),它具有许多现有技术所没有的吸引人的优点。首先,CtrlFormer在不同控制任务之间联合学习视觉令牌和策略令牌之间的自注意力机制,可以在不发生灾难性遗忘的情况下学习和迁移多任务表示。其次,我们精心设计了一个对比强化学习范式来训练CtrlFormer,使其能够达到较高的样本效率,这在控制问题中是非常重要的。例如,在DMControl基准测试中,不像最近的先进方法在使用100k样本迁移学习后在“Cartpole”任务中产生零分而失败,CtrlFormer可以在仅使用100k样本的情况下获得769±34的最先进的分数,同时保持之前任务的性能。代码和模型发布在我们的项目主页上。

https://www.zhuanzhi.ai/paper/9692ae63f6623f9fc8ad4d18583f4002

成为VIP会员查看完整内容