深度神经网络在人工智能的各个领域取得了显著的成功。

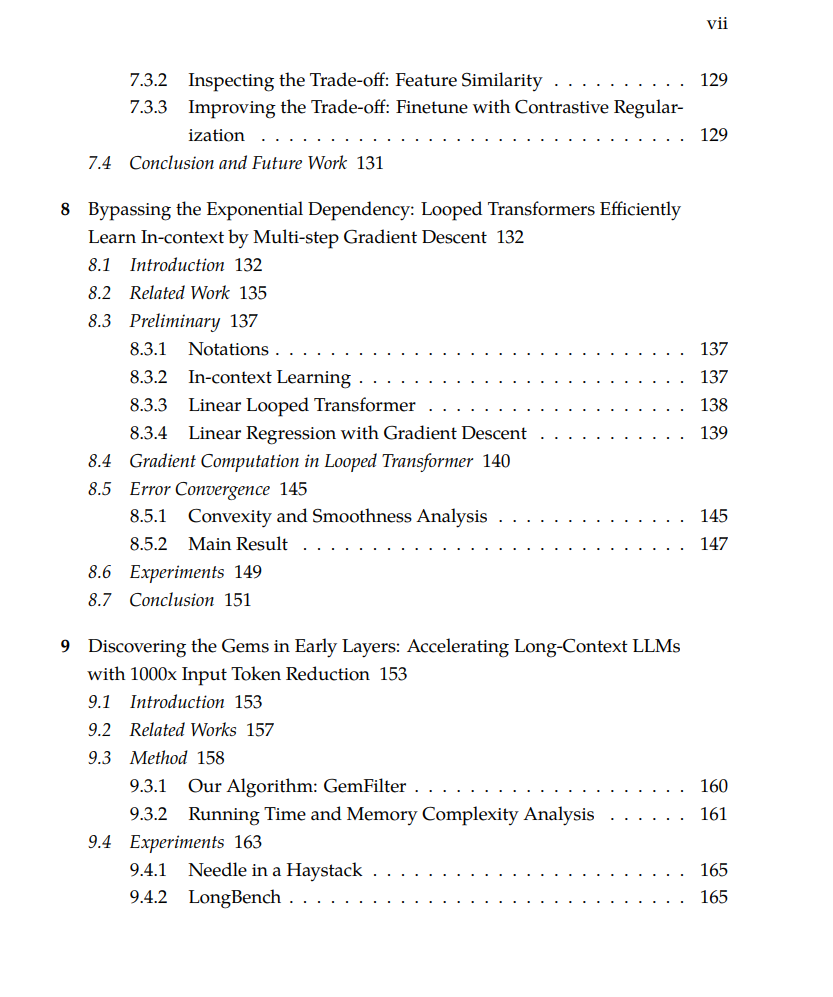

它们成功的关键因素之一是能够从数据中学习有效的特征表示,这使得它们与传统机器学习方法有所区别。本论文探讨了特征学习在神经网络训练过程中如何出现,并展示了它在基础模型适应下游应用中的关键作用。 首先,我们从理论上阐述了特征学习在神经网络中的出现。我们证明了神经网络在训练的早期阶段可以高效地学习与类别相关的模式,且只需使用最小的参数,从而避免了影响传统方法的维度灾难。我们的分析表明,这种能力源于网络利用输入数据固有结构的能力。我们开发了一个统一的分析框架,适用于通过梯度下降训练的两层网络,表征了特征学习如何超越核方法发生。我们将研究扩展到 Transformer 架构,分析了单层 Transformer 中的傅里叶特征,并揭示了模型规模与上下文学习行为之间的关系。我们的发现表明,较大的模型覆盖更多的隐藏特征,而较小的模型则强调重要特征,导致不同的上下文学习行为。 在这些理论洞察的基础上,我们开发了基础模型的实际应用。我们引入了核范数正则化方法,以提高领域泛化能力,并在多个任务中展示了持续的性能提升。我们通过一种新的正则化方法解决了对比学习中的普适性与标签效率之间的权衡问题。此外,我们提出了循环 Transformer,用于在上下文学习中实现多步梯度下降,并开发了 GemFilter 算法,利用早期层的注意力特征加速大语言模型的推理。 本论文推进了我们对神经网络中特征学习的理解,并提供了改进基础模型性能的实用方法,为开发更高效和有效的机器学习系统奠定了基础。 https://pages.cs.wisc.edu/~zhmeishi/Thesis_Zhenmei_Shi.pdf

成为VIP会员查看完整内容

相关内容

Arxiv

36+阅读 · 2023年4月19日

Arxiv

186+阅读 · 2023年4月7日

Arxiv

71+阅读 · 2023年4月4日

Arxiv

130+阅读 · 2023年3月29日