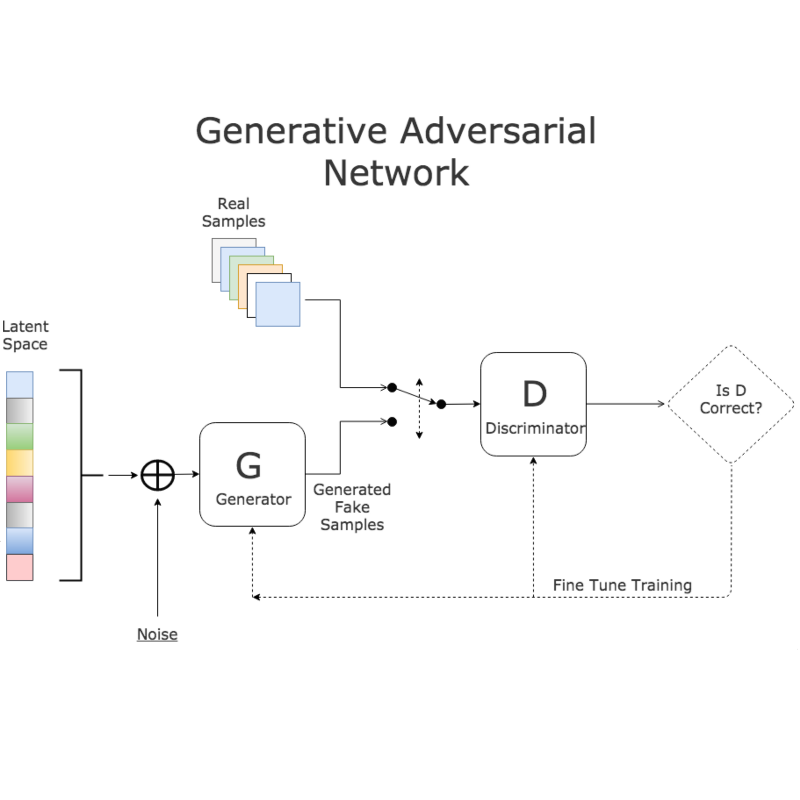

随着大数据的普及和算力的提升,深度学习已成为一个热门研究领域,但其强大的性能过分依赖网络结构 和参数设置。 因此,如何在提高模型性能的同时降低模型的复杂度,关键在于模型优化。为了更加精简地描述优 化问题,本文以有监督深度学习作为切入点,对其提升拟合能力和泛化能力的优化方法进行归纳分析。给出优化的 基本公式并阐述其核心;其次,从拟合能力的角度将优化问题分解为3个优化方向,即收敛性、收敛速度和全局质量 问题,并总结分析这3个优化方向中的具体方法与研究成果;从提升模型泛化能力的角度出发,分为数据预处理和 模型参数限制两类对正则化方法的研究现状进行梳理;结合上述理论基础,以生成对抗网络(generative adversarial network,GAN)变体模型的发展历程为主线,回顾各种优化方法在该领域的应用,并基于实验结果对优化效果进行比 较和分析,进一步给出几种在GAN领域效果较好的优化策略。现阶段,各种优化方法已普遍应用于深度学习模型, 能够较好地提升模型的拟合能力,同时通过正则化缓解模型过拟合问题来提高模型的鲁棒性。尽管深度学习的优 化领域已得到广泛研究,但仍缺少成熟的系统性理论来指导优化方法的使用,且存在几个优化问题有待进一步研 究,包括无法保证全局梯度的Lipschitz限制、在GAN中找寻稳定的全局最优解,以及优化方法的可解释性缺乏严格 的理论证明。

随着智能技术的发展,深度学习备受青睐,广泛 应 用 于 计 算 机 视 觉(Agbo-Ajala 和 Viriri,2021; Abdolahnejad和Liu,2020)、图异常检测(陈波冯 等, 2021)、推荐系统的数据分析(Khan等,2021)和自然 语言处理(Torfi 等,2020)等领域。研究人员主要致 力于如何更好地提高深度学习模型的性能。Hinton 和 Salakhutdinov(2006)最早初步解决了“梯度消失” 问题。首先通过无监督的学习方法逐层训练模型, 每训练一层隐藏节点就作为下一层隐藏节点的输入(该过程称为预训练),再使用有监督的反向传播 (Rumelhart 等,1986)进行调优,以逐层预训练的方 式提取数据的高维特征,初步解决梯度消失的问题。 Glorot和 Bengio(2010)提出 Xavier初始化,使状态方 差和梯度方差保持不变,进而提升模型分类性能。 2011 年,ReLU(rectified linear unit)激活函数被证明 可以针对性控制梯度消失的情况(Glorot等,2011), 此时深度学习仍处于理论研究阶段。直至2012年, Hinton 团 队 在 ILSVRC(ImageNet large scale visual recognition challenge)大赛上通过结合 ReLU 激活函 数构建AlexNet(Krizhevsky等,2012),以碾压性的分 类性能夺冠,进一步推动深度学习成为研究热点。 此后,深度学习在其他领域也得以蓬勃发展。Gir⁃ shick(2015)提出 R-CNN(region convolutional neural network)将深度学习引入目标检测领域。

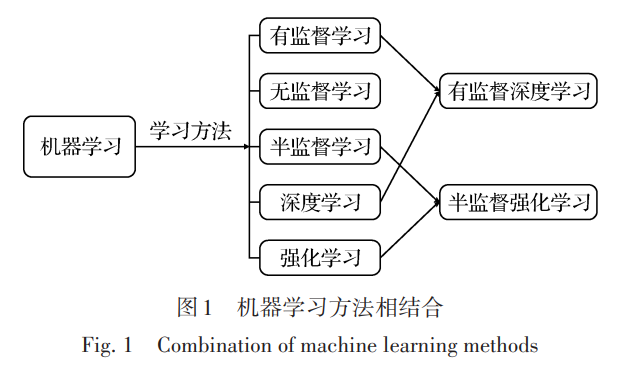

作为一种机器学习方法,深度学习可与其他机 器学习方法相结合,如图 1 所示。为了更加精简地 描述优化问题,仅以有监督深度学习的优化作为切 入点进行分析。监督学习的目标是通过得到的样本 找到一个近似底层函数的函数,主要由“表示”(repre⁃ sentation)、“优化”(optimization)和“泛化”(generaliza⁃ tion)3个步骤组成(Sun,2020)。“表示”即找到一个丰 富的函数族用以表示目标函数;“优化”即通过最小化 损失函数以确定函数参数;“泛化”指用得到的目标函 数进行预测,产生的误差称为测试误差,包括表示误 差、优化误差和泛化误差。一般默认已经找到适合 的目标函数再进行优化,因此不考虑表示误差。 神经网络本质上是一种对网络参数优化变量的 方法。因此,在确定适合的目标函数后,深度学习的 核心问题可归结为一个优化问题,其强大性能高度 依赖经验,研究人员需要经过训练大量模型才能得 到适合的参数。此外,在训练模型的过程中,现有的 理论无法严谨地分析所用方法的有效性。因此,深 度学习的优化问题可概括为:设计有效的优化方法 来提升模型的拟合能力,降低训练误差;同时,还要 考虑通过正则化方法提升模型的泛化能力,还能降 低模型的复杂度,更加高效地训练神经网络。 首先,介绍深度学习优化的理论基础,从拟合能 力的角度将深度学习优化问题划分为3个具体研究 方向,即收敛性、收敛速度和全局质量问题,并对每 个方向进行总结分析。其次,针对集成多种优化方 法可能存在过拟合进而降低模型泛化能力的问题,以提升模型泛化能力的正则化方法作为切入点,详 细阐述分析不同正则化方法的作用。接着,讨论上 述优化方法在生成对抗网络(generative adversarial network, GAN)中的使用。最后,在现有深度学习优 化理论的基础上,分析目前深度学习领域仍存在的 问题并分析未来研究方向。