人类在日常生活中通过多种感官与环境互动:视觉用于感知和理解环境,身体意识用于定位,语言用于交流和语义理解,触觉则用于接触反馈。同样地,机器人在面对非结构化的真实世界环境中的操作任务时,也需要具备类似的多感官整合能力。

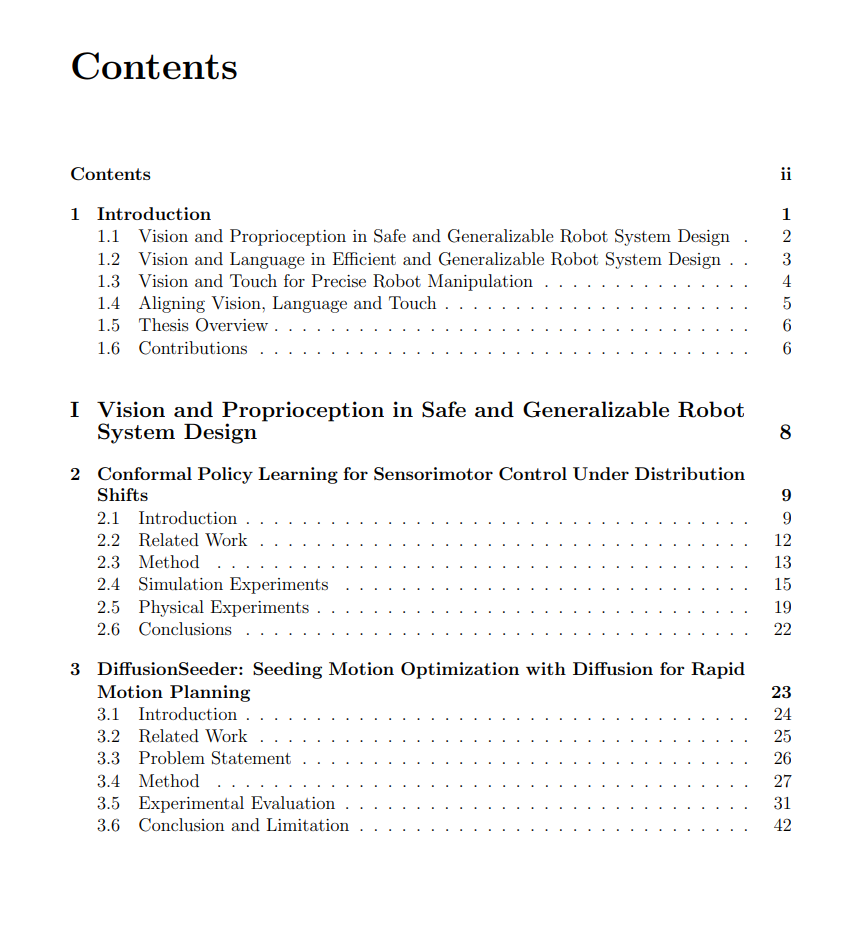

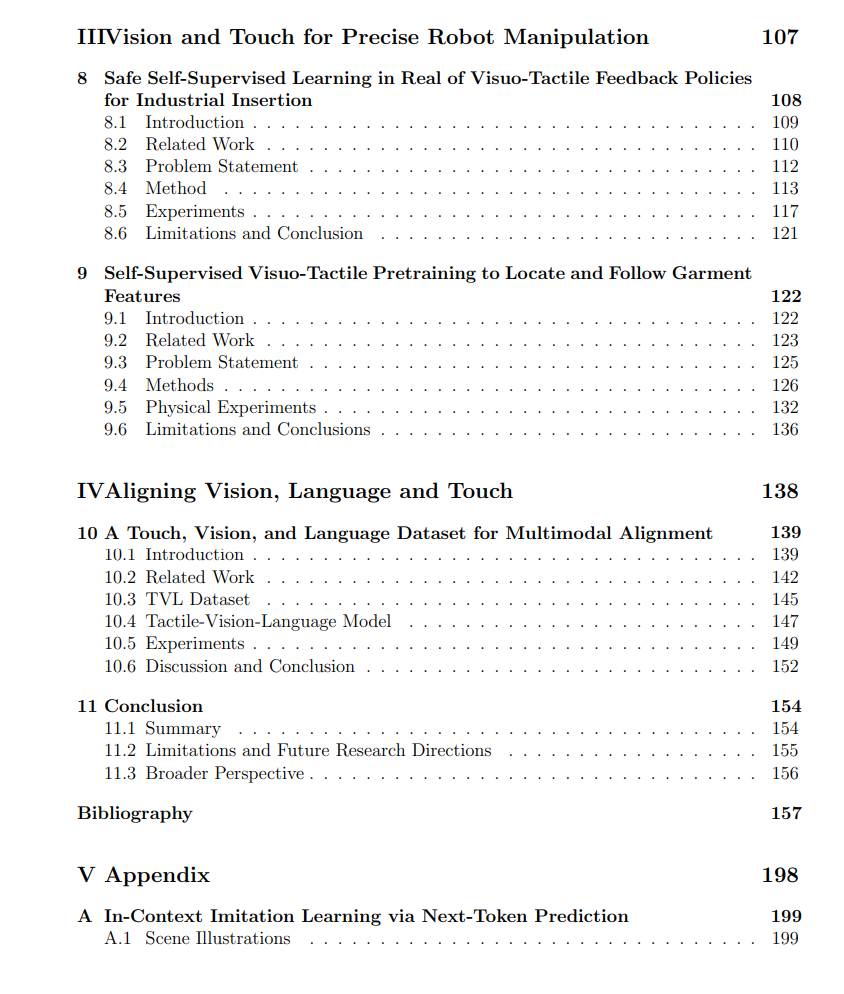

本论文探讨了如何融合多种感知输入,以提升机器人在现实世界中操纵物体的能力。通过整合视觉(为机器人提供详细的空间信息)、本体感觉(提供身体位置反馈)、语言(理解并执行指令)以及触觉(提供精细接触信息),我开发了安全、高效且具有良好泛化能力的机器人系统。 论文中的研究贡献涵盖多个方向,包括:感知-运动控制、运动规划、模仿学习、机械搜索、富接触操作任务以及多模态对齐,整体目标是提升机器人在跨模态感知、推理与行动能力,突破单一感知模态的局限。 研究首先从视觉与本体感知的融合出发,以增强机器人在分布偏移条件下的控制鲁棒性,并通过基于扩散模型的轨迹生成方法提升规划效率。接着,提出了一种基于**“下一个 token 预测”机制的上下文模仿学习方法**,使机器人能通过 prompt(提示)快速适应新任务。 随后,论文将视觉与语言的融合引入到遮挡物体的机械搜索与通用操作任务中。借助大型视觉-语言模型(Vision-Language Models),实现了更强的语义推理能力,从而获得更有效的操作策略。 进一步地,我研究了触觉传感在高精度操作任务(如工业插接与布料处理)中的应用,提出了自监督策略学习与视觉-触觉预训练方法,显著提升了任务成功率。 最后,我构建了一个新的对齐视觉、触觉与语言的多模态数据集,以支持机器人领域的多模态学习研究。 通过理论分析、仿真实验与真实机器人实验,本论文全面展示了多模态感知如何增强机器人操作任务中的泛化能力、适应性与安全性。 https://www2.eecs.berkeley.edu/Pubs/TechRpts/2025/EECS-2025-68.html