现代军事行动需要跨分布式系统的弹性且隐私保护的数据处理能力,而集中式学习往往无法满足安全与作战需求。联邦学习(FL)通过无需传输原始数据即可实现模型训练的方式,提供了一种去中心化解决方案。本论文评估了联邦学习在战术边缘网络流量分类任务中的性能、鲁棒性及面对对抗攻击的脆弱性。研究采用随机森林、极限梯度提升与卷积神经网络等监督模型,基于物联网-23和美国海军研究生院企业研究网络数据集,对比联邦学习与集中式学习的表现。结果表明联邦学习在二分类任务中可匹配集中式性能,但在多分类任务中表现不佳(尤其在类别不平衡条件下)。标签翻转攻击能在保持整体准确率的同时降低少数类性能。本文还引入一种新型后门攻击方法,通过嵌入特征级触发器而不改变标签,使宏观F1分数与加权F1分数下降高达10%。本研究贡献包括联邦仿真框架构建、模型对比分析及威胁评估。研究结果揭示需改进评估指标、加强类别平衡并集成防御机制以提升联邦学习鲁棒性。这些见解为未来在数据敏感性、资源约束与作战安全性至关重要的军事及联盟领域部署联邦学习提供了重要参考。

现代军事行动日益依赖跨分布式系统与多国联盟的安全高效数据交换。然而随着对手能力与复杂性的快速演进,现有架构难以在保密与非保密域同时维持敏感信息的机密性、完整性与可用性。2022年美国《国防战略》强调将弹性与敏捷性融入防御体系以应对复杂跨域威胁的紧迫性[1]。2022年美国《国家军事战略》呼应这一观点,强调需要联合部队战备、快速技术现代化与数据驱动决策以维持战略优势[2]。这一战略要求与2024-2026财年网络安全与基础设施安全局网络安全战略计划相对应,该计划指出网络威胁态势日益严峻,倡导通过安全设计架构与自动化实现先发制人的可扩展防御[3]。此外,美国网络司令部最新态势声明强调在战术边缘部署人工智能增强型网络防御的作战紧迫性,这需要采用既能保持作战安全性又能促进快速学习适应的去中心化方法[4]。

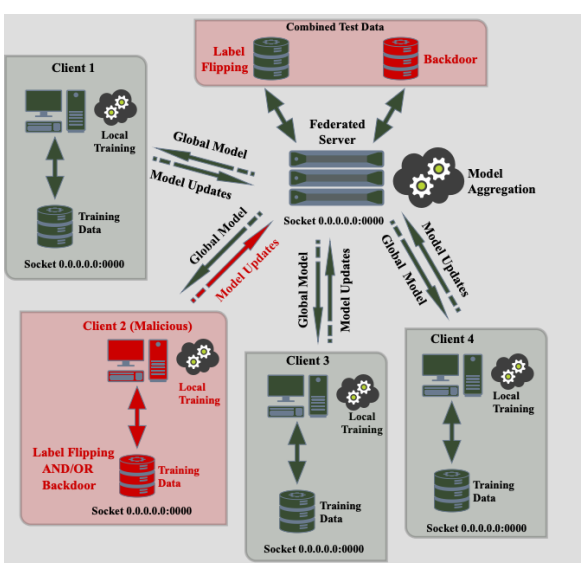

联邦学习为战略、作战与监管需求的交汇提供了创新解决方案。作为一种去中心化机器学习方法,联邦学习支持跨地理分散节点进行模型训练而无需将原始数据传输至中央服务器。其将共享全局模型分发给参与边缘设备,各设备执行本地训练后仅发回模型更新进行安全聚合。这减少了数据暴露风险,最小化通信开销,并增强了有限或间歇连接环境下的弹性。通过保持数据本地化,联邦学习符合零信任原则,支持欧美数据保护标准合规,并为实时流量分类提供可扩展框架。该架构还通过最小化跨组织边界的数据共享需求,增强了联盟互操作性。

本文主要贡献包括: • 提出基于套接字的联邦学习仿真框架,用于在受限环境中评估监督式流量分类模型 • 对比分析集中式与联邦设置下监督学习模型(随机森林、极限梯度提升与卷积神经网络)的性能表现 • 研究使用SelectKBest进行特征选择,比较基于流量的分类任务在缩减特征空间与完整特征空间下的效果 • 评估联邦模型在数据投毒攻击(特别是标签翻转与后门注入)下的鲁棒性,分析其对性能的影响

共分六章,各章分别核心研究问题。第二章介绍流量分类、机器学习与联邦学习的关键概念,并综述相关研究工作以识别模型鲁棒性与去中心化分析领域的空白。第三章阐述研究方法,包括数据集获取、预处理步骤、模型开发以及集中式与联邦学习的实验设置(含对抗测试)。第四章呈现实验结果,比较不同特征集与攻击场景下集中式与联邦模型的分类性能及鲁棒性。第五章结合背景讨论结果,评估研究问题,并检验对战术边缘网络安全的更广泛影响(包括优势与局限性)。第六章总结主要发现与贡献,并为联邦学习在任务关键环境中的未来应用指明方向。

图3.18. 展示通过套接字连接实现客户端-服务器通信的联邦学习架构示意图。客户端2作为恶意参与节点,在本地训练过程中执行标签翻转和/或后门攻击,从而影响聚合后的全局模型。服务器在聚合模型更新的同时,基于混合了正常样本与污染样本的测试集进行验证测试。