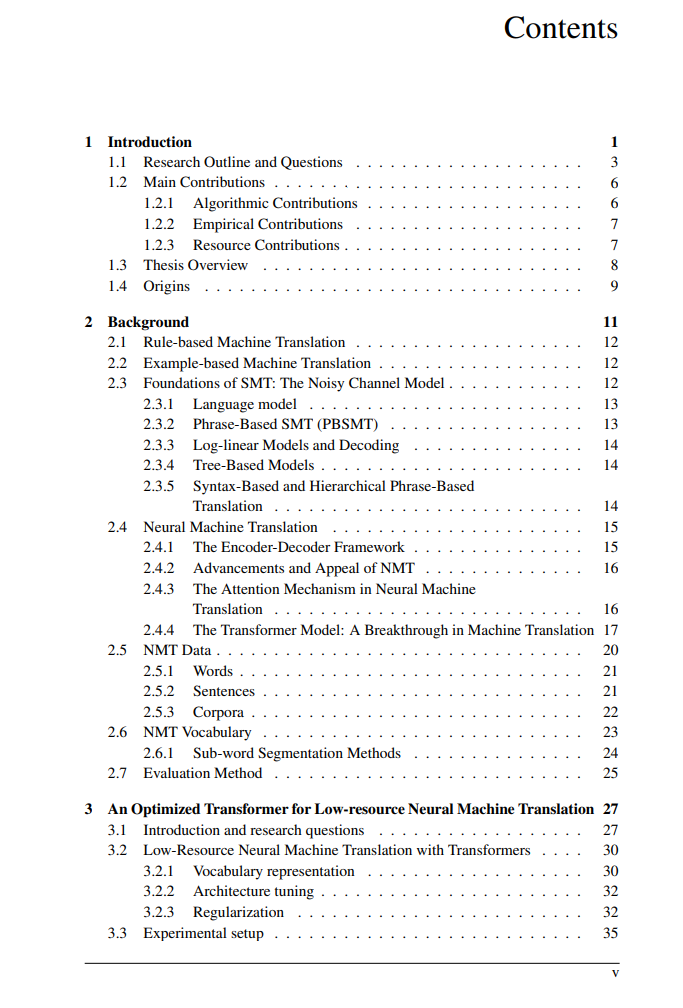

![]() 神经机器翻译(NMT)通过深度学习推动了机器翻译的进步,但其对大型平行数据集的依赖限制了其在低资源语言上的表现。本论文通过优化模型设计、数据处理和注意力机制,解决了这一问题,旨在提升NMT系统在数据稀缺条件下的性能,而无需依赖额外的数据。首先,我们优化了Transformer的超参数——如前馈网络维度、注意力头数量和dropout率——在低资源语言对中取得了显著的改进。接着,我们考察了字节对编码(BPE)作为预处理步骤,证明其在处理语言学相似的语言中的稀有词方面有效,但在处理某些词汇表外(OOV)词汇时存在局限性。为了提高模型的泛化能力,我们引入了联合Dropout(JD)这一数据驱动的方法,灵感来源于基于短语的机器翻译,该方法通过将等价的短语对替换为联合变量来增强模型对输入变动的鲁棒性。此外,我们提出了熵与距离正则化注意力(EaDRA),通过精细调整注意力机制,使其能够聚焦于关键输入元素,从而模拟高资源模型中发现的注意力模式。这些方法共同推动了低资源NMT的实用性进展,解决了与数据稀缺、OOV词汇和注意力机制相关的挑战。本研究有助于弥合高资源与低资源机器翻译之间的差距,并支持更具可访问性的语言技术的开发。https://hdl.handle.net/11245.1/11eef33b-50f9-4b8c-a64c-d563fbd24b07

神经机器翻译(NMT)通过深度学习推动了机器翻译的进步,但其对大型平行数据集的依赖限制了其在低资源语言上的表现。本论文通过优化模型设计、数据处理和注意力机制,解决了这一问题,旨在提升NMT系统在数据稀缺条件下的性能,而无需依赖额外的数据。首先,我们优化了Transformer的超参数——如前馈网络维度、注意力头数量和dropout率——在低资源语言对中取得了显著的改进。接着,我们考察了字节对编码(BPE)作为预处理步骤,证明其在处理语言学相似的语言中的稀有词方面有效,但在处理某些词汇表外(OOV)词汇时存在局限性。为了提高模型的泛化能力,我们引入了联合Dropout(JD)这一数据驱动的方法,灵感来源于基于短语的机器翻译,该方法通过将等价的短语对替换为联合变量来增强模型对输入变动的鲁棒性。此外,我们提出了熵与距离正则化注意力(EaDRA),通过精细调整注意力机制,使其能够聚焦于关键输入元素,从而模拟高资源模型中发现的注意力模式。这些方法共同推动了低资源NMT的实用性进展,解决了与数据稀缺、OOV词汇和注意力机制相关的挑战。本研究有助于弥合高资源与低资源机器翻译之间的差距,并支持更具可访问性的语言技术的开发。https://hdl.handle.net/11245.1/11eef33b-50f9-4b8c-a64c-d563fbd24b07

![]()

![]()