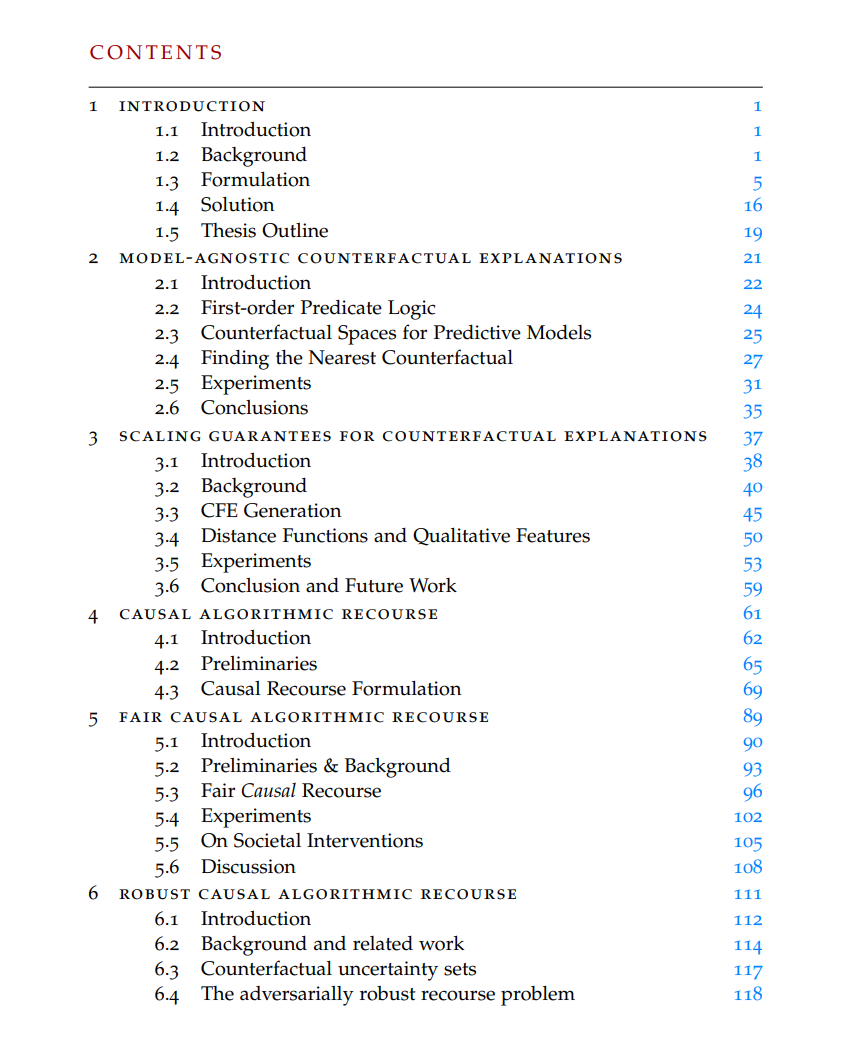

机器学习正在逐渐被用来指导在敏感环境中的关键决策,这些决策对个人的生活产生深远影响。例如,审前保释、贷款批准、简历筛选或重要药物的处方等。在这些情境中,模型必须准确、鲁棒,同时维护社会相关价值,如公平性、隐私性、问责制和可解释性。这些方面显著影响这些技术的接受度和影响。 在这篇论文中,我特别关注启用和促进算法补救的任务。这包括为个人提供易于理解的解释和建议,关于如何通过自动化系统做出的不利决策进行最有效(高效且理想地低成本)的恢复。以下研究问题得到解答: Q1. 我们如何为各种环境中受影响的个人提供补救?针对这个问题,我提出了一种基于正式验证标准理论和工具构建的生成模型不可知的反事实解释(MACE)的新算法。这种方法克服了以前策略的局限性,并支持模型、数据类型和距离不可知的反事实解释。它还为任何个人提供合理且多样的反事实,并以可证明的最优距离实现。Q2. 可以从反事实解释中得到哪些可行的见解?我认为解释必须使人们能够采取行动,而不仅仅是理解。使用反例和结构性因果模型(SCM)理论,我展示了行动建议通常不能从反事实解释中推断出来。我提出了生成最小后果干预(MINT)的新优化问题,提供在知道真实SCM的情况下的确切补救,以及仅当因果图可用时的概率补救。Q3. 提供补救解释/建议如何影响其他利益相关者?在这篇论文的第三部分,我认为应该在更广泛的背景下考虑向个人提供补救权,包括其对其他利益相关者和公平性、隐私性以及模型/IP安全等其他理想属性的影响。我定义并提出了提供公平补救的解决方案,并讨论不确定性和非平稳性如何影响提供的补救。我探索了鲁棒的补救策略,并讨论了可能对分类器或数据生成过程的潜在改变,以促进公平/鲁棒的补救。 总之,这篇论文为未来研究方向提供了路线图,挑战了现有的假设,并将补救的领域扩展到监督学习之外。