空战是一个复杂多变的领域,人类飞行员面临着严峻的挑战。整合人工智能,特别是强化学习(RL),有可能彻底改变空战行动的有效性。通过利用 RL 技术,自主智能体可以根据不断变化的战场条件制定新战术。在这项研究中,使用先进的 RL 技术训练了空战智能体,同时考虑到了不同的初始作战几何形状和相对位置。结果表明,空战几何形状的变化对智能体的能力有显著影响。为了评估其能力和应变能力,对具有对称战斗几何形状的相同智能体进行了检查。任何与预期对称结果的偏差都会被检测到,这可能意味着在训练探索阶段遇到了挑战。在这一框架内对不同的代理进行比较时,它们在特定空战场景中的优势就会凸显出来,从而为加强更多智能代理的开发提供有价值的信息。

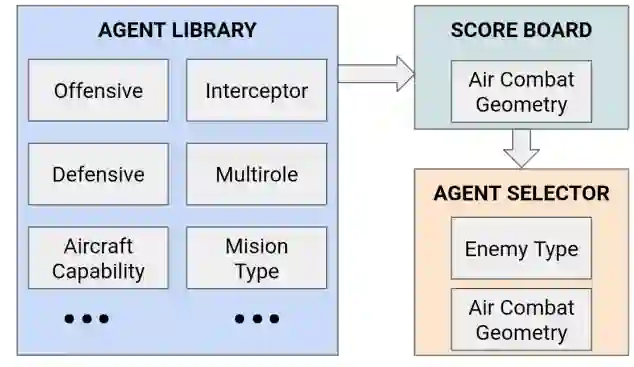

图 7. 根据敌方和空战几何图形选择智能体的整体视图

人工智能(AI)在航空航天领域的应用取得了重大进展,尤其是在安全关键型系统中,可解释性和安全性至关重要。随着无人战斗飞行器(UCAV)的发展,空战已成为需要人工智能集成的突出领域之一。

已有多个项目致力于推动这些自主系统(AS)的发展,其中包括 DARPA AlphaDogFight Trial [1]。在这个项目中,人工智能体的任务是在模拟的可视范围内(WVR)与对方进行斗狗。最终参赛队与人类飞行员进行了角逐,结果人工智能获胜。竞技团队是利用深度强化学习(DRL)方法来训练和发现新颖稳健的空战战术。

文献中对使用 RL 生成空战战术进行了广泛研究。值得注意的是,[2]的一项研究探索了使用深度确定性策略梯度(DDPG)训练 RL 智能体,结果在视距内(WVR)作战中大大提高了性能。另一项研究[3]深入研究了多智能体强化学习(MARL),以模拟涉及多架飞机的复杂合作空战策略,展示了 RL 在复杂场景中的潜力。[4] 采用分层强化学习(HRL)将空战任务分解为易于管理的子任务,从而简化了训练和决策过程。[5]研究了基于模型的 RL 在空战智能体训练过程中加速收敛和提高采样效率的功效,有助于在动态环境中发挥卓越性能。最后,[6] 应用了先进的深度强化技术--近端策略优化(PPO)和软行为批判(SAC),并比较了它们的性能。

在文献中,多种 RL 方法都显示出了优于其他方法的性能。然而,还没有研究关注如何分析和比较 RL 智能体在所有搜索空间(包括不同方向和距离组合)中不同空战几何条件下的胜任能力和鲁棒性。

本文提出了一种新颖的分析工具,旨在管理所有训练参数和奖励,从而能够执行智能体对智能体场景进行综合分析。我们采用最先进的 RL 方法,在不同的初始空战几何条件下训练空战智能体,如不同的相对位置和方向,使自己的飞机处于优势、中立或劣势位置。事实证明,相对空战几何形状的差异是影响智能体能力和鲁棒性的主要因素。我们通过启动具有对称作战几何形状的相同人工智能代理来测试空战代理的稳健性,并发现了与对称结果预期的偏差,这可能表明训练的探索阶段存在问题。我们的分析工具还测试了智能体的泛化能力以及在遇到训练外情况时的偏离趋势。此外,在这一框架内对不同代理进行的比较表明了每个智能体在特定空战场景中的优越性,为开发更智能的空战代理库提供了有价值的信息。最终,我们提出的分析工具通过提高空战场景中的可解释性、安全性和性能,推动了航空航天领域人工智能的发展。