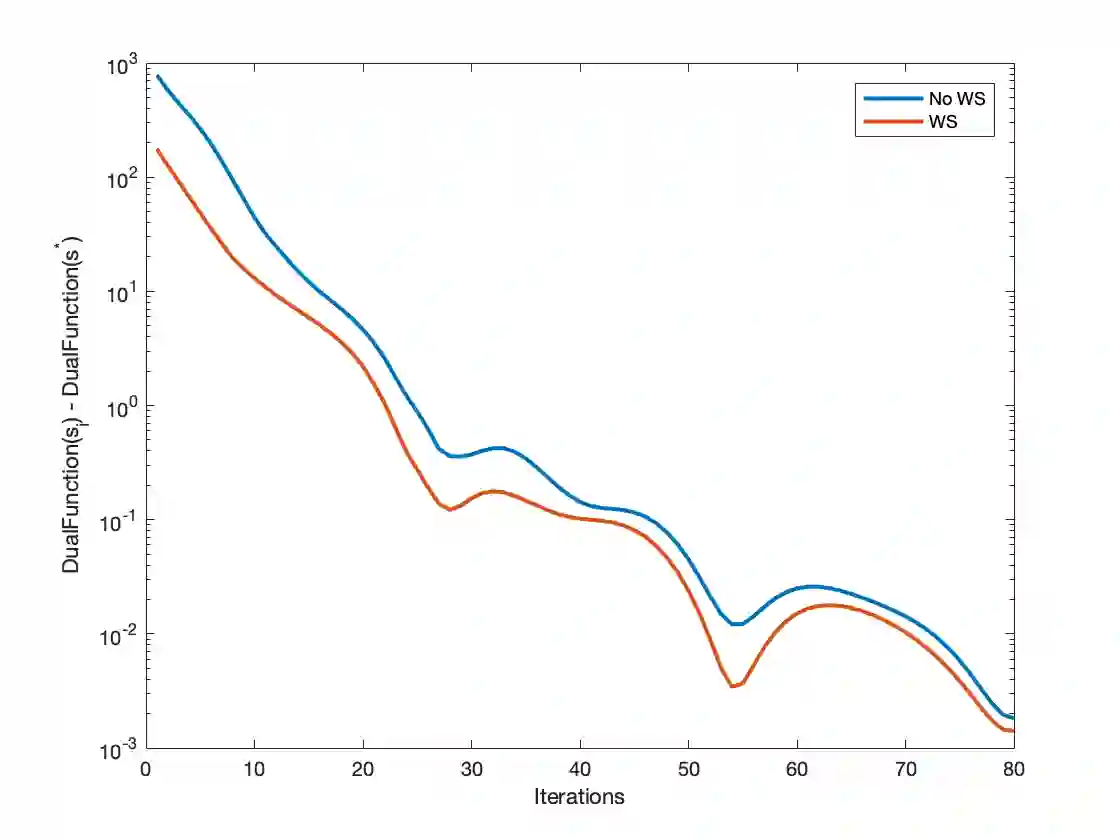

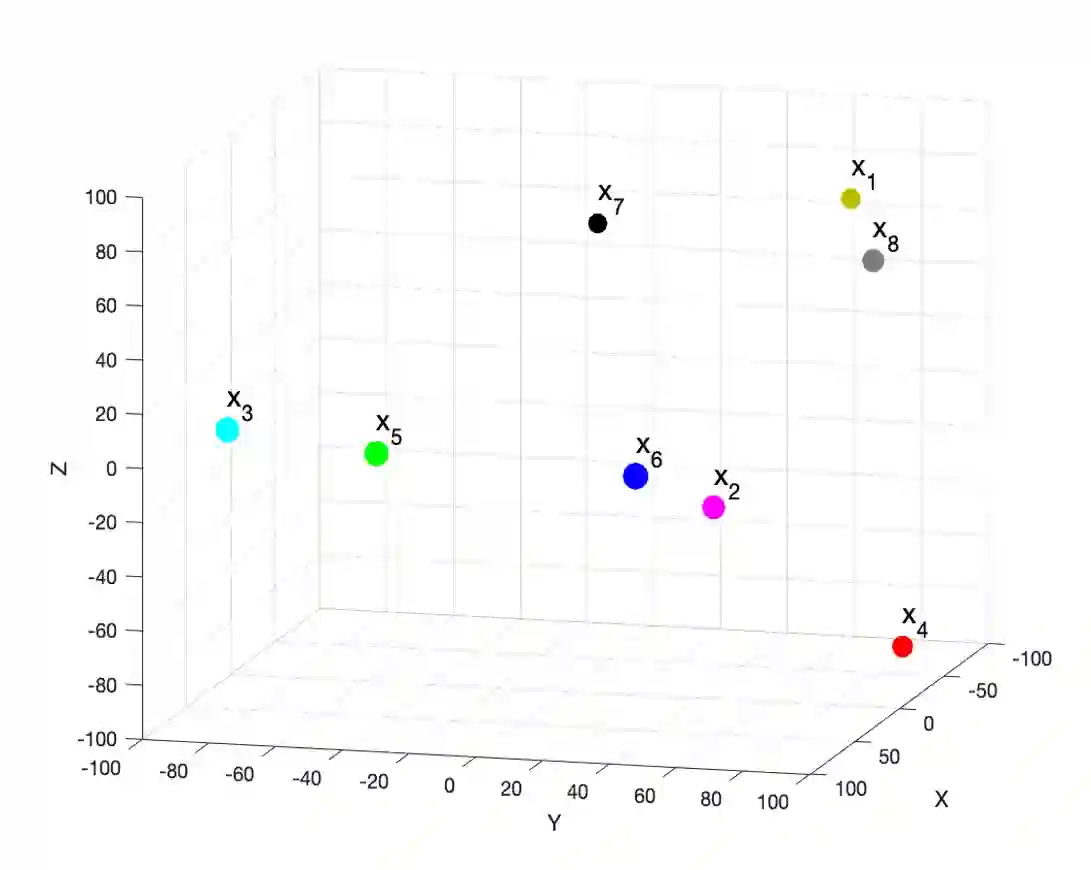

First-order methods for stochastic optimization have undeniable relevance, in part due to their pivotal role in machine learning. Variance reduction for these algorithms has become an important research topic. In contrast to common approaches, which rarely leverage global models of the objective function, we exploit convexity and L-smoothness to improve the noisy estimates outputted by the stochastic gradient oracle. Our method, named COCO denoiser, is the joint maximum likelihood estimator of multiple function gradients from their noisy observations, subject to co-coercivity constraints between them. The resulting estimate is the solution of a convex Quadratically Constrained Quadratic Problem. Although this problem is expensive to solve by interior point methods, we exploit its structure to apply an accelerated first-order algorithm, the Fast Dual Proximal Gradient method. Besides analytically characterizing the proposed estimator, we show empirically that increasing the number and proximity of the queried points leads to better gradient estimates. We also apply COCO in stochastic settings by plugging it in existing algorithms, such as SGD, Adam or STRSAGA, outperforming their vanilla versions, even in scenarios where our modelling assumptions are mismatched.

翻译:随机优化的第一阶方法具有不可否认的相关性,部分是由于其在机器学习中的关键作用。这些算法的差异减少已成为一个重要的研究课题。与很少利用客观功能的全球模型的通用方法相比,我们利用混凝土和L-吸附性来改进由随机梯度梯度或骨骼输出的噪音估计值。我们称为COCOCO denoiser的方法是其噪音观测中多种函数梯度的最大联合估计可能性估计器,但两者之间有共同的共振性限制。由此得出的估计值是二次二次曲线的二次曲线训练的二次曲线问题的解决办法。尽管这个问题很难用内部点方法解决,但我们利用其结构来应用加速的第一阶算法,即快速双极准引力法。除了分析拟议的估计器的特点外,我们从经验上表明,增加查询点的数量和距离会提高梯度估计值。我们还将COCO公司应用在随机环境中,将它插入现有的算法中,例如SGDG、Adam或STRASSA的模型模型模型模型模型模型,也就是我们的VGDA模型。