Facebook 推出双摄手机新玩法:即时3D摄影

点击上方蓝字关注、置顶、标星,获取一手信息

什么叫即时3D摄影?

即时3D摄影是是今年发表在图形图像著名国际会议Siggraph 2018上的工作,该论文名字《Instant 3D Photography》,由伦敦大学学院的Peter Hedman和Facebook计算摄影部门的研究科学家Johannes Kopf合作完成。千言万语不如一个视频来的直接,先来看一段该技术介绍的精彩视频吧!

Facebook的作者表示,3D照片这项成果的研究初衷并不是用来提升和完善当前2D照片的不足,而是从如何让VR内容创作变得更简单的角度出发的,这样Facebook上普通的网友就可以根据该工具构建3D模型或创建VR内容。

该技术的应用还是挺有趣的。比如当你用手机拍摄照片时,该算法可以计算出整个场景的深度,使得普通的2D照片也可以动起来,呈现出多个角度的3D景象。

这些3D照片可以在桌面或者手机App中的Facebook实时信息流中体验到。当你滑动信息流时,这些照片和普通照片看起来没有区别,而当你点击进入照片时,他们立刻突破平面2D的束缚,就像一个小窗口一样,一下子把你拉进3D照片的世界。如下图所示

该技术的原理是什么?

该技术早期的版本是用户移动单摄像头相机来完成,然后通过仔细分析视差以及手机的动作,再以3D形式的进行场景重建。但是通过单个相机拍摄多张照片来推断深度信息需要大量的计算,尽管这种方式能完成该任务,但处理时间较长。由于当今主流手机几乎都具备了双摄像头,后来他们就通过双摄手机来完成3D照片的拍摄。

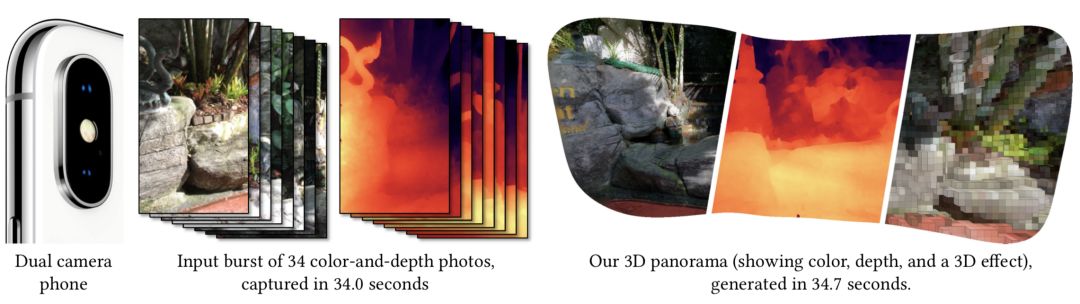

该方法的处理流程图如下图所示。双摄手机每隔一秒拍摄一组图像(彩色图+深度图),对于双摄手机来说,无论拍摄对象处于静止还是运动状态,都可以根据视差获得深度图。如果要获得中等大小的全景图的话,整个端到端方案需要几十秒的运行时间。最后得到的3D全景图非常精细,可以在VR头戴显示器中显示出视差效果。

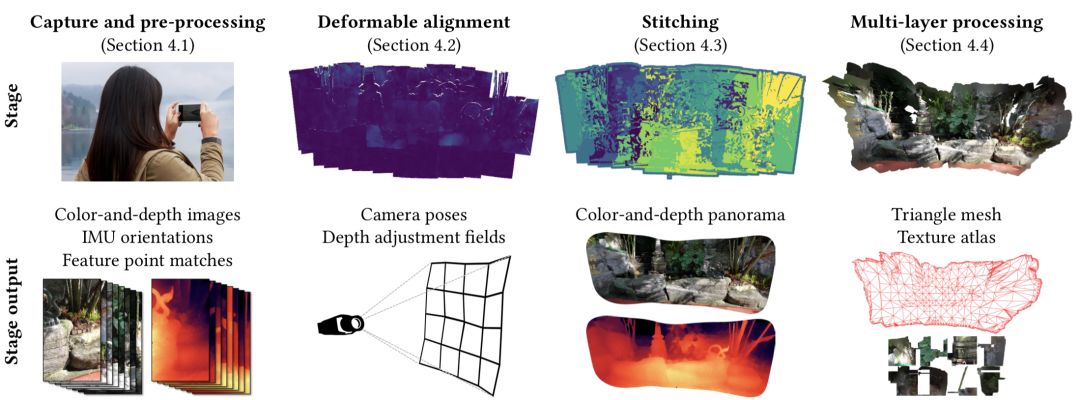

具体来说,算法可以分为四个过程。如下图所示

1、拍照和预处理阶段

算法的输入是一系列对齐好的彩色和深度图对,这些图是用一个定制的拍照捕捉应用程序从一个双镜头手机上获得的。Facebook目前就是采用iPhone的双摄像头。

2、可变深度图对齐

由于小的相机基线及其产生的三角测量的不确定性,导致输入深度图不是很精确,也不可能通过全局转换很好地对齐它们。基于此,该方法使用一种新的优化方法来解决这个问题,该方法联合估计相机的姿态和空间变化的自适应可变深度图,从而更好的对齐他们。

3、拼接

接下来,该方法将对齐的彩色和深度照片拼接为一张全景图。通常这是一个标记问题,并使用离散优化方法来解决。然而,优化标签平滑度,例如,使用MRF求解器,即使下采样速度也是非常缓慢的。该方法使用精心设计的数据项和高质量的深度对齐数据,用基于深度引导的边缘敏感的方法过滤数据项后,用独立优化每个像素的标签平滑度优化取代标签平滑度优化。这在视觉上实现了相似的结果,并带来了超过一个数量级的加速。

4、多层网格生成

在最后一个阶段,该方法将全景转换成多层的纹理网格,可以在任何设备上使用标准的图形引擎进行渲染。并且在深度较强的边缘撕裂网格,并将背面延伸到遮挡区域,在遮挡区域产生新的颜色和深度值。最后进行网格简化并计算了纹理图集。

实验效果怎么样?

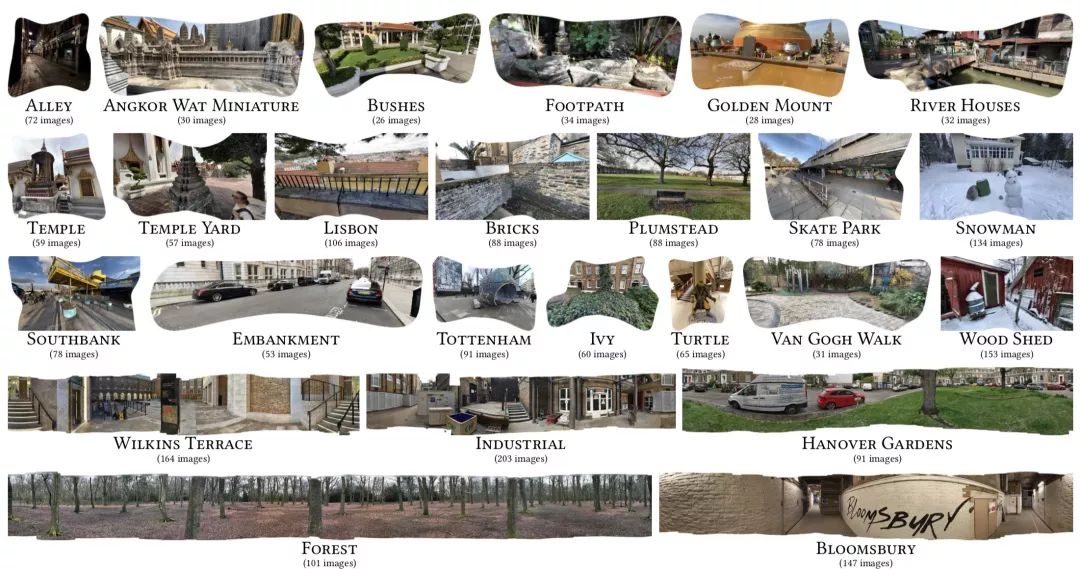

该方法在iPhone7上做了大量测试,包括室内室外,城市风景和自然场景,白天晚上,欠曝光和过曝光等场景。覆盖了从60°到360°的水平视场角。

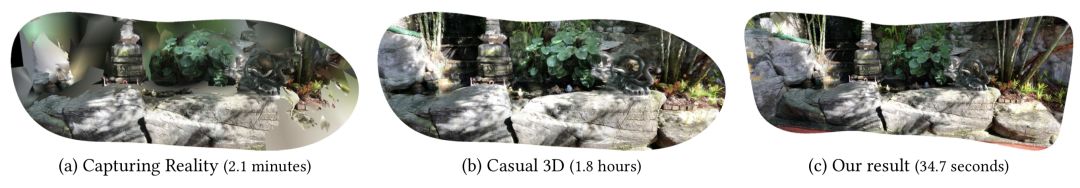

和已有多目视觉系统:Capturing Reality和Casual 3D的对比如下图所示。Capturing Reality方法处理的速度相对慢一点(2.1分钟),不过不太鲁棒,距离超过几米远后重建就会失败。Casual 3D重建结果质量很高,但是速度太慢了(同等情况下需要1.8小时),本文的方法重建结果和Casual 3D相当甚至更高,但是比它快了200多倍,只需要35秒。

更多的详细结果见论文。

另外在论文中,Facebook也讨论了如何用通过另一个卷积神经网络来使得单摄像头的相机也拥有同样功能。不过,使用单摄像头方法生成深度图耗时很久,效果也不如双摄像头系统的好。但是市场空间很大,这还需要算法公司的继续努力,这是一个非常有前景的研究方向。

有什么参考资料?

项目主页:

http://visual.cs.ucl.ac.uk/pubs/instant3d/相关推荐

华为 Mate20 Pro 3D建模,真的能让宅男的手办老婆复活吗?

长按图片关注 “计算机视觉life”

点Ad点赞 = 赞赏