今日 Paper | 4D关联图;通用表征学习;元转移学习;无偏场景图生成等

目录

使用多个摄像机的实时多人运动捕捉的4D关联图

放大学习:将深度立体匹配网络泛化到新颖场景

面向深度人脸识别的通用表征学习

用于零样本超分辨率的元转移学习

基于有偏训练的无偏场景图生成

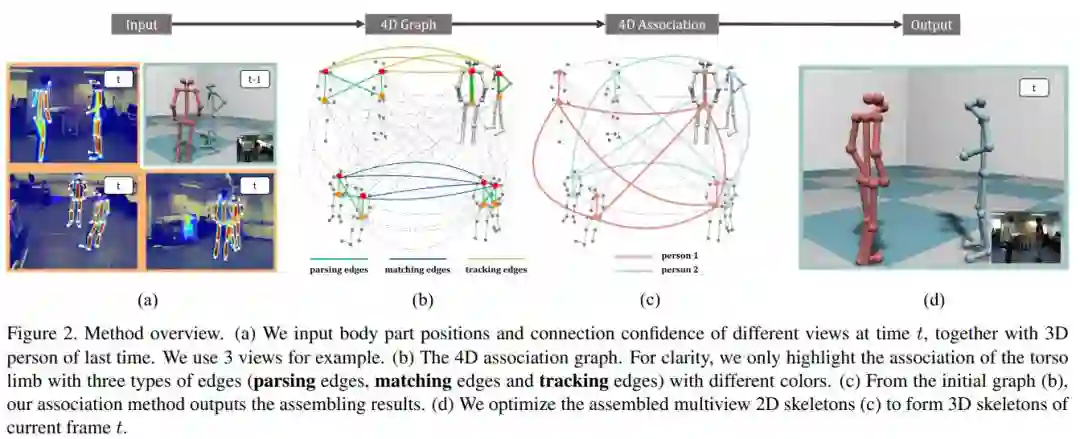

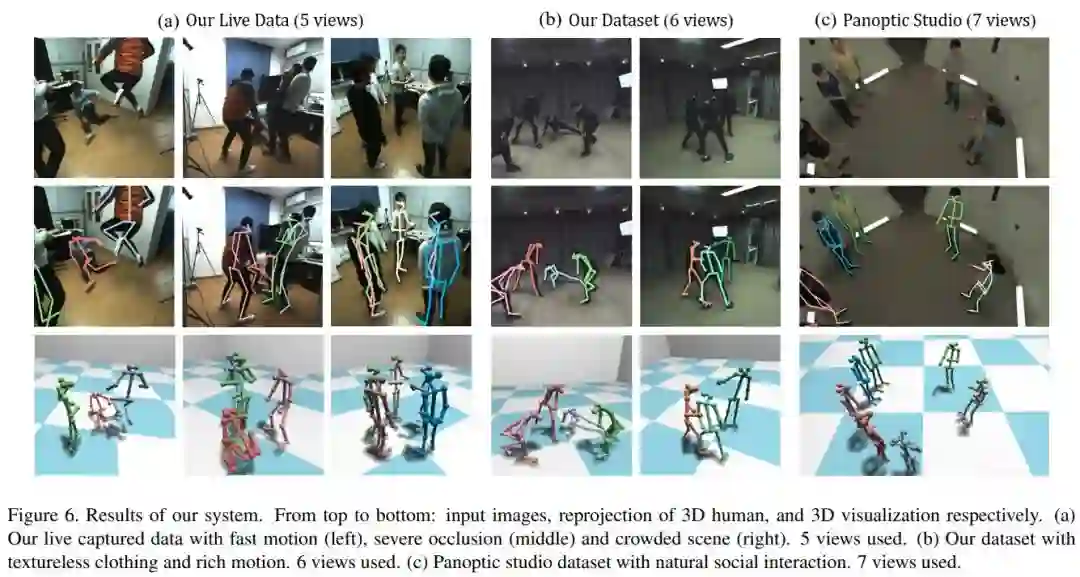

使用多个摄像机的实时多人运动捕捉的4D关联图

论文名称:4D Association Graph for Realtime Multi-person Motion Capture Using Multiple Video Cameras

作者:Zhang Yuxiang /An Liang /Yu Tao /Li Xiu /Li Kun /Liu Yebin

发表时间:2020/2/28

论文链接:https://arxiv.org/abs/2002.12625

推荐原因

这篇论文被CVPR 2020接收,提出了一种新的使用多视点视频输入的实时多人运动捕捉算法,首次将视图解析、跨视图匹配和时间跟踪整合到一个优化框架中,即得到一个4D关联图,该图可以同时平等地处理每个维度(图像空间、视点和时间)。为有效求解4D关联图,这篇论文进一步提出基于启发式搜索的4D肢束解析思想,然后通过提出束Kruskal算法对肢束进行组合。这个新算法可以在5人场景中使用5个摄像机,以30fps的速度运行实时在线运动捕捉系统。新算法不仅对噪声检测具有鲁棒性,还获得了高质量的在线姿态重建结果。在不使用高级外观信息的情况下,新算法优于当前最优方法。

放大学习:将深度立体匹配网络泛化到新颖场景

论文名称:Zoom and Learn: Generalizing Deep Stereo Matching to Novel Domains

作者:Pang Jiahao /Sun Wenxiu /Yang Chengxi /Ren Jimmy /Xiao Ruichao /Zeng Jin /Lin Liang

发表时间:2018/3/18

论文链接:https://arxiv.org/abs/1803.06641v1

推荐原因

本文核心是解决深度立体匹配模型在合成数据上预训练后在真实数据上泛化能力很弱的问题。作者观察到,将真实数据放大后输入由合成数据预训练的模型,其结果比原始大小输入会更加精细化。因此,这种放大真实数据得到的视差图可以作为一种“真实”视差进行监督。另外,作者借鉴图拉普帕斯正则化技术,对得到的视差图进行约束,可以有效去除合成数据上预训练模型产生的噪声和失真现象,并且视差图更加光滑,边缘更加细致。这篇论文也表明了域自适应的两个关键因素:(1)真实数据应当具有较为可靠的“伪标签”监督;(2)视差图需要平滑且保留边缘的约束条件。该论文收录在CVPR 2018。

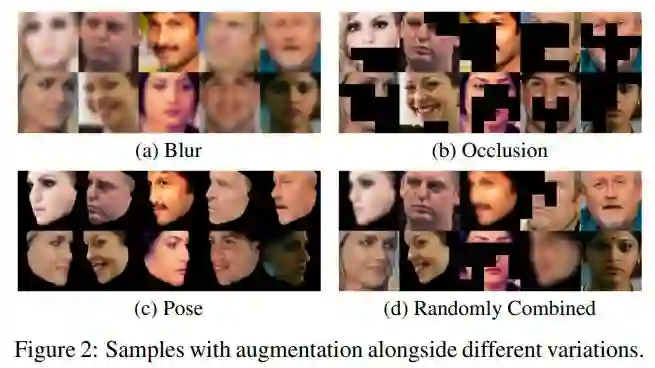

面向深度人脸识别的通用表征学习

论文名称:Towards Universal Representation Learning for Deep Face Recognition

作者:Shi Yichun /Yu Xiang /Sohn Kihyuk /Chandraker Manmohan /Jain Anil K.

发表时间:2020/2/26

论文链接:https://arxiv.org/abs/2002.11841

推荐原因

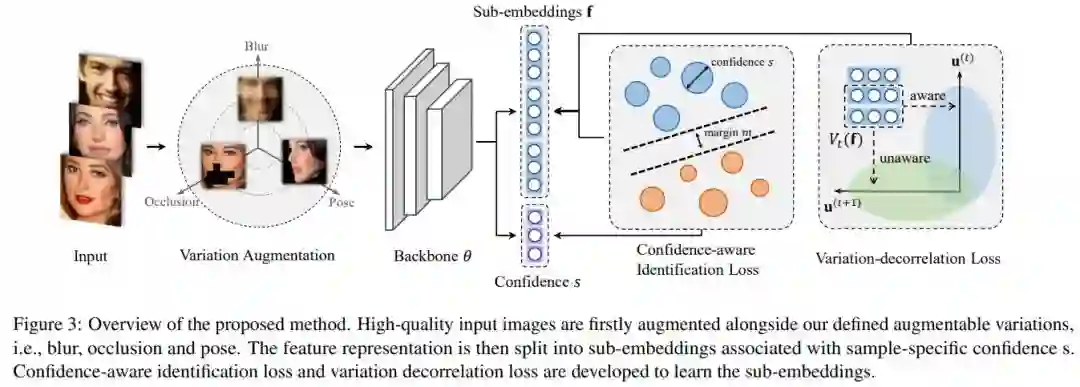

这篇论文被CVPR 2020接收,提出了一种面向深度人脸识别的通用表征学习框架,可以处理给定训练数据中未发现的较大变化,而无需利用目标域知识。新框架首先将训练数据与一些有意义的语义变化(例如低分辨率、遮挡和头部姿势)一起合成。训练过程中将特征嵌入拆分为多个子嵌入,并为每个子嵌入关联不同的置信度值,以简化训练过程。通过对变化的分类损失和对抗性损失进行正则化,可进一步对子嵌入进行解相关。实验表明,新的框架在LFW和MegaFace等常规人脸识别数据集上均取得最佳性能,而在TinyFace和IJB-S等极端基准集上则明显优于对比算法。

用于零样本超分辨率的元转移学习

论文名称:Meta-Transfer Learning for Zero-Shot Super-Resolution

作者:Soh Jae Woong /Cho Sunwoo /Cho Nam Ik

发表时间:2020/2/27

论文链接:https://arxiv.org/abs/2002.12213

推荐原因

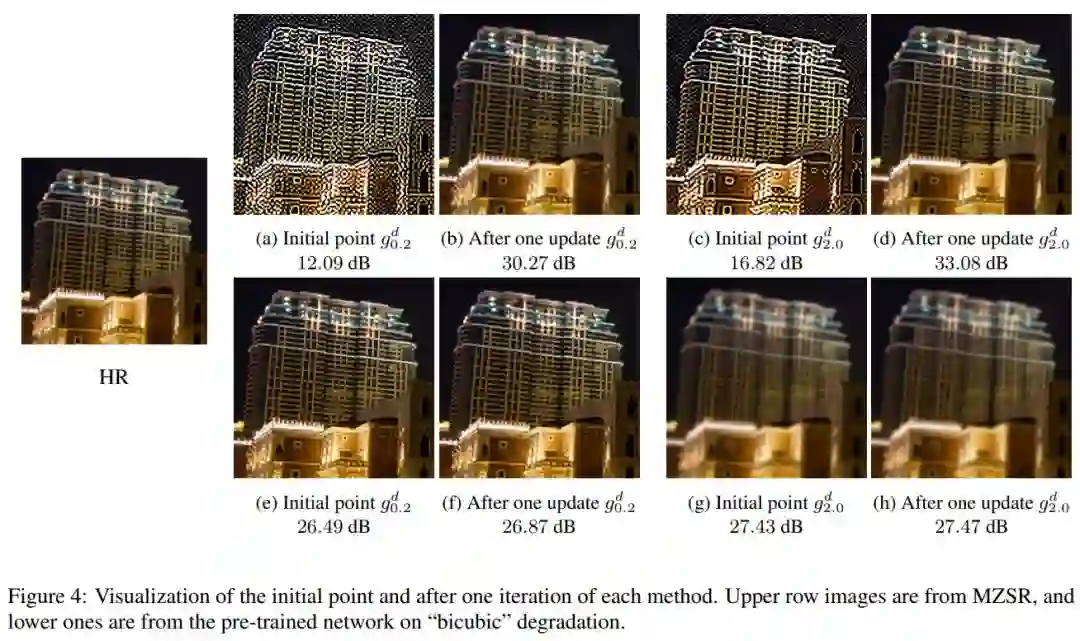

这篇论文被CVPR 2020接收,考虑的是零样本超分辨率的问题。

以往的零样本超分辨率方法需要数千次梯度更新,推理时间长。这篇论文提出用于零样本超分辨率的元转移学习。基于找到适合内部学习的通用初始参数,所提方法可以利用外部和内部信息,一次梯度更新就可以产生相当可观的结果,因此能快速适应给定的图像条件,并且应用于大范围图像。

基于有偏训练的无偏场景图生成

论文名称:Unbiased Scene Graph Generation from Biased Training

作者:Tang Kaihua /Niu Yulei /Huang Jianqiang /Shi Jiaxin /Zhang Hanwang

发表时间:2020/2/27

论文链接:https://arxiv.org/abs/2002.11949

推荐原因

这篇论文被CVPR 2020接收,要解决的是场景图生成的问题。

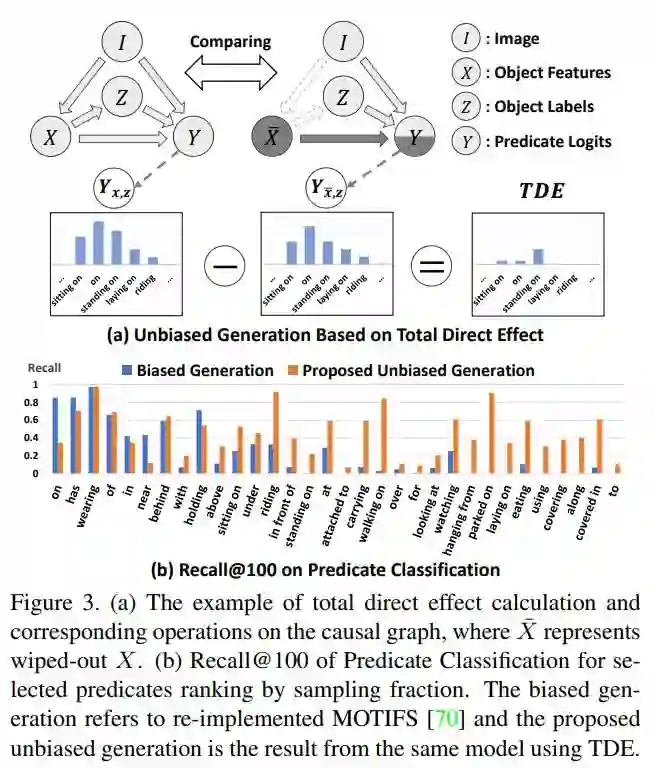

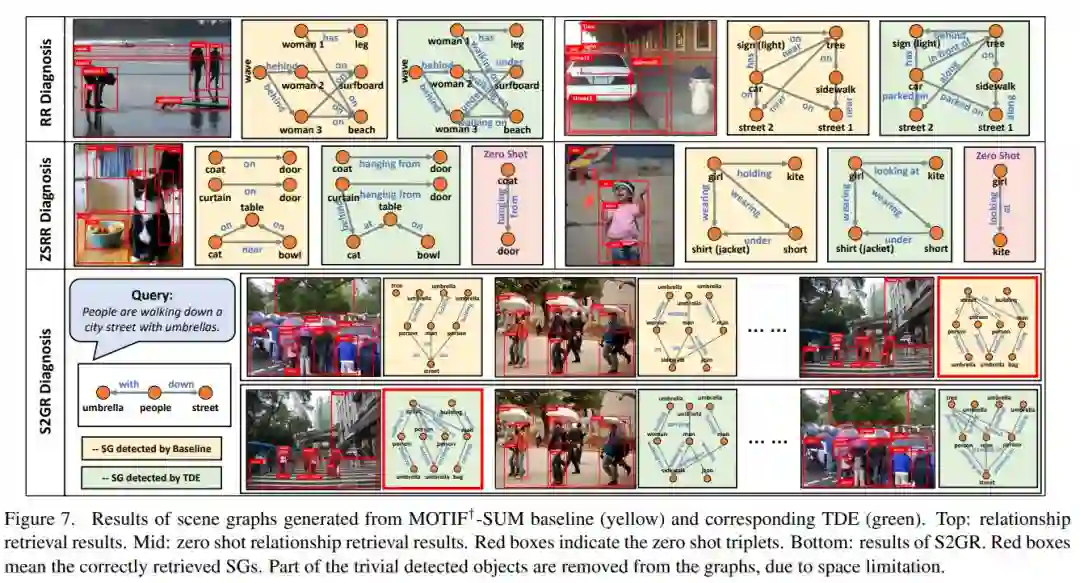

已有的场景图生成容易受有训练偏见的问题,例如将海滩上人类的步行、坐、躺等多样行为类型笼统分为海滩上的人类。这篇论文提出了一种新的基于因果推理的场景图生成的框架。首先建立因果图,然后使用该图进行传统的有偏训练,接着从训练图上得出反事实因果关系,以从不良偏置中推断出影响并将其消除。场景生成基准集Visual Genome上的实验表明这篇论文所提的方法与以前的最佳方法相比有显著改进。

论文作者团队招募

为了更好地服务广大 AI 青年,AI 研习社正式推出全新「论文」版块,希望以论文作为聚合 AI 学生青年的「兴趣点」,通过论文整理推荐、点评解读、代码复现。致力成为国内外前沿研究成果学习讨论和发表的聚集地,也让优秀科研得到更为广泛的传播和认可。

我们希望热爱学术的你,可以加入我们的论文作者团队。

加入论文作者团队你可以获得

1.署着你名字的文章,将你打造成最耀眼的学术明星

2.丰厚的稿酬

3.AI 名企内推、大会门票福利、独家周边纪念品等等等。

加入论文作者团队你需要:

1.将你喜欢的论文推荐给广大的研习社社友

2.撰写论文解读

如果你已经准备好加入 AI 研习社的论文兼职作者团队,可以添加运营小姐姐的微信(ID:julylihuaijiang),备注“论文兼职作者”