ICLR 2022入选论文线上分享预告:一作解读,不容错过

01

ICLR介绍

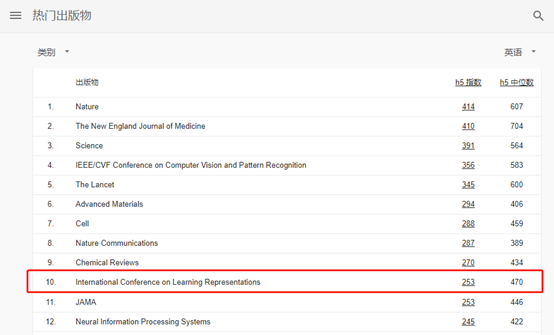

ICLR,全称为International Conference on Learning Representations(国际学习表征会议),自2013年成立至今仅九年的时间,它已被学术研究者们广泛认可,在谷歌学术全领域的热门出版物中排名第十。

谷歌学术“热门出版物”榜单

目前ICLR 2022已经放榜,总提交数量为3328篇,最终有1095篇论文入选,其中Oral 54篇,Spotlight 176篇,Poster 865篇。

02

线上分享

ReadPaper从入选的优秀论文中选出了10篇,其中大部分被评为Oral或Spotlight,邀请到论文的第一作者给大家做线上分享,带来论文的一手解读,聊聊研究背景、实验过程以及背后的科研故事等等。刚好在看论文的小伙伴,一定记得收藏活动,关注直播哟。

在讲解过后,直播还设置了互动问答环节,记得提前准备好提问,千万不要错过了。

线上分享将会在“ReadPaper论文阅读”的B站直播间(http://live.bilibili.com/24493335)进行,详细日程如下:

|

时间 |

嘉宾 |

ICLR入选论文 |

|

3.11 12:00 |

何俊贤 |

Towards a Unified View of Parameter-Efficient Transfer Learning (Spotlight) |

|

3.16 12:00 |

金汶功 |

Iterative Refinement Graph Neural Network for Antibody Sequence-Structure Co-design (Spotlight) |

|

3.16 19:00 |

孟强 |

Improving Federated Learning Face Recognition via Privacy-Agnostic Clusters (Spotlight) |

|

3.18 12:00 |

林森 |

TRGP: Trust Region Gradient Projection for Continual Learning (Spotlight) |

|

3.18 19:00 |

陈骁宇 |

Understanding Domain Randomization for Sim-to-real Transfer (Spotlight) |

|

3.23 12:00 |

金庆 |

F8Net: Fixed-Point 8-bit Only Multiplication for Network Quantization (Oral) |

|

3.23 19:00 |

吴海旭 |

Anomaly Transformer: Time Series Anomaly Detection with Association Discrepancy (Spotlight) |

|

3.25 12:00 |

吴梓阳 |

How Low Can We Go: Trading Memory for Error in Low-Precision Training |

|

3.30 12:00 |

王子丰 |

PAC-Bayes Information Bottleneck (Spotlight) |

|

3.30 19:00 |

董力 |

BEiT: BERT Pre-Training of Image Transformers (Oral) |

03

十问回答

和往常的活动一样,嘉宾们也被邀请入驻ReadPaper,并针对他们的论文进行了非常详尽的“论文十问”回答,亲自阐述了不少有关论文的解析和研究思考。

在观看直播之前,小伙伴们可以点击文末的阅读原文,前往论文十问,先睹为快!

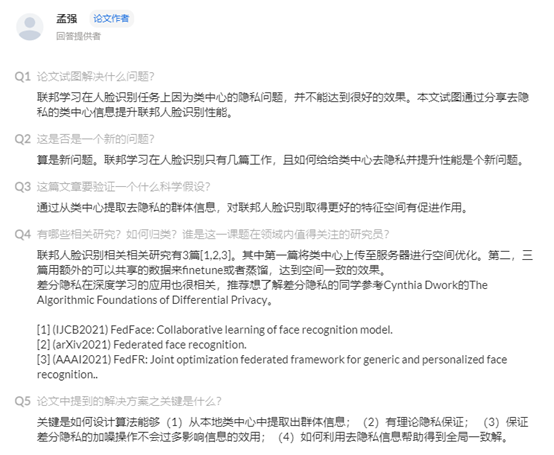

“Improving Federated Learning Face Recognition via Privacy-Agnostic Clusters” 的十问节选

04

嘉宾及论文介绍

▼点击卡片展开▼

点击“阅读原文”进入活动详情页。