CHI 2019丨无论哪种姿势,平板电脑都为你备好了最佳交互界面

编者按:人机交互顶会CHI 2019(ACM SIGCHI Conference on Human Factors in Computing Systems)将于5月4-9日在英国格拉斯哥举行。本届CHI中,来自微软研究院的论文“姿势感知界面”针对用户使用平板电脑时的各异姿势,对更细致的动作捕捉和交互进行了探索。该论文获得最佳论文提名。本文部分编译自微软研究院博客文章“Prototype tablet tricked out with sensors just proves Mom was always right: Posture is important!”。

当你将一台平板电脑拿在手里,接下来你会摆出各种各样的姿势:

你可能坐得端端正正,左手握住平板,右手单手操作;或者陷到软塌塌的沙发里,把平板搁在腿上使用;或者用懒人床上支架架起平板,达成学到睡着的成就……

平板电脑的移动性为人机交互提供了更多的想象空间。在不同的物理环境、使用目的、甚至是不同情绪的影响下,用户使用平板的姿势都会发生变化,包括坐姿、与平板设备的接触程度、抓握和操作的惯用手和手势、甚至是拇指和食指抓住平板的动作细节。

“姿势感知界面”正是针对这一灵活的场景进行设计,应用程序可以感知人们如何握住和操纵平板,在配合触控笔的情况下又会出现哪些动作,为不同的情况提供差异化的流畅交互,以适应用户姿态各异的使用行为。

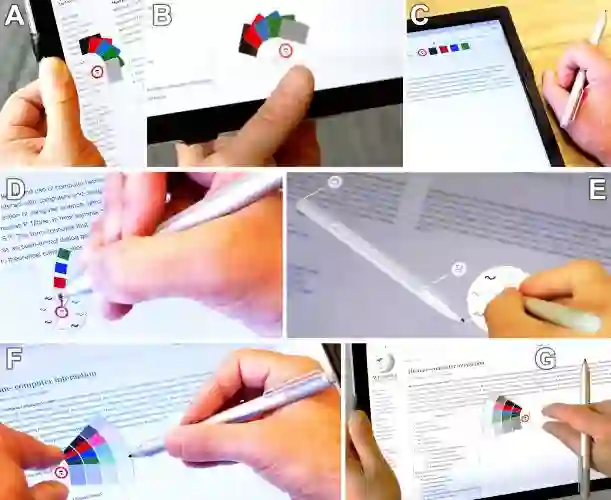

图中展示了一个简单的做注释和标记的应用程序,姿势感知界面根据人们抓握、触摸、标记的细微差别,给出相应的交互响应:

• 当你握住平板电脑,将拇指搭在屏幕上(图中的A和B),拇指工具栏将出现在你的大拇指边。

• 当你将平板电脑平放在桌面上,工具栏会恢复至标准状态,出现在右上角的位置(图中C)。

• 手掌工具将以你的惯用手为圆心展开,以更贴合使用习惯的方向呈现(图中D)。

• 将笔直接放在屏幕上,会出现自定义设置界面(图中E)。

• 如果你把两根左手手指放在屏幕上,系统会显示更多选项,并呈扇形向右打开,方便触控笔点选(图中F)。而如果你把两根右手手指放在屏幕上,系统会向左展开(图中G)。

这些简单的适应都由传感器驱动,通过姿势感知和平滑动画,来为用户提供流畅的交互体验。

那么,姿势感知界面是如何敏锐地感知用户使用行为的呢?

姿势感知界面系统结合了以下三种不同的传感方式:

• 触摸屏检测的完整图像

通过检测用户的双手在触摸屏上运动的图像,来推断用户正在进行的动作。通常来说,触摸屏只感应手指的接触,而图像检测的方法能够感知手部交互的更多细节。

• 倾斜和运动传感器

我们使用设备中内置的加速度计和陀螺仪传感器来感知屏幕的角度和运动位移。这些传感器经常用于自动屏幕旋转,那是微软研究院在大约20年前推出的一项创新。在这一项目中,我们使用这些传感器来推断平板电脑的运动情况,使交互适应用户抓握平板电脑的不同姿势。比如,当你抓着平板在沙发上躺下,平板的屏幕经常自动旋转过来,而我们现在可以结合抓握感应,使屏幕不再自动调转方向。

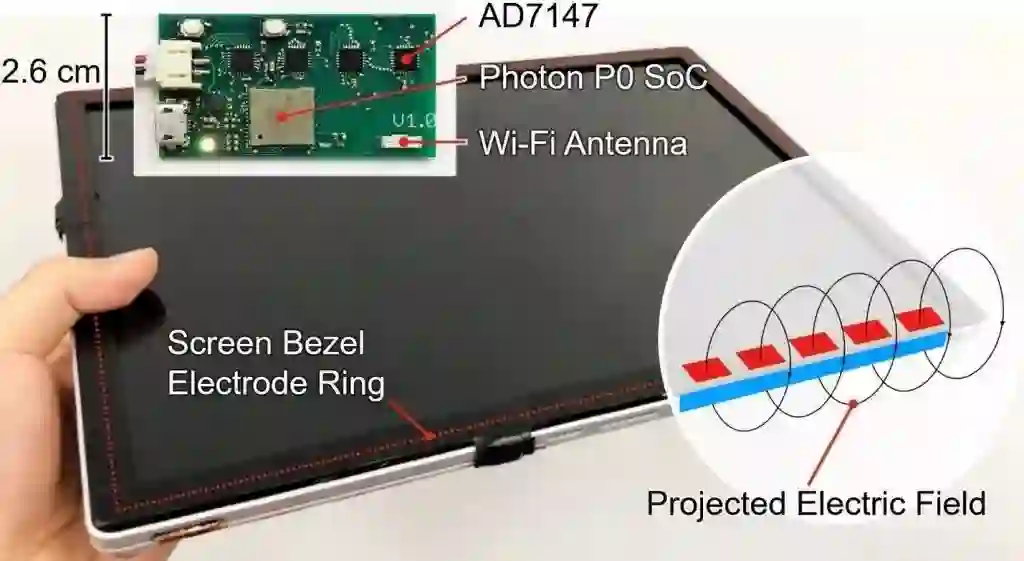

• 外围电场传感器

这是整个传感设置中最关键的部分。

外围电场传感器由电极环和定制电路组成,在平板电脑的屏幕边框下,约50个铜带段组成了电极环,可以较为精细地检测平板周围的电容场,从而感知你的手在什么时候接近或抓住了平板电脑,以及将从哪个方向接触到平板电脑。因此在你的手指触摸到屏幕之前,姿势感知界面就可以感知到你的手部动作并做出响应。

外围电场传感器由下图所示的定制电路驱动。

三种传感器既能单独检测手部抓握屏幕边框的时间、抓握位置,也能组合在一起共同工作。选择这三种传感器元件的原因之一是它们在面向消费者的平板电脑中有实际应用的可能,其中,前两个传感器在商用平板电脑中已经可以广泛应用。

该研究由微软雷蒙德研究院EPIC组(Extended Perception, Interaction, and Cognition)进行,姿势感知界面通过感知用户在使用平板电脑时的不同姿势和使用行为,为用户定制体验更佳的交互和界面元素。

论文:

Sensing Posture-Aware Pen+Touch Interaction on Tablets

Yang Zhang, Michel Pahud, Christian Holz, Haijun Xia, Gierad Laput, Michael McGuffin, Xiao Tu, Andrew Mittereder, Fei Su, Bill Buxton, Ken Hinckley

地址:https://www.microsoft.com/en-us/research/publication/sensing-posture-aware-pentouch-interaction-on-tablets/

在CHI 2019中,微软研究院共有34篇论文入选,其中有3篇论文获得了最佳论文奖,另有6篇论文获得了最佳论文提名。这些有趣的工作都会在格拉斯哥举行的大会现场进行展示,如果你也在CHI 2019现场,欢迎亲自体验哦。

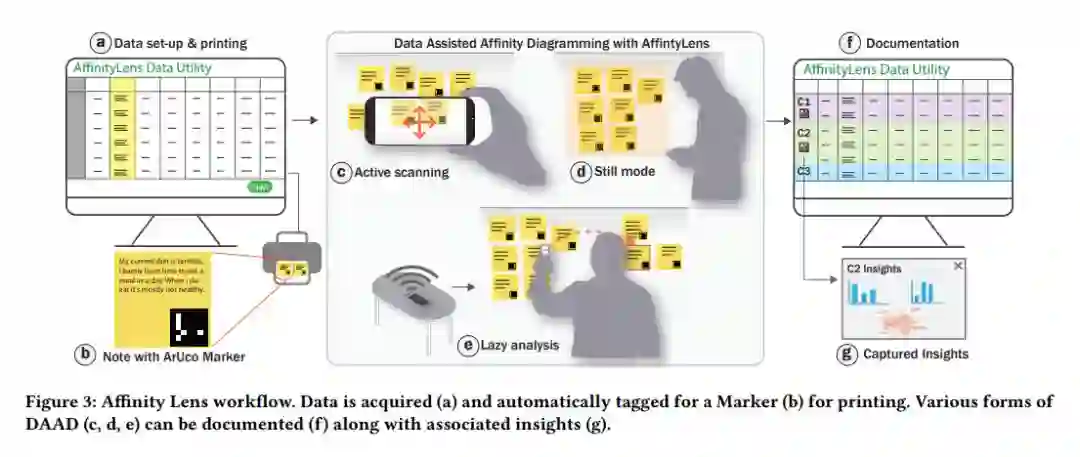

数据辅助的AR亲和图应用Affinity Lens

亲和图法(Affinity Diagrams)是交互设计和用户研究工作中的常用方法,虽然目前可以使用软件,许多人还是更喜欢用纸质便签来做亲和图,因为便签可以随时移动,在分类非结构化数据时格外具有灵活性,也适合协作。但遇到调查等定性、定量数据混合的情况时,从一堆密密麻麻的贴纸中获取数据洞见就变得比较困难。

基于增强现实(AR)的移动应用Affinity Lens就可以帮助人们进行数据辅助的亲和图制作(Data-Assisted Affinity Diagramming)。它通过增强现实技术和多个视图模式的切换,来帮助用户从物理标签中展示、查找、聚类、汇总信息,并在物理便签上呈现实时的数据洞见, 让使用者能在“定性视图”和“定量视图”之间轻松地切换。这项工作在CHI 2019中获得了最佳论文奖。

论文:

Affinity Lens : Data-Assisted Affinity Diagramming with Augmented Reality

Hariharan Subramonyam, Steven Drucker, Eytan Adar

地址:https://www.microsoft.com/en-us/research/uploads/prod/2019/01/AffinityLens_CHI_19-2.pdf

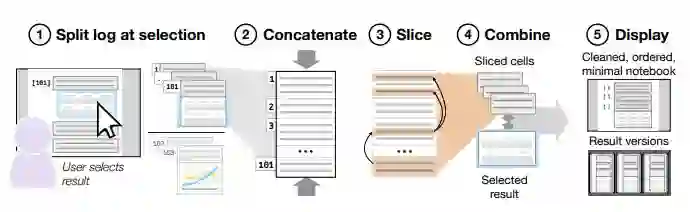

管理和改进计算笔记本中的编码混乱

数据分析师常常使用计算笔记本(Computational Notebooks)来进行探索性的数据分析与可视化,但随着探索性分析的进行,计算笔记本可能会变得越来越乱,产生前后不一致等等情况。这篇论文提出了一种代码清理和收集工具,它可以帮助分析师在混乱的计算笔记本中查找、清理可用代码,生成经过自动清理的新版本,也归档了所有版本的代码输出,允许分析师查看、比较和恢复不同的版本。对12位专业分析师进行的可行性研究表明,这一工具对清理计算笔记本和编写分析代码很有帮助。这项工作也在CHI 2019中获得了最佳论文奖。

论文:

Managing Messes in Computational Notebooks

Andrew Head, Fred Hohman, Titus Barik, Steven Drucker, Rob DeLine

地址:https://www.microsoft.com/en-us/research/uploads/prod/2019/01/Managing_Exploratory_Messes_in_Computational_Notebooks-2.pdf

人工智能交互指南

我们在此前的文章中介绍过这份《人工智能交互指南》。随着越来越多的AI技术被应用于各类产品和服务中,AI设计师面临着许多全新的挑战。微软研究院的研究人员基于前人对搭建高效人工智能交互系统等相关问题的研究成果,整合成了这份全面的交互指南。该指南共分为四个板块,规定了交互初始阶段、用户与系统交互过程中、系统出错情况下以及随着时间推移,人工智能系统分别应该如何表现这份指南不仅为AI设计师提供了具体、可操作的建议,也旨在推动从业者就相关问题展开讨论,推动这一领域研究的进步。这篇论文在CHI 2019中获得最佳论文提名。

论文:

Guidelines for Human-AI Interaction

Saleema Amershi, Dan Weld, Mihaela Vorvoreanu, Adam Fourney, Besmira Nushi, Penny Collisson, Jina Suh, Shamsi Iqbal, Paul Bennett, Kori Inkpen, Jaime Teevan, Ruth Kikin-Gil, Eric Horvitz

地址:https://www.microsoft.com/en-us/research/uploads/prod/2019/01/Guidelines-for-Human-AI-Interaction-camera-ready.pdf

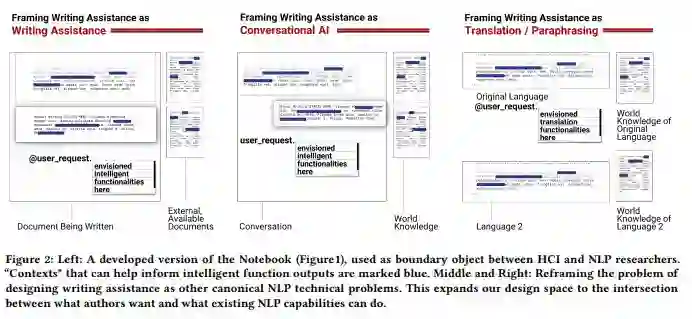

面对大段大段的用户体验描述,该怎么画草图?

用户体验研究和草图设计是交互设计中非常重要的环节。基于用户研究,草图设计通常会用简单、有形的工具(比如画图和纸质原型)快速地表示出一些抽象的想法。但在遇到访谈等基于自然语言的用户体验时,画草图可不是一件易事,有的用户描述出的体验可能很难在草图里抽象化,有的则很难想到一个普遍可行的功能。这篇论文详细说明了这一挑战,并提出了一些新的解决方案,比如专门针对语言交互的新线框格式和快速原型制作方法。这篇论文也在CHI 2019中获得最佳论文提名。

论文:

Sketching NLP: A Case Study of Exploring the Right Things To Design with Language Intelligence

Qian Yang, Justin Cranshaw, Saleema Amershi, Shamsi Iqbal, Jaime Teevan

地址:https://www.microsoft.com/en-us/research/uploads/prod/2019/02/Sketching-NLP.pdf

浏览器“阅读视图”能为读者提升阅读效率吗?

随着人们的阅读场景从纸质转移到线上,许多浏览器提供了“阅读视图”,通过简化网页布局和设计来提高可读性。这一方式真的能为用户改善阅读体验吗?一项由391名受访者(包括42名自我报告患有阅读障碍的人)参与的调查表明,阅读视图比标准界面能使读者平均提高5%的阅读速度,感知可读性和视觉吸引力也有显著提高。 研究建议网站和浏览器进行更多适应性设计,更好地支持具有不同阅读水平的人。

论文:

The Impact of Web Browser Reader Views on Reading Speed and User Experience

Qisheng Li,Meredith Ringel Morris,Adam Fourney,Kevin Larson,Katharina Reinecke

地址:https://www.microsoft.com/en-us/research/uploads/prod/2019/01/Li_Reading-View_CHI19.pdf

相关论文

微软研究院在CHI 2019发表的更多论文,请访问:

长按扫码,查看论文

你也许还想看:

感谢你关注“微软研究院AI头条”,我们期待你的留言和投稿,共建交流平台。来稿请寄:msraai@microsoft.com。