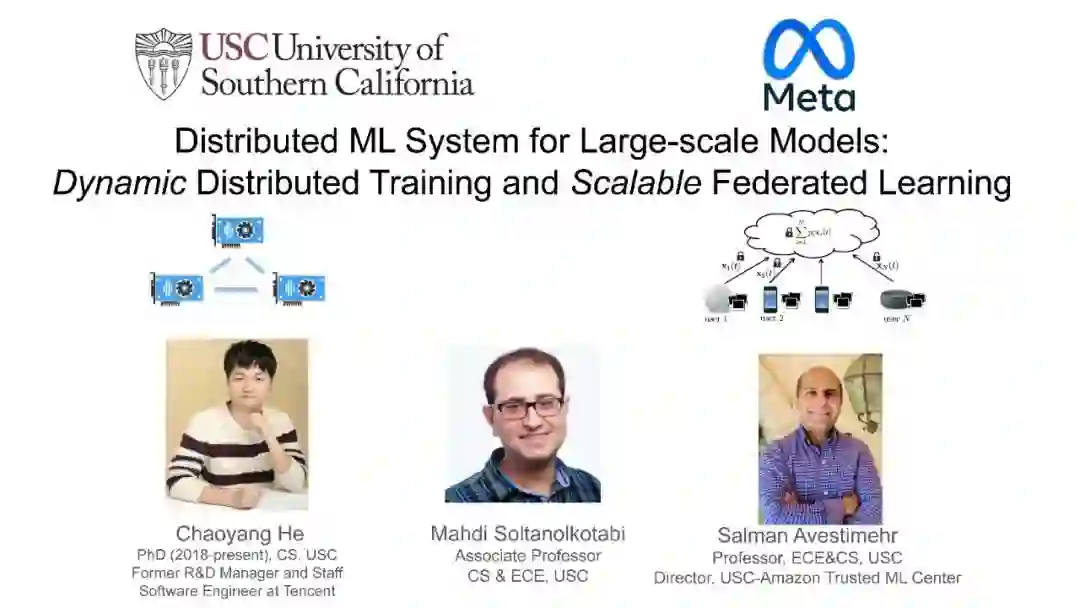

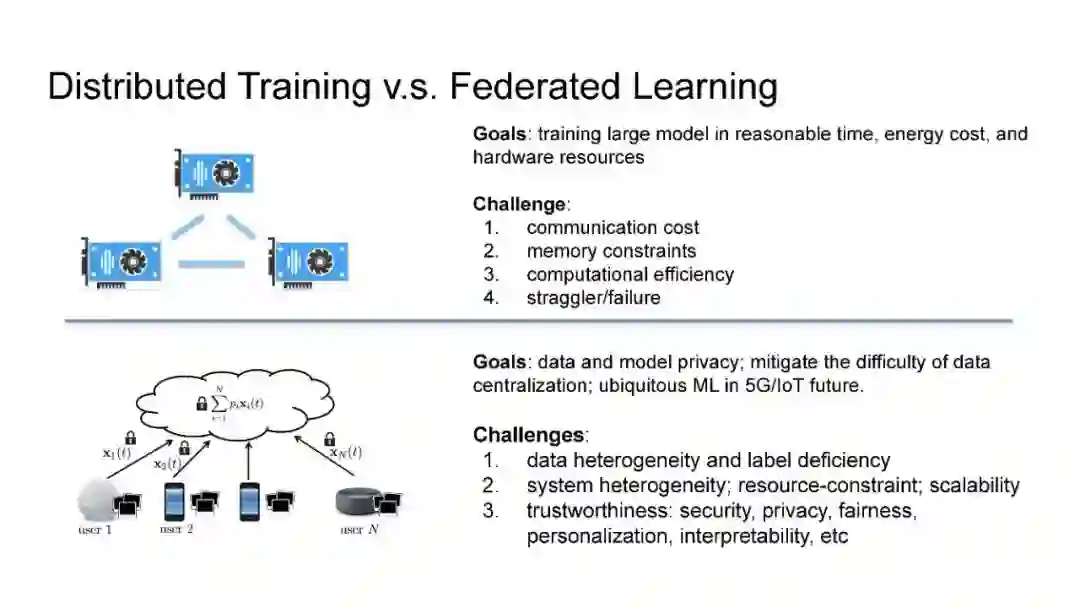

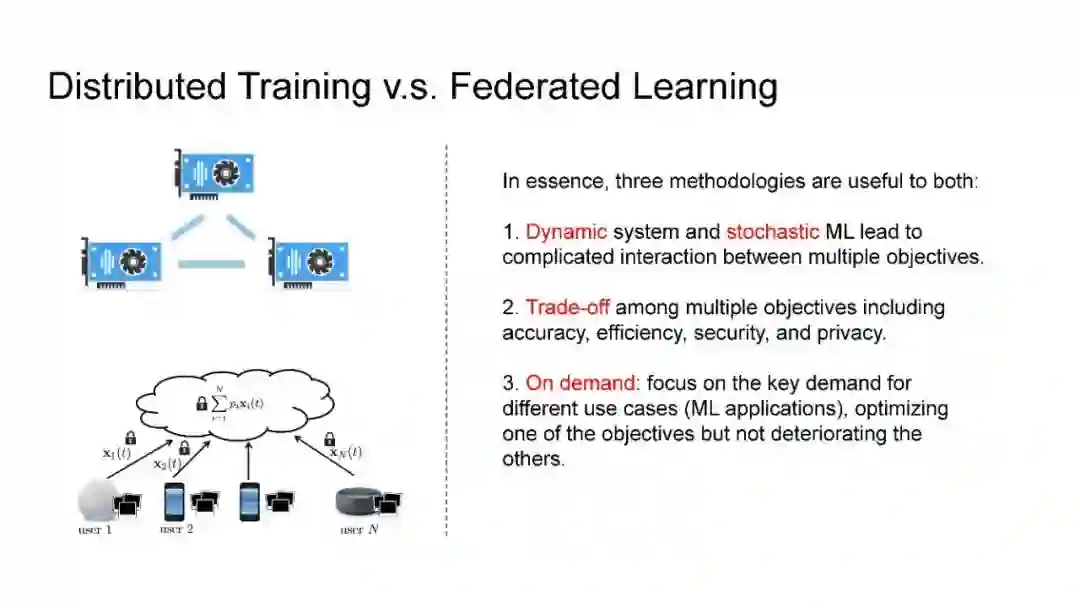

106页ppt附视频!面向大规模模型的分布式ML系统:动态分布式训练和可扩展的联邦学习

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DSLM” 就可以获取《面向大规模模型的分布式ML系统:动态分布式训练和可扩展的联邦学习》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年11月22日