原来神经网络是一种图?

近日,斯坦福 Jure Leskovec 和 Facebook 的何凯明等人提出了一种神经网络的新型的图表示法。该表示法有助于对神经网络的架构和预测性能有更深层的理解。这篇论文已经被 ICML 2020 收录。

本文系统地研究了神经网络的图结构与其预测性能之间的关系。

Graph Structure of Neural Networks

神经网络通常被表示为神经元之间的连接图。然而,尽管它们被广泛使用,目前人们对神经网络图结构与其预测性能之间的关系知之甚少。本文系统地研究了神经网络的图结构是如何影响其预测性能的。为此,我们开发了一种新的基于图的神经网络表示,称为关系图,其中神经网络的计算层对应于沿着图结构的几轮信息交换。使用这种表示,我们表明:

-

神经网络的图结构很重要; -

关系图的“甜蜜点”导致神经网络具有显著提高的预测性能; -

神经网络的性能近似是其关系图的聚类系数和平均路径长度的平滑函数; -

我们的发现在许多不同的任务和数据集中是一致的; -

可以有效地识别顶层结构; -

表现良好的神经网络具有与真实生物神经网络惊人地相似的图结构。

我们的工作为神经结构的设计和对神经网络的一般理解开辟了新的方向。

方法概述

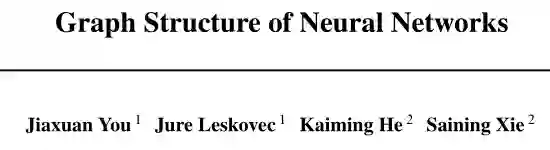

(b)更多神经网络层和关系图的示例。

(c)根据关系图的图度量(包括平均路径长度和聚类系数)来探索关系图的设计空间,其中完全图对应于一个完全连通层。

(d)我们将这些关系图转换成神经网络,并研究它们的预测性能如何依赖于它们对应的关系图的图度量。

本文系统地研究了神经网络图结构与其预测性能之间的关系。开发了一种将神经网络表示为图的新方法,称之为关系图。主要关注信息交换,而不仅仅是定向数据流。

举个简单的例子,对于固定宽度的完全连接层,我们可以将一个输入通道和一个输出通道一起表示为单个节点,关系图中的一条边表示两个节点之间的信息交换 (图1(A))。在此基础上,利用适当的信息交换定义,我们证明了关系图可以表示多种类型的神经网络层(完全连通层、卷积层等),同时摆脱了计算图的许多约束(如有向、无环、二部、单进单出)。一个神经网络层对应于关系图上的一轮信息交换,为了获得深度网络,我们在同一图上进行几轮信息交换。我们的新表示使我们能够建立更丰富、更多样化的神经网络,并使用成熟的网络科学工具对其进行分析。

然后,我们设计了一个名为 WS-flex 的图形生成器,它允许我们系统地探索神经网络的设计空间(即关系图)。基于神经科学的见解,我们通过关系图的聚类系数和平均路径长度来表征神经网络 (图1(C))。此外,我们的框架是灵活和通用的,因为我们可以将关系图转换为不同的神经体系结构,包括多层感知器(MLP)、卷积神经网络(CNNs)、ResNets等,并控制计算预算 (图1(D))。

图上的信息交换

信息交换的一般定义:

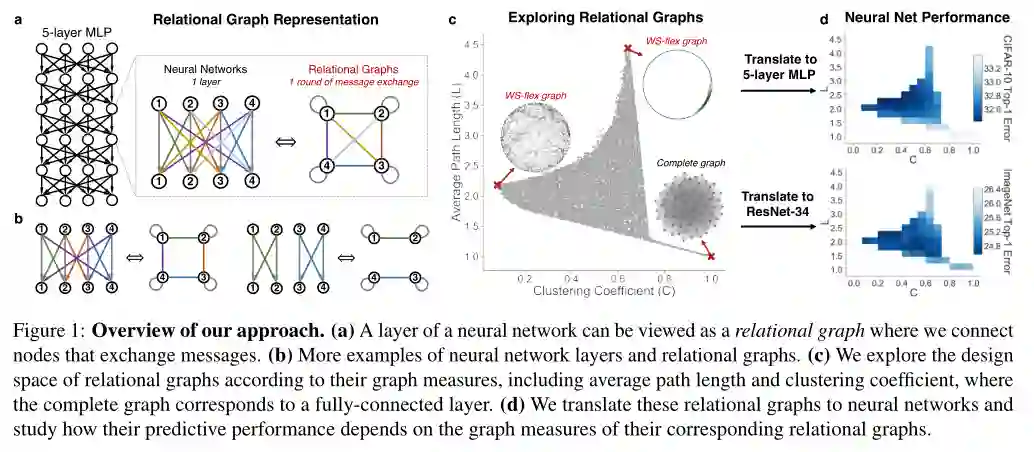

用关系图的语言表达不同的神经结构

关系图提供了神经网络的一般表示。通过正确定义节点特性和信息交换,关系图可以表示不同的神经体系结构。

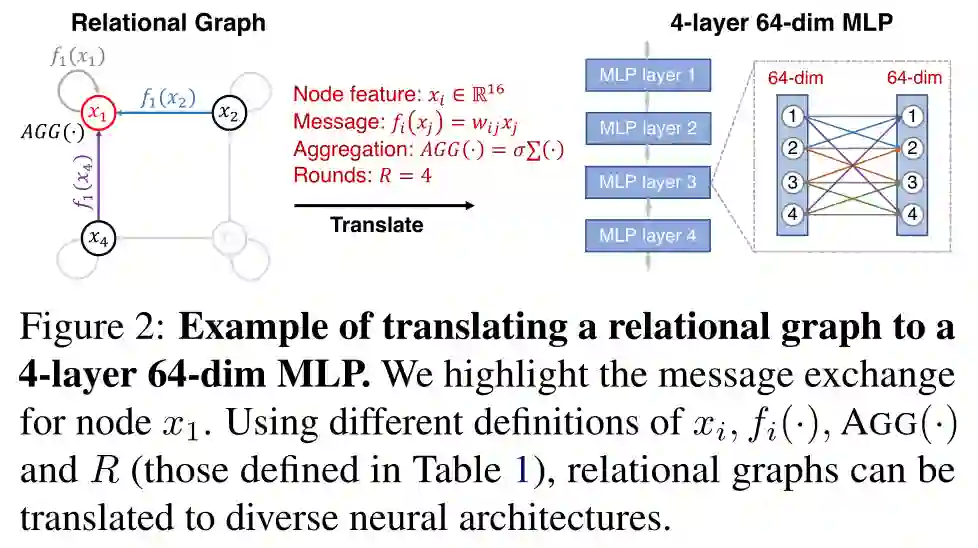

将关系图转换为 4 层 64 维 MLP 的示例

突出显示节点 的信息交换。使用 、 、 和 (表1中定义的那些)的不同定义,关系图可以转换为不同的神经体系结构。

关键结果

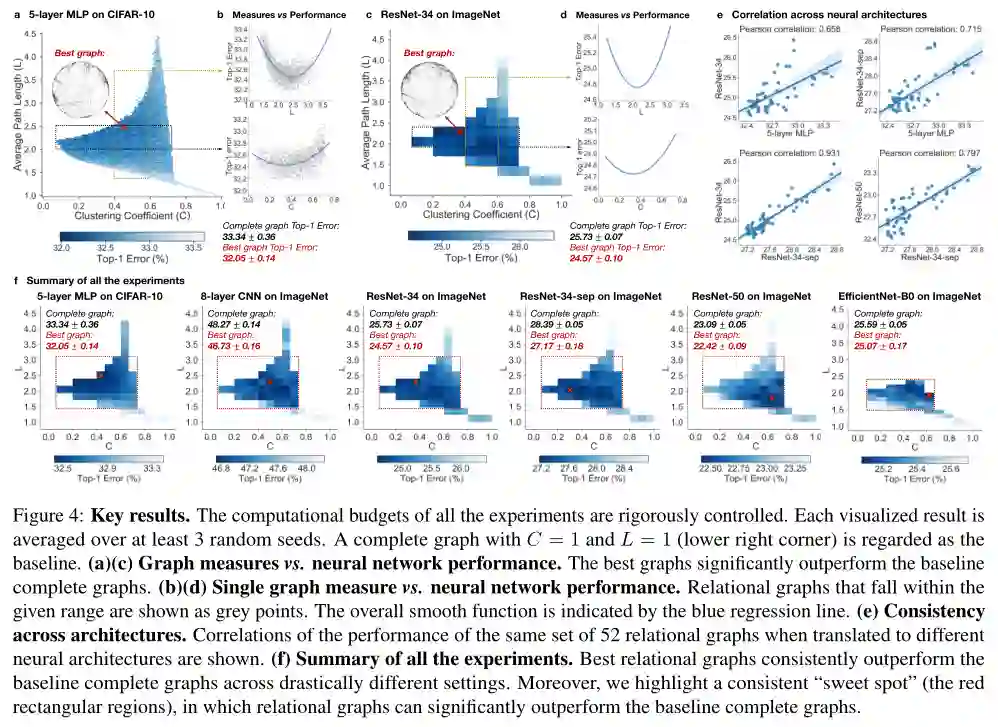

所有实验的计算预算都受到严格控制。每个可视化结果在至少3个随机种子上求平均。

和

(右下角)的完整图被视为基线。

(a)(c)图形测量

神经网络性能。 最佳图的性能明显优于基线完整图。

(b)(d)单图测度

神经网络性能。 落在给定范围内的关系图显示为灰点。总体平滑函数由蓝色回归线表示。

(e)架构的一致性。给出了同一组52个关系图在转换到不同神经结构时的性能相关性。

(f)所有实验的总结。最佳关系图在截然不同的设置中始终优于基线完整图。此外,我们强调了一个一致的“甜蜜点”(红色矩形区域),在该区域中,关系图的性能可以显著优于基线完整图。

结论

综上所述,本文提出了一种使用关系图表示来分析和理解神经网络的新视角。我们的工作提出了一个新的转变,从研究传统的计算体系结构到研究神经网络图的结构。我们展示了其他科学学科(网络科学、神经科学等)提供的成熟的图形技术和方法。有助于理解和设计深度神经网络。我们相信,这可能是解决更复杂情况的未来研究的一个富有成效的途径。

欢迎加入图神经网络技术交流群

进群请添加AINLP小助手微信 AINLPer(id: ainlper),备注图神经网络

![]()

推荐阅读

征稿启示| 200元稿费+5000DBC(价值20个小时GPU算力)

完结撒花!李宏毅老师深度学习与人类语言处理课程视频及课件(附下载)

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

文本自动摘要任务的“不完全”心得总结番外篇——submodular函数优化

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

![]()

阅读至此了,分享、点赞、在看三选一吧🙏