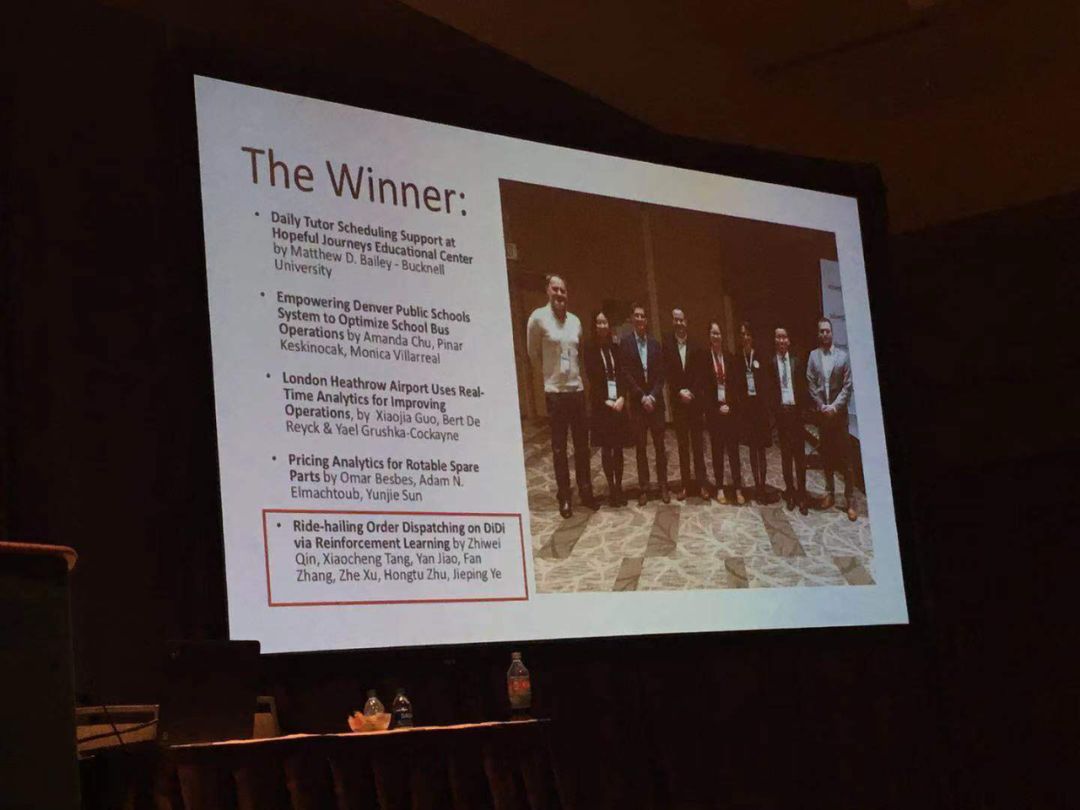

中国首次!运筹学顶级奖项瓦格奖结果出炉,滴滴用强化学习派单获奖!

新智元报道

新智元报道

来源:中国网

编辑:元子

【新智元导读】滴滴因为用reinforcement learning学习半马尔科夫决策过程,并用于派单,获得世界顶级奖项运筹学会(INFORMS)瓦格纳奖,成为该奖项自创办22年以来,首个获奖的中国企业。来新智元 AI 朋友圈与胡郁等AI大咖一起讨论吧~

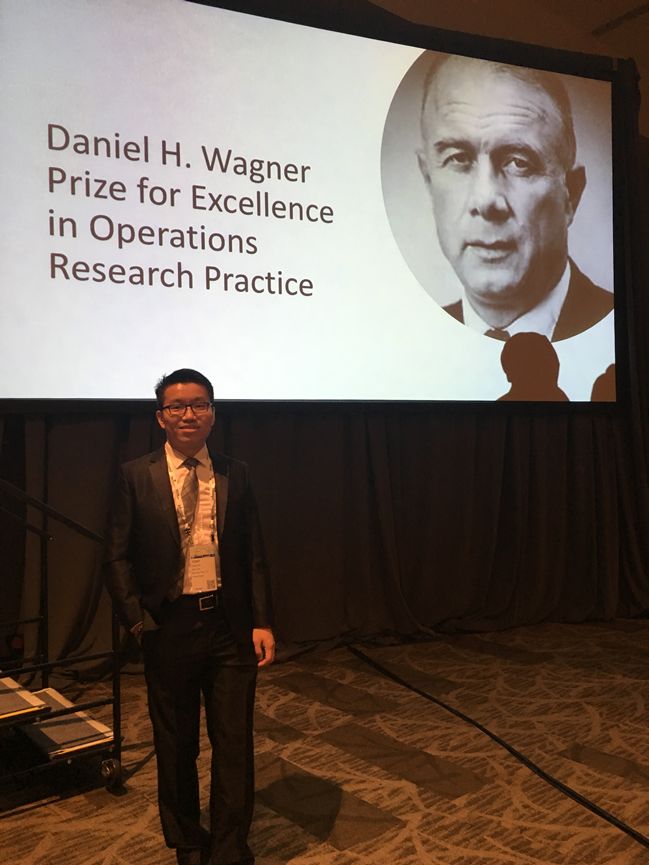

近日,一家被瓦格纳评审委员称为“不知名”的中国企业“滴滴”,获得了2019年度瓦格纳运筹学杰出实践奖(Daniel H. Wagner Prize),轰动了外媒。因为这是该奖项设立至今22年来,首次由中国公司获得!

美国时间10月20-23日,2019年运筹学和管理科学研究协会年会(2019 INFORMS Annual Meeting)在西雅图召开。大会上,滴滴AI Labs团队提出的《基于强化学习的网约车派单解决方案》,在强手林立的入围项目中脱颖而出,成功获奖。

滴滴AI Labs对网约车派单问题进行半马可夫过程建模,提出基于强化学习的泛化决策迭代框架,创新有效的结合了深度强化学习,时间差学习和传统组合优化方法,在确保乘客出行体验的同时进一步提升司机的收入,体现了广泛的应用能力和影响力。

马尔可夫决策过程(Markov Decision Process, MDP)是序贯决策(sequential decision)的数学模型,用于在系统状态具有马尔可夫性质的环境中模拟智能体可实现的随机性策略与回报。

MDP的得名来自于俄国数学家安德雷·马尔可夫(Андрей Андреевич Марков),以纪念其为马尔可夫链所做的研究。

那么马尔科夫和强化学习之间,有什么关系呢?stackexchange上有人回答了这个问题:

在强化学习(RL)中,要解决的问题被描述为马尔可夫决策过程(MDP)。RL中的理论结果依赖于MDP描述与问题的正确匹配。

如果将你的问题描述为MDP,则RL可能是找到解决方案的良好框架。这并不意味着需要完全描述MDP(所有转换概率),而只是希望可以建立或发现MDP模型。

相反,如果你不能将问题映射到MDP上,则RL背后的理论不能保证任何有用的结果。

影响RL工作状况的一个关键因素是声明应具有马尔可夫属性,即当前状态的值足以确定操作选择后的即时过渡概率和即时奖励。再者,我们不必事先知道它们是什么,只需要这种关系是可靠和稳定的即可。如果不可靠,则可能有一个POMDP;如果不稳定,则可能存在不稳定问题。

在任何一种情况下,如果与更严格定义的MDP的差异足够小,您可能仍然无法使用RL技术或需要对其稍加调整。

RL和MDP之间的一般关系是RL是解决可以表示为MDP的问题的框架。

在运筹学 (OR)、管理科学 (MS) 和商业分析领域,INFORMS是全世界公认的最具影响力的权威学会。学会每年均会颁发瓦格纳运筹学杰出实践奖,是该领域的世界级顶级奖项之一。

瓦格纳奖设立于1998年,旨在表彰在运筹学研究实践方面做出突破性的杰出成果。该奖项注重的是项目分析的质量和连贯性,解决方案的独创性和数学应用,以及成功的实践,每年获奖项目被认为是代表了运筹学领域内的最前沿应用。

以往获奖都是国外机构,例如康奈尔大学、佐治亚理工学院、美国疾病控制与预防中心、福特汽车、麻省理工学院、杜克大学、智利大学、英特尔、IBM和普林斯顿大学等。今年首次由中国公司获奖。

参考来源:

https://t.cj.sina.com.cn/articles/view/3164957712/bca56c1002000yvui