从音视频的生产、传输到对内容、用户的理解与个性化推荐,再到技术基础设施建设,快手的布局无愧于「科技公司」的称号

![]()

11 月 6 日,国民短视频社区快手公布了招股书。

令人惊讶的一个数字是,2020 年上半年快手研发投入高达 23 亿,占同期总收入比例高达 8.9%。

我们一般不会将短视频归入高科技行业之列,但是仔细想想,短视频中的科技应用场景其实非常多。比如视频拍摄特效、千人千面的推荐算法、高速低延时的网络基础设施等。

而快手几乎是从成立初始就开始这些技术布局,从生产与消费的体验,到对音视频内容的理解以及针对用户的个性化推送,再到技术的基础设施建设,布局之深厚超乎想象。

现在,拨开「短视频的第一股」的外表,是时候来重新评估快手这家「技术公司」了。

一、内容生产:自研深度学习推理引擎,AI「飞入寻常百姓家」

用快手拍摄短视频,一个非常大的乐趣是能实现各种各样奇妙的 AI 特效。

基于强大的图像 AI 技术,快手在移动端实现了结合自动人像识别、分割、背景生成的实时隐身特效,用户在手机端就可以创作各种有趣的作品。

比如,快手最新上线的「变身童话公主」系列的魔法表情。

![]()

再比如,从天而降的「隐身魔法」是结合单图图像修复和帧间图像对齐的视频修复算法,在短视频行业中的首次应用。

![]()

基于手机上的摄像头和传感器,快手的移动端混合现实技术几乎可以让每一部手机都变成可以实时感知空间信息的设备,实现虚拟元素和真实环境的自然交互和呈现。

该技术可让快手用户不需要复杂的设备,在手机上就能实现基于空间的创意和沉浸式交互体验。

基于深度学习 GAN 技术,快手 2019 年在国内首发了「娃娃脸」特效,使用该表情就能让脸一键回到幼儿时期。在此基础上还有「变性别」「变手绘」以及即将出现的「变童话」等各种应用。

以上都是快手在短视频行的业首发应用,具有技术先进性。

为保持应用的创新性,快手 2018 年就成立了 AI 实验室 Y-tech,招募了许多技术大牛专门负责前沿算法研究,且和魔法表情部门的特效团队合作,加入了产品经理,让技术研究和产品落地无缝对接。

在落地实践上,为克服技术在手机端实时处理的障碍,Y-tech 还自研了一套算法压缩模型,能在有限的计算以及内存资源条件下,依然把模型的计算量降到最小,且不影响算法效果。

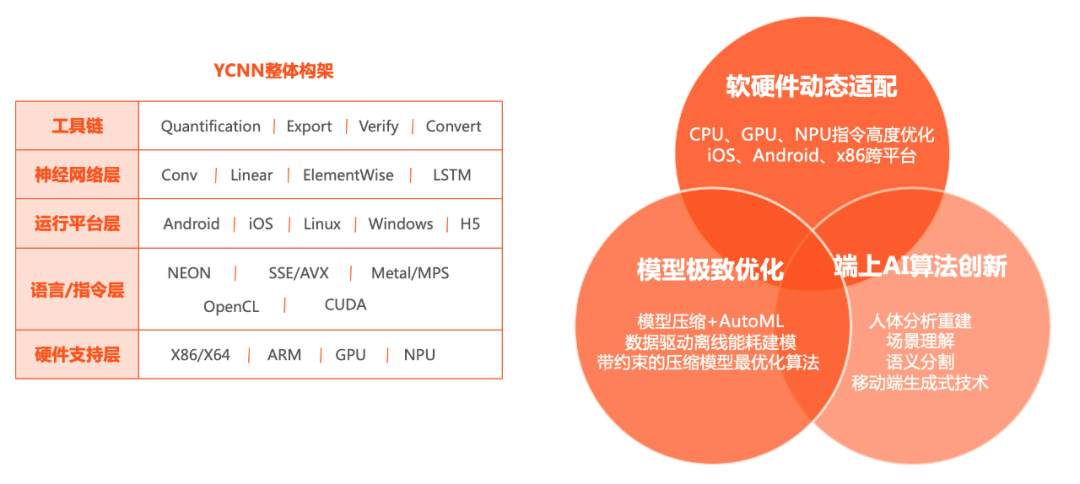

并且,为让特效在所有的手机上都能运行,

Y-tech 同时也自主研发了一款深度学习推理引擎 YCNN

。

YCNN 能支持各种型号的 CPU、GPU 和 NPU 等底层硬件,且能根据不同的手机算力提供大小不同的特定模型,通过模型下发的方式将设备上的最好算力与相应的模型相匹配。

![]()

在推理引擎优化方面,工程师也会针对不同设备端有针对性地进行算子优化,以最大化利用设备性能。

此外,YCNN 引擎还具有完善的 AI 工具链,支持 PyTorch,TF/TFlite 模型直接转换为 YCNN 模型,并支持训练时模型量化与基于硬件的模型结构搜索。综合性能比业界引擎有 10% 左右的优势。

二、音视频传输:自研传输协议 KTP,与直播卡顿较劲

以「拥抱每一种生活」为 slogan 的快手,用户分布在全球各地。打开 App,经常会发现「老铁们」在山沟、田间地头甚至荒野里开直播,但很少出现网络卡顿的情况。

这里面就涉及到快手以

「私有传输协议 KTP 和流式多码率标准 LAS」为代表

的核心音视频传输技术。

这种技术不仅能保证弱网下作品发布的成功率、直播推流的稳定性与平滑性、视频会议等 RTC 应用的低延迟与流畅性,

还能支持端到端高清 1080P 视频的拍摄、制作、上传和播放

,并能依据不同用户的网络状态与设备性能,动态选择最佳的清晰度,在观看体验的流畅性、清晰度、低延迟之间取得平衡。

具体解释,媒体内容从生产到被看见必然要经历网络分发的过程。手机将音视频内容经过采集、编码、处理后,传输到媒体服务器,媒体服务器与 CDN 网络互联,进而由 CDN 分发给快手的用户进行消费。

整个网络传输过程分为上行(媒体内容从主播 / 创作者到媒体服务器)和下行(媒体内容从 CDN 到观众),

针对上下行,快手分别自研了传输协议 KTP 与多码率标准 LAS 来优化端到端的用户体验

。

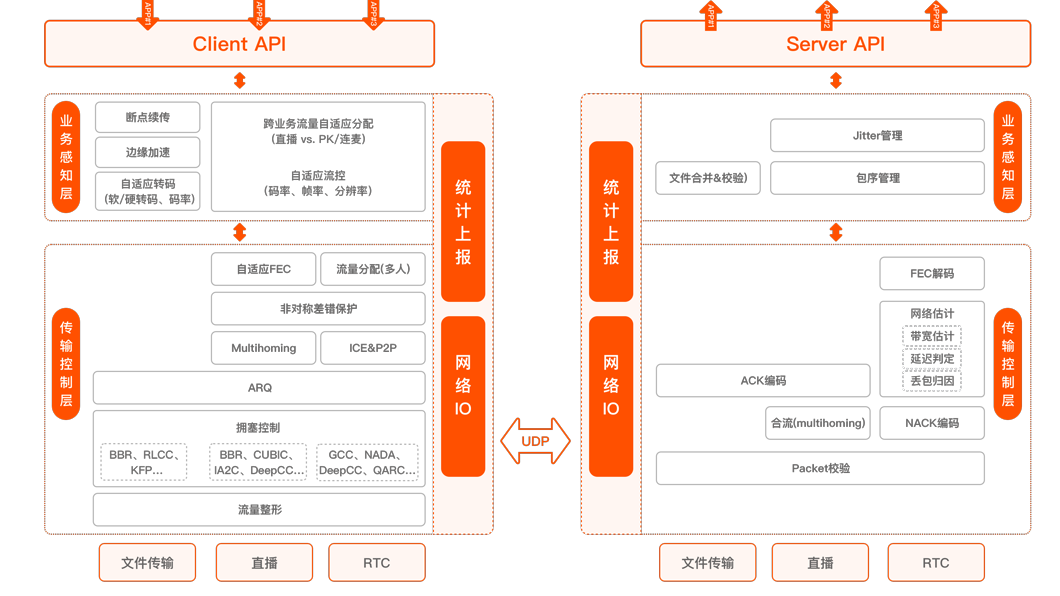

快手的业务复杂,有作品发布、直播推流、PK / 连麦、视频会议、多人互动等等,不同的业务对传输性能的需求各不一样。

例如作品发布要求高吞吐、高可靠、低耗时,直播推流则对低延迟、高平稳性有需求。目前以后的协议与算法,都只关注到某一点,难以满足快手的需求。为此,快手设计了私有传输协议 KTP,其架构如下图所示:

![]()

KTP 基于 UDP,从而具有非常强的灵活性,快手的工程师和算法专家们可以在其之上设计各种各样的传输算法。

KTP 分为服务端和客户端,每端又分为传输控制层与业务感知层,在传输控制层,包含大量的传输算法,可适应各种网络状态与需求,在传输控制层之上是业务感知层,该层是业务与网络的桥梁,通过感知业务的特性与网络的的结合,实现跨层的信源信道联合优化。

目前,KTP 已全面用于快手的各项业务,并取得非常显著的收益,其性能也处于业界领先水平。例如,与 QUIC\SRT 等相比,KTP 能显著降低作品发布耗时,降低直播推流卡顿,提升清晰度。与业界常见的 RTC 产品相比,KTP 能获得更多的延迟,更强的抗弱网能力。

KTP 采用可插拔的设计方式,所有的算法和功能模块相互解耦,从而极大了提升可 KTP 的灵活性与扩展性。同时结合快手强大的 A/B 测试系统,任何算法和改动,都能快速的在线上得到最真实的反馈,从而使得 KTP 保持了领先性与实用性。

LAS:Live Adaptive Streaming

复杂的网络环境导致单一清晰度难以满足不同用户的需求。为了提升所有用户的体验,快手研发了多码率自适应策略,让不同的用户,在各自当前的网络条件下,获得最佳的体验。

针对直播,快手自研了基于流式的直播多码率标准 LAS,并正式对外开源。

目前,各大云厂商均支持 LAS,在云端保障 LAS 服务,咋客户端,快手也开源 Web 端解决方案,并与 B 站共建,联合开源了移动端解决方案。

与大家熟知的多码率标准 HLS 相比,如下图所示,LAS 能获得更低延迟、更高清晰度、更流畅的直播体验。

![]()

除了传输协议,快手在媒体消费体验上的优化与研究也可圈可点:

例如快手先后上线了 60 帧、HDR 等一系列提升视频画质的技术,而且快手现在支持 VR 视频观看,只要下载快手 APP,相当于拥有了一部 VR 终端

在编解码领域,

位于圣地亚哥的快手音视频标准实验室提交的多个提案已经获得了全球联合倡议组织 JVET(ITU-T VCEG 及 ISO/IEC MPEG 联合视讯探索小组)采纳,为其主要贡献者之一

。

在应用方面,快手视频解码标准(KVC)已经于 2020 年 3 月开始大规模部署上线。在主观质量相同的情况下,KVC 可大幅缩减媒体文件的大小,并提高视频播放的流畅度。

当然,作为国内数一数二的短视频平台,仅能让用户看到好看、清晰的视频是远远不够的。

随着视频和用户数量的增多,平台要能保证视频的原创性和安全性,还要能根据用户个性化需求推荐不同的视频。这都涉及到平台对音视频内容和用户的理解,所以,深度学习技术在快手中出现了。

2015 年是人工智能爆发的一年,也正是这一年快手成立了第一支深度学习团队。2016 年深度学习部门开始涉猎语音、文字、音乐等多种媒体形式,所以名称改为「多媒体理解组」(Multimedia understanding,简称 MMU)。

由于快手是较早对视频内容分析产生强烈刚需的公司,所以 MMU 团队基本上是从零起步,从「定义一个合理的标签体系」开始理解用户产出的错综复杂的音视频内容。两大应用方向包括人机交互与信息分发。

从具体场景说,首先多模态技术会帮助用户实现更好的视频创作。

在这方面,

快手目前是中国短视频行业首家成功大规模应用端到端自动语音识别系统的公司

。

一般的语音合成应用都是基于参数语音合成算法,合成的语音比较僵硬。MMU 团队则是采用并改进完全端到端的神经网络模型,可以让合成语音效果更自然,且神经网络结构能利用硬件并行计算能力,支持实时合成语音。

为最大限度保留配音角色说话韵律风格,团队还对算法进行一系列调试,比如在生成算法中加入风格控制回归编码网络以体现韵律性;用基于深度神经网络的声码器以还原声音特点等。

技术支持下,快手有很多有趣的「声音」功能。典型应用是今年快影上线的智能配音功能,用户只要输入文字,软件就能自动将之转化为高质量的视频配音,还有多位「发音人」和方言可供选择。

还有去年上线快手直播间的语音助理「小快」,可以识别语音命令来放音乐、讲笑话,活跃直播间气氛。

另外,MMU 团队还开发了「根据视频内容自动生成音乐」功能,能让视频画面与音乐节奏更匹配,为此,团队还特地招募了懂音乐的人和工程师一起集成创新。

创作之外,多模态技术也能精准的理解视频内容,帮助创造更好的分享机制。

在这里面 MMU 团队做了两个比较有意思的事:

第一是强调音频和视觉的多模态综合的建模,而不仅仅是单独的视觉或者音频

;

第二快手拥有非常多的用户数据,这是不在传统多媒体内容研究范畴里的,但快手却可以很好地利用这些数据做内容理解。

快手会融合行为数据和内容数据进行综合建模

,在同样大小的人工标注量前提下,快手利用海量的用户行为数据能够获得比纯内容模型更好的性能。

![]()

如今,MMU 团队每天可实时分析逾 1500 万条视频及逾百万小时直播内容,已经开发出人工智能驱动的内容算法系统,可对平台海量数据(文本、图片、音频及视频)进行实时多维分析及筛选,还可以实时过滤不当和非法内容以及可能侵犯第三方知识产权的内容。

对于所有的短视频平台来说,「个性化推荐」都是最影响用户感受的环节。

所以,除了要理解内容外,平台还要能将内容推给最合适的客户。在这方面快手做的也不错。

从界面设计看,快手的推荐引擎是全球极少数的双列带缩略图以及上下滑个性化推送界面设计的大型推荐引擎之一。

缩略图可让用户可根据喜好快速挑选想要浏览的短视频及直播,上下滑个性化推送则支持上滑屏幕时自动播放下一个视频,浏览更顺畅。

另外,快手也是短视频行业首批极少数将深度强化学习算法大规模应用于视频推荐的公司之一,其推荐引擎基于自研图神经网络(KGNN)建立。

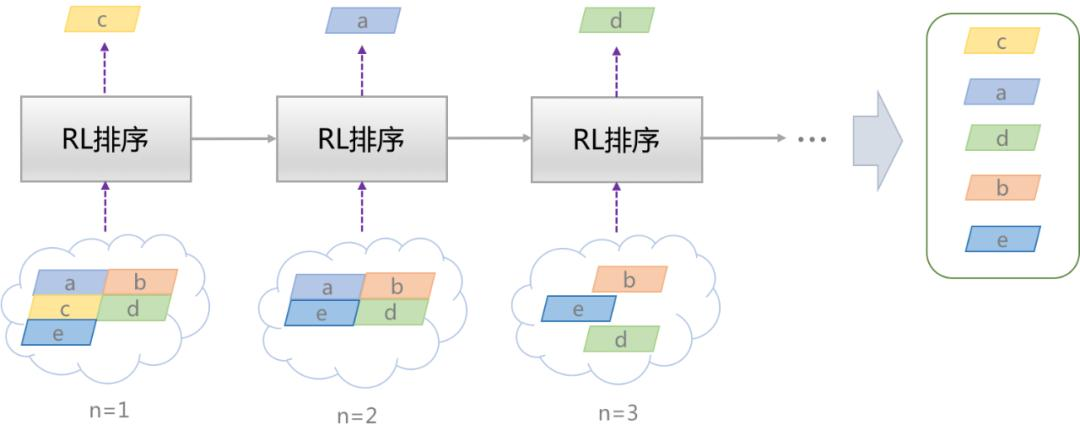

个性化推荐一般分为两个步骤,先是「召回」,从千万量级的视频库中基于简单的模型窜出数百相关候选视频,再「排序」,用复杂模型最终挑选出若干视频(一般数量为十)返回给用户。

在排序的过程中,传统推荐排序算法通常会采用 point-wise 排序框架,基于经验公式或者排序模型,「独立」地预估每个候选视频的排序分数,从高到低截取 top N 视频返回。

但

独立打分的方法忽略了相邻视频间的影响,倾向于将同类视频排到前面,造成推荐内容同质化

,长此以往会使用户对内容厌倦。

所以,快手技术团队提出了基于强化学习的序列化排序框架,将输出 N 个视频序列的任务建模为连续进行 N 次决策的过程。

强化学习排序模型端到端的完成整个推荐排序过程,从数百视频候选集中挑选出由数十个视频组成的有序列表,返回展示给用户

。

![]()

在强化学习排序过程中,每次挑选的目标都是最大化视频序列的整体奖励,保证推荐内容的多样性。

另外,强化学习排序算法还可以保证更好的推荐精准性与实施性,用户每次反馈(点击、点赞、转发)后,系统都会通过强化学习算法完成排序模型的在线更新。

身为一家科技公司,快手能实现以上技术最离不开的就是「基础设施」。

首先是人才,快手在全球各地招募了很多非常优秀的技术人才。根据招股书,截至 2020 年 6 月 30 日,快手拥有逾 5000 名研发人员,超过 2300 名研发人员拥有硕士或以上学位。

2017 年、2018 年、2019 年及截至 2020 年 6 月 30 日,快手研发开支分别为 476.6 百万元、18 亿元、29 亿元及 23 亿元,分别占同期经营开支的 23.1%、26.8%、21.5% 及 13.6%。

并且,快手在全球各地都设有研发中心。人工智能研究中心 Y-tech 专门致力于计算机视觉和深度学习等前沿领域研究,完善快手 AR、滤镜等技术驱动的特效功能。其研究中心位于北京总部,在杭州和美国帕洛阿尔托均设有办公室。

为了拓展海外布局,快手也在美国设立了研发中心。总部在硅谷,这里集成了快手多个重要团队,包括 Y-Tech 、图形 AI、多媒体算法和异构计算实验室。

![]()

西雅图实验室旨在吸引美国优秀人才,建立技术壁垒,承担项目包括商业化广告推荐、游戏 AI 及策略优化、手机端 AI 模型效率优化。

圣地亚哥视频编码标准实验室则主要致力于探索新一代视频压缩技术,研究方向包括视频压缩算法、视频处理、视频内容分析、机器学习及质量评测等。

并且,快手也已经和清华大学联合成立了「清华大学 - 快手未来媒体数据联合研究院」,用产学研结合的方式培养学生用 AI 解决产品上的问题。

在网络基础设施方面,快手目前拥有超过 24 万台服务器,分布在全国 22 个网络数据中心,数据总量是 EB 级别。

此外,快手还

计划在全国布局超大规模数据中心,6 月已经和乌兰察布数据中心项目举行签约仪式,项目投资达百亿元,预计明年投入使用

。

数据中心外,为提高计算效率,快手还针对算法优化,自研基于 CPU/GPU 异构的计算体系,进一步提升算法的运行效率。

如果总结快手技术团队的特征,可以用两个词来形容,「用户导向」和「追求极致」。

技术人员想问题通常会从技术角度出发,但快手会有意识的培养工程师的反向思维能力,考虑用户的需求。

最简单的方式就是研发人员会成为产品的深度用户,自己从用户角度推敲和优化,跟产品经理一起深入研讨如何改进得更好。

比如,在主播与粉丝的音视频连线场景中,很多直播团队在 2016 年就上线了连麦功能。而快手刚上线直播时,产品团队从用户角度做了评估:直接上线视频连麦可能会给用户带来社交压力,如何最小化用户开通连麦的压力?

最容易接受的形式是语音连麦,所以快手最先上线的是技术上简单一些的语音连麦,实时证明用户结束度很高,等到反馈「露脸」需求时,快手才在 2017 年上线视频连麦。

追求极致则是快手技术团队一直以来的原则。2019 年快手 CEO 宿华就在年会上强调过,「不追求极致,我们就赢不了。」

所以,在每一个看似微小的功能背后,快手都会投入非常大的资源,用技术打造极致的用户体验。

正如快手音视频技术负责人于冰曾对媒体说的,

「我们给了最优秀的技术人员一个很好的机会——把特别细的细节做好,不像有的产品只做到 80 分就够了。」

本文为机器之心原创,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告 & 商务合作:bd@jiqizhixin.com