最强读心术!脑波直接转语音,你的秘密已无处藏身 | Nature子刊

晓查 安妮 发自 凹非寺

量子位 出品 | 公众号 QbitAI

不动口也不动手,该怎样与人交流?

靠眼神吧略显暧昧,靠第六感吧又不太靠谱,这道题有解么?

有,用万能的AI啊。最近,Nature子刊Scientific Reports上报道了一项新技术进展:监测一下脑电波,AI就能还原你听到的声音。

来,我们听听下面这段效果展示:

△ 你来听听

你一定听出来了。没错,音频内容就是用英语从0念到9。研究披露,普通人理解并重复这些声音的准确率达到了75%,效果远超以往同类研究。

把大脑活动直接转化成语音,这项研究潜力炸了。

目前,系统只能恢复人类听觉区信号的简单词汇,但研究者最终想找到脑电波与语音的关联,让失去语言能力的人重新开口说话。

想象一下,失语的渐冻人或中风患者只要头戴脑机接口设备,就能将所思所想直接转化为文字语音。

不过,所有秘密也会随之暴露,谁让这是当代版最强“读心术”呢。

AI“读心”

这项研究来自哥伦比亚大学电气工程学院副教授Nima Mesgarani团队。他们在一系列实验的基础上,完成了这一研究。

△ Nima Mesgarani本人

实验开始前,研究人员选择了五名接受癫痫治疗的患者作为实验对象。研究人员采用植入性脑皮层电图(ECoG)方法进行测试。所以实验第一步就是,保证每个人脑中都已嵌入电极。

随后,5位受试者开启了听音测试状态,如同大学英语考试,两位女考官开始读单个数字。

这份“听力材料”的难度不大,内容范围就是从0~9这10个数字。女考官随机读出,前后共读了40个数。

受试者只需要坐在那里,通过脑机接口用模型重建语言信息,最后由电脑读出来。

那么问题就是,整个重建流程是怎样的?

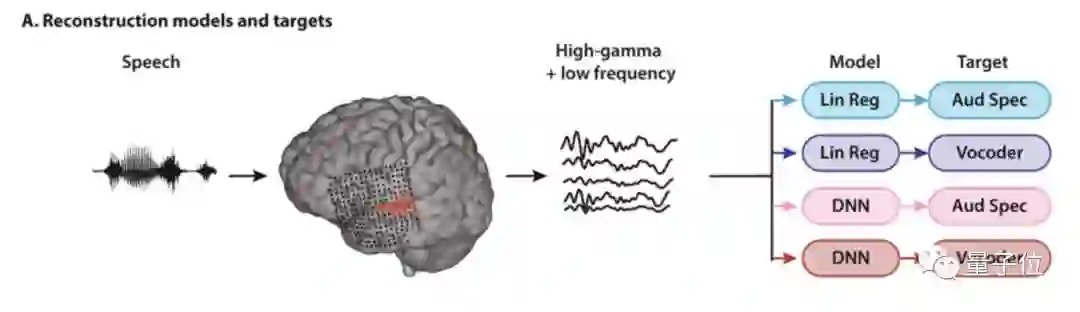

在这个过程中,受试者接受到声音,经过耳蜗时声波信号被转化成了神经电信号,经过前庭神经传递给大脑处理。

大脑听觉皮层的神经网络此时开始活跃,神经电信号同时也被电极所接收。

研究人员收集这些不断变化的信号,提取其中的有效信息,也就是高γ包络(HG)+低频(LF)信号。随后,就该根据这些信号重建声音了。

研究人员用两种回归方法与两种重建的语音表示,探究两两组合情况下哪种重建方法效果最好。这样一来,整个重建过程就分成了四种不同的方法,分别是:

(浅蓝)线性回归+听觉图谱(Aud Spec),简称LAS

(紫色)线性回归+声码器,简称LV

(粉色)非线性深度神经网络(DNN)+(Aud Spec),简称DAS

(红色)非线性深度神经网络(DNN)+声码器,简称DV

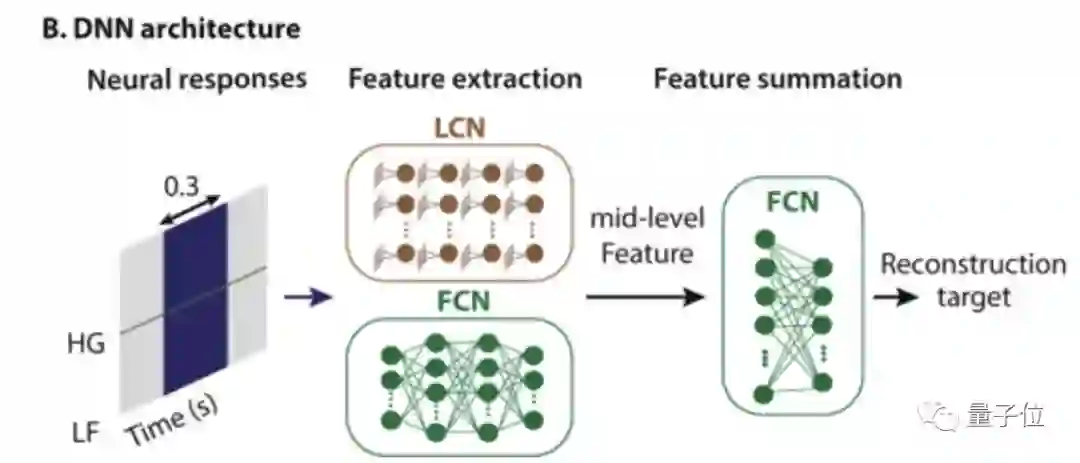

这里的DNN架构由两个模块构成,即特征提取网络和特征求和网络。前者由全连接神经网络(FCN)与局部连接网络(LCN)构成,后者为一个双层全连接神经网络(FCN)。

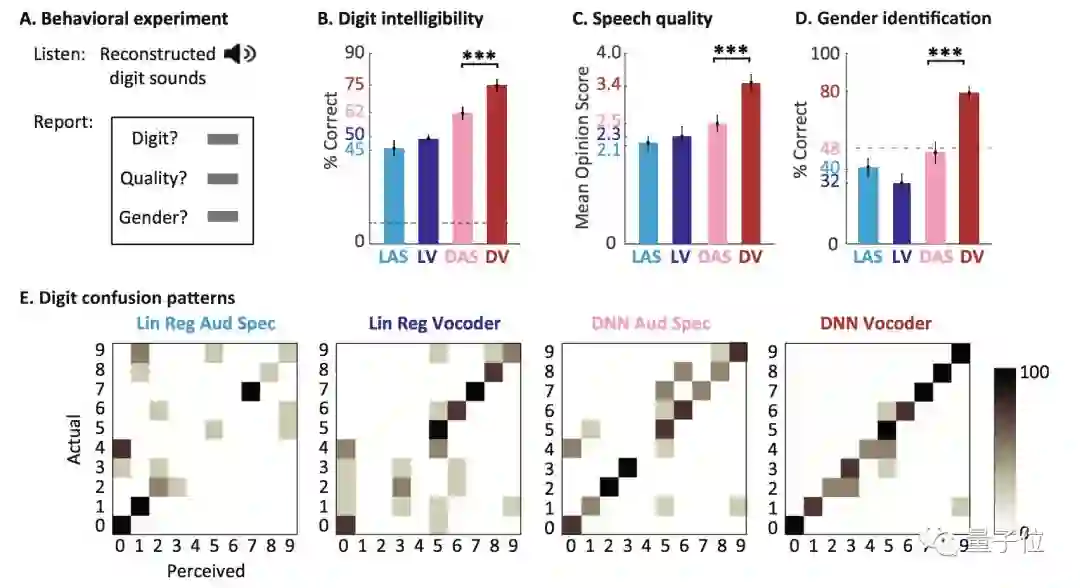

在评估测试结果时,研究人员找来了11位听力正常的志愿者,随机收听用四种模型组合重建的音频效果。如同大学英语4级听力一样,每个句子只读一遍。

最后,志愿者理解与复述所听内容,研究人员统计平均结果及平均意见得分(MOS)。

结果显示,非线性深度神经网络(DNN)+声码器组合(红色,DV)的还原度最高,志愿者的正确还原率达到了75%,且MOS得分最高,达到了3.4分。

此外,在志愿者对受试者语言性别判断中,DV的准确识别率也是组合中效果最好的,性别正确识别率达到了80%。

如果你对研究的详细内容感兴趣,可以看下他们团队已经发表的论文:

Towards reconstructing intelligible speech from the human auditory cortex

传送门:

https://www.nature.com/articles/s41598-018-37359-z

困难亦重重

以上种种,都不是件容易的事。

“我们尝试搞清楚神经元在不同时间点打开和关闭的模式,并推断出语音。”Nima说:“这种映射关系并不是那么直接。”

脑电波转换成语音的模式因人而异,所以模型需要针对每个人单独训练。而且只有极其精准的信号才能得到最佳结果。怎么才能获得最精确的脑电波?

目前答案只有一个:开颅。

但是,能够打开头骨进行研究的机会非常之少。

要么是在切除脑肿瘤期间,外科医生需要读取脑电波帮助定位,避免术中伤及语音和运动区域;要么就是癫痫患者手术前几天,开颅并植入电极以确定引发癫痫的部位。

“留给我们的时间最多只有20、30分钟。”来自瑞士日内瓦大学的Stephanie Martin表示,收集数据的时间非常、非常之有限。

但,还有比开颅更困难的事情。

目前的进展,其实只是还原了一个人听到了什么,想更进一步怎么办?比如一个失语者想说点什么,这套算法还管用么?

加州神经学家Stephanie Riès表示,当一个人默默“说话”时,脑电波肯定与聆听时不同。没有与大脑活动相匹配的声音发出,计算机甚至很难理解大脑内部一段话开始和结束的时间。

而人类目前的技术水平,可能根本不知道如何才能做到这一点。

荷兰马斯特里赫特大学的Christian Herff提供了一个思路:

当你听到一个声音时,在大脑里迅速默念出来,只要对人类和神经网络充分的训练,或许AI最终能具备完完整整的“读心术”。

从大脑打字到大脑发音

自从计算机发明以来,人类一直希望实现脑机交互,也就是“脑后插管”。

在两年前的F8开发者大会上,Facebook现场演示了如何让一位渐冻症患者用大脑打字,速度可以达到每分钟8词。速度虽然不及手打,但对于残障人士来说是巨大福音。Facebook未来的目标是实现每分钟100词的速度。

国内也有神经科学团队在从事这项研究,去年量子位就现场体验了清华大学实验室的“意念打字”,控制屏幕软键盘上的26个字母就能打出任何语句。

去年,京都大学的科学家再大脑控制键盘的基础上再进一步,恢复了人脑中的图像。不仅仅是简单的符号,而是拥有多种颜色和结构的照片。

有了这项技术,以后就可以轻易地知道一个人曾经发生过什么事,去过哪些地方,甚至连白日做梦的场景都可以被读取出来。

但语音才是人类与外界沟通最主要的方式。哥大的研究如果真的迈向实用化,前途不可限量。

One More Thing

研究之外还有福利~

放出这项研究的同时,研究人员还开放了神经声学处理库Nap Lib,可用于表征语言神经网络表示的各种属性。

Nap Lib同时适用于植入性和非植入性设备,是脑电图(EEG)、脑皮层电图(ECoG)和脑磁图(MEG)研究中的通用工具。

Nap Lib简介:

http://naplab.ee.columbia.edu/naplib.html

GitHub地址:

https://github.com/Naplib/Naplib

— 完 —

加入社群

为给AI从业者提供更好的交流平台,量子位现开放「AI+行业」社群,将会不定期邀请AI大咖、知名企业家、技术大牛进群分享,福利多多,欢迎小伙伴入群交流。

面向人群:AI相关从业者,技术、产品等人员,根据所在行业可选择相应行业社群;

入群方式:请在量子位公众号(QbitAI)对话界面回复关键字“行业群”,获取入群方式。

Ps.为保证社群价值,小助手会对申请入群的朋友进行审核,请大家理解!

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

喜欢就点「好看」吧 !