EMNLP 2019 | 基于层次化注意力图网络和多视角学习的商品推荐

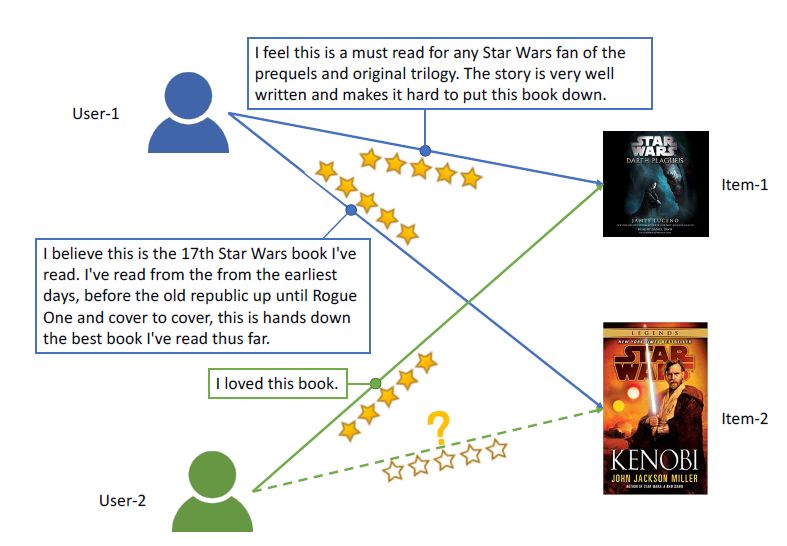

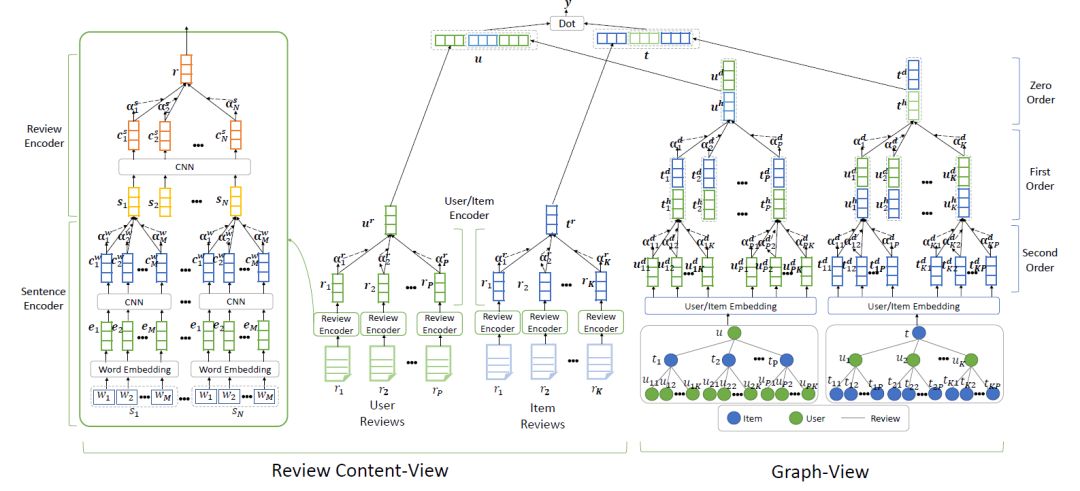

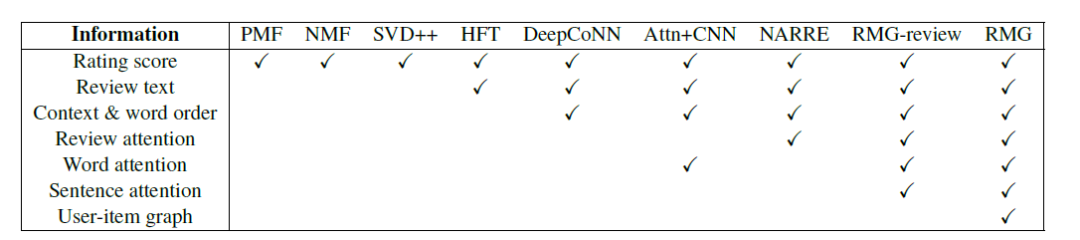

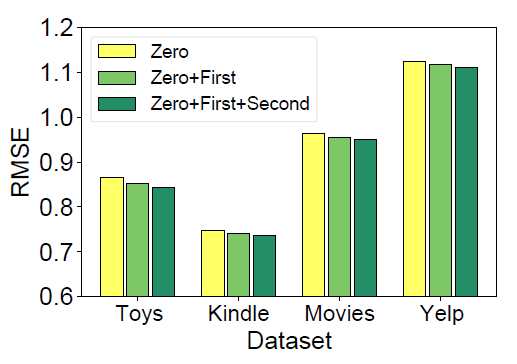

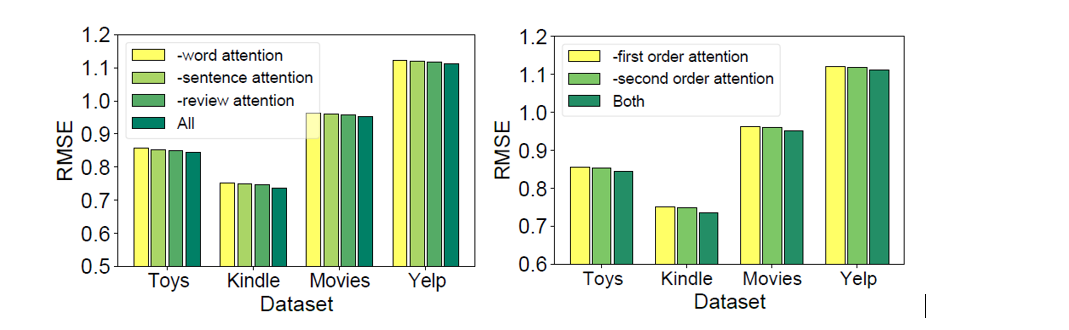

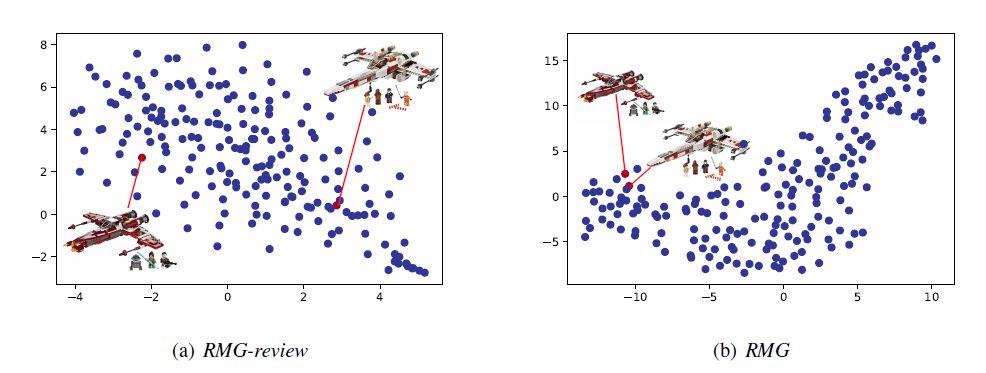

编者按:一年一度的双十一剁手节又来了,各大平台是不是给你推荐了一大波的好物?在电子商务的发展中,个性化推荐技术对于提升平台运营水平、商户营收以及用户购物体验都发挥着至关重要的作用。精进这一技术的关键在于准确有效的用户和商品表示与交互。微软亚洲研究院在 EMNLP 2019 上提出了一种基于层次化注意力图网络增强用户和商品表示的个性化推荐方法 RMG,可以有效结合商品评论以及用户-商品图信息。

用户与商品的表示与交互

表1:

数据集的统计数据

表1:

数据集的统计数据

你也许还想看:

登录查看更多

相关内容

Arxiv

10+阅读 · 2019年9月5日