【工业互联网】工业对象如何建模、不要纠结于不当的大数据观点、工业数据分析与建模过程的悖论、工业大数据的理论体系

来源: 郭朝晖 蝈蝈创新随笔

一起来学习下郭老师的真知见!彩色字体为 “产业智能官” 的见解。

工业对象如何建模

谈到工业建模时,经常听到有人问:你用机理方法、还是用数据方法?不客气地说,问出这种问题的人基本上是外行——因为建模的方法,一般是原理和数据的有机融合。而工程师的水平,也就体现在融合上:能用纯粹机理和数据建模解决的问题,都是简单问题。

按照我的经验,用纯粹的数据建模时,最好不要多于3个自变量,如果自变量超过5个就非常困难了——除非你非常幸运地实现了解耦或者数据的精度特别高、干扰因素特别少。自变量多时,纯粹的数据建模会遭遇组合爆炸问题。这时,成功的概率如同大海捞针。(第SI范式在金融领域处理千万个自变量,这就是实体经济和虚拟经济的差别,虚拟经济的相关数据没有线下“噪音”)

对于一般的工业过程,超过10个自变量是非常常见的。这时,纯粹的数据建模基本上不靠谱。但另外一个方面,无论问题涉及到多少个自变量,人类似乎总会有些办法。这听起来似乎很神秘,但确实如此。所以,数据建模一定要学会借助人的理论和经验。而对于典型的工业过程,人们总是会有一些科学理论的。同时,我也发现:基于人的经验(实际工作、数据产生)和理论(科学、研究产生)进行数据建模,总会比人的经验强一点。对创新来说,强一点就够了——然后可以持续改进。一下子想得到理想的结果,基本上是不靠谱的。

但是,纯粹的理论一般也不靠谱。我们注意到:科学原理很少有10个以上变量的。因为科学研究的都是本质、都是简单的东西。而在应用科学原理的时候,人们往往却会遇到10个以上自变量的情况——这是因为,科学原理中所需要的参数,往往是不能直接测量的、而是受到其他因素的影响。比如,冷却过程可以用热传导方程;热传导方程需要边界条件;边界条件往往收到很多因素的影响。这样以来,问题就复杂了。所以,纯粹的机理模型,也几乎找不到好用的地方。

事实上,工业界的知识,往往不是理论推导出来的——而是实验手段获得的。理论的作用是给人以启发,少走弯路、少做实验(仿真,就是基于机理模型的数字化实验,即少做线下真正的实验)。一个办法成功了(通过实验),就记住这个办法。然后,把这个办法所用的参数尽可能地固定下来,以求得稳定的产品质量——这就是工业界真正的逻辑。(大多数企业已经形成固定产品质量参数,要做的是结合机理模型+数据模型优化这些参数)

这个逻辑,对于工业建模或者数据分析,依然有效。我们知道这样做是可以的,但这样做为什么是好的却不一定能计算清楚、甚至也不一定有必要计算。由于前面所说的组合爆炸问题,工业界的多数知识都是这样的。这也就是大数据方法特别重要的原因——可以获得大量“不纠结于因果的知识”。

机理和数据方法的综合应用,往往就是基于这种知识的:所谓的知识,其实是知道一个工作点(如特定的成分和工艺,能生产出特定钢种)(通过线下实验或线上仿真);工业界总想把生产过程的所有重要参数控制在这个工作点附近。但由于各种干扰粗暴在,总会出现偏离。出现偏离之后,就要设法纠偏。纠偏的时候需要找到办法:可以用机理得到一个架构,然后用实际的数据来纠正机理模型。这样,机理和数据就融合起来了。当然,人们一般还会遇到一个问题:如何调整、如何纠正机理模型?事实上,控制理论的思想就是用来纠偏的,这里就不多说了。

(在CNC行业我们做法如下:通过CNC加工程序+“G”代码实现:

1、得出可靠的参数初始值

正如郭老师所言,通过通过线下实验得到参数初始值;当然,IT男可以通过以下方式:

(1)使用生产历史数据,机器学习分类算法:支持向量机、决策树、集成模型、深度学习训练设备检测模型,得出可靠的参数初始值。具体算法选择依据场景来定,CNC领域由于参数复杂,用拟合能力最好的深度神经网络;

(2)使用初始值开始生产并实时监测良品率;

2、生产过程参数优化:

(3)若次品率超过设定的阈值,则使用最优化算法(如蚁群、遗传算法等)搜索最优参数。

(4)将参数模型代码化,生成控制程序“G”代码

(5)CNC加工程序+“G”代码同时控制数控机床,从而大大提供产品质量。)

科学家会告诉你:理想情况是怎样的。而工程师的水平在于:条件不理想的时候,你知道怎么办。

不要纠结于不当的大数据观点

现在流行的大数据观点很多是不恰当的。现在不当的观点有三个:一个是纠结于“4V”特征,一个是纠结与“相关与因果”、一个纠结于数据分析。这几种说法的问题在于:让人们的注意力偏离价值创造的最终目的,而纠结于特定场景下的细节,见树木而不见森林。

第一个问题,纠结于“4V”。

纠结于“4V”让人们的注意力大数据的个别外部特征,而忽视了大数据的真正价值在于知识。

我们为什么要研究大数据?数据是计算机表达信息的“语言”,随着数字化工作的不断普及,越来越多的历史记录在数据中。人们要深入研究一个问题时,就必须学会利用数据;学会利用数据,就是要学会与计算机交流。

我们关心大数据的原因是数据里面蕴含知识和信息越来越多、越来越完善,以及这些知识和信息的价值越来越大。我们应该关心如何用大数据创造价值,何必关心它是不是“价值密度低”呢?我们关心大数据里面蕴含大知识,何必关心数据量有多少才算“大数据”呢?

“文以载道”,要有足够的背景知识(见今日推送文章《智造时代,专业能力是一个人成事的关键》),才能读懂大数据里面的信息和含义;要构造好大数据的基础,让数据蕴含知识、容易提炼知识——这才是大数据技术最应该关注的问题。

所以,我们观察大数据不应该只看表面的数据量大、数据种类多、产生速度快、价值密度低等特点。因为这些特点只是IT人员关心的、会给他们的工作带来麻烦;而对用户来说,只要数据处理不是障碍,就可以无视这些观点。这时,谈论4V就像谈论“回字有四种写法”一样无聊。

第二个问题,纠结于数据分析。

有些人认为,大数据就是用来做数据分析用的,也就是说是用来发现知识的。这个观点其实是完整的。

例如,某家居公司把各种房型和风格的家居设计都用数据保存起来。用户来了以后,先找到自己的房型,然后从自己喜欢的风格中挑选出合适的设计。这样,产品设计的过程,本质上就是客户挑选设计图的过程,或者说挑选数据的过程。而这些数据本身,就是人类研制出来的知识产品。

我经常说:有用的数据本身或者是信息、或者是知识;缺乏关联的碎片化数据是无用的垃圾。在笔者看来,大数据应用的场景,主要是用数据承载知识,而不是费劲地从信息中挖掘出知识(需要“云、管、端”之边缘计算能力:即边缘处理后经过管道上到云端的有效数据)。

我的老朋友、著名工人发明家孔利明先生曾经讲过一个故事:过去老师傅教徒弟调琴,要求做到“声音浑厚”。那么,什么是“浑厚”呢?很难说清楚、徒弟也很难明白。现在有了数字化就很好办了:把频谱分析出来,“浑厚”就一目了然了。这种“标准的频谱”就是数字承载的知识啊。在这样的例子中,大数据最重要的用途是用数据直接承载知识。在工厂里,大量的碎片化知识都可以用数据(不一定是程序代码)表达出来。

这些知识的特点是处于人的“预料之中”。工作的特点是把人头脑中的知识拿出来、用“数字化”这种“通用的语言”进行共享。这些知识常常是“可遇可求”的,“只要有播种,就会有收获”。数据分析也能得到的知识,但会受到各种不确定因素的干扰,知识的获取很可能是“可遇不可求”的。所以,我主张知识数字化而非数据分析作为大数据应用的主流。(相辅相成:不断生成知识,不断分析预测,返还到知识库,丰富其内容)

当然,对已有数据进行分析也是必要的。数据分析主要针对“意外”事件的发生,去研究分析结果。“意外为什么发生”的知识是很难事先准备好的——每次的原因可能都不一样,而预料之外的问题恰恰容易发生。这时,数据分析就是有必要的。

纠结于“数据分析”时,往往还容易犯一个错误:重视数据分析技巧、轻视数据基础建设。多年来,我的经验是:如果数据质量好,分析工作会非常简单;反之,如果数据条件不合适,分析工作可能是完全无法达到目的。

换个角度看:我的主张是强调用大数据直接承载知识,而数据分析强调的是从繁杂的信息中找到可重复性的规律,也就是探索出知识。前者只需要找到知识,后者则需要探索、评估、验证,麻烦得很。从数据中探索知识是必要的、却是不得已而为之的做法。从经济性和技术可行性上说,前者当然更好了。

第三个问题纠结于相关和因果。

大数据思维“是相关而不是因果”直接把人带入坑里,让人纠结起来:这个观点到底要告诉我们什么?笔者估计,这句话的原意是让数据分析师不久纠结于发现因果、只要发现相关性就可以了。

当然,有些相关关系很难找到因果解释。西方有句谚语:“taste no argument”,大体意思就是“萝卜青菜各有所爱,没什么理由”。发现这种相关性显然是有价值的。但是,如果把大数据的应用局限在这样的范畴内,岂不是太局限了?

当然,单纯从数据中基本不可能得到因果关系。一般情况下,数据不可能描述完整的事实,而只是客观事实在数据空间的投影。打个比方:数据描述的是木偶的动作,而因果则是后面的操作。强调相关非因果是让人不要钻牛角尖?事实上数据分析需要比较可靠的结果。为此,必须有因果分析才能保证结论的可靠性。(目前深度学习已经开始研究因果关系,不久就可以看到相关论文了)

例如,工厂进行质量异常分析时,数据分析的过程就是确定哪个原因的概率最大、较大。人们最常遇到的是两类问题:一类是找不到相关性很强的因素;一类是相关的因素很多。事实上,即便找到唯一一个相关性很强的因素,也不能判断它就是真正的原因:因为真正的原因可能会遗漏掉。不论是哪种情况,人们都需要不断补充知识和数据、变换观察问题的角度,来进行论证和辨别。这其实就是一个追求因果的过程。(机理模型和数字模型结合:机理找因果关系,数字找关联关系。)

如前所述,大数据(其实是大知识)应用有两种方式:一种是从知识库中把需要的知识找出来,一种是从信息中提炼出知识。所谓“相关非因果”应该主要指的是从信息中提炼出知识,而不是把人们掌握的知识进行数字化。

我们举一个例子:你想知道哪条路到机场最快。我们可以用“大数据”的办法,搜索所有到机场的人,看哪条是最快的。这样,我们就得到了答案、也就是最快道路的知识。但这条知识是相关呢、还是因果?

我们知道:“相关”是数据之间体现出来的关系。发现相关关系,的确是数据分析的一个重要手段、也可以促进人的思考。但是,人们从事大数据工作的目的是为了解决问题;为了解决问题,用的知识和手段不限于数据和数据分析。纠结于“因果还是相关”容易把人们的视野局限在数据和数据分析过程本身。有必要吗?

如果让我提炼大数据的特征的话,我会赞同这样几种说法:

1、样本=全体。这意味着,最新发生的事件,很可能在历史上曾经发生过。换句话说,有历史经验和知识可以借鉴。这是在大数据背景下才有的优势。

2、混杂性。我的理解是:混杂性让我们能够通过多个角度和线索确认知识或者事实。换句话说,知识的真假和适用范围比较容易确认。

3、不拘泥于数据分析。大数据应用不拘泥于从数据中发现知识,更关注用数据承载知识。当然,这些知识未必是因果知识。如果把成功的案例、失败的教训记录下来、让数据本身承载知识;只要信息显对完整并经过适度的论证,就会对应用有参考价值。这时,只要能够设法找到这些知识,就能用来解决问题。也就是所谓简单方法能解决复杂问题。

总之,认识大数据的着眼点应该是如何让数字化的知识创造价值,而不是局限于某些过程和场景下的细节。以免造成“不识庐山真面目”的困惑、最该做的事反而被忽视了。

工业数据分析与建模过程的悖论

开展数据分析项目时,数据分析师总是试图从用户那里得到更多的信息和知识。而用户却认为:我请你来的目的,是为了得到过去不知道的知识。如果我自己都知道,要你来干什么?这种认知上的差异,可能会对解决问题产生不利的影响。

如何理解这种矛盾呢?

依照我的经验,现场技术人员对自己负责的领域往往相当熟悉、人类积累的科学知识也相当丰富。所以,不论是数据建模还是数据分析,我总是把“工艺机理已知”作为前提条件。所以,人们的疑惑就是:既然机理已知,还要数据建模或者分析做什么?

事实上,机理已知指的往往是科学原理。科学原理在转化成技术时会遇到各种困惑。比如,热传导方程的原理是容易知道的,但表面条件、物性参数却往往是很难知道的;锈蚀的化学原理是知道的、但不同厂家钢板的耐锈蚀性却不一样,其原因可能是未知的。总之,数据建模和分析,一般不是研究理论的过程,而是“理论和实际结合的过程”。所以,必须先把工艺机理了解清楚了,数据建模和分析才好做。

理论和实践是如何结合的呢?举一个例子:检测得到的数据和生产实际,往往是有差别的。比如,当产线产生质量问题时,工艺人员最常见的反应就是:工艺参数都是正常的,为什么会产生质量问题呢?

其实,设备检测到的工艺参数和实际的生产情况是两个概念。有时候,工艺参数正常并不能标志设备状态正常;有时候,检测数据正常并不标志实际参数正常。所以,数据分析过程的一个重要任务,就是判断“检测到的工艺参数正常”与“实际的生产过程正常”之间是否存在差异。而这种差异,很可能就是大家希望得到的结果。要得到这样的结果,就要理解“工艺参数正常”与“生产过程正常”的内涵是什么,也就是要了解生产的机理。

如果数据分析师不了解工艺对象,就很难做好分析工作。当然,随便用数据分析一下就得到合适结果的“好事”也有。但遇到这种好事概率很低。我们不能寄希望于“守株待兔”的机会总是出现,就要下工夫了解分析对象。

数字化、数学与物理

经常看到误入歧途的数字化工作。他们花了很多代价收集和存储的数据,却没啥用处:既无法用来帮助人们识别信息、也无法帮助人们做出决策。做这些工作的人大概有这样的想法:数据先收集起来再说、总归会有用的,而不知道。这种思想其实就像把没有受过训练、配置合适武器的士兵推向战场,是不负责任的。这种人即便取得成功,也不过是“瞎猫碰到死耗子”,不值得仿效。

数字化为什么有用?在我看来,数字化的意义在于可以转化成计算机能够处理数学问题。所以,上述问题似乎可以换一种问法:数学方法为什么有用?数学方法有用,在于它可以科学、准确地描述客观过程或者对象。换句话说,如果我们在进行数字化的工作时,无法科学、准确地描述对象,数字化就是没有用的。

最近了解到几个有趣的例子。这些例子可以表现为:“数字化的价值是:过去的数字化工作没有正确地描述对象和过程。” 由于过去没有正确地描述对象和过程,才会造成跑冒滴漏、才会造成管理混乱、才会导致价值损失、才会难以发现问题。

所以,数字化过程本质上是针对对象或过程的建模。模型建的好不好,是个关键问题(当然,模型永远是一种简化而不是对象本身,关键是建模的目的是什么)。而建模过程所反映的,是人们自己对客观事物的理解,只不过是用数据来描述罢了。如果人的脑子里没有模型,也就很难把模型建好。数据对建模的作用大概是:在人类事先给定的筐子里选出合适的结构和参数。但前提是人类人类事先给定的筐子不要太大。

按照我的经验,人的数学建模能力其实不仅与数学有关。物理学对培养建模能力的作用非常大。物理学得好的人,建模能力不会太差。据说某省的高考取消了物理,教育主管部门真的是太荒唐了。

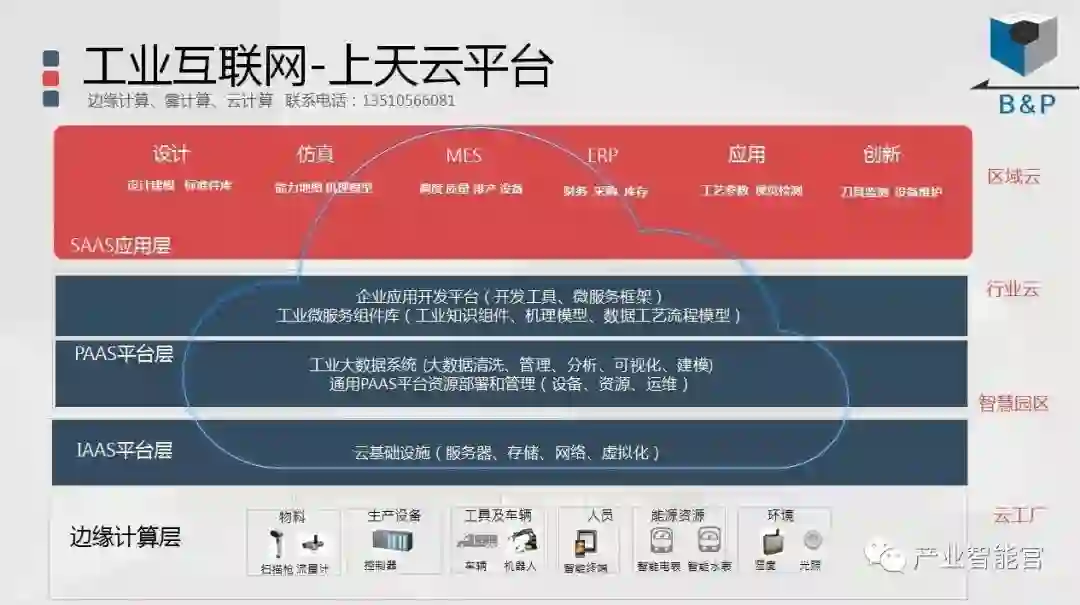

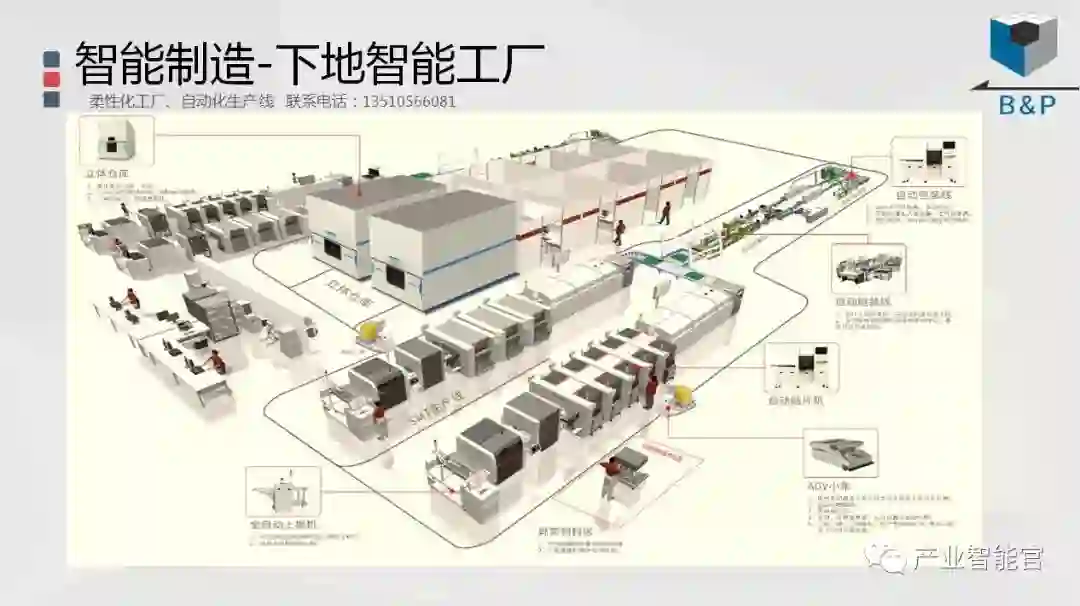

工业互联网

产业智能官 AI-CPS

通过工业互联网操作系统“AI-CPS OS”(云计算+大数据+物联网+区块链+人工智能)在场景中构建状态感知-实时分析-自主决策-精准执行-学习提升的机器智能和认知系统;实现产业转型升级、DT驱动业务、价值创新创造的产业互联生态链。

版权声明:产业智能官(ID:AI-CPS)推荐的文章,除非确实无法确认,我们都会注明作者和来源。涉权烦请联系协商解决。联系、投稿邮箱:erp_vip@hotmail.com