高新波:异质图像合成与识别

编者按:在机器视觉普及之前,传统模式识别系统都是基于高质量的输入图像的,要求待识别对象与图像采集设备之间很好的配合,只有这样才能获得较好的识别效果。随着图像采集设备的普及,获得目标图像的代价越来越小,由此而造成所采集到的图像质量参差不齐。在一些敏感的场合,还会出现拟识别对象与采集设备之间的不配合,造成无法获得对象的正面清晰图像,使得传统模式识别系统难以奏效。而通过引入人类智慧,利用画家经验,可以根据低质量的图像或图像序列,来生成素描画像,基于机器学习方法可以学习画像与图像之间的复杂映射关系,从而由画像合成出可用来进行模式识别的图像信息,进而取得良好的识别结果,我们可以称之为异质图像识别,或模式识别2.0。

本文中,来自西安电子科技大学的高新波教授将为大家介绍,如何通过数据驱动和模型驱动两类方法,实现异质图像的合成与识别。

文末,提供文中提到参考文献的下载链接。

我陪伴VALSE度过了七年之痒,今年就坚持到八年抗战了。今天可能是我最后一次在VALSE上做学术交流,所以我希望能系统总结一下我们团队这八年以来在异质图像合成和识别方面的工作。

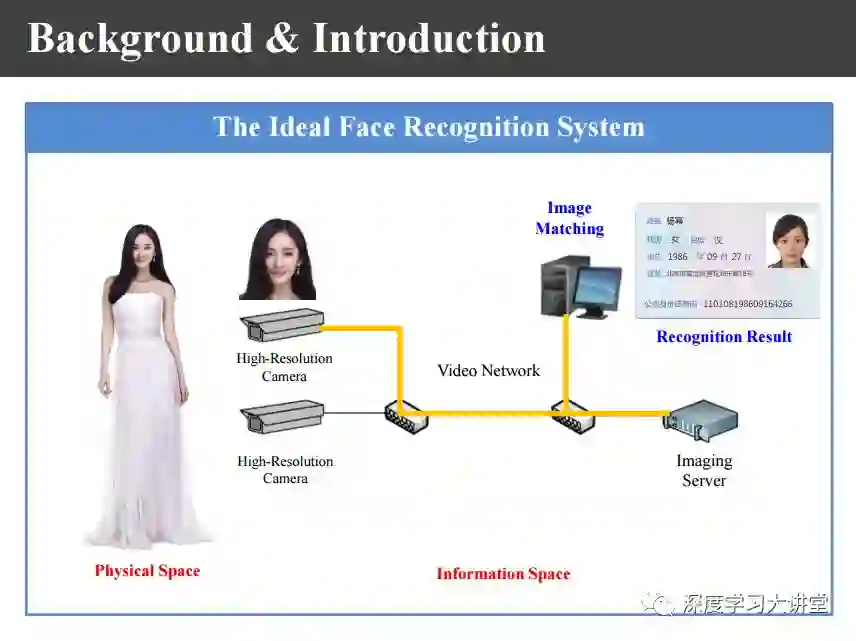

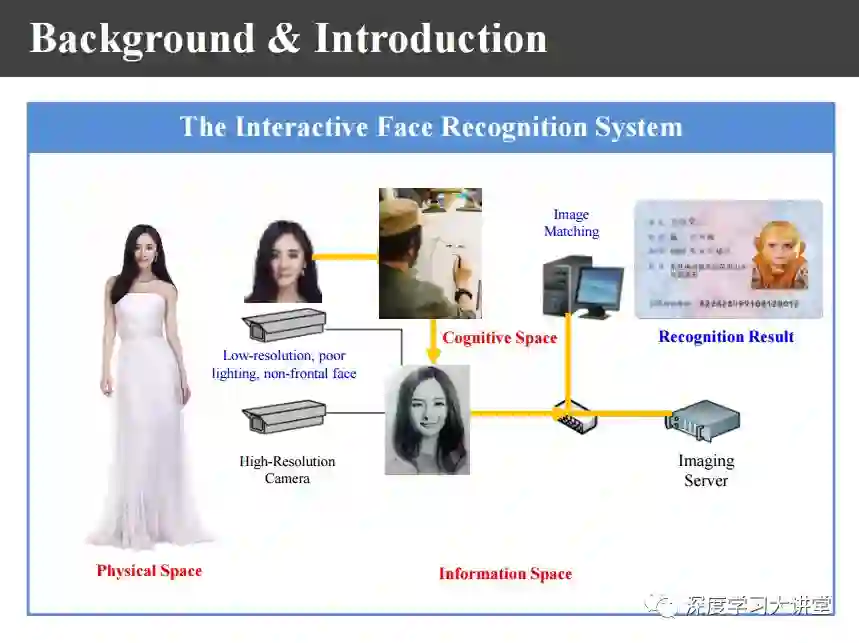

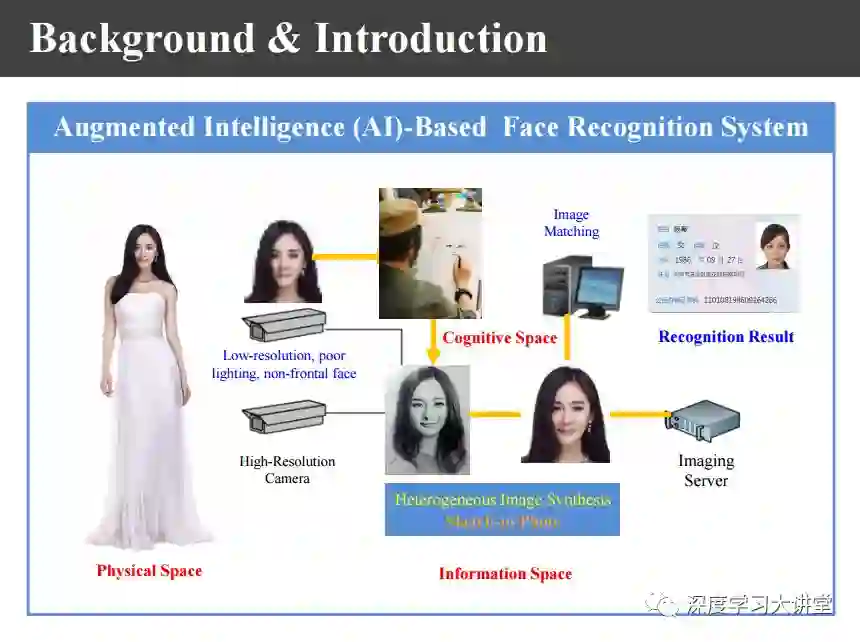

首先,我们来看一下异质图像合成与识别的背景。对于模式识别任务来说,理想的识别系统经过比对以后可以很容易地识别出这个人的身份。上图是理想的人脸识别系统。

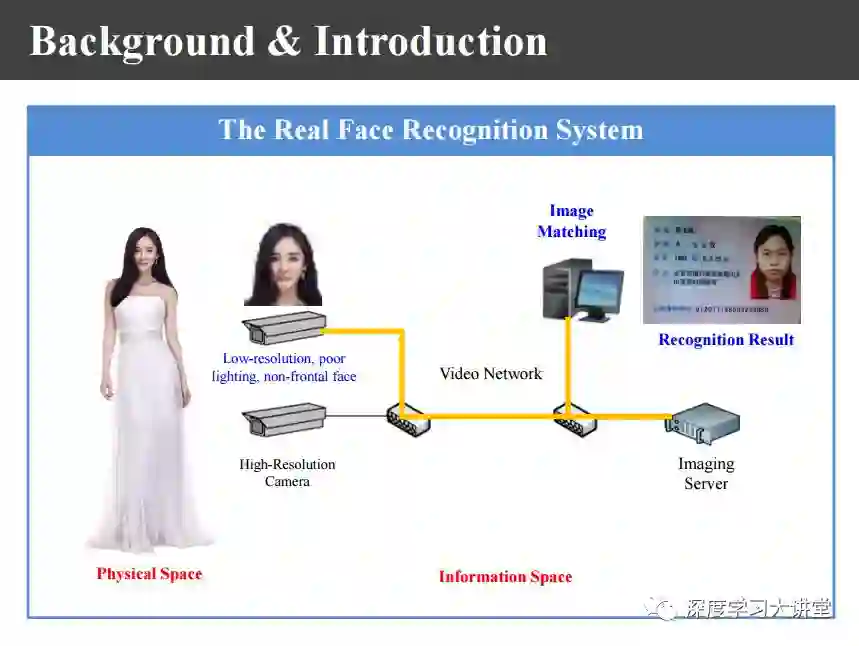

实际系统是当人站在摄像机前面时,摄像机可能是低分辨的,也可能人是不配合的,因而得到的图像质量是非常差的。在《今日说法》节目中发生案件时我们得到的图像总是不清楚,这样的话识别的效果就大打折扣了。

上图是一个真实案例,有人在河的对面发现了两个逃犯,于是拍了照片发给公安部门,由于分辨率太低公安部门的识别系统根本识别不出来,但是善于素描的人员可以通过想象、经验画出画像,再利用画像来排查嫌疑犯。

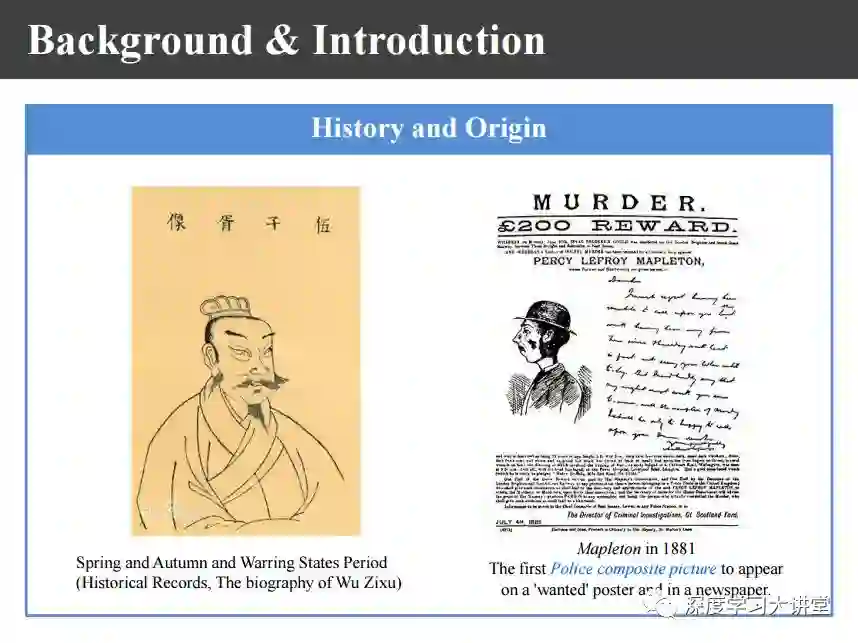

上图左侧是春秋战国时期利用画像追凶的例子,由于伍子胥的画像被挂在了城墙上,他过昭关的时候一夜急白了头。右侧是欧洲1881年报纸上关于铁路杀手追凶的报道,比我们整整晚了2000多年。

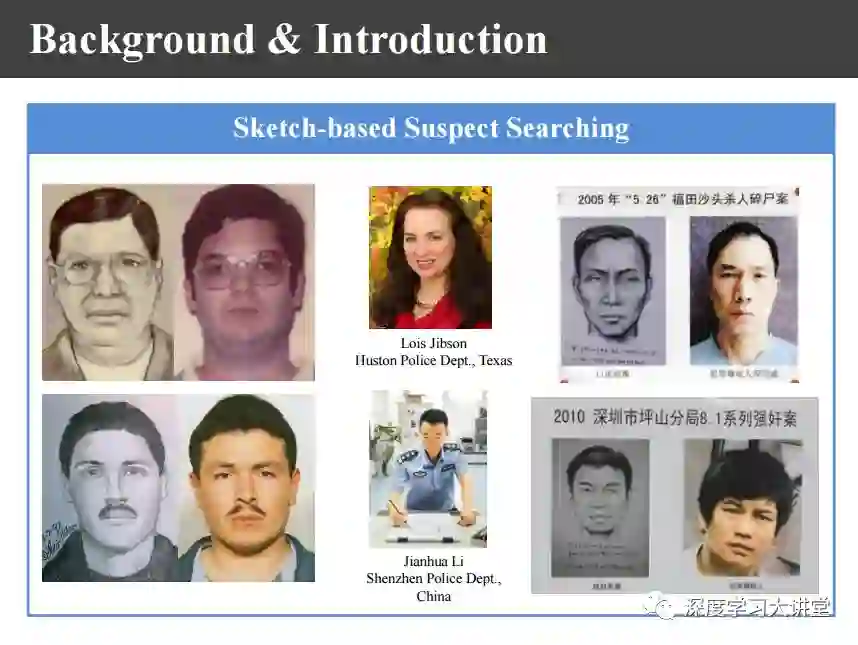

基于画像追凶有实际案例。上图中上方的吉布森女士是休斯敦警察局的职员,她有一次下班时遭到抢劫,因为她是画家就把画像画出来,结果第二天就破案了,从那之后她已经破了2000多个案件。画像追凶来自中国,为什么成功在美国呢?我就在网上搜索了一下,发现我们国家也有这样的人才,比如深圳警察局的李建华同志,利用他的画像追凶已经成功侦破了几个大案,所以画像追凶确实可行。

这样一来,当我们得到的图像是不清晰或者是非正面图像的时候,是不是可以通过引入人的智慧,利用画家得到清晰画像,用画像直接进行识别是否可行呢?上图是我们加入人为画像的识别系统。我们测试了一下,结果也不尽如人意。因为我们的画像主要是通过线条疏密来表现图像的变化的,而照片则是靠灰度深浅来反映,最终的结果是把纹理比较丰富的孙悟空识别出来了。

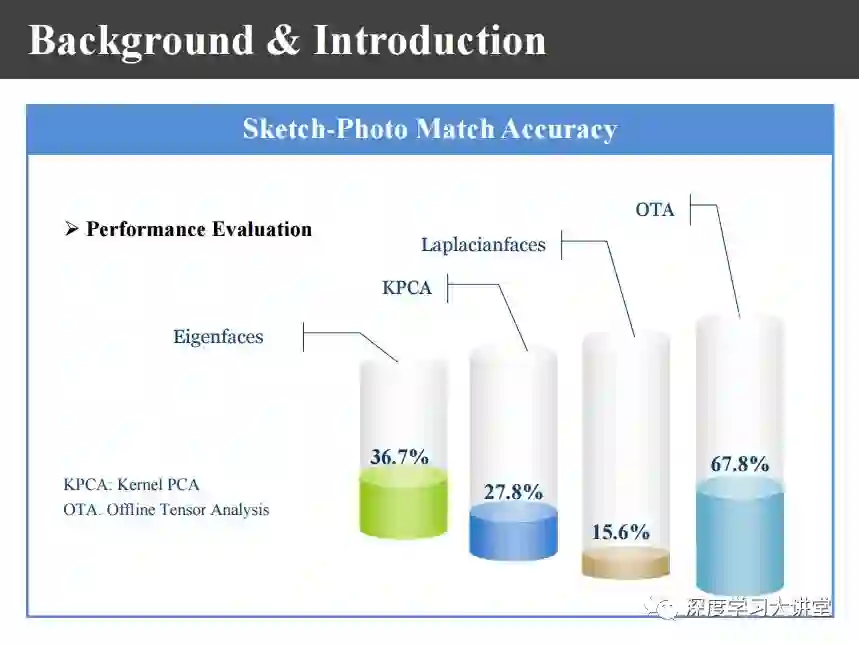

我们做了如上图所示的很多实验,结果都不太好。

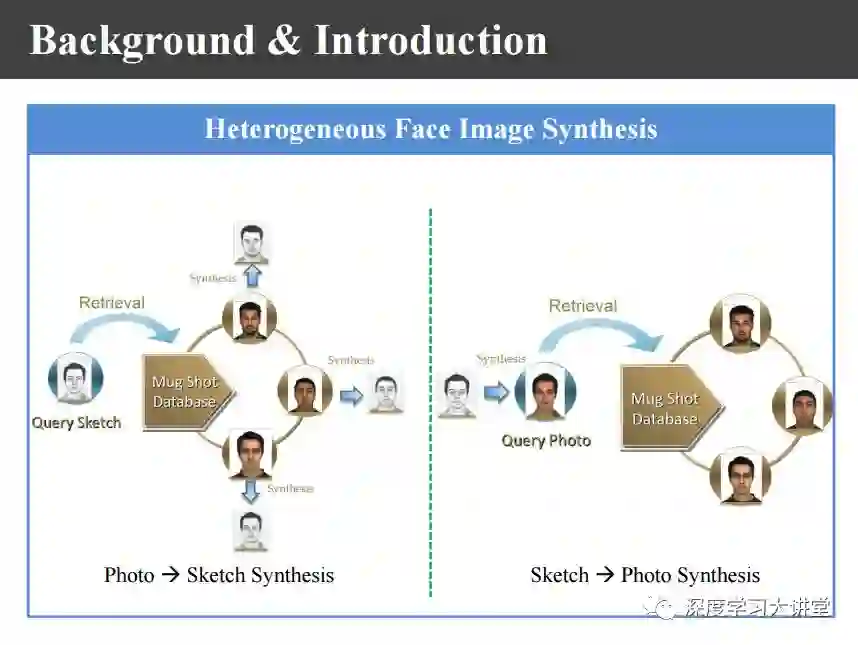

原因在于图像和画像两者之间的表达方式不同。这样一来我们就考虑可能需要做一个从画像到照片的转换系统。这就是上图所示的异质图像变换所做的工作。

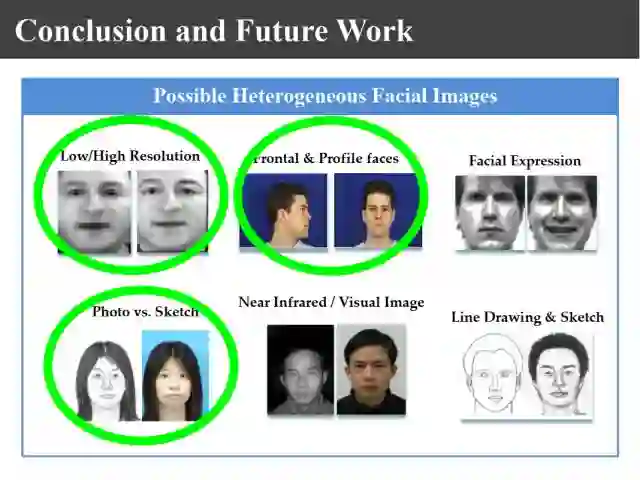

如上图所示,通过把画像转化为照片,我们发现转化之后的识别结果就正确了。所以我今天报告的主题就是异质图像变换,主要包括画像和照片之间的转换。其实不仅仅局限画像到照片,其他异质照片也可以通过机器学习来转化。

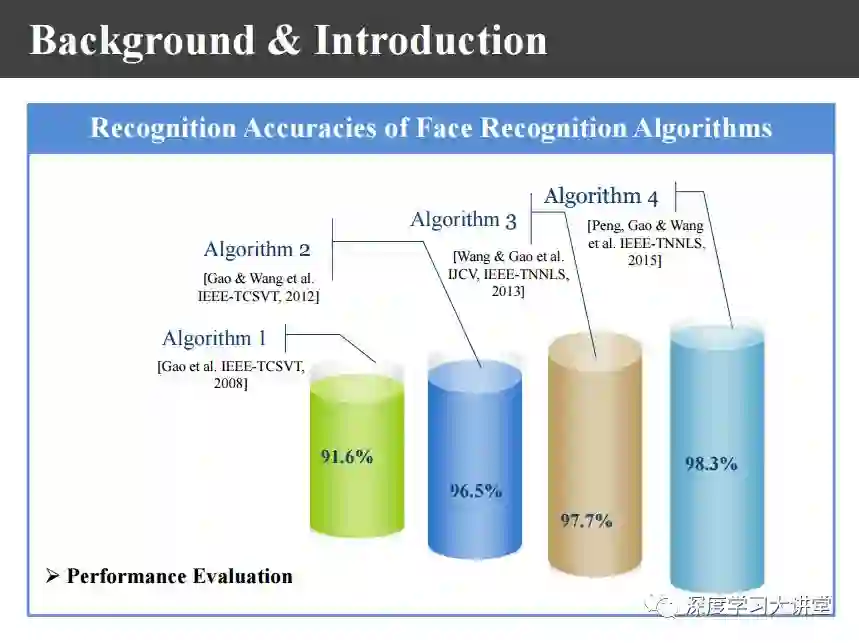

上图显示了我们做的工作,证明了经过转化以后识别率都非常高。

传统的模式识别系统中物理空间的人通过传感器就转变到信息空间去,现在又把人的智慧加进来,形成上图中物理空间、信息空间、认知空间三元融合的空间,这与今天人工智能的一个分支----混合增强智能是完全相关的。

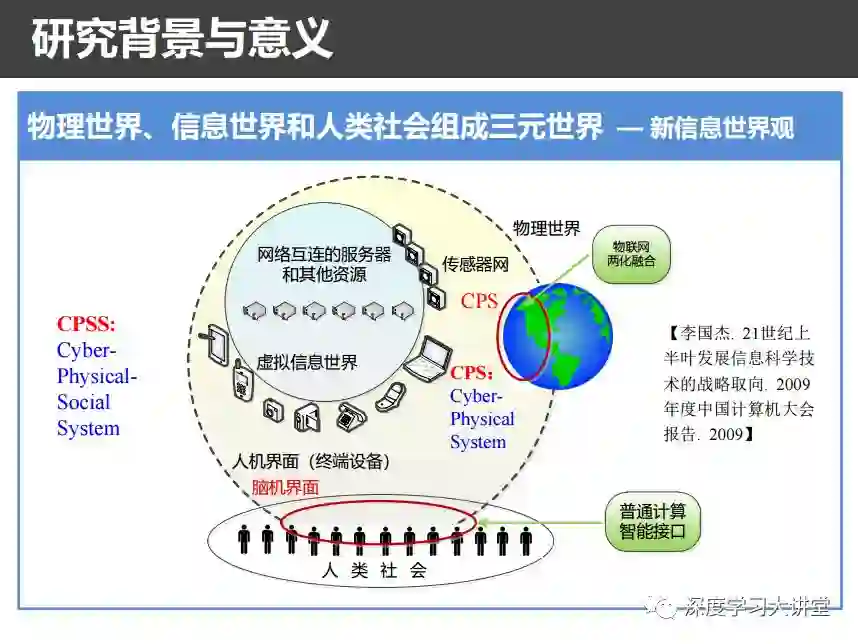

它的哲学基础就是上图李国杰院士提出的新信息世界观:物理世界、信息世界和人类社会组成的三元世界。

去年北大女硕士生章莹颖在美国失踪,最后找到如上图的监控录像。从监控录像中基本上只能看出人的形状,中国的警察林宇辉根据经验画出了画像。我们这个系统把画像转成照片,在人脸识别系统中前10个人里面就把犯罪嫌疑人找出来了。所以,这个系统确实是有用的。

为此,我们也和相关公安部门进行合作,在很多案件里面都发挥了作用。

所以将来可能是这样的,通过不太清晰的监控或者非正面的图像监控,还有目击证人的描述可以形成画像,利用我们这个系统转成照片,转成照片以后利用人脸识别系统进行识别,识别以后就可以实施抓捕了。可能公安部门认为我们的逻辑太简单,但我们只是提供一份可供参考的线索。

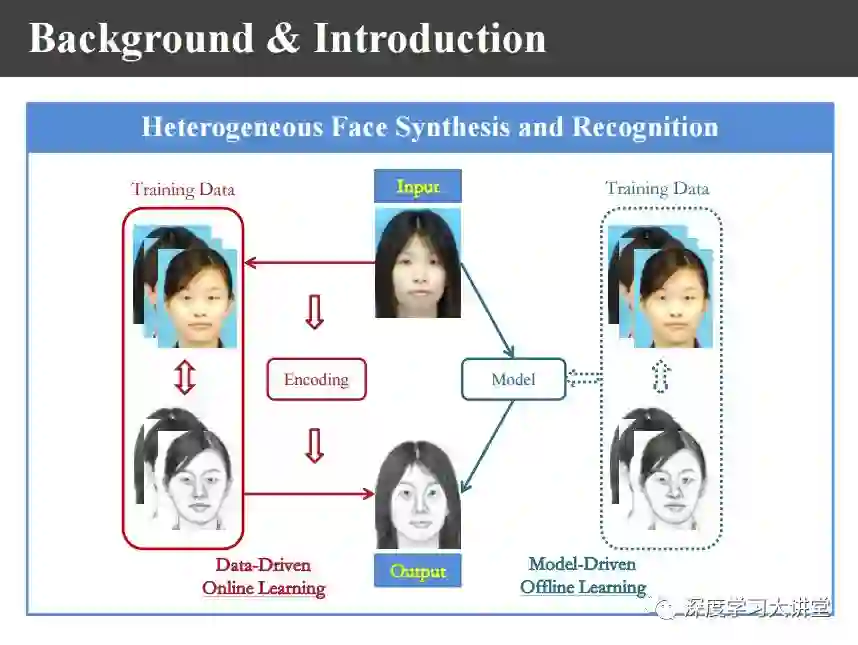

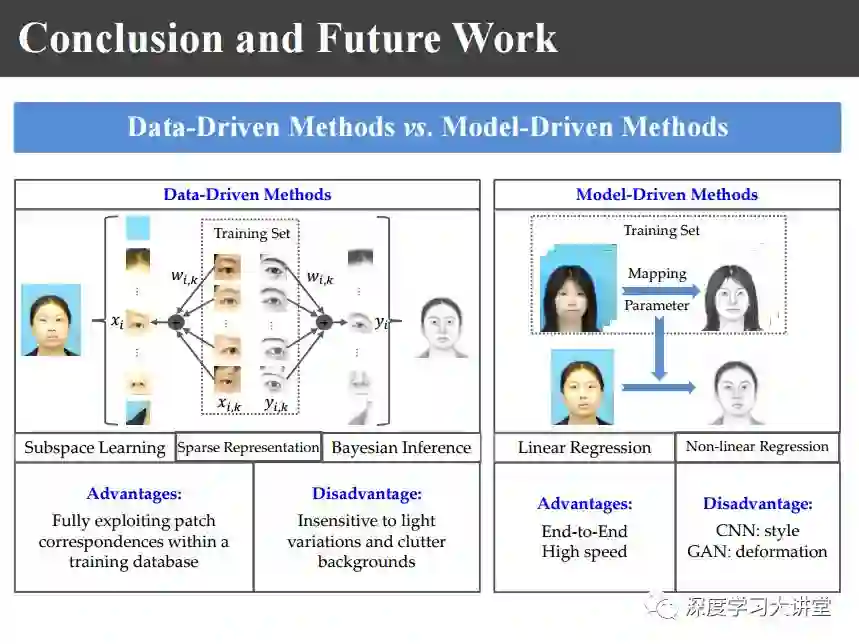

接下来,重点来讲一下讲异质人脸图像合成和识别。关于异质图像的合成和识别我们做了将近十几年的工作,我今天系统总结一下。整个工作可以分成两大类,一种是基于online学习的data-driven的方法,通过输入照片以后,利用训练照片画像对来合成画像或者由画像合成照片。而offline学习的model-driven的方法则是通过机器学习学到model以后,不再需要训练样本,将输入通过映射函数得到生成的画像。

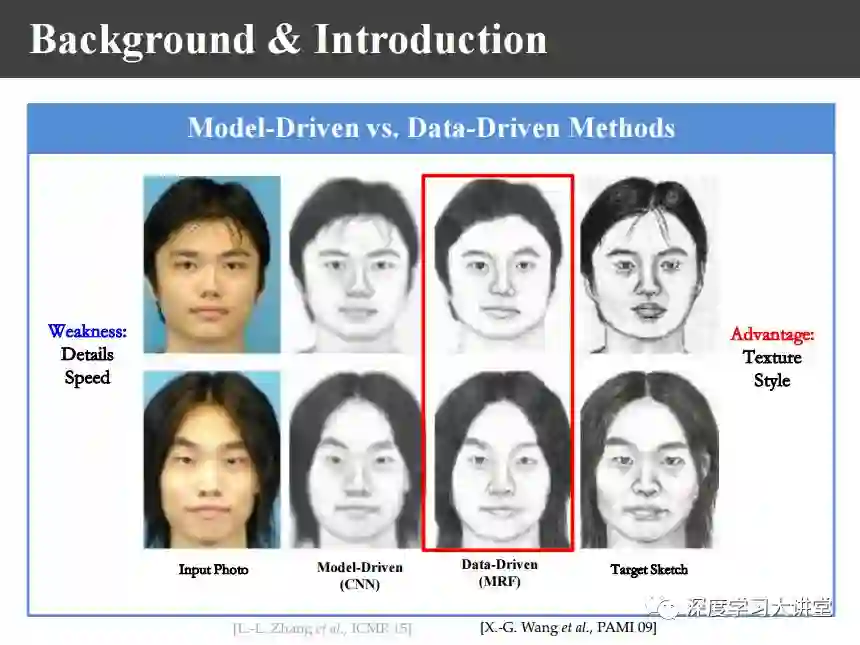

通过上面两张图的对比可以看出,model-driven的优点是训练过程虽然很慢但是合成速度很快,细节比较好;不足是合成图像纹理不够丰富,风格更像照片,不太像画像。data-driven由于需要在线学习导致速度比较慢,但纹理比较丰富,更像画像。这两者目前各有千秋,在使用中可以根据需要混合使用。

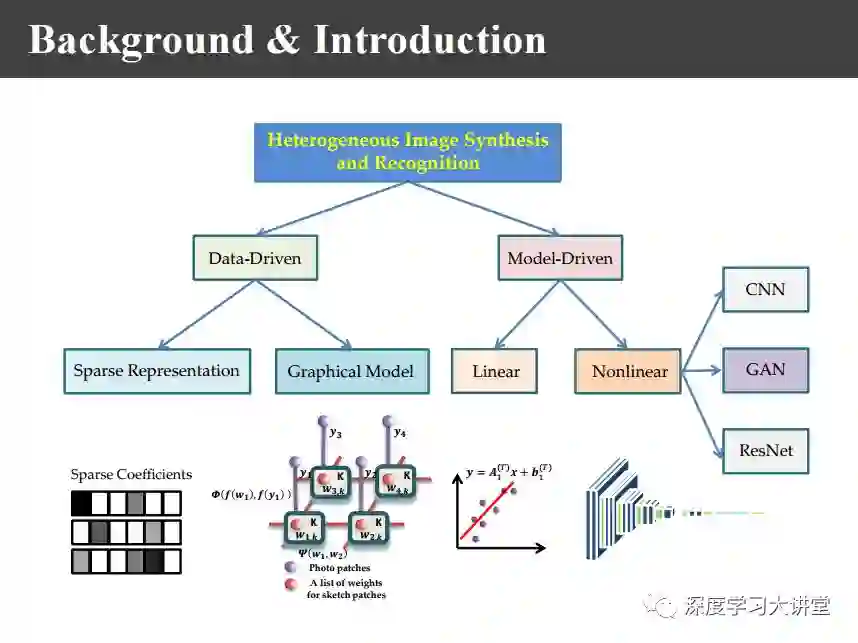

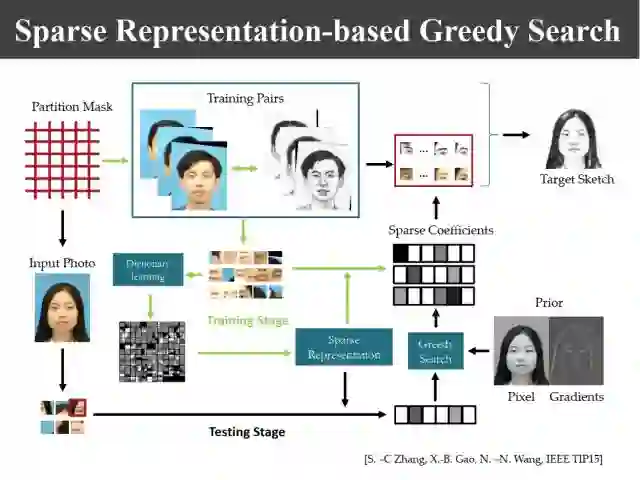

今天关于data-driven主要有两部分工作,一部分是基于稀疏表示的;另外一部分是基于概率图模型的。model-driven主要包括线性model和非线性model,非线性模型包括CNN、GAN、ResNet等主要基于深度学习的方法。

我们首先来简要看一下data-driven的相关内容。

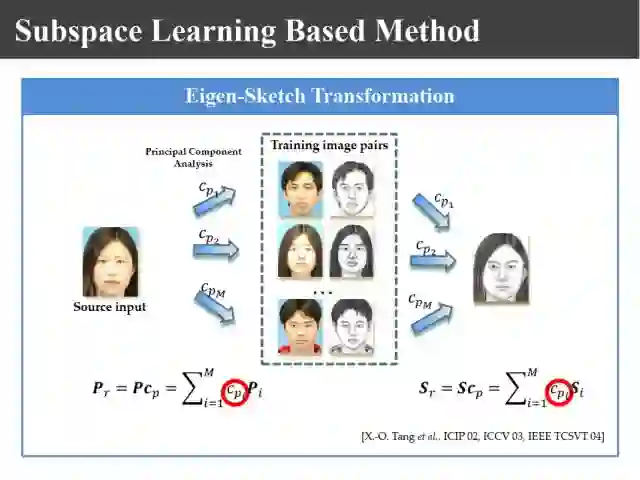

上图是汤晓鸥教授最早在ICCV2003上发表的一个名为Eigen-Sketch的工作。利用Eigenface的思想,对照片利用训练样本进行线性组合生成,得到照片线性组合的系数以后,将组合系数叠加到画像上,可以合成出画像。这是最早的异质图像合成的工作,也是奠基性的工作。

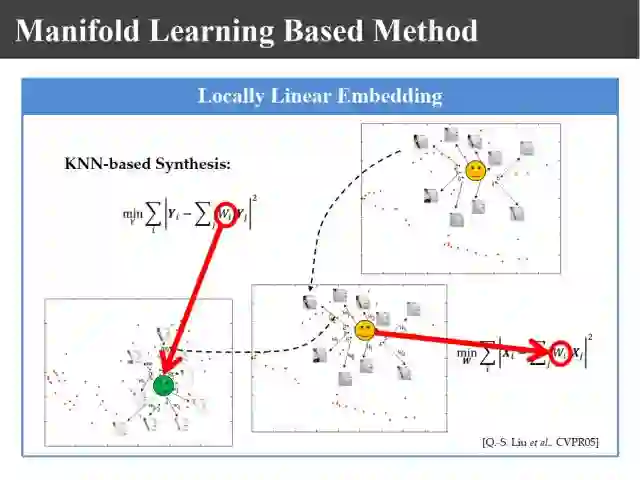

上图是刘青山教授在CVPR2005上提出的改进工作。受启发于当时如火如荼的流形学习,他认为把整幅图像进行合成的做法存在不足,他利用LLE的思想把照片分割成一个个照片块或者画像块,再对每一块进行线性组合,组合以后把对应画像利用对应的系数合成照片,这样就把整幅图像的线性转变成局部线性嵌入。

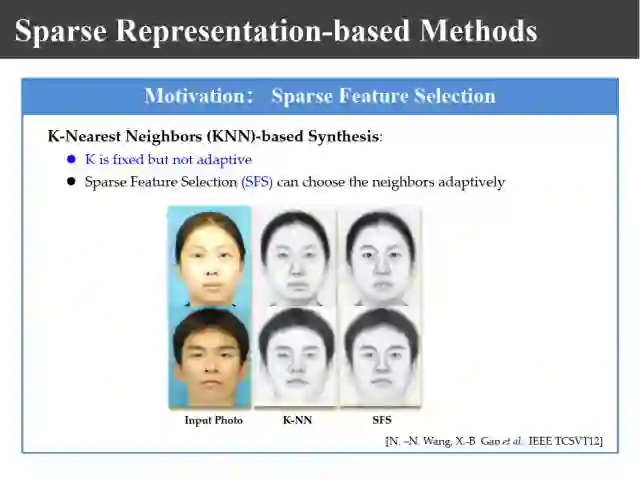

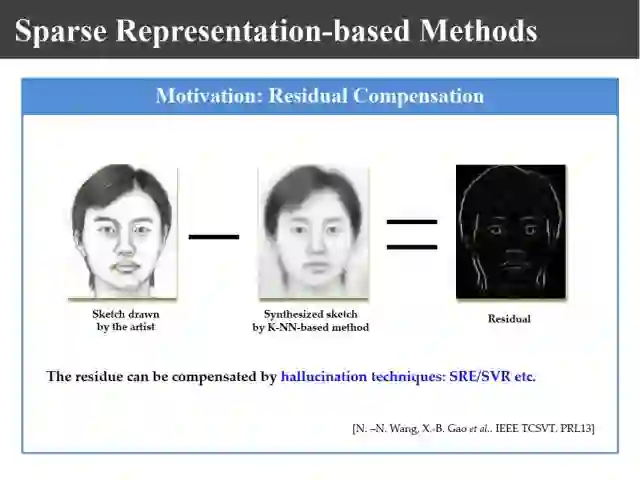

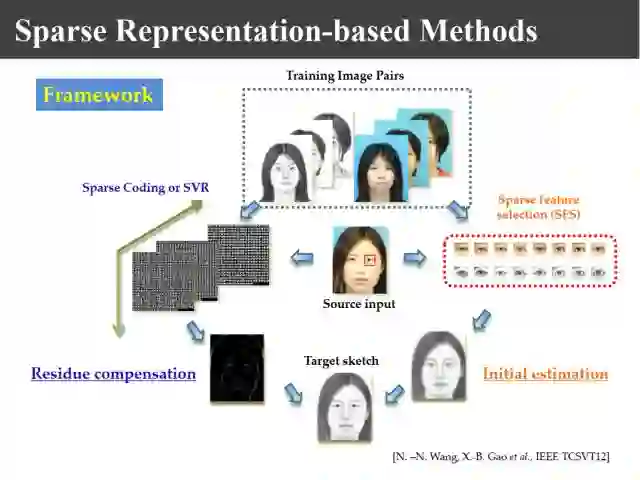

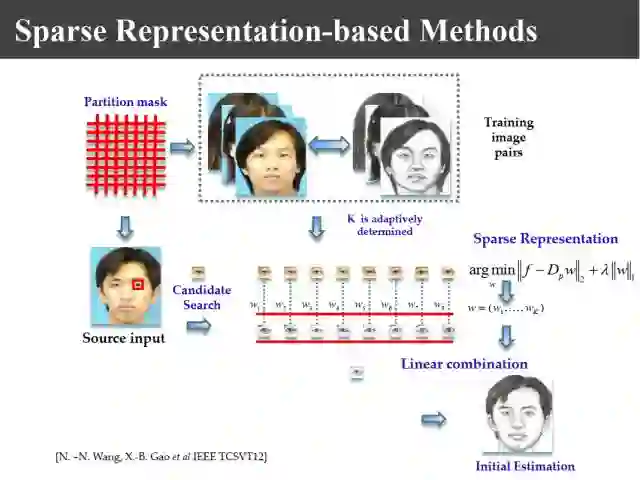

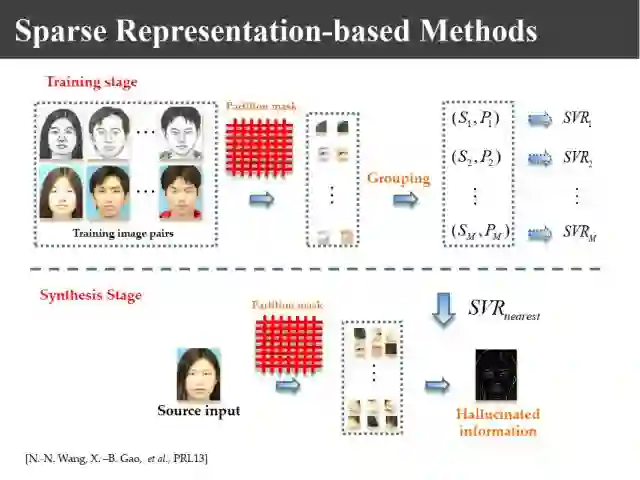

在上述工作中仍然存在两个问题。一是选择K近邻来线性组合,K值是固定的,有的时候K个近邻块的距离是比较近的,有的时候却是比较远的,如此线性组合以后会出现模糊。这个时候正是稀疏表示发展起来的时候,我们基于稀疏表示做了相应的改进工作。

另一方面,由于线性叠加相当于低通滤波,为了使它更清晰我们又加了高通增强,对高频成分也进行线性组合以后叠加上。利用稀疏表示来自适应选择K值,K是动态变化的。另外把高频分量也进行类似学习,合成以后得到比较清晰的画像。具体算法这里不再赘述,我们在相应数据库上做了很多实验。

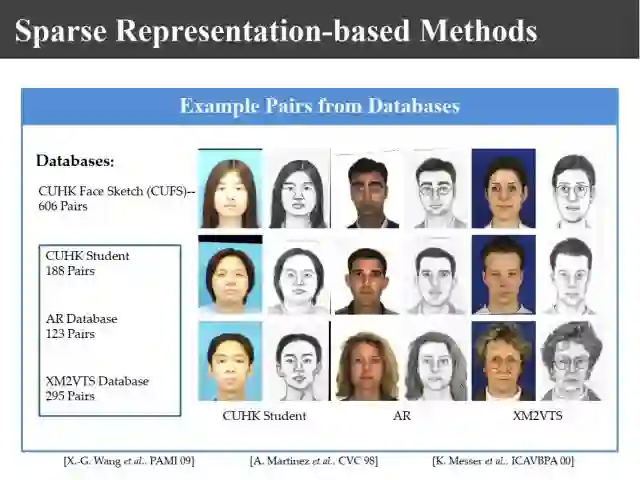

上图是香港中文大学做的数据库,这个数据库共有606张照片。

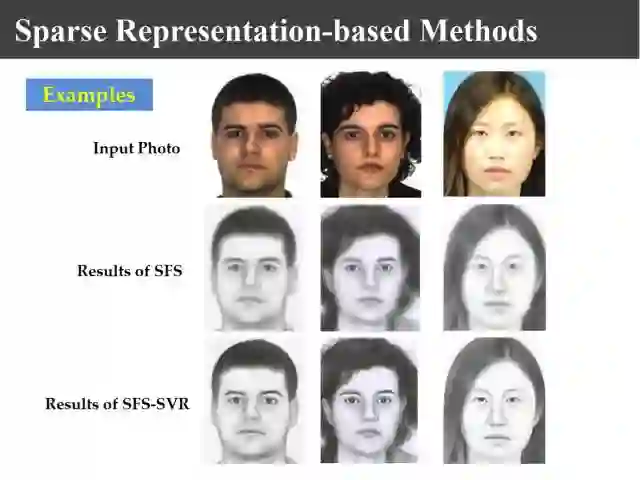

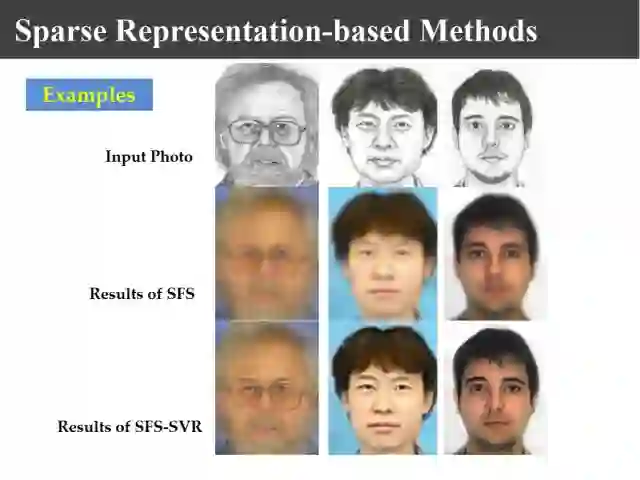

我们利用照片可以生成相应的画像,上图是我们生成的画像,中间一行只是利用稀疏表示生成的画像,显然不够清晰。

同样给一个画像可以反过来生成照片的例子,上图我们生成的照片。

相似的技术还可以用在其他方面,比如说我们在公安部数据库看照片的时候,都是打着网纹的,这是一种数据保护。通过我们的技术可以实现去网纹的工作,上图展示了我们的效果。

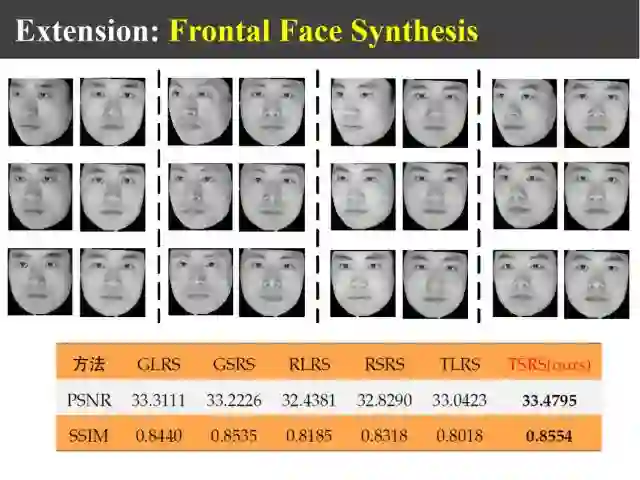

另外,同样的技术还可以利用非正面的、侧面的照片合成正面照片。

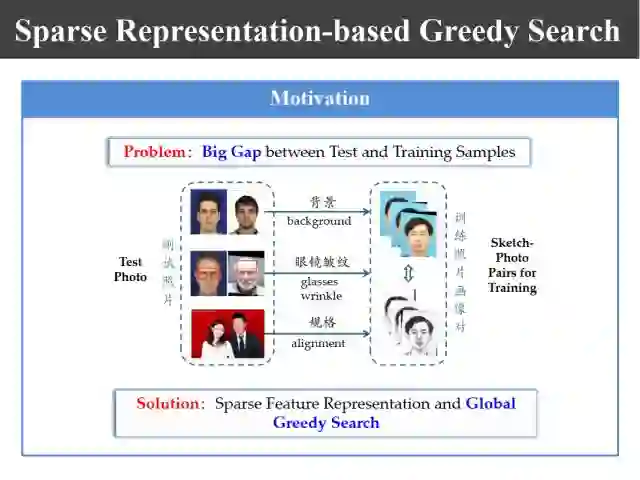

实际上,基于data-driven的方法也还存在其它问题。比如,上图所示的训练数据库里面没有出现的情况我们很难合成出来。比如说背景不一样,或者训练数据库里面都是年轻人,香港中文大学的数据库中的照片都是年轻人的,如果合成老年人,它的皱纹很难合成出来;如果数据库里面没有戴眼镜的,要想合成戴眼镜很难,因为我们眼睛的合成区域总是找相应的眼睛区域来合成的。这样就使得合成出的画像与待测试样本之间有差别,为此我们利用稀疏表示和贪婪学习的方法设计新的方法,就是进行全局搜索。

原先我们的合成是基于local mean的,这个新的学习算法实际上是一个nonlocal mean。nonlocal mean存在一个问题,如果我们要搜索一个眼睛的话,需要在整幅图上搜索它的近邻区域,这样的整幅图像搜索速度非常慢,为此我的团队提出了上图所示的基于稀疏表示的贪婪学习方法。利用训练样本我们可以构造一个字典,把每一个图像块利用字典来表示,得到基于字典的表示系数,形成一个稀疏系数矩阵,这样来一个测试图像以后,同样的也可以用字典来表示成一个系数序列。进行匹配的时候就像一个哈希搜索一样就变得非常快,这样一来就解决了快速全局搜索的问题。

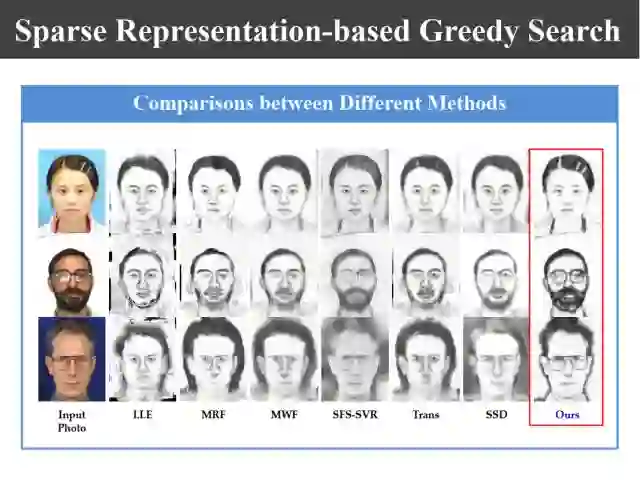

上图是我们和其他方法合成效果的对比图。对于第一行戴发卡的女孩,其他方法生成出来很难有发卡,我们的方法可以很好地把发卡合成出来。同样戴眼镜的照片也是,以前的方法本身合成不出来眼镜,因为训练样本里面没有人戴眼镜,但是通过全局学习,眼镜可能就是利用他的下巴合的轮廓成出来,这样一来可以合成训练样本中没有的细节信息。

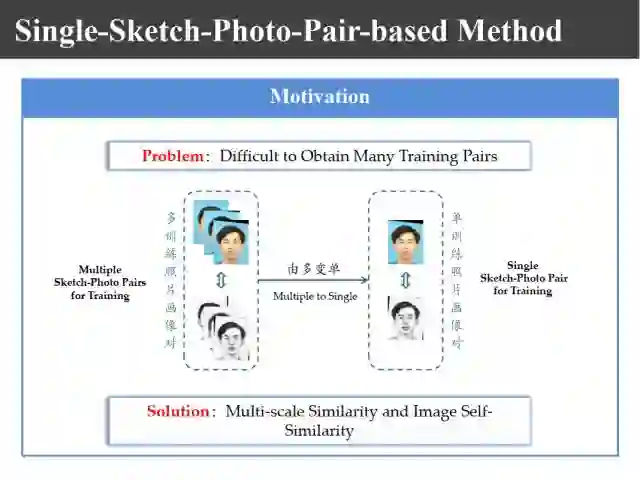

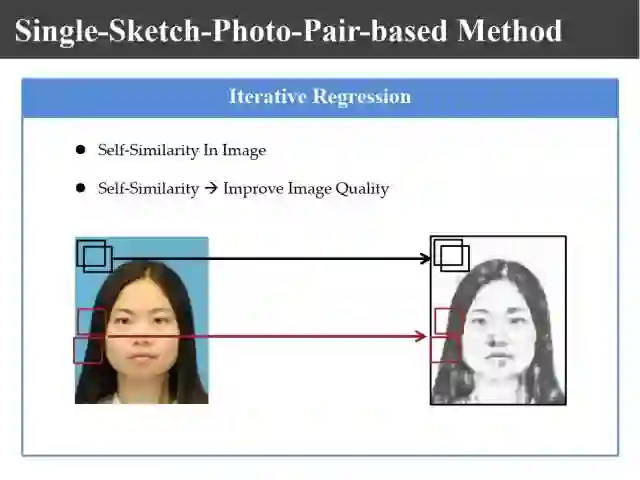

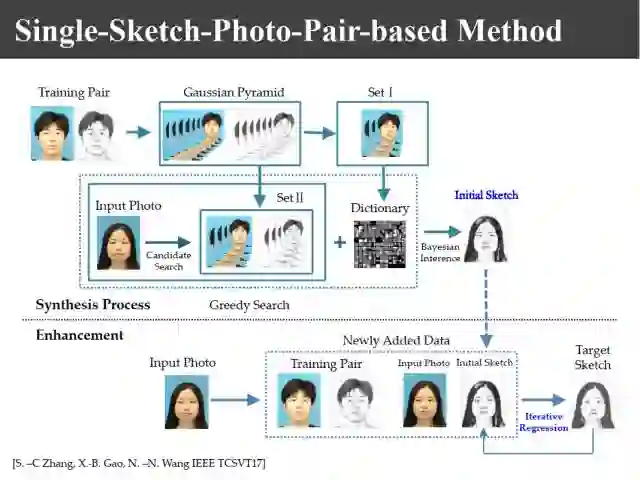

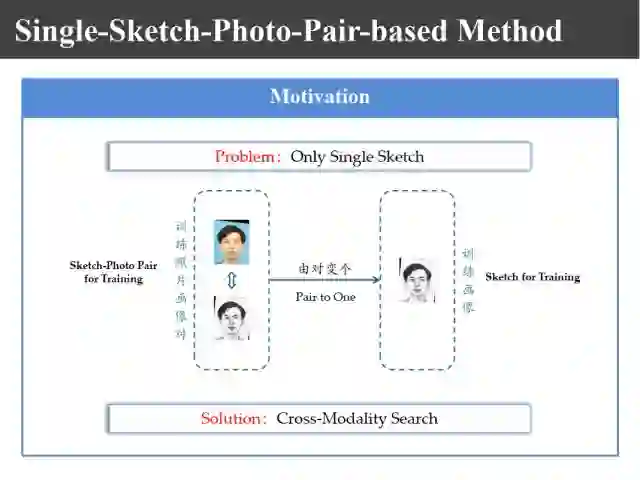

前面的学习都是基于大量训练样本的,如果我们有一个应用只有一对训练样本怎么办?也就是说我们的训练只有上图所示的一个照片和画像对,它也是可以工作的。因为可以利用人脸的多尺度构造更多的图像,一个大人通过缩放可以变成小孩;另外一个图像里面有自相似结构,比如左脸和右脸非常相似。

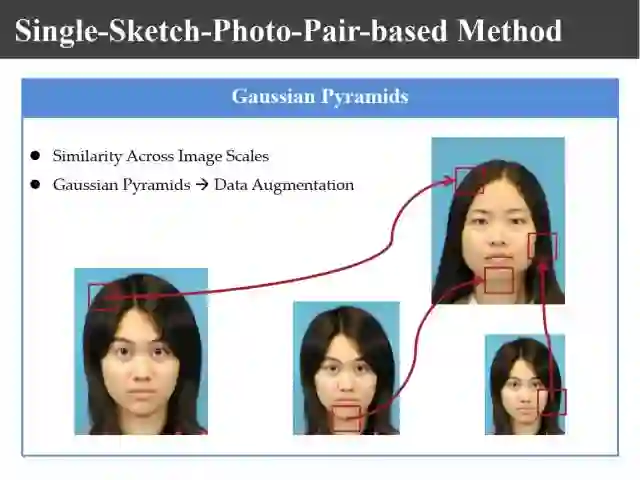

利用上述性质,一方面可以利用高斯金字塔生成多尺度图像,构造更多的图像和画像对。

另一方面利用图像自相似结构也可以进行合成。

这样如果只有一个训练对的话,利用高斯金字塔可以生成一系列不同尺度的照片和图像对。可以通过合成字典,同样利用刚才讲的贪婪学习方法合成出初始的画像。然后把训练样本和测试样本生成的初始画像这两对放在里面进行迭代,依然可以生成高质量的合成画像。

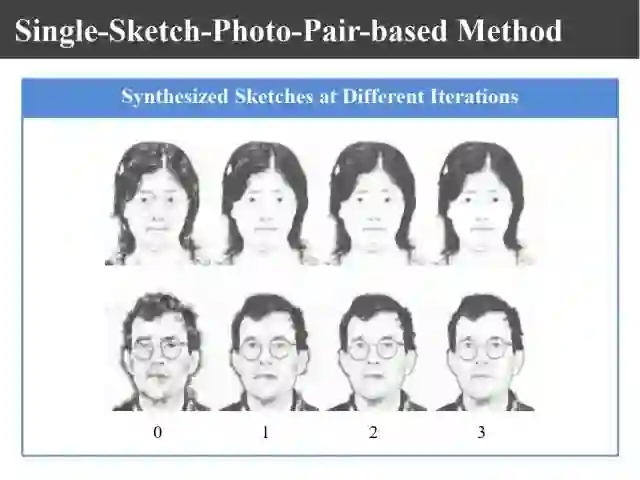

上图是我们逐次迭代生成的的画像结果。

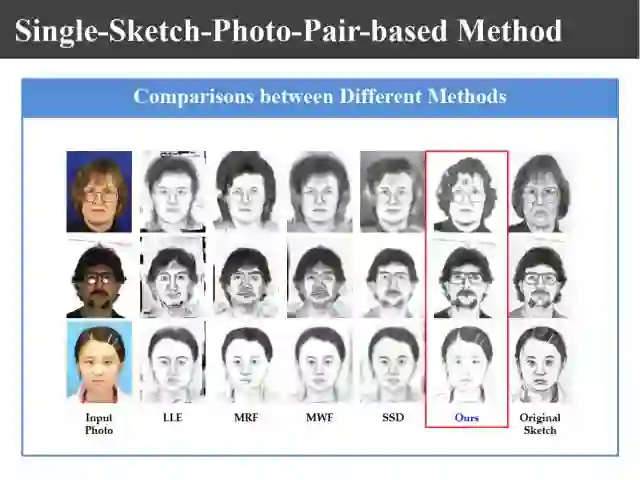

上图展示了采用不同的方法由照片合成的画像的效果,虽然只有一个照片-画像训练对,但是所合成的画像质量还是不错的。

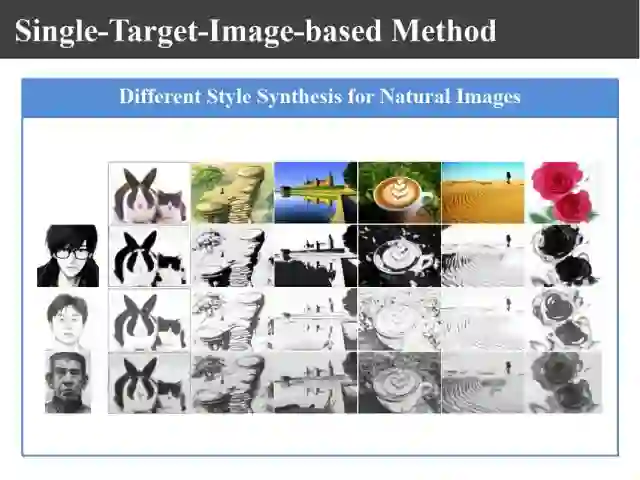

我们进一步来把约束条件进行松弛。如果只有一个画像,连照片也没有,这就变成风格的合成,这样一来我们仍然可以合成出需要的画像。

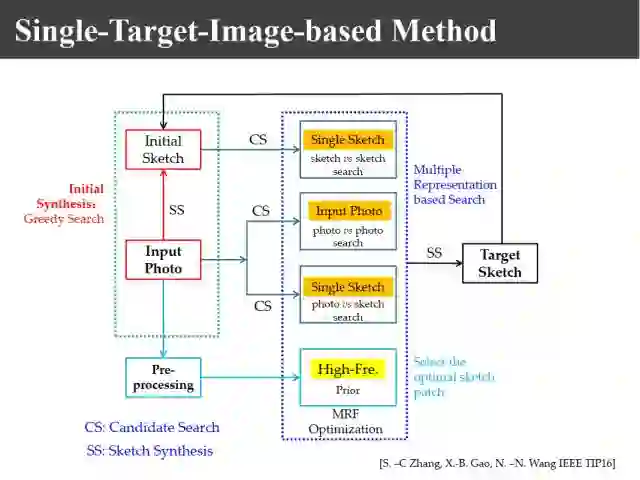

首先利用贪婪学习算法生成初始的画像,然后利用照片和画像,分别使画像和画像匹配去寻找K近邻,基于照片和照片匹配去寻找K近邻,基于照片和画像匹配去寻找K近邻,由于画像和照片它的高频分量比较吻合,利用它做先验知识来选择一个最佳的K近邻然后进行合成,最终进行迭代以后仍然可以得到好的结果。

上图是我们生成的结果。

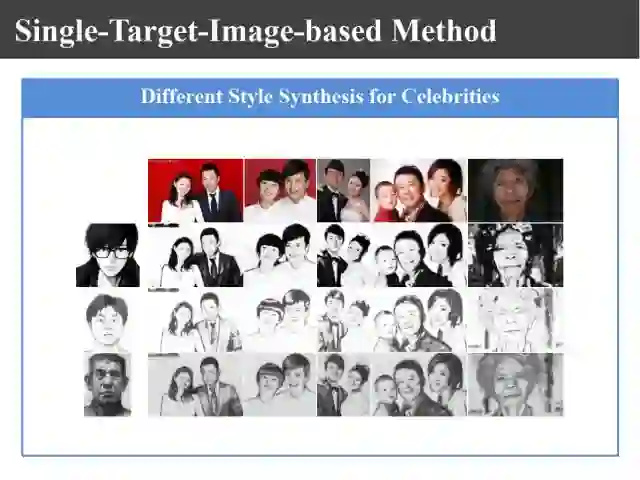

上图是我们利用给定风格的画像(一张),可以将给定的测试照片合成出对应风格的画像分。

同样地,对于非人脸图像的其他图像来说,也可以生成如给定的人脸图像风格一样的画像来。上图中分别展示了根据动漫风格、简单素描、复杂素描风格进行合成的画像。

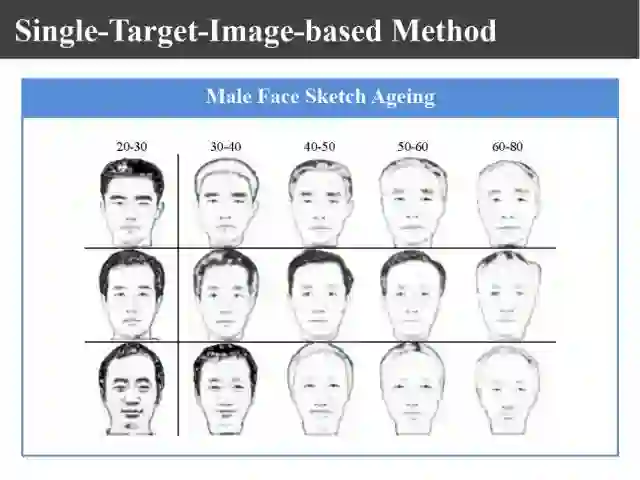

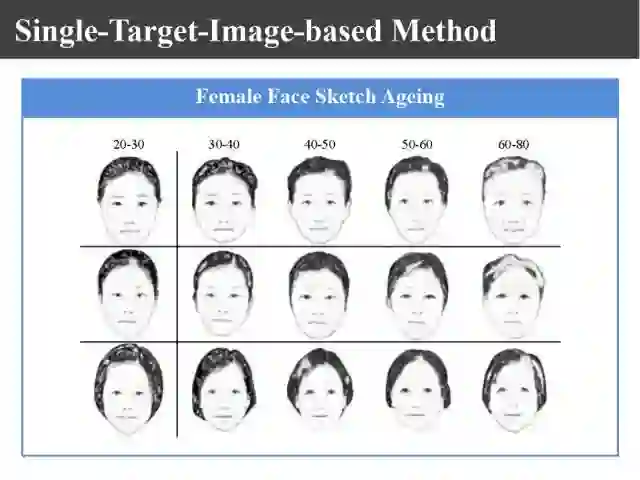

当然我们还可以合成不同年龄的人脸。如果小孩走丢的时候是7、8岁,现在已经17、18岁,我们可以根据年龄的迁移合成不同年龄段的画像。以上主要讲的是由照片生成画像,当然也可以实现由画像生成照片,因为该过程是可逆的。

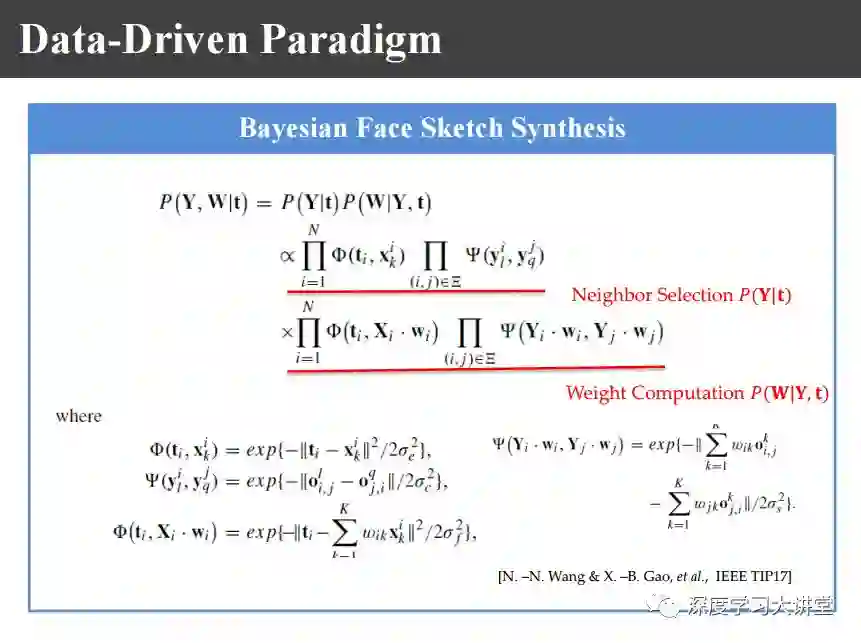

接下来是基于概率图模型的异质图像合成方法。

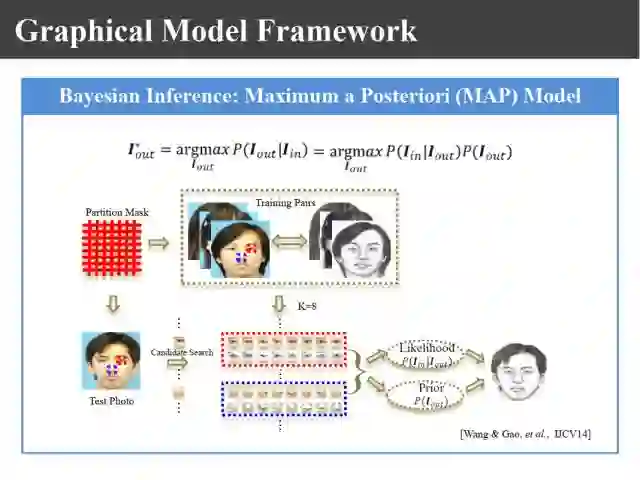

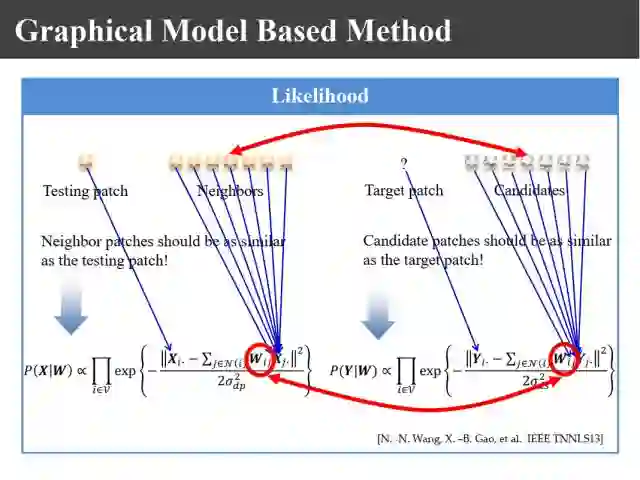

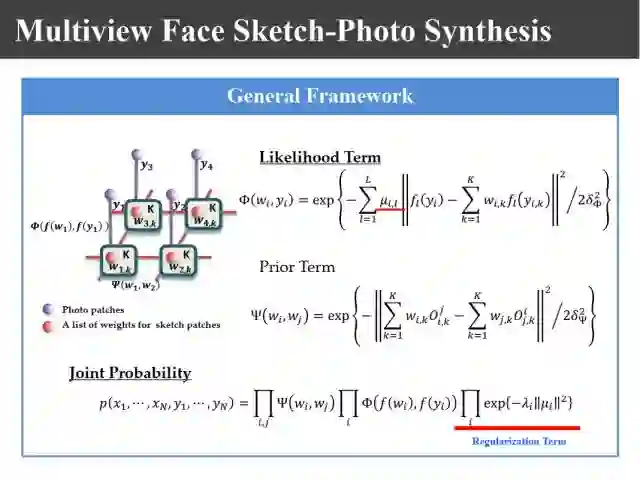

基于概率图模型的方法实际上可以用最大后验概率的方法寻找k近邻。当然,最大后验概率可以分解成最大似然函数和先验概率的情况。

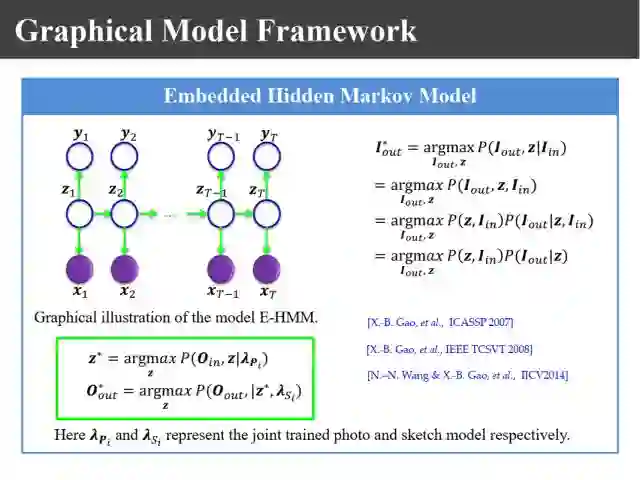

上图是我们在2007年的时候提出的嵌入式模型合成方法。把画像和照片看成是观测序列,同时存在一个隐含状态和状态转移空间,利用状态转移矩阵得到合成模型,然后基于该模型实现画像或照片的合成。2014年在IJCV上我们对它做了新的解释,完全可以用最大后验概率或者概率图模型进行解释,这样我们就把它统一到概率图模型的框架上去。

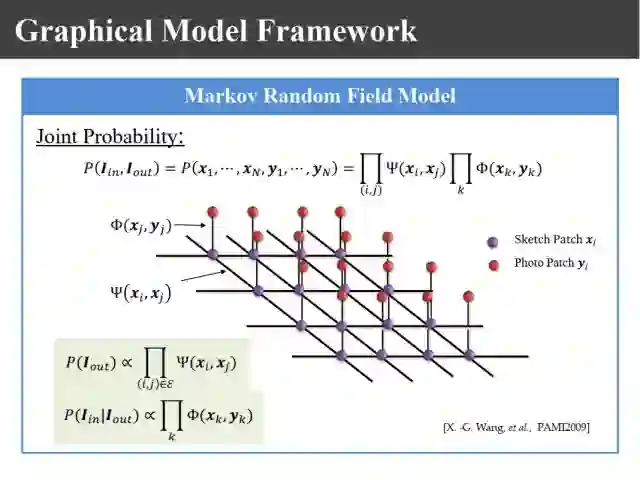

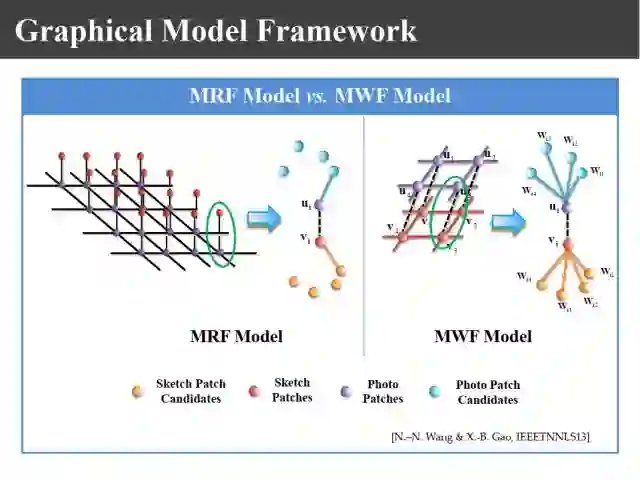

09年在PAMI上有上图所示的王晓刚教授的一个工作,提出了利用马尔科夫随机场理论来进行画像的合成。过去我们生成画像块的时候只是利用照片和画像之间的关系,其实要生成画像的话,相邻画像块之间也有约束关系,为此提出了嵌入式的马尔科夫模型。这里面就有两个似然函数,一个表示画像和照片之间的关联性,一个表示画像块之间的兼容性。

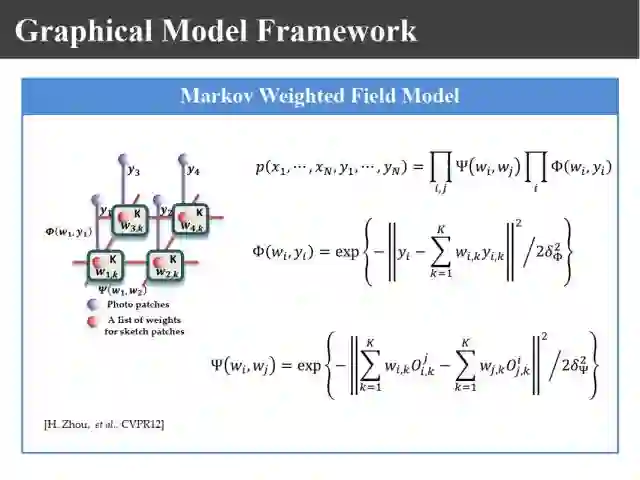

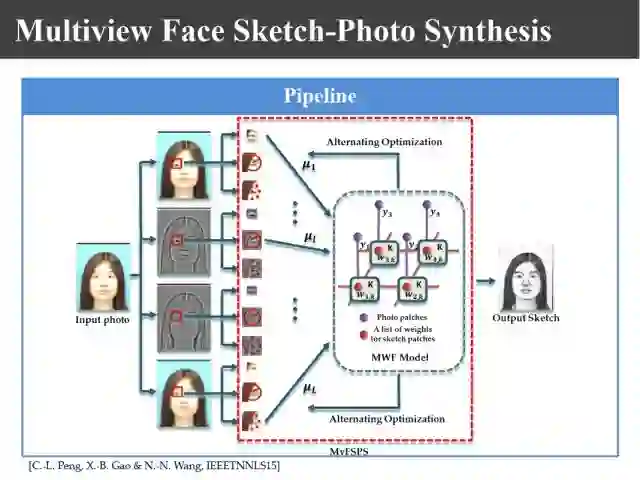

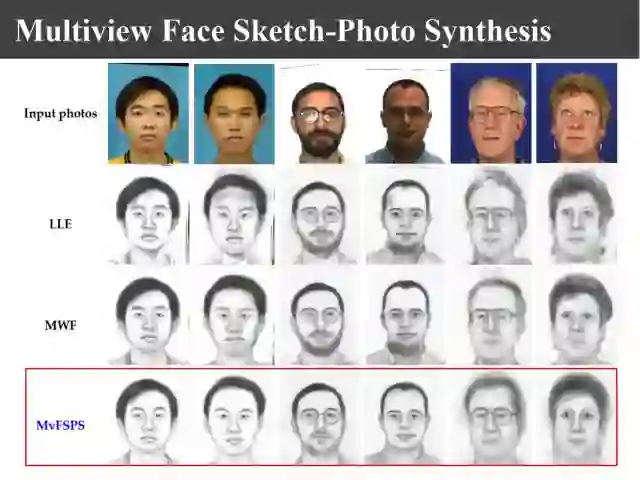

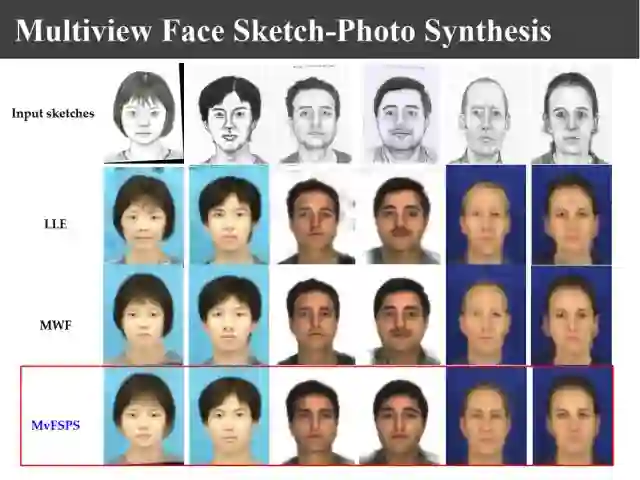

上图是香港科技大学学者在CVPR2012提出马尔科夫加权随机场模型。在考虑块和块之间的关系时,把每一块又使用k近邻来表示,变成k近邻和k近邻之间的约束关系,同样分为画像和照片之间的关系和照片和照片之间的关系。

如上图所示,马尔科夫随机场实际上是找最近邻,而马尔科夫加权随机场实际上是利用k近邻来合成。

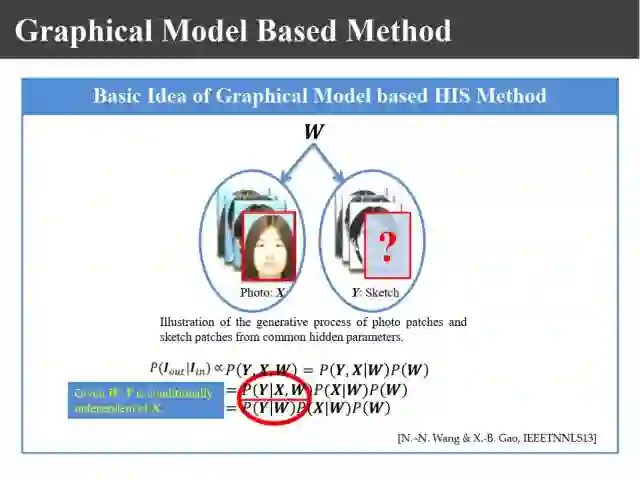

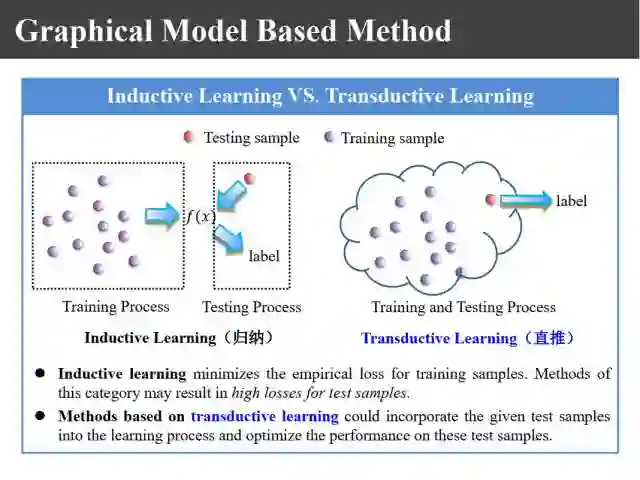

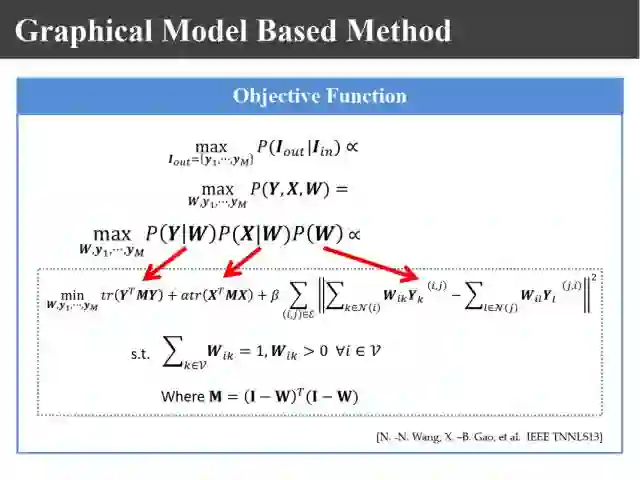

我们在此基础上又提出上图所示的新的基于直推式学习的方法。上图是一个非常简单的图模型,这个图上照片和画像都只有一个叶节点,由一个共同的根节点来控制,这个节点就是它们加权生成的加权矩阵W。现在如果来一个照片以后如何得到它的画像呢?过去是训练好以后再进行处理,现在要把训练和测试样本放在一起学习,就变成直推式的学习,这样我们来推导最大后验概率。实际上这个最大后验概率的计算可以基于概率图模型进行简化,当给定W的时候两个叶节点之间相互独立,可以把模型简化成上图中两个似然函数和一个先验概率的情况。

这种学习算法是我们2014年发表的,叫做基于直推式的学习,把训练样本和测试样本放在一起,原来归纳式的学习方法相当于在训练样本上做的误差很小,但是在测试样本不能保证误差也很小,直推式的方法可以保证在测试样本上误差也是非常小的。

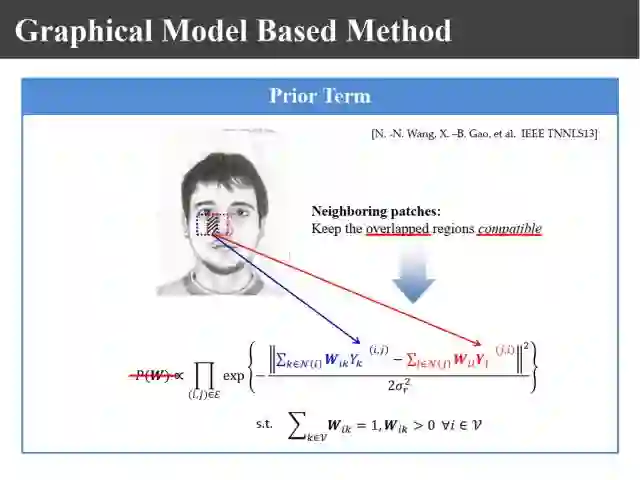

这样一来求最大后验概率的问题就转变为如何构造先验概率和似然函数的问题。先验概率是构造式的,比如说我们要生成上图所示的这样一个块,利用k近邻加权线性组合形成的,邻近的块也是利用加权形成的,对于交叠的区域应该是非常兼容的,所以利用两个误差越小越好,相应的指数函数越大越好,这样构造出一个先验概率。

对于似然函数则是上图这样的,合成鼻子的时候事先找到了k个相近的鼻子,使得它合成的误差越小越好,画像上把对应的鼻子和权值W组合就可以生成出鼻子来,这样就可以构造出两个似然函数,合成误差越小越好。这两个权值在两者之间是共享的。

这样一来就可以构造出上图所示的一个目标函数,看上去非常复杂,实际上推导一下只不过是用矩阵来表示最大后验概率的计算公式。

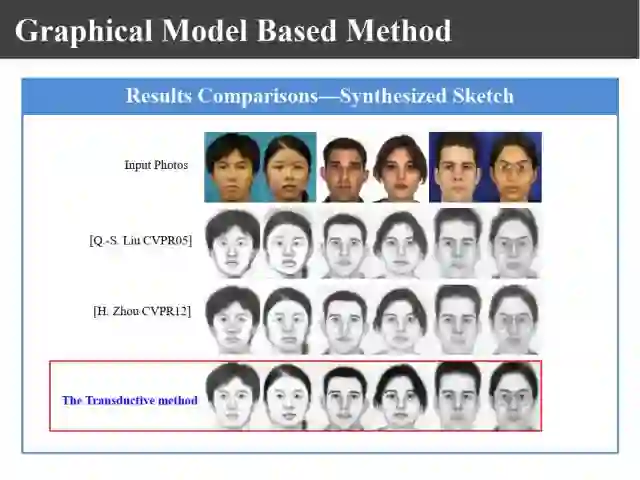

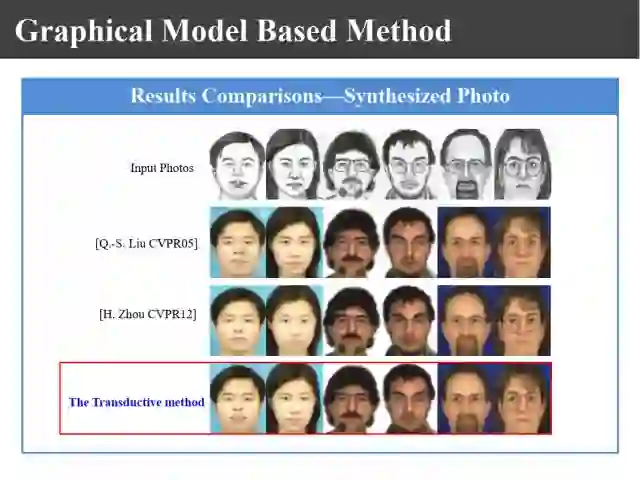

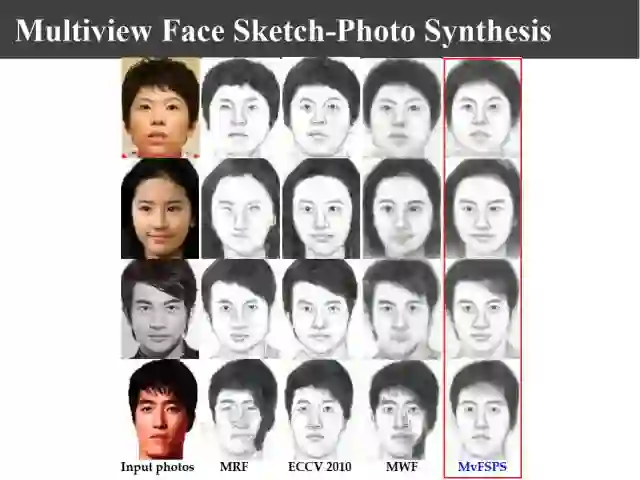

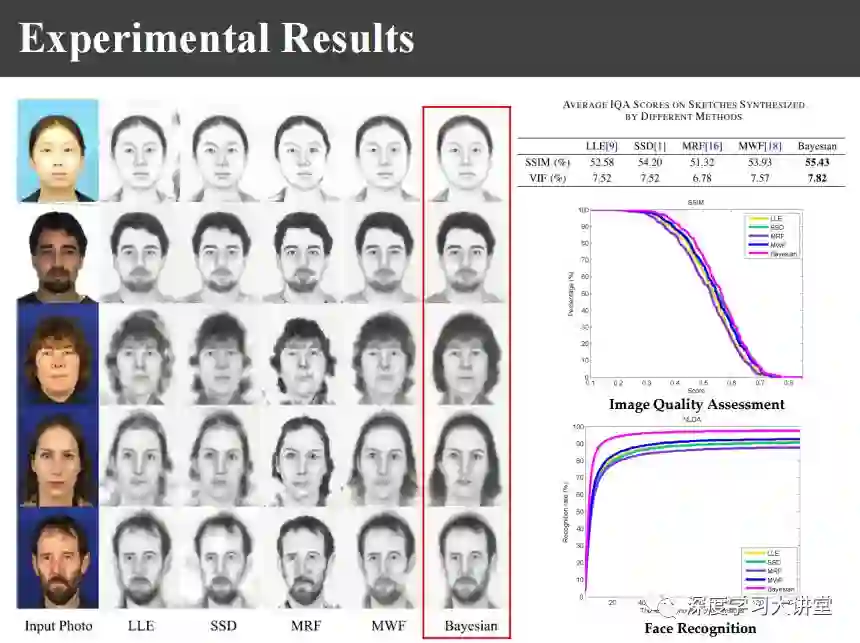

优化目标函数以后就可以得到生成结果,上面分别是由照片生成画像和由画像生成照片的结果,显然比原来的两种方法合成出的图像更清晰。

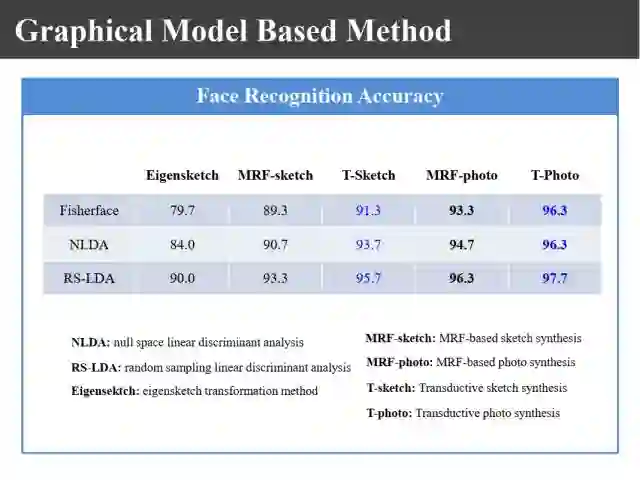

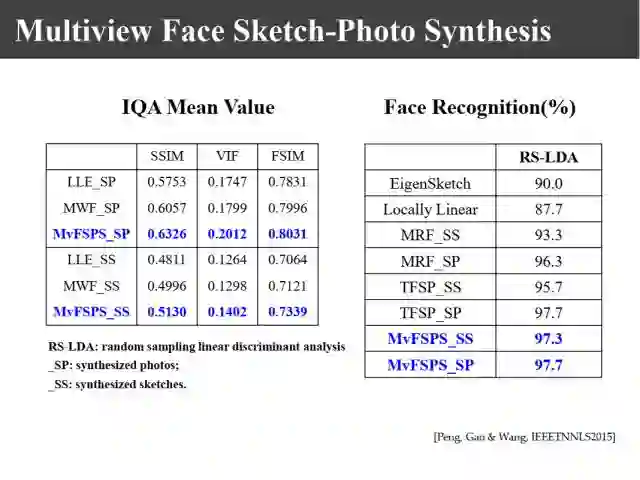

同样还可以用合成出来的照片和画像进行模式识别。如上图所示,在香港中文大学的数据库上可以达到97%左右的正确率。

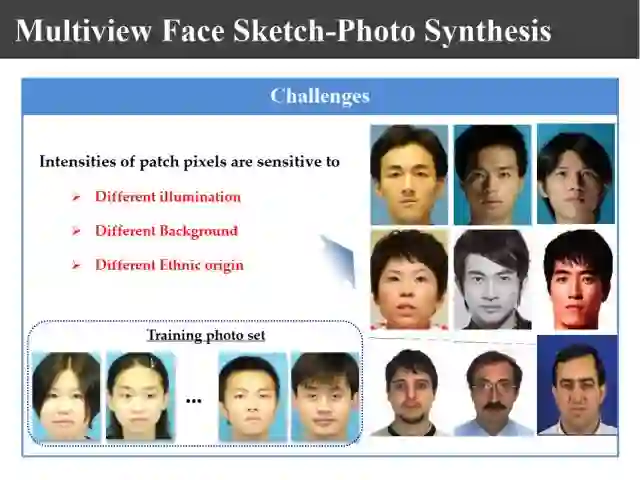

在合成过程中,如上图所示,如果测试图像里面光照是单侧不是正面光的,生成出来效果就不好;如果不同背景,原来照片训练里面都是蓝色背景,实际合成有黄色、白色背景,那合成出来效果也不好;另外不同种族,当训练库中的照片都是华人的照片,要合成一个欧洲人,那么合成出来的结果一定会像一个亚洲人。

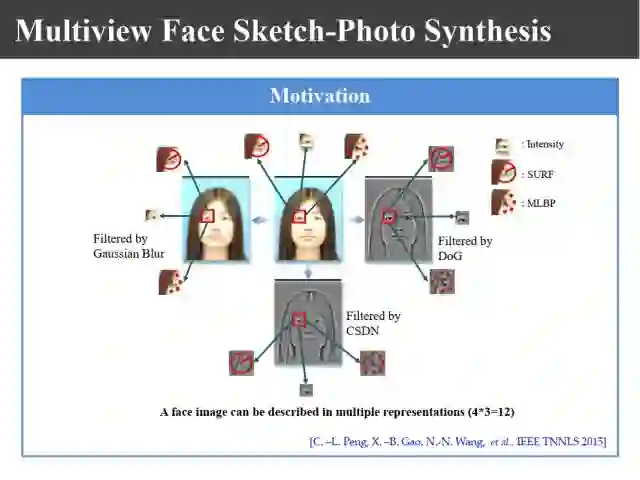

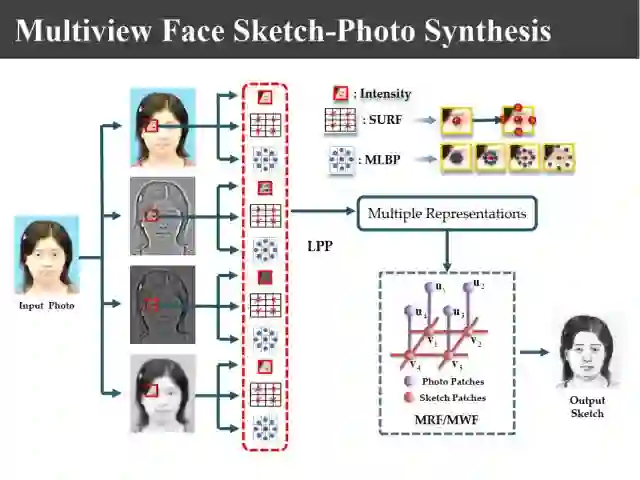

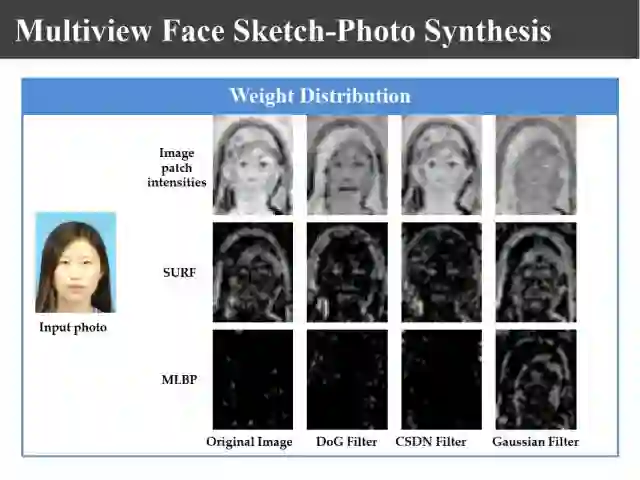

为了解决这个问题,我们做了一个上图所示的基于多视的表示方法,进行特征描述的时候,不仅仅用灰度,还利用不同的滤波器滤波以后的图像,在图像上分别提取灰度信息、SURF特征、多尺度LBP特征,构造非常复杂的特征表示形式。

利用这个精细的表示形式,可以利用刚才讲的概率图模型进行上图所示的合成。

但是,由于生成不同的图像,不同特征的贡献率不一样。所以又引入一个加权系数,同时要学习一个合成的加权系数W,它们之间通过上图所示的迭代来进行优化。

同样基于概率图模型构造似然项和先验概率项,最后得到了上图所示的联合概率密度的形式。为了避免平凡解,我们还加入了一项正则项。

上图就给出不同特征的贡献程度,越亮的话就表示这个特征起的作用越大,越暗表示起的作用越小。

上图是我们由照片生成的画像,其他方法由于背景不一样可能会生成一些伪的背景。

同样我们可以由画像生成照片,上图是我们的实验结果。

可能对其他的照片我们的视觉不一定敏感,对于名人的照片一般都比较敏感。上图是对于一些明星的照片合成的画像结果,其他方法可能都有一些伪的阴影出现。

上图表示在用其他描述方法上我们的识别率都达到97%左右。

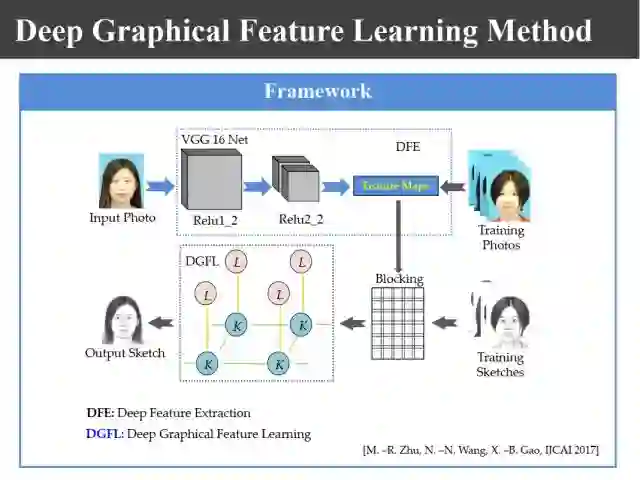

深度学习来了,前面的工作都是前些年做的,我们也不能免俗也要利用一下深度学习。刚才的特征提取方法完全可以换成CNN的方式来提取特征,然后再来进行描述,效果也是不错的。

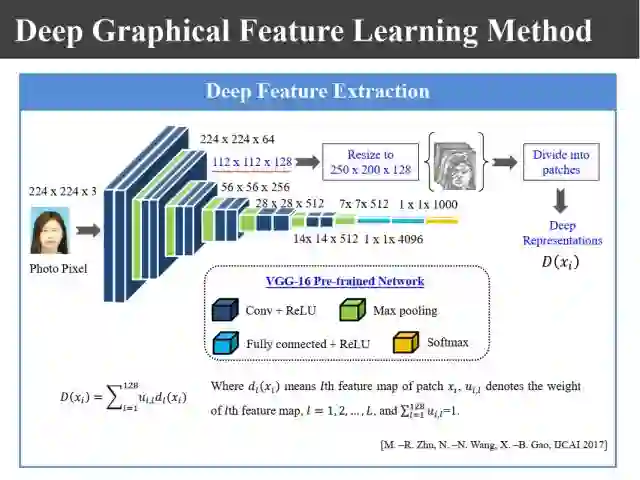

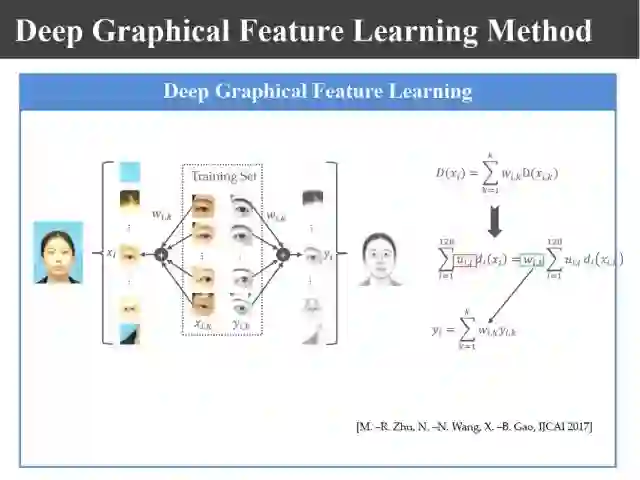

利用16层VGG网络提取特征以后,将特征加权和合成权值优化以后构造相关的函数。

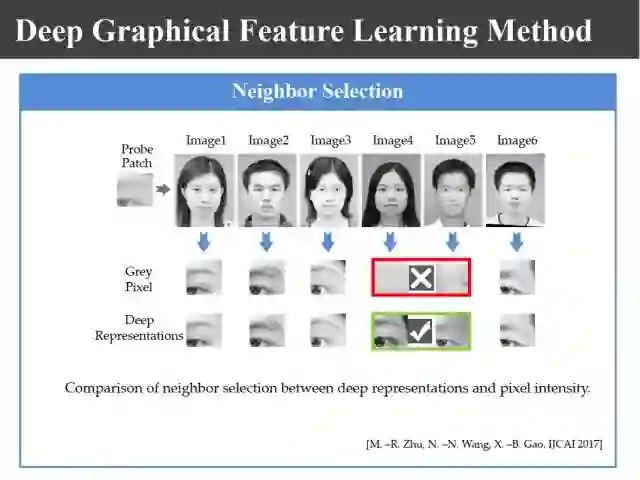

大家看一下上图,用了VGG以后,在寻找近邻块的时候性能往往比较稳定。利用灰度作为特征时近邻块可能会找错,而利用深度特征时就找对了,所以至少在这方面可以找到更好的近邻进行图像合成。

上图是基于深度学习合成出来的结果,也是不错的。

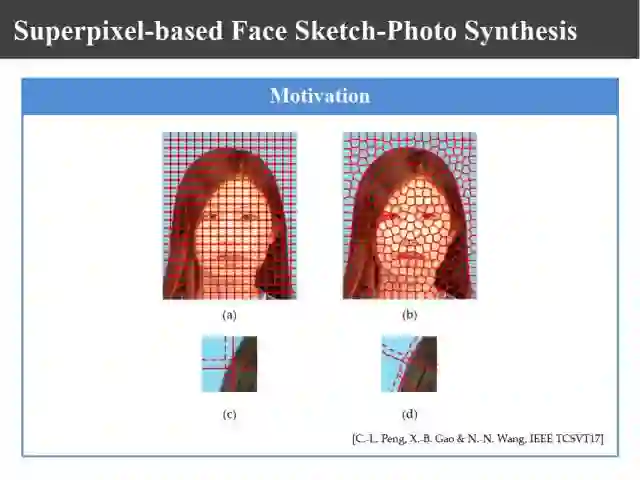

刚才我在分块的时候都是基于刘青山教授提出的均匀分块方法的。实际上均匀分块会分出上图所示的混合块,这个块既有眼睛又有眼睛以外的地方,既有头发还有皮肤,这样合成起来效果就会大打折扣了。

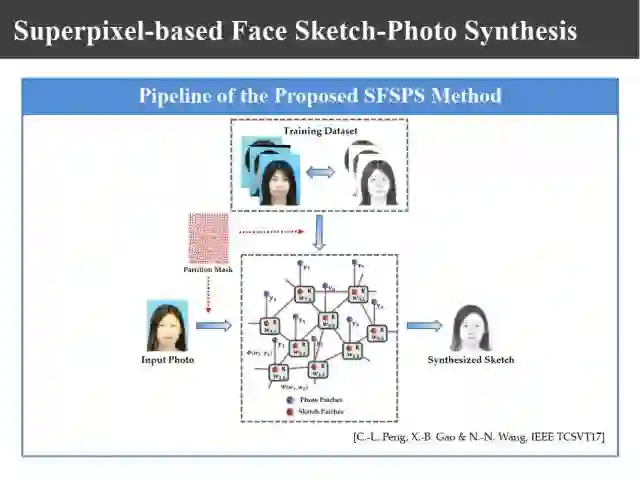

于是我们提出上图所示的基于超像素的自适应分块方法,使用超像素分割来进行分块,它的优点是更自适应了,缺点是原来的近邻非常规范,而现在每个块的邻域块可能数目都不一样了,需要将每个块的近邻块记录下来。

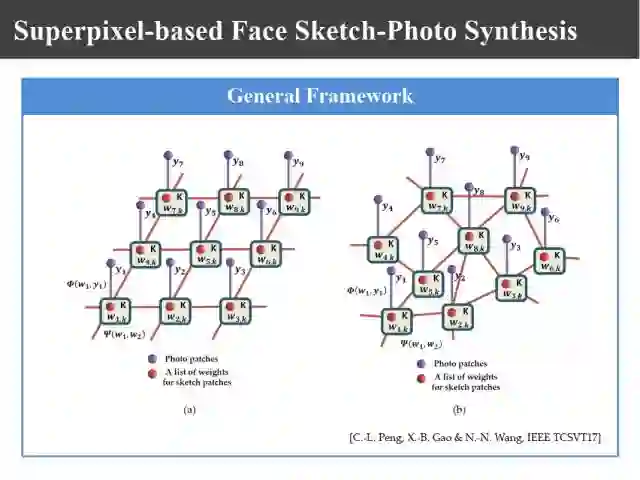

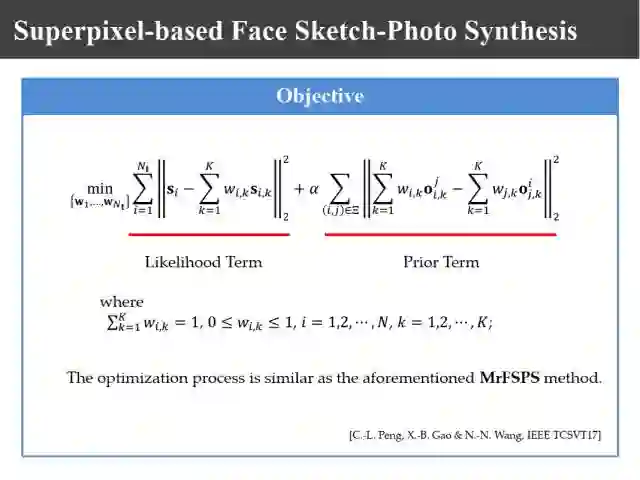

按照相同的方法构造目标函数,之后用基于概率图模型的方法即可生成画像。上面两张图分别展示了构造目标函数和概率图模型方法。

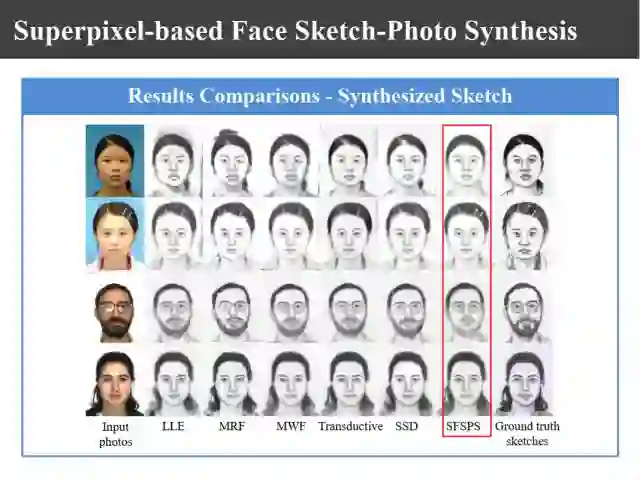

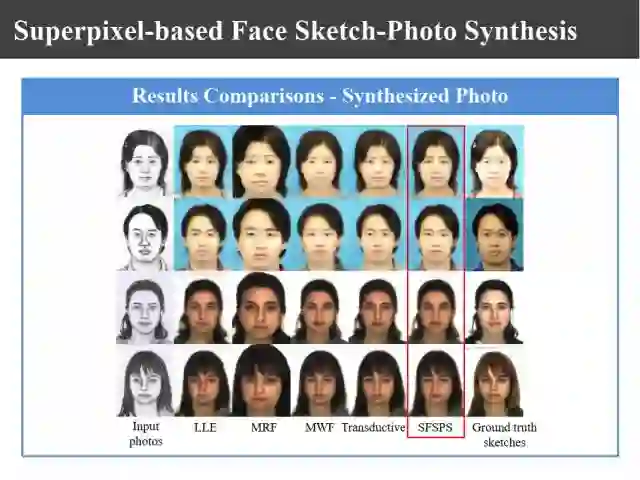

上图是我们生成的实验结果,从结果来看效果还是不错的。

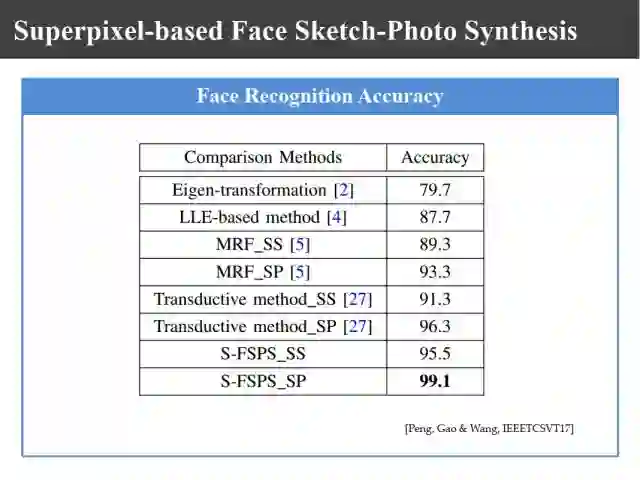

上图是由画像生成照片的识别结果,我们的方法识别率达到了99%。

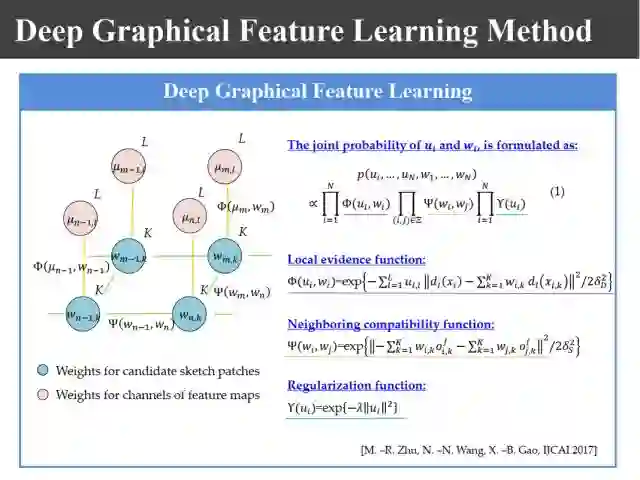

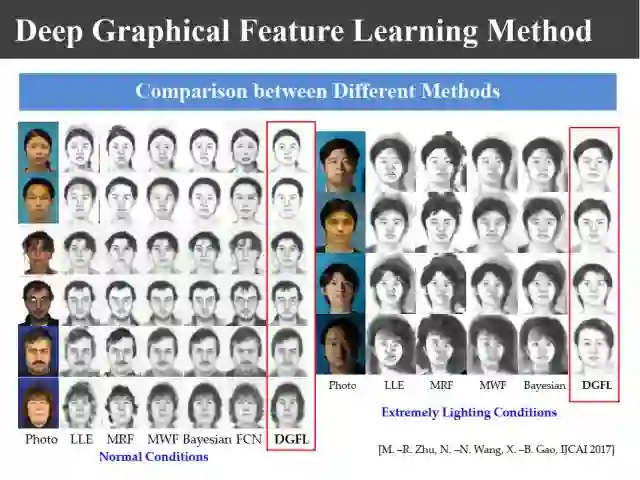

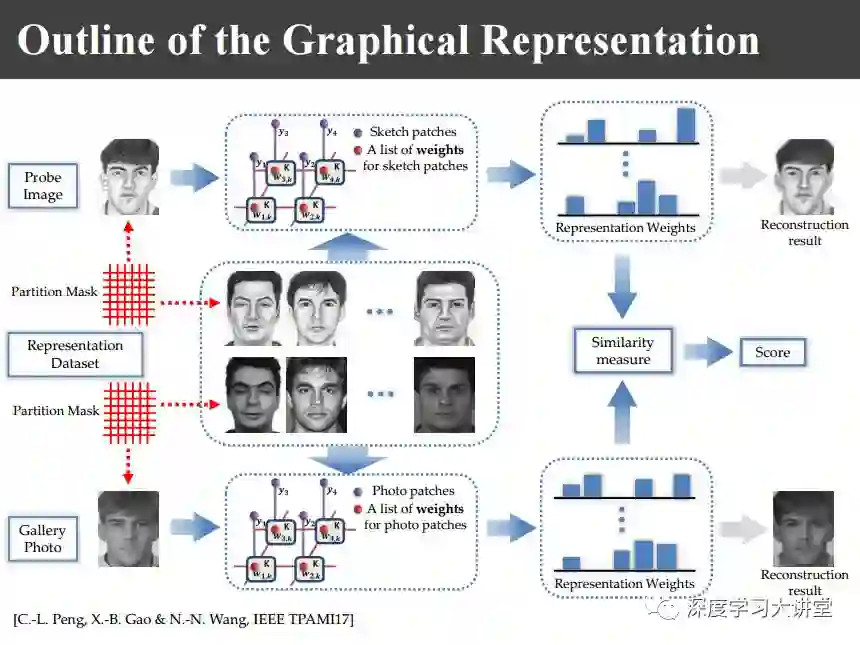

2017年的工作是把前面的相关工作进行了系统总结。我们发现整个算法流程基本上分为几个模块:对于给定的训练数据库,首先要对每一幅照片-图像对进行分块,进行图像块的描述,也就是说怎么来表示每一个图像块,另外就是近邻块的搜寻,怎么来寻找最近邻图像块,另外是怎样优化加权的权值W。

整个过程里面有两个部分需要优化,一个是对邻域块的搜索,一个是进行权值的计算。针对这两个模块,前面的工作只是对权值计算利用了概率图模型,而邻域图像块的搜寻同样可以利用概率图模型来优化。

把两个概率图模型加上以后发现效果更好一些。

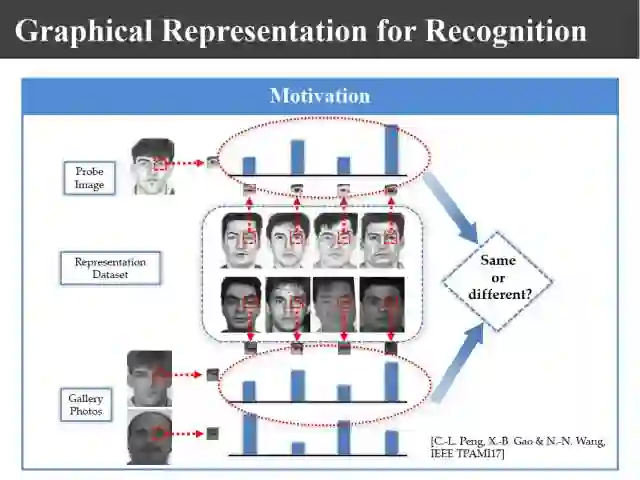

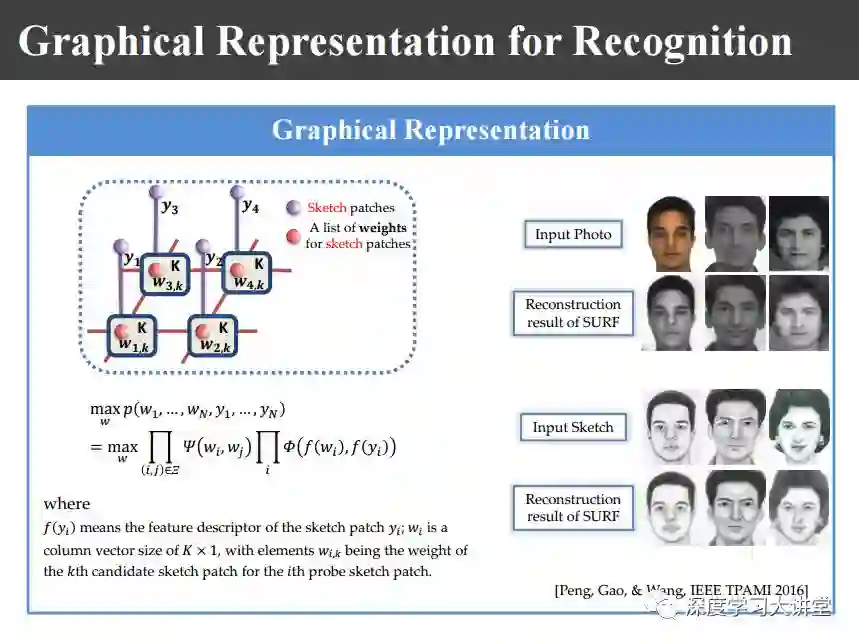

关于异质图像识别是这样的,前面的方法基本上是首先将异质图像通过合成转化为同质图像以后再进行识别。其实完全不必这样,可以直接在特征域进行比对,比如,用概率图模型表示以后,可直接基于概率图模型的表示进行匹配识别。

也就是说来一个图像以后,用概率图得到它的表示系数之后,对异质图像之间的表示系数进行匹配就可以了,这个工作发表在16年的TPAMI上。

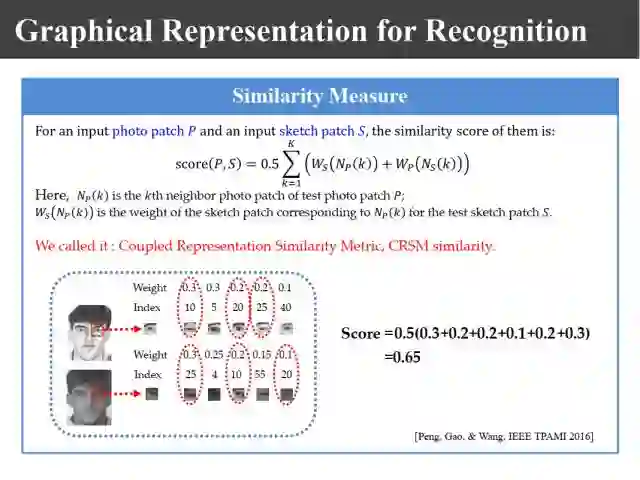

这篇文章的主要工作是构造了similarity的一个计算方法,当我们用上面所示的概率图模型表示图像块的时候,由于基图像不一样,所以必须首先找到基图像一样的系数进行相似性测度的构造,通过这样构造以后就可以直接利用表示系数的相似性进行识别了。

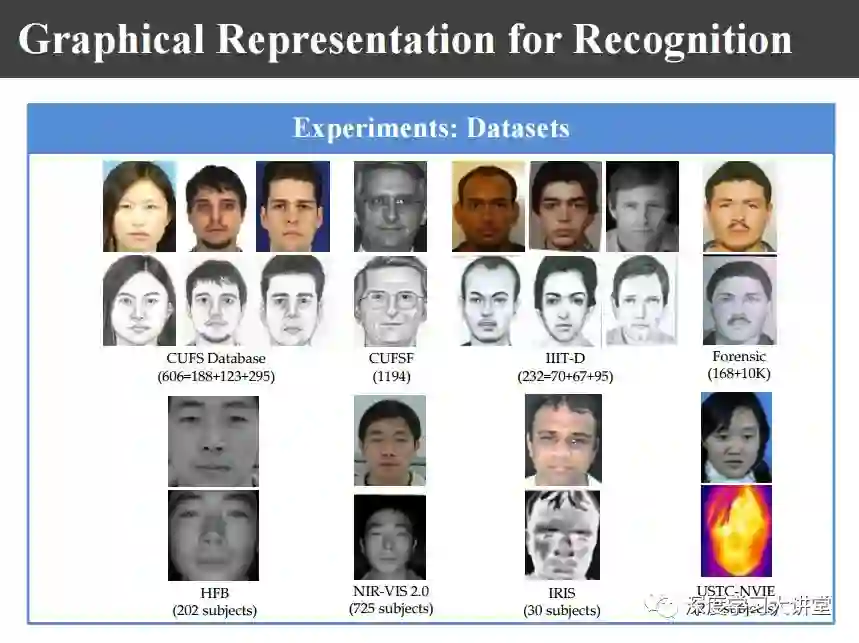

上图是不同的数据库,包括香港中文大学的CUFS和CUFSF数据库,印度的IIIT数据库,网上的数据库,照片、可见光和近红外的数据库,可见光和热红外的数据库。这里所谓的异质图像是指不同传感器得来的图像。

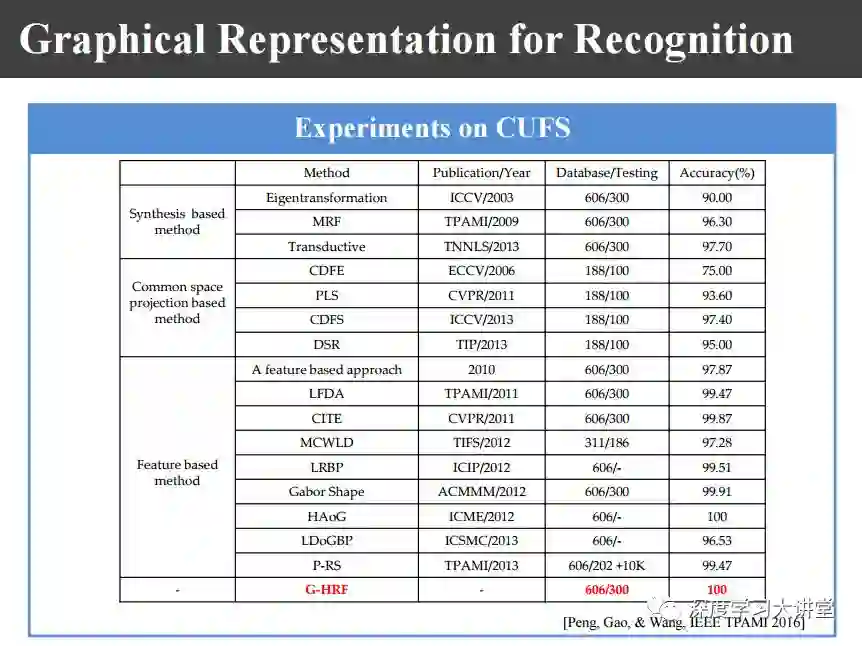

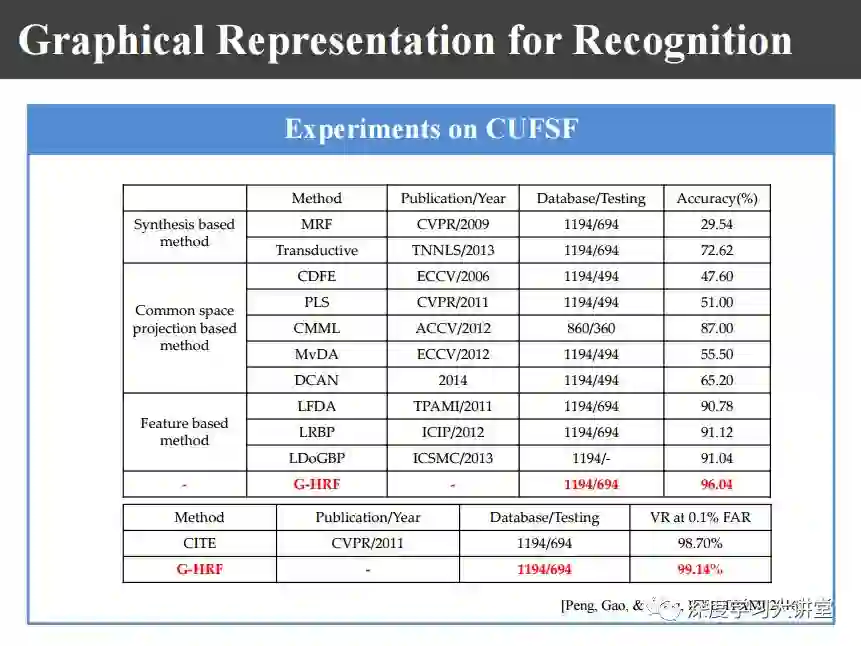

上图是我们在不同数据库上实验所得到的识别率。我们在香港中文大学数据库已经达到100%的识别率,加了Forensic数据库之后变成了99%,在identification上面是96%,在verification上得到99%的识别率。

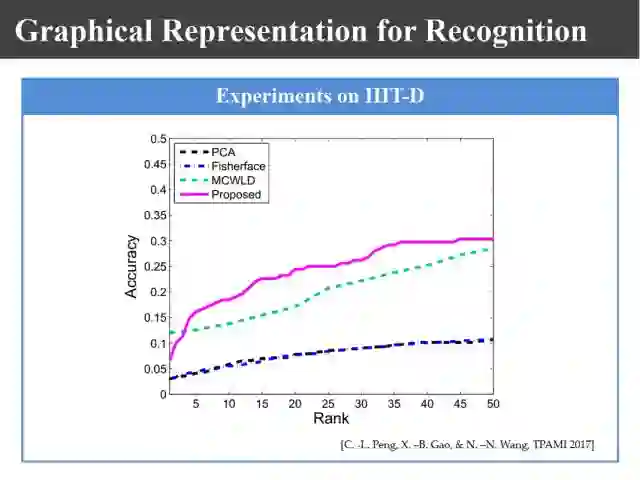

上图是在IIIT数据库上的识别结果。识别率只有不到30%,因为这个数据库中的画像都是基于记忆而绘制的画像,画像和照片之间对齐的非常不好。

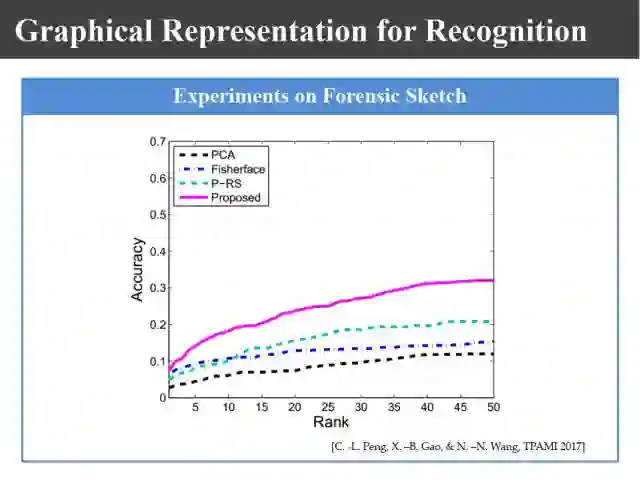

上图是在Forensic数据库上的识别结果,我们的方法得到最好的结果,也不过30%。

刚才的方法都是基于data-driven,下面来介绍基于model-driven的异质图像合成和识别方法。

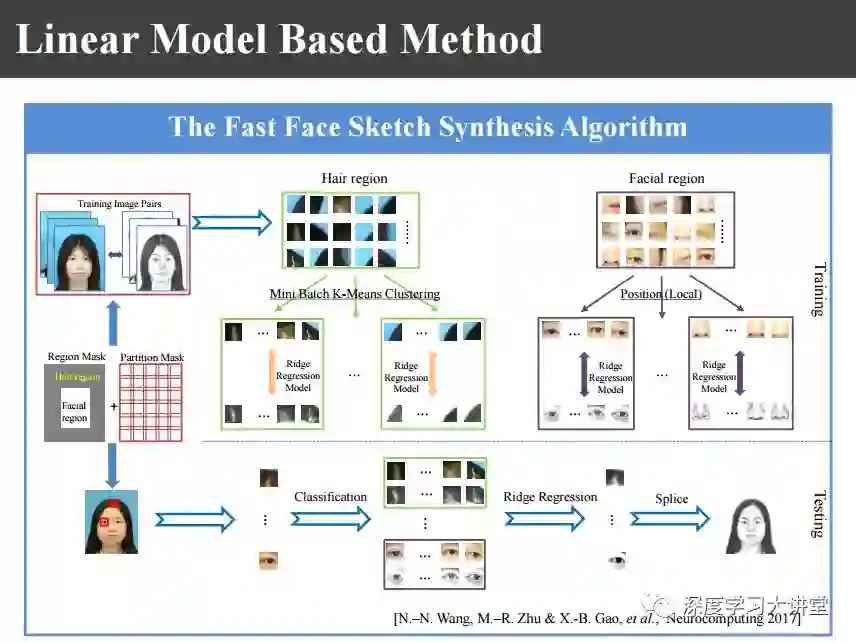

上图是一个基于线性模型的方法,基于Ridge Regression脊回归的简单工作。给定一幅图像之后,我们首先进行区域划分,分成头发区域和人脸区域,对于头发区域利用mini batch K-means算法进行聚类,聚类以后对类内进行脊回归;对于人脸区域仍然找它的近邻,眼睛找眼睛区域,鼻子找鼻子区域,对每个区域基于位置进行脊回归,然后把两部分回归的结果进行组合之后就可以得到合成的画像。

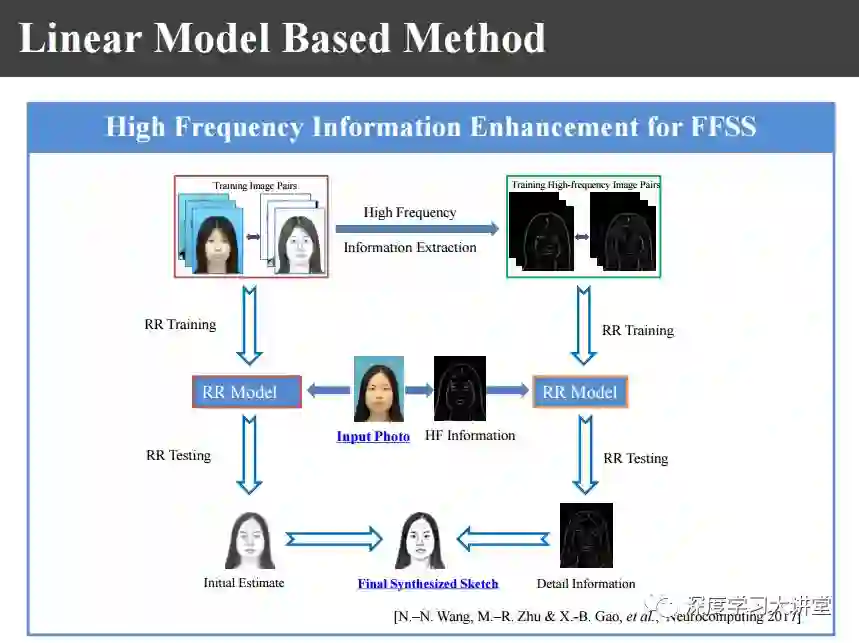

上图是整个合成过程的框图。为了获得更为清晰的结果,也可以增加高频增强模块,即针对给定图像的高频部分也进行类似的异质图像合成。

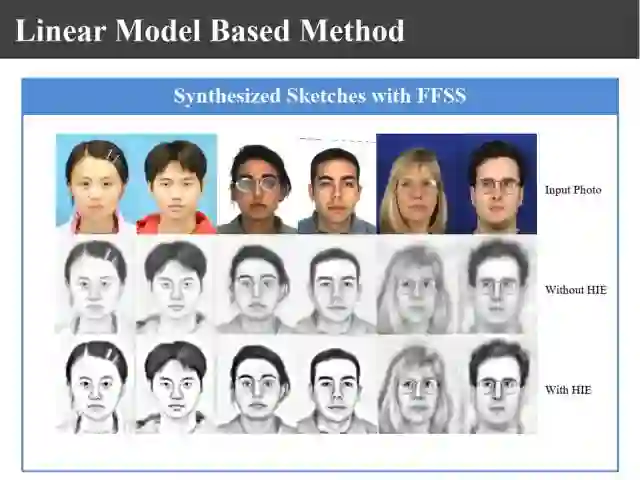

上图是使用了高频增强和没有使用高频增强所得到的合成图像的对比。

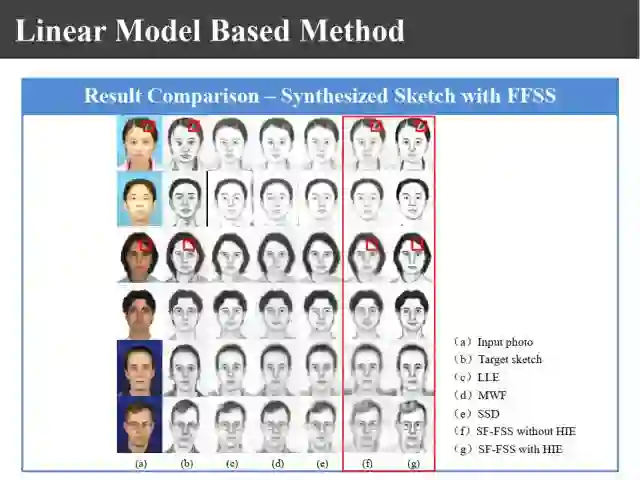

上图是在另一个数据库上的结果。

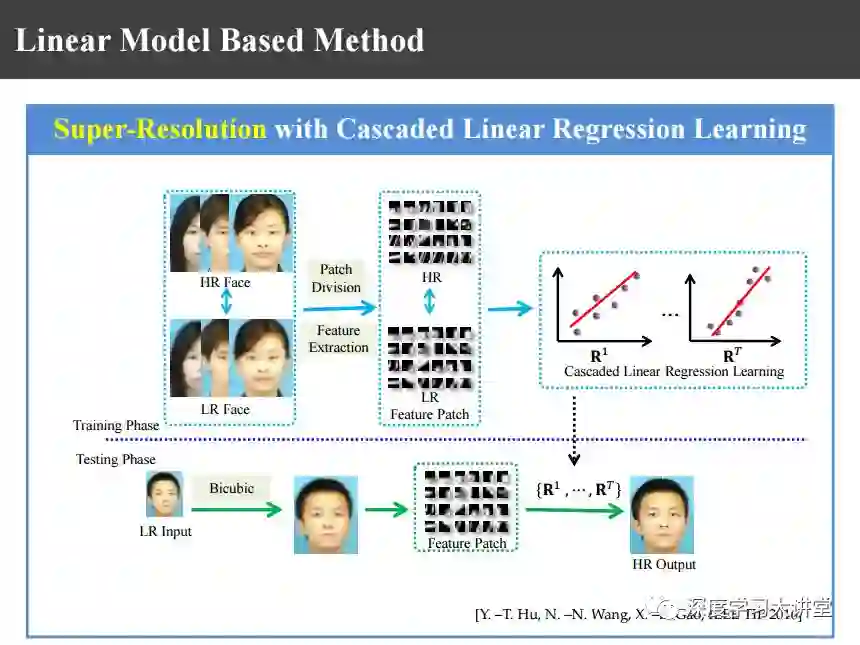

我们方法的特点是速度非常快。因为使用了脊回归,有回归函数以后,对于新来的图像直接做回归,结果就直接产生了。同样的算法也可以用在超分辨重建上,用在超分辨重建上以后也可以得到很好的结果。因为从本质上来看两个问题是一致的。

基于非线性回归的方法当然就是基于最近比较热的基于深度神经网络的方法。

最近,大家都比较熟悉所谓的基于端对端的学习,还有上图基于conditional GAN的方法。不管是照片还是画像,把它映射到另外的异质图像域里,在这个图像域计算它的重建损失reconstruction loss。

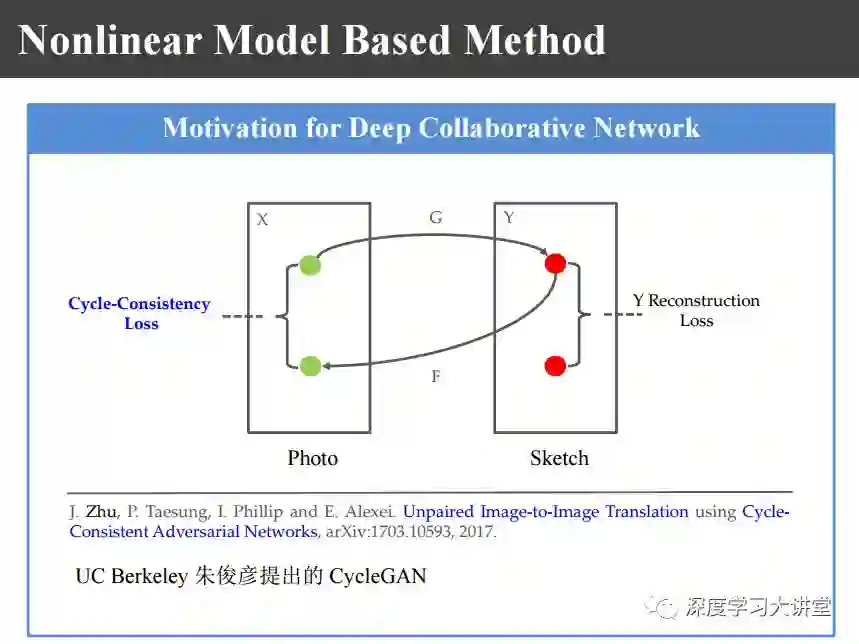

后来UC Berkeley的朱俊彦博士提出了上图的CycleGAN,对照片或者图像映射到异质图像域以后再反映射回来,在原始图像域计算Cycle-Consistency Loss。比如,在超分辨重建的时候没有高清图像,在这高分辨域没办法算Loss函数,还要再反映射回来在低分辨域计算它的Loss函数。

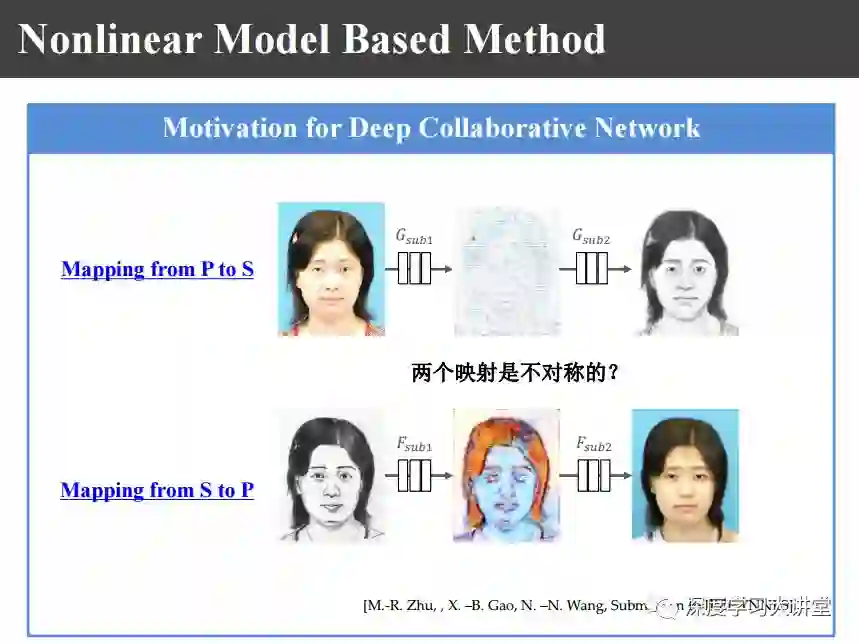

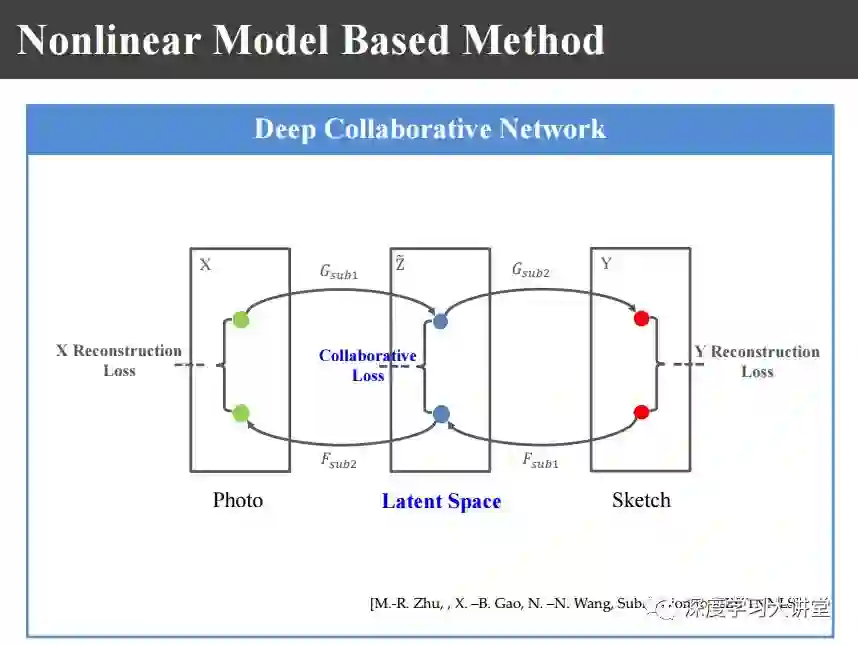

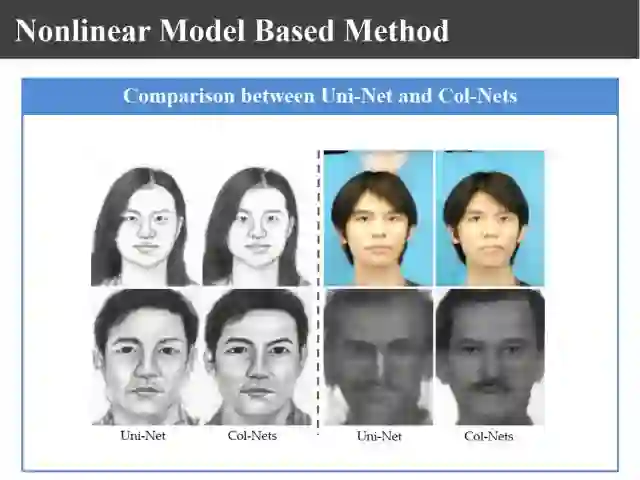

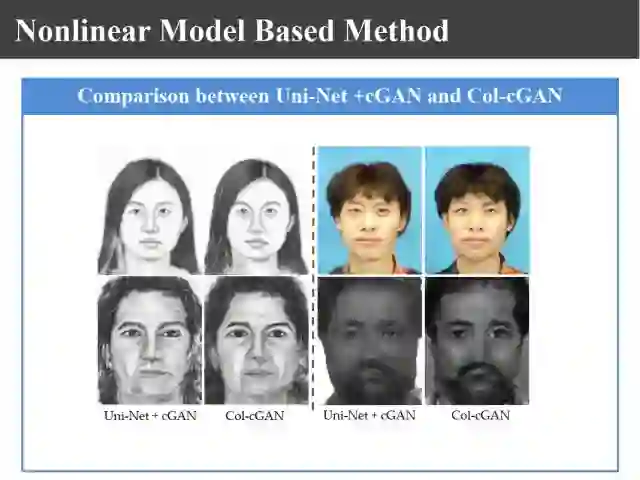

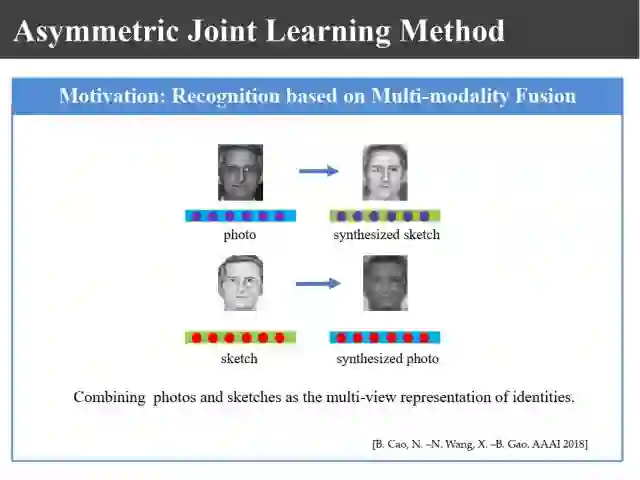

在此基础上我们有上图的考虑,图像正反两个映射是分别单独学习的,从照片到画像学一个,从画像到照片再学一个。那么,这两个映射能不能联合起来一起学习呢?两个映射之间是不是对称的呢?在研究的过程中,上侧是从照片到画像,下侧是从画像到照片,我们把神经网络中间结果拿出来以后发现不是很对称,如果不加约束的话就不是对称的,所以我们就增加一个约束使得它们两个之间能够是对称的,所以就构造下图所示的中间隐空间latent space。

如上图,在这个隐空间里面,原来端到端网络和conditional GAN是在变换空间里面计算它的loss,前面的CycleGAN是在原始空间里面计算loss的,我们希望在隐空间里面计算协同loss。

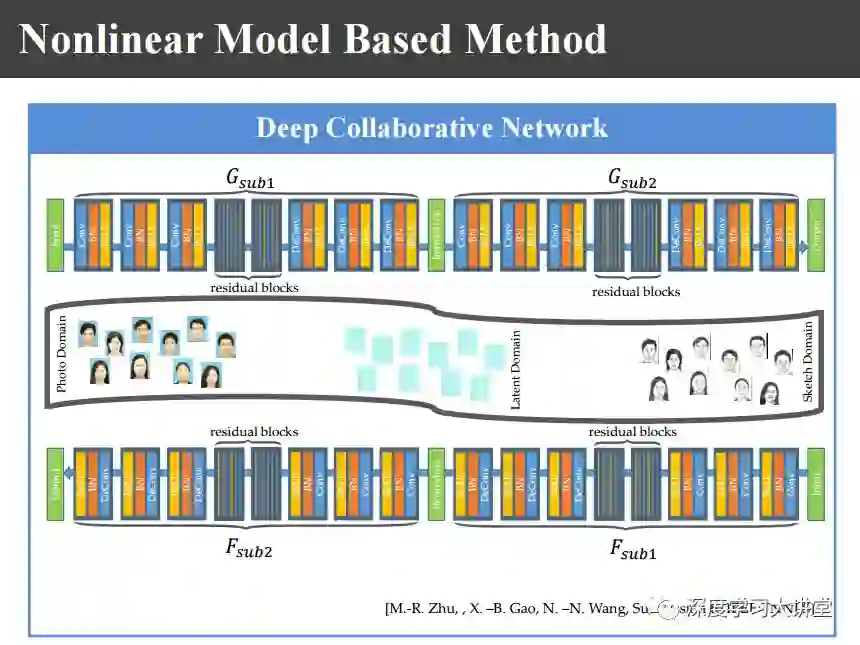

这样一来我们希望把画像和照片、照片和画像之间两个映射在隐空间里面达到相似,这样一来我们提出上图的深度协同网络。

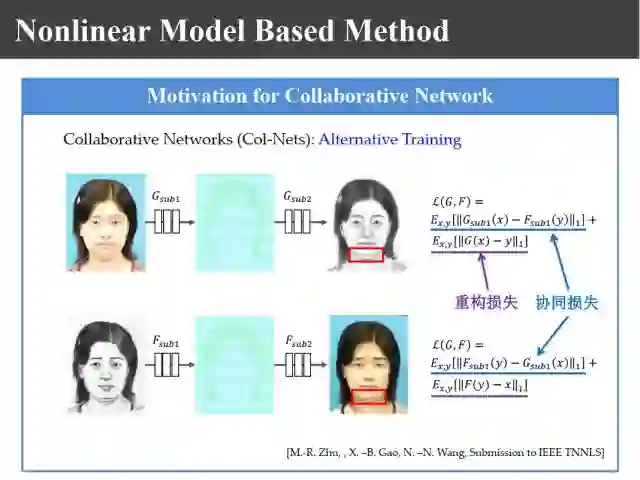

利用深度协同网络使两个映射之间越相似越好,这样就构造上图的重构损失和协同损失,利用两个损失进行约束和优化。

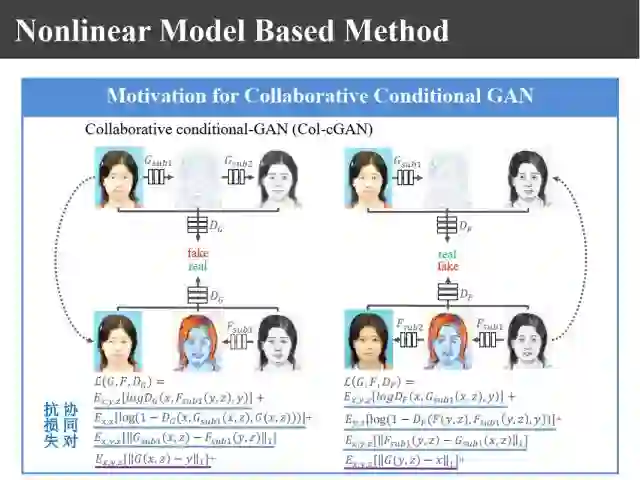

如上图,同样也可以引入GAN,这两个映射G和映射F都可以用生成对抗式网络进行学习。

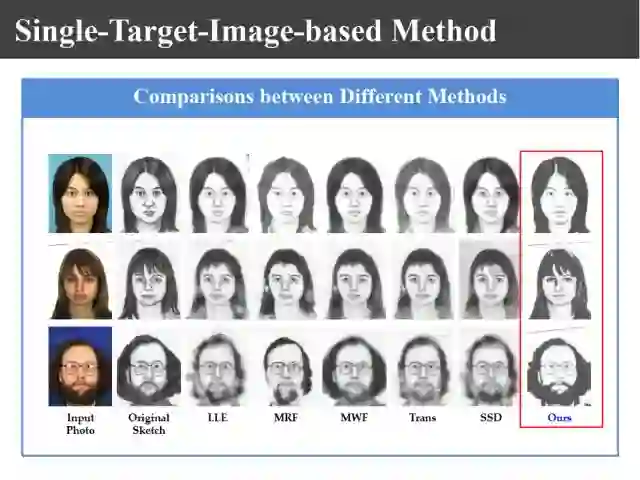

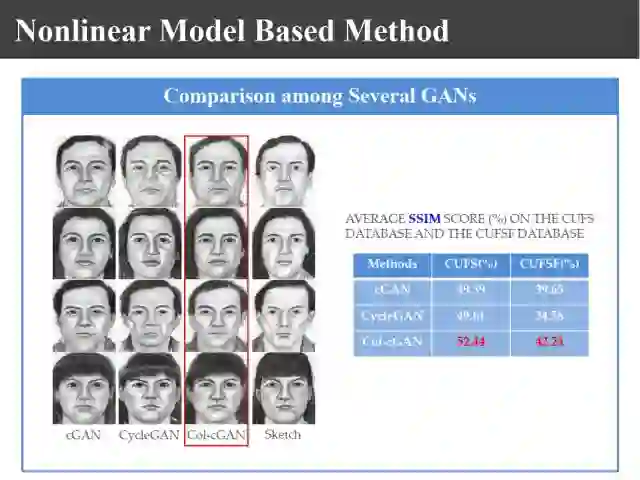

从上面两张图可以发现,通过协同学习比不协同学习合成图像的质量要好的多。

上图是我们基于协同学习得到的实验结果,另外两种都是基于GAN得到的结果。从图像质量评价测度来说,我们这个结果优于他们的结果。

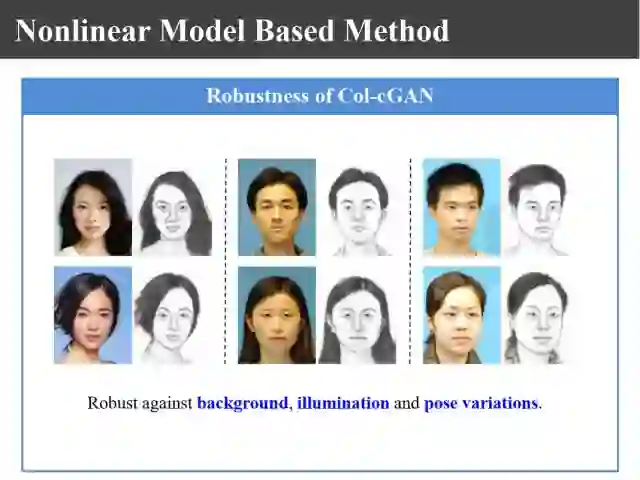

上图展示了我们方法的鲁棒性。通过这个方法它的鲁棒性也非常好,不管是对背景、对光照、对不同姿态都不是那么敏感。

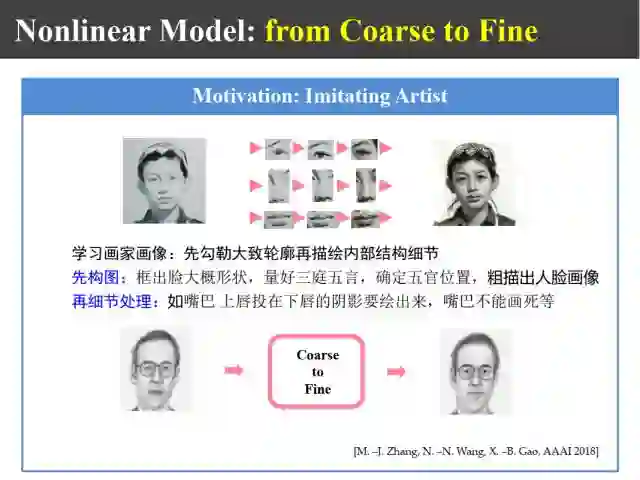

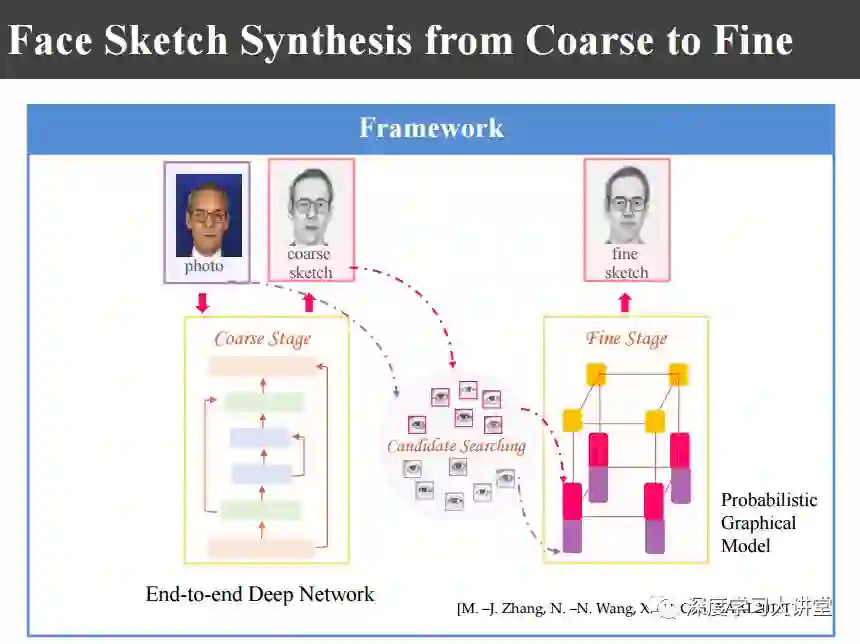

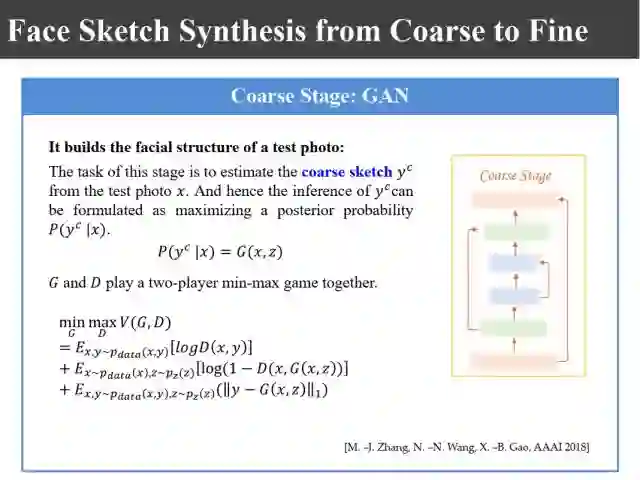

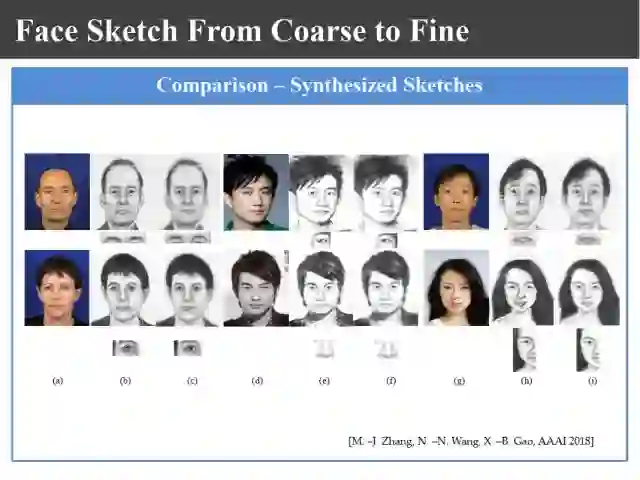

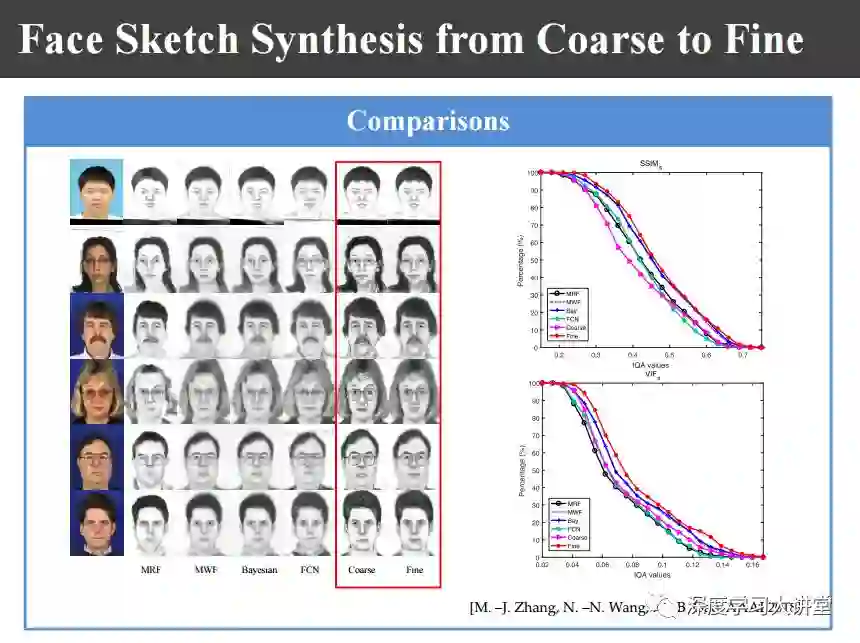

另外我们基于画家画像先画轮廓再画细节的做法,还提出了一种上图中由粗到细的合成方法。

首先利用端对端的GAN学习粗的模型,再利用概率图模型进行细化。

上图是其中涉及到的公式,具体大家可以看我们的相关论文。

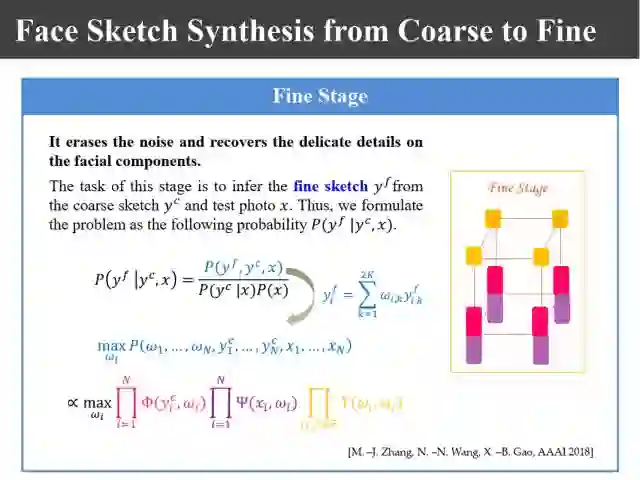

其中的精细结构仍然是基于概率图模型来得到的,其核心是似然函数和先验概率的构造。

上图是我们生成由粗到细的结果,效果越来越好。

上图是我们和其他方法的对比结果。

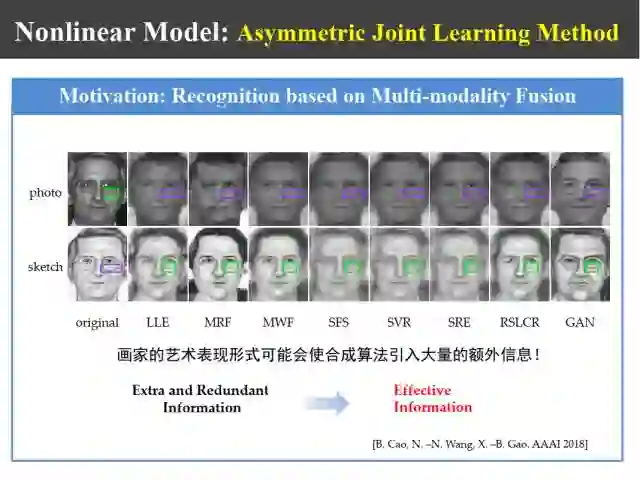

如上图所示,在人脸识别过程中,我们发现不同合成方法都合成出来一些额外信息,而这些额外信息有时候对识别是有用的,可以增加训练样本的多样性。

比如说上图中有些区域,比如说眼袋,不同合成方法合成出来的情况不一样,具有多样性。另外比如说眼镜,眼镜本来没有框,为了画像的效果画家往往会给眼镜画了一个框,合成出来结果有的有框有的没框。那么,如何利用这些额外信息提高模式识别的鲁棒性呢?这为我们的研究提供了新的线索。

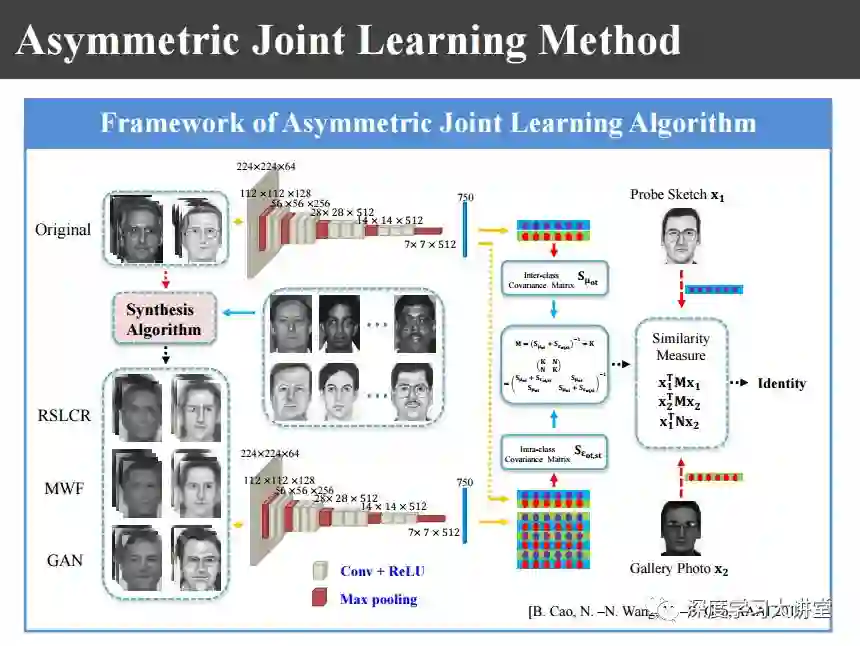

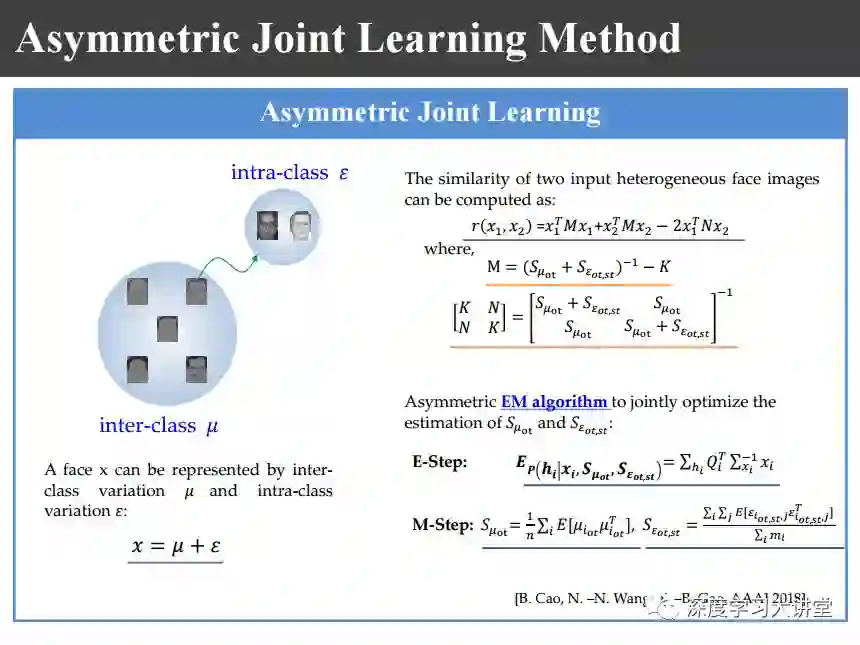

为此我们就提出上图非对称联合学习的识别方法。也就是说,有了照片和画像以后,用不同合成方法都去合成出一些画像和照片来,利用这些信息可以来学习对应不同个体的图像的类内方差,这是为后来的识别服务的。也就是说我的画像和照片对,有了画像和照片数据库以后,把数据库里面的照片和画像都用不同的合成方法合成出一些新的图像对。提完特征以后,利用这些特征提取类间的协方差矩阵和类内的协方差矩阵。类内的协方差主要是因为使用不同的方法合成的,类间的主要还是因为训练不同的数据库里的图像,所以说蛇是一个非对称的学习。

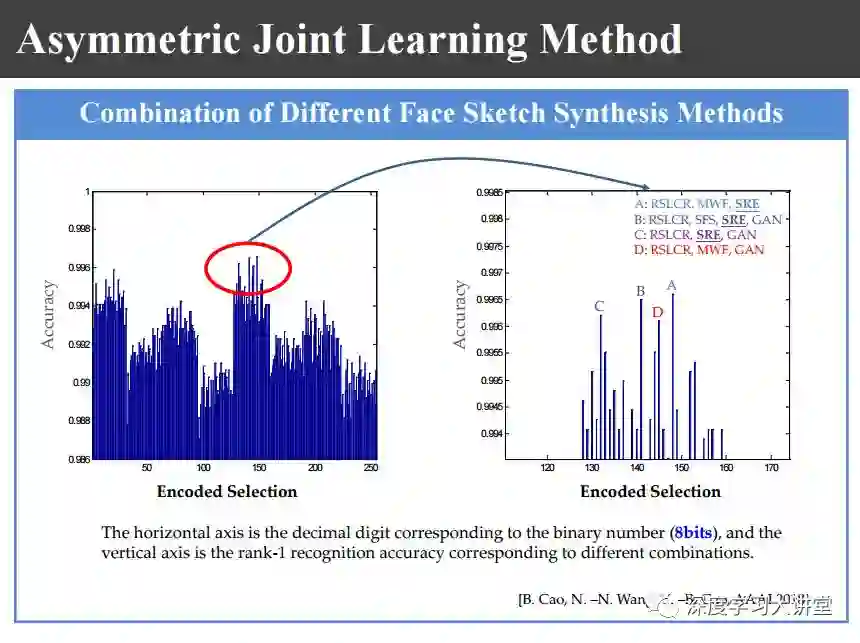

我们有8种图像合成方法,我们分别对这8种用8个二进值数来表示,对所有的256种情况都做了上图的比较,最后选了一种效果不是最好、但是速度最快的方法来进行合成。

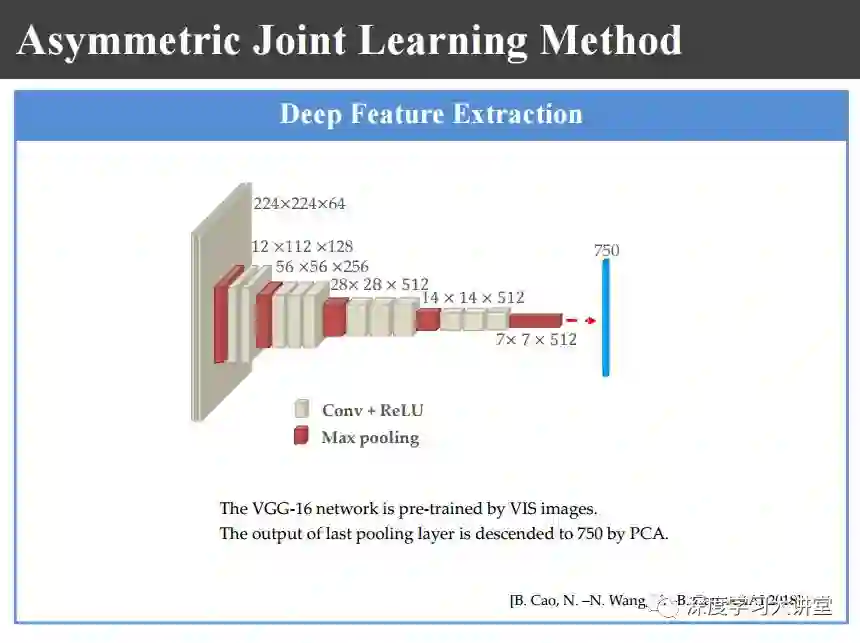

合成以后我们使用上图所示的网络来提取深度特征。

如上图所示,分别计算类间和类内的协方差矩阵,利用这两个协方差矩阵来进行识别。

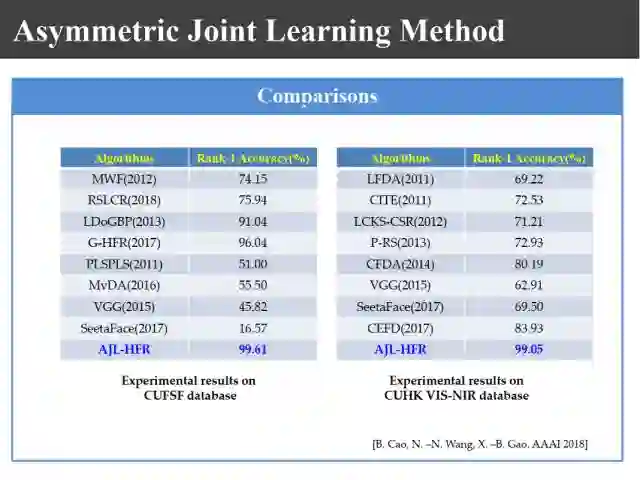

在上图不同数据库上做识别以后,我们现在识别结果在CUFSF数据库上可以达到99.61%,在CUHK VIS-NIR数据库上达到99.05%。

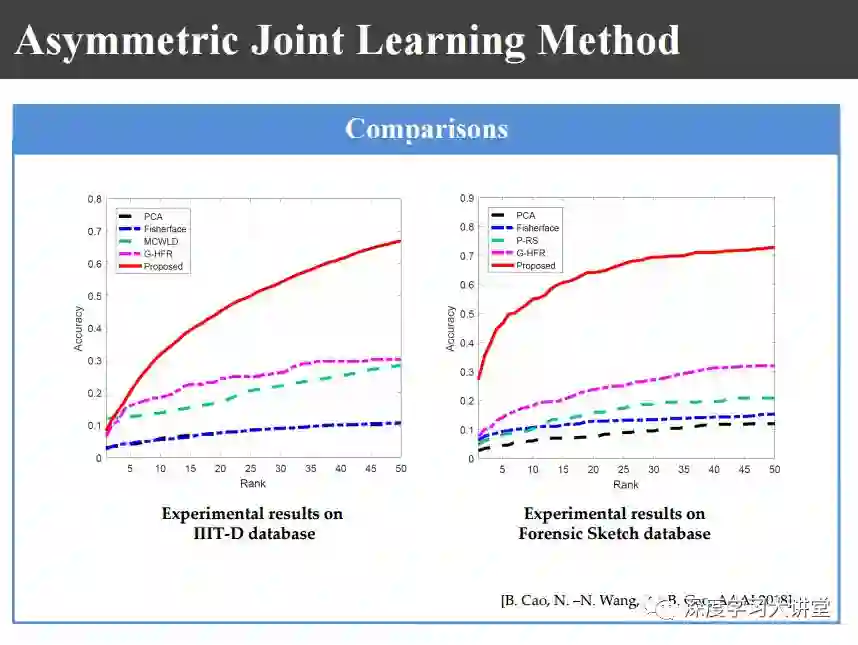

即便是在印度理工的数据库上,过去的识别率是30%,现在可以达到60~70%的结果,这个结果已经是非常好的了。

最后我总结一下。

上图系统总结了我们8年以来在异质图像合成方面的工作,主要有data-driven和model-driven两种不同类型的合成方法。

如上图,异质图像不仅仅是画像和照片、低分辨和高分辨、侧面到正面,还有其他的情况,还可以把这些方法进行不断推广。

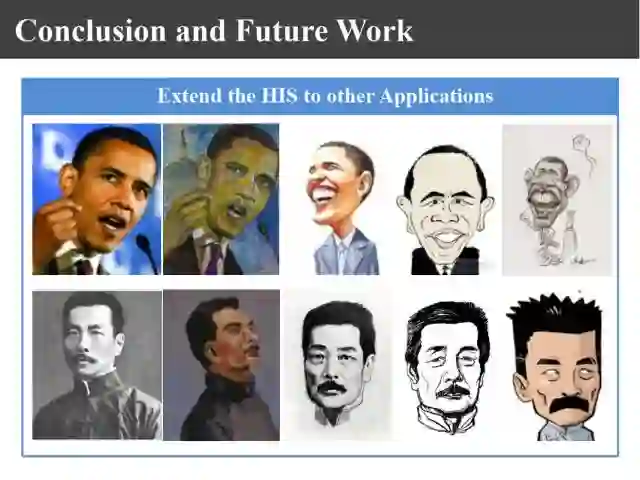

比如说推广到上图这种情况。上图这些都是异质图像,如果将来能生成油画甚至漫画就更好了。

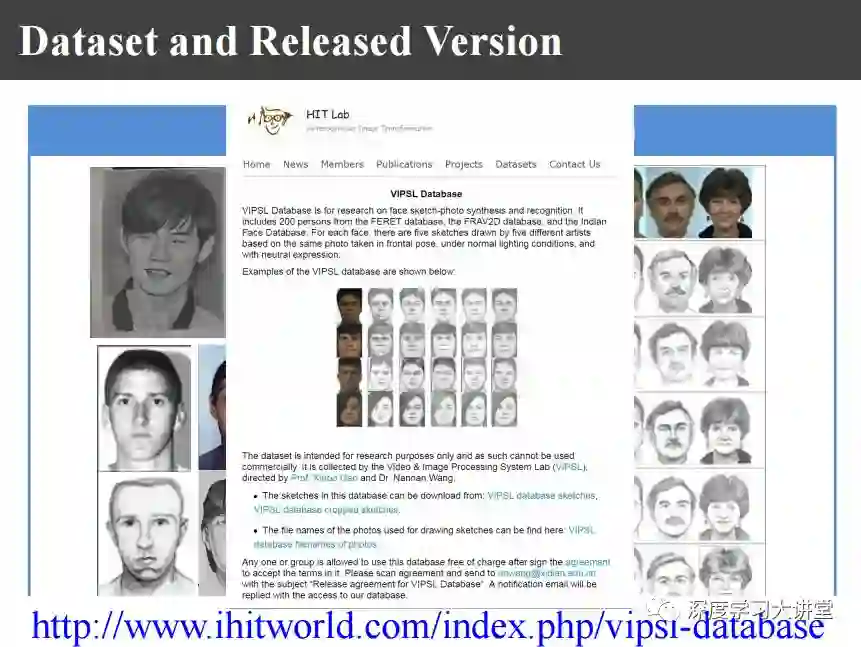

另外相关的数据库也非常难得,有的画像是看着照片画的,也有看一眼之后根据记忆画的,这种就更难了,真实应用的时候都是根据记忆来画的。现在我们找美院学生对不同照片由5个人来画了画像,这个画像已经在网上release。如果大家有兴趣的话,可以到上图的网站上去下载,可以去进行测试。

上述整个工作是我的团队和我一起完成的,团队主要成员有王楠楠副教授,另外还有我的几个博士后、博士生一起完成的,在此一并感谢。

最后谢谢大家。

文中提到参考文献下载链接:

https://pan.baidu.com/s/1pACLck_EcMJBve0NCXNxBA

密码: nv3f

主编:袁基睿,编辑:程一

整理:周文、杨茹茵、高科、高黎明

--end--

该文章属于“深度学习大讲堂”原创,如需要转载,请联系 Emily_0167。

作者简介:

高新波,博士,教授,西安电子科技大学模式识别与智能系统学科带头人,综合业务网理论及关键技术国家重点实验室主任,国家万人计划科技创新领军人才,新世纪百千万人才工程国家级人选,国家杰出青年科学基金获得者,教育部长江学者特聘教授,科技部重点领域创新团队负责人、教育部创新团队负责人。IET Fellow、CIE Fellow、IEEE高级会员、中国图象图形学学会常务理事、中国计算机学会理事、中国指挥与控制学会富媒体指挥专委会常务委员、中国电子学会青年科学家俱乐部副主席。主要从事计算机视觉机器学习等领域的研究和教学工作,获国家自然科学二等奖1项、省部级科学技术一等奖3项。

往期精彩回顾

欢迎关注我们!

深度学习大讲堂是由中科视拓运营的高质量原创内容平台,邀请学术界、工业界一线专家撰稿,致力于推送人工智能与深度学习最新技术、产品和活动信息!

中科视拓(SeetaTech)将秉持“开源开放共发展”的合作思路,为企业客户提供人脸识别、计算机视觉与机器学习领域“企业研究院式”的技术、人才和知识服务,帮助企业在人工智能时代获得可自主迭代和自我学习的人工智能研发和创新能力。

中科视拓目前正在招聘: 人脸识别算法研究员,深度学习算法工程师,GPU研发工程师, C++研发工程师,Python研发工程师,嵌入式视觉研发工程师,运营经理。有兴趣可以发邮件至:hr@seetatech.com,想了解更多可以访问,www.seetatech.com

中科视拓

深度学习大讲堂

点击阅读原文打开中科视拓官方网站