深度神经网络可解释性方法汇总,附Tensorflow代码实现

新智元推荐

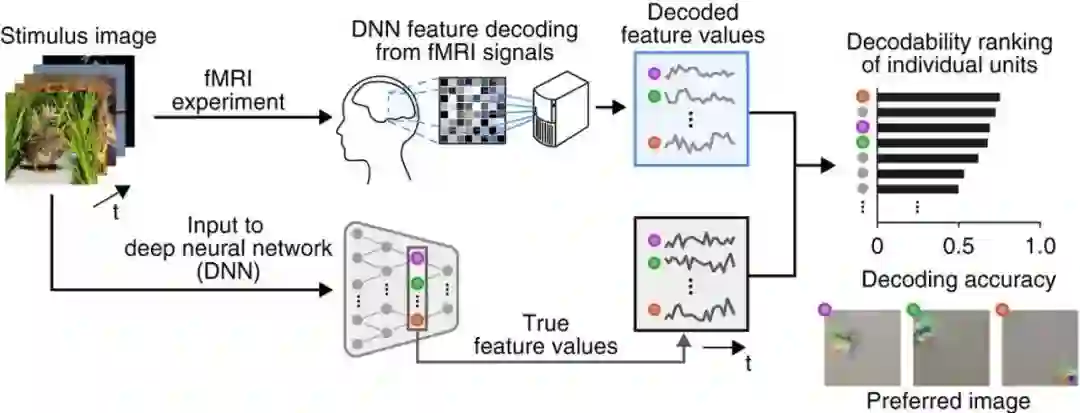

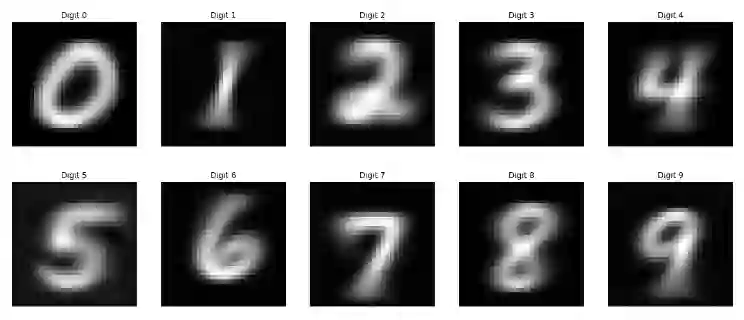

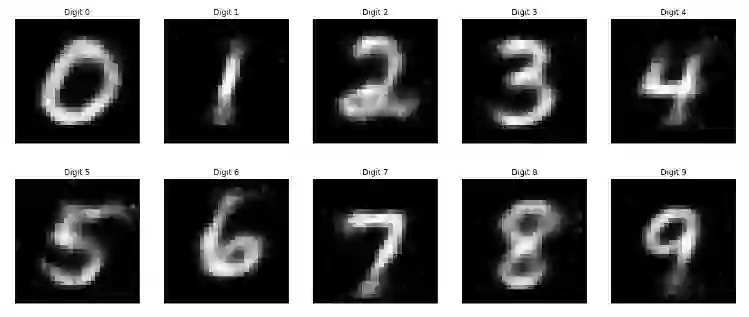

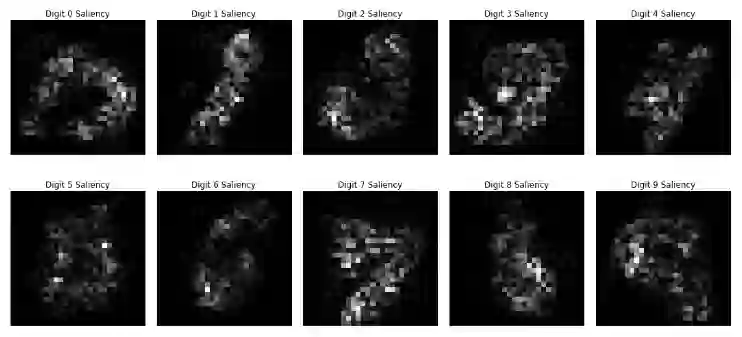

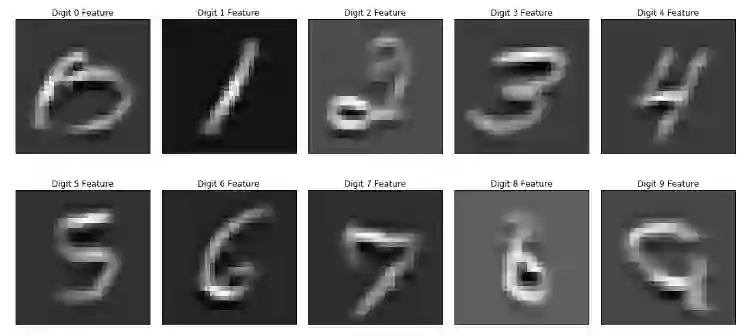

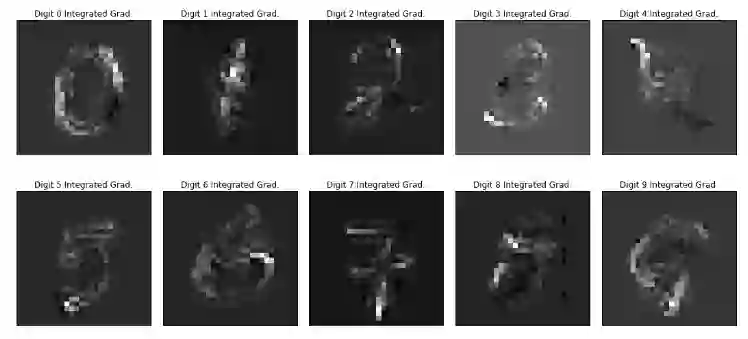

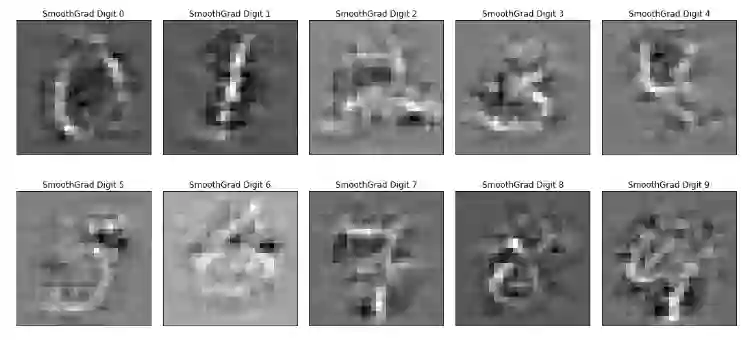

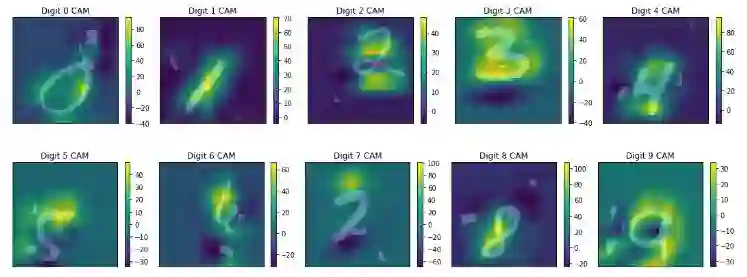

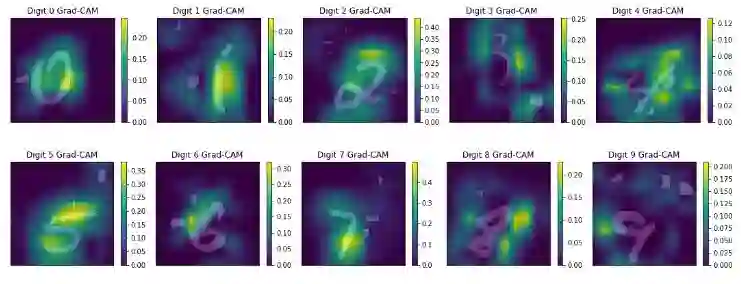

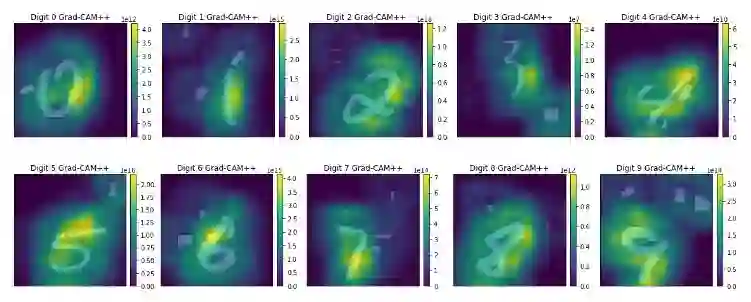

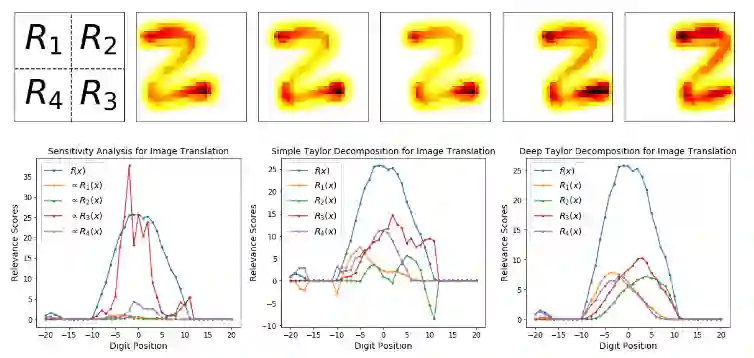

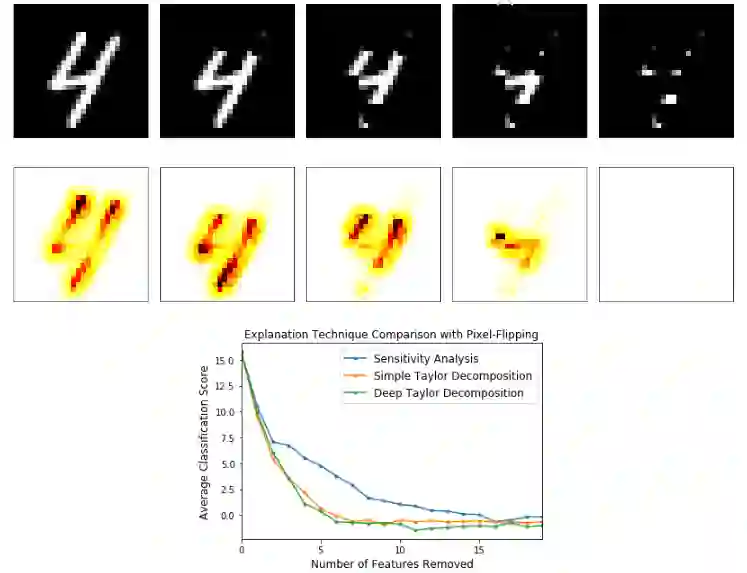

【新智元导读】理解神经网络:人们一直觉得深度学习可解释性较弱。然而,理解神经网络的研究一直也没有停止过,本文就来介绍几种神经网络的可解释性方法,并配有能够在Jupyter下运行的代码连接。来新智元 AI 朋友圈和AI大咖们一起讨论吧。

登录查看更多

相关内容

Arxiv

4+阅读 · 2018年5月24日