![]()

作者 | 蒋宝尚

5月19日刚刚公布了2020年被收录的论文,昨日又发博客分析了大会论文的录取领域。并且与2019年的ACL会议论文进行了比较。

![]()

地址:https://acl2020.org/blog/general-conference-statistics/

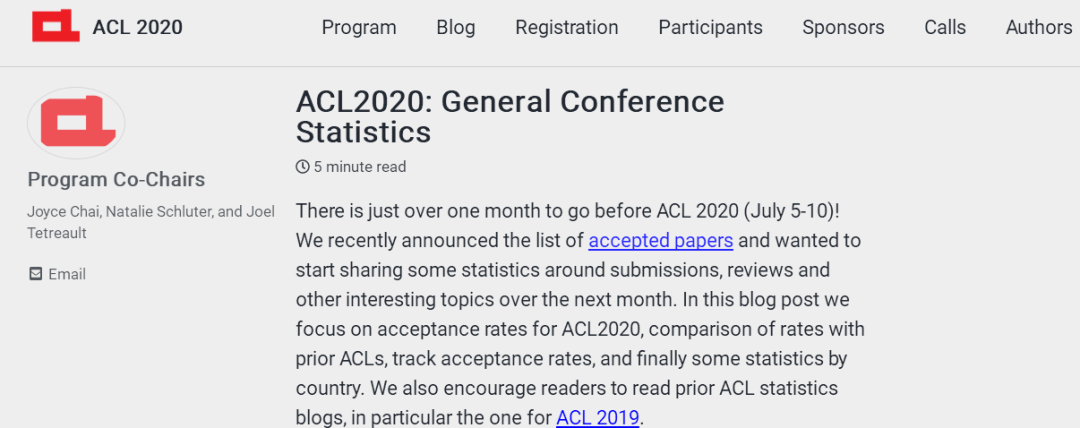

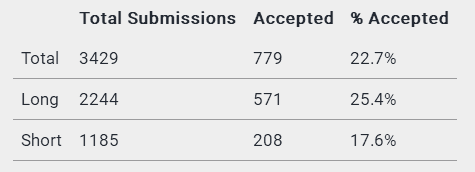

在博客中,ACL组委会将之前的3088篇论文提交的数据更正为3429。如此一来,在接收论文为779篇不变的情况下,

接受率由之前的25.2%变为22.7%。

当然,组委会也解释了这一变动的原因,即之前有29篇直接拒稿(Desk Reject)和312篇撤回(Withdrawal)稿件没有计算在内。

图注:779 篇论文中包括 571 篇长论文和 208 篇短论文

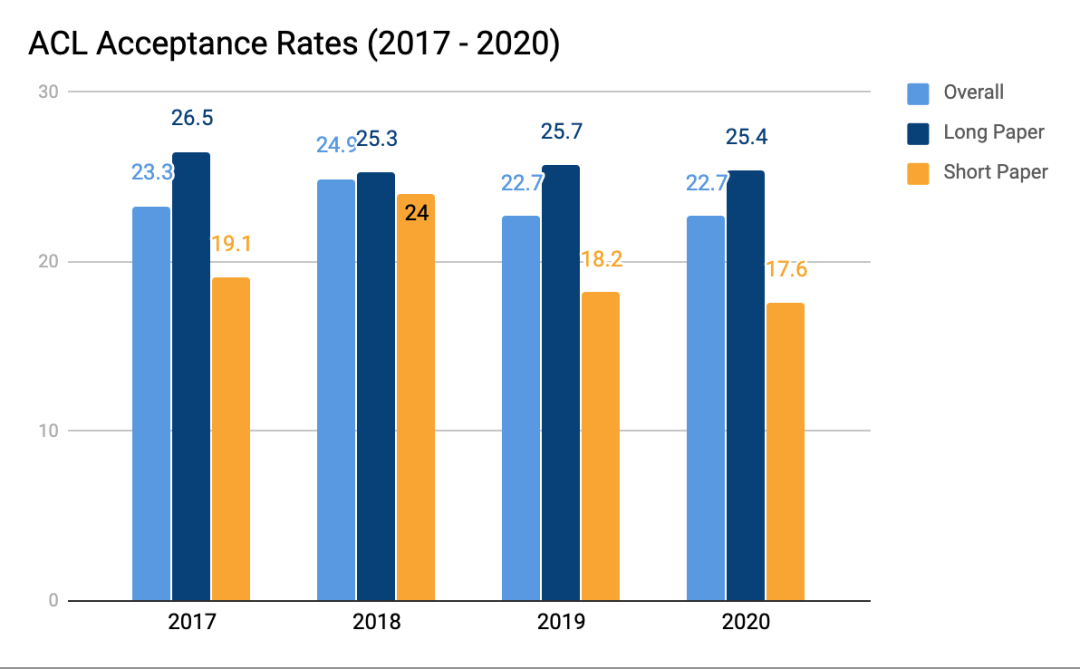

ACL 2020 的录取率变为22.7%之后,刚好和ACL 2019打平,具体数据如下:

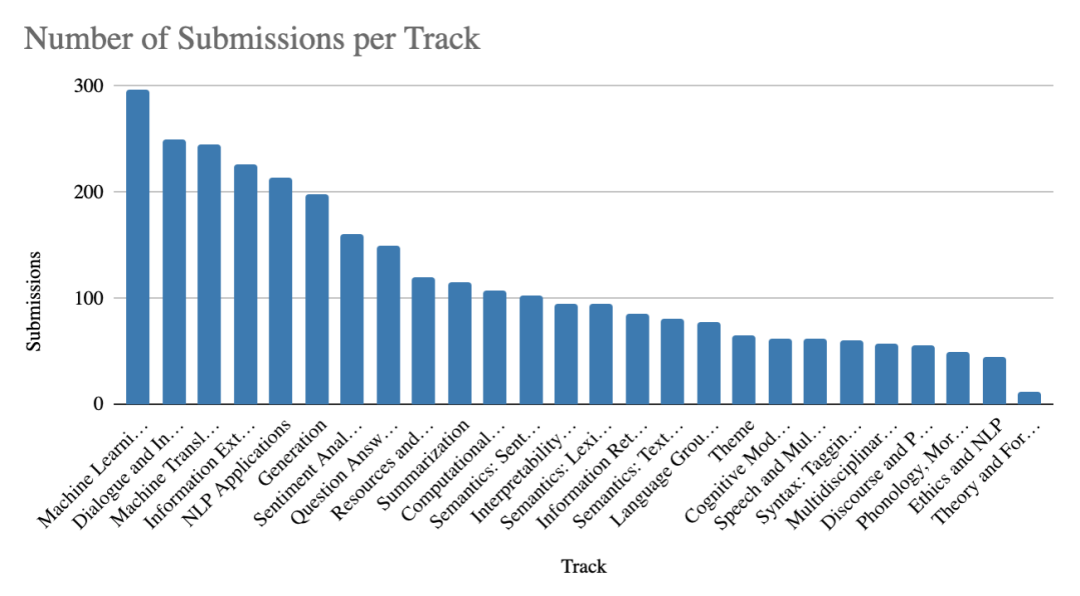

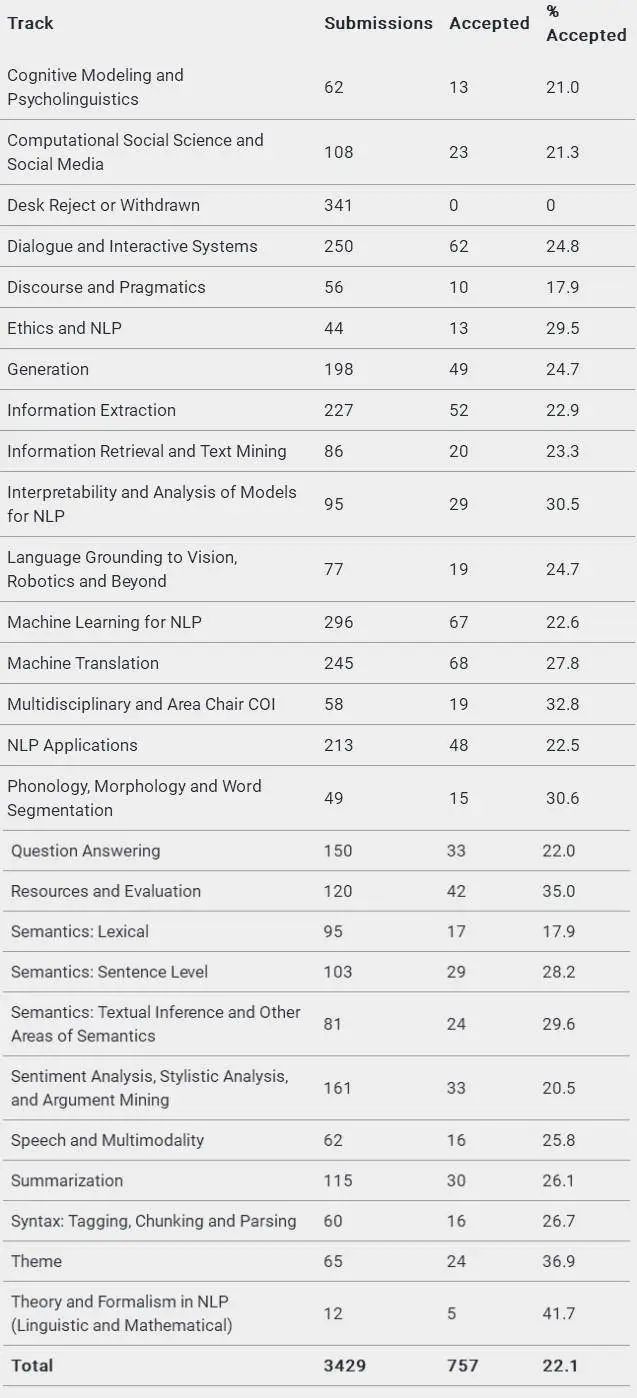

如果将收录的文章进行领域细分,那么机器学习、对话交互技术、机器翻译、信息提取以及NLP的应用这五个方向是最热门的研究领域。这五个方向中机器学习有接近300份论文提交,其他四个方向,每一个都有超200份的论文提交。

那么,这些领域的录取率怎么样呢?根据博客中的统计,论文录取率最低的是17.9%,来自词汇语义(Lexical Semantics),其有95篇投稿,17篇被收录;论文录取率最高的是41.7%,来自Theory and Formalism in NLP (Linguistic and Mathematical),其有12篇投稿,5篇被收录。

投稿数量排名前五的领域的录取率为:机器学习—22.6%;对话交互技术—24.8%;机器翻译—27.8%;信息提取—22.9%;NLP的应用—22.5%。

可以清楚的看到,机器学习和应用方向的论文录取率并未达到平均线。

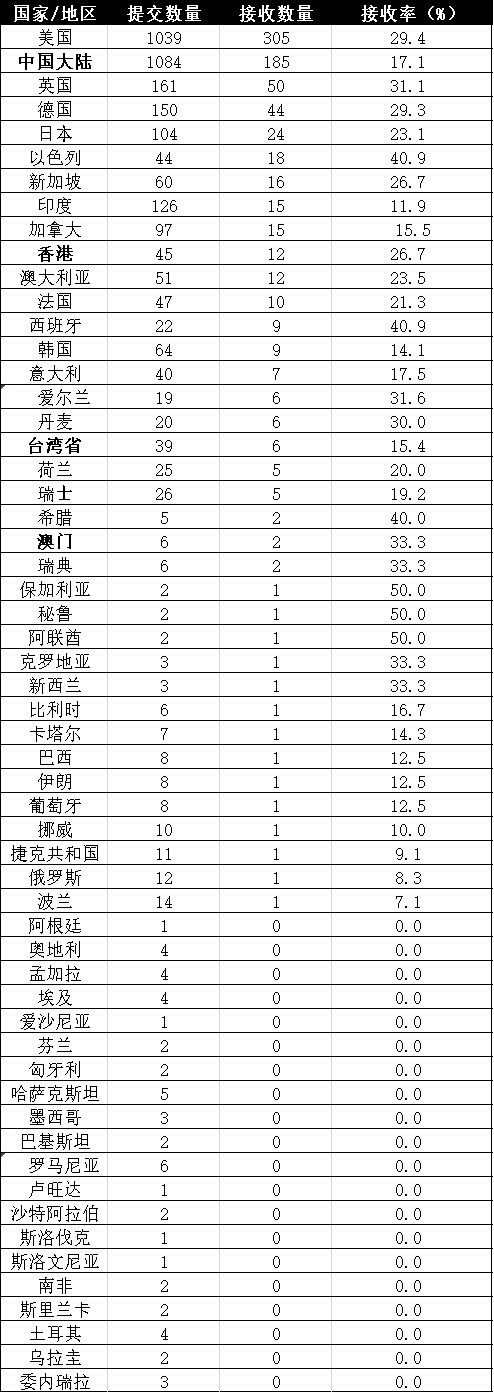

国家/地区层面的情况如何呢?在博客中,组委会介绍到:一共有57个国家/地区的研究员提交了论文,其中中国大陆最多为1084(185,17.1%)篇,美国排名第二为1039(305,29.4%)篇,英国排名第三为161(50,31.1%)而这一数据在2019是:美国提交了820份申请,德国以136份位居第三。

![]()

图注:中国合计投稿数量为1174,接收数量为205,录取率为17.5%,未进前五。

如上图所示,如果只考虑提交数量最多的15个国家/地区,录取率前五的国家/地区则是:以色列(40.9%) 、英国(31.1%) 、德国(29.3%) 、新加坡(26.7%)、香港(26.7%)。

显然单从录取率来看,中国大陆尚未挺进前五。

哈工大SCIR 车万翔教授曾经写过一篇《ACL 2010-2020研究趋势总结》,详细分析了ACL十年研究领域的变迁。如上述视频,这十年来,人机对话等新兴领域上升势头迅猛,而句法分析、机器翻译等传统领域有所衰落。

2015年之前,ACL上几乎没有人机对话的文章发表,但是从2016年开始,随着语音识别技术的突破,NLPer开始重视人机对话的研究,今年ACL该方向上的研究重点和研究趋势如下图所示。

可以看到近10年来,机器学习的热度一直居高不下,特别是随着预训练模型的成功,NLP模型大有被大一统的趋势。下面的一些机器学习研究方向为今年ACL所重点关注。

严格来讲自然语言处理应被分为自然语言处理和自然语言生成两个方向,然而受到技术的限制,传统的文本生成多采用基于模板的方法,因此在研究上并没有引起太多的关注。随着序列到序列模型的产生,人们意识到可以采用类似的方法进行逐词的文本生成,从而产生了大量的研究和应用问题,因此文本生成也成为了目前自然语言处理的热门研究领域。今年ACL上的研究热点如下图所示。

![]() 4、问答系统绝地反击

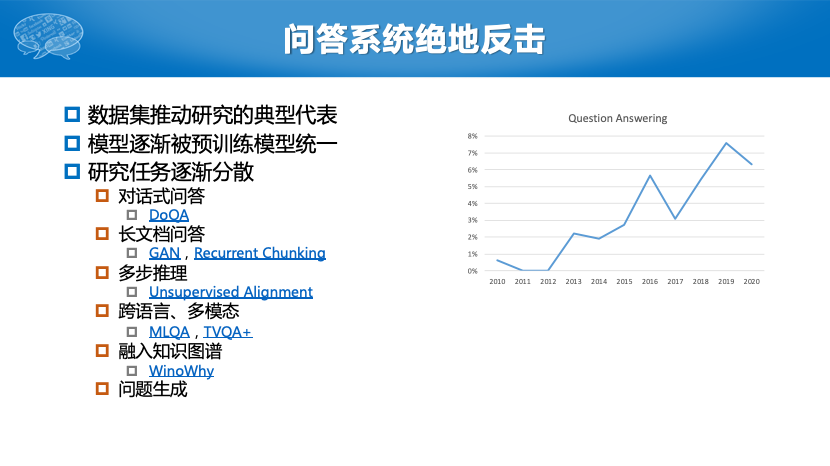

随着斯坦福大学SQuAD数据集的诞生,以抽取式阅读理解为代表的问答系统近年来引起了大量的关注。但是为什么说是“绝地反击”呢?主要是因为在更久之前,问答系统就曾经是信息检索和自然语言处理领域的热门研究方向,但是受限于当时的技术手段,答案准确率并不是很高,因此该研究方向曾一度被人们所冷落。经过这几年的发展,问答系统的模型逐渐被预训练模型所统一,因此今年ACL上的相关文章更关注问答系统的各个子任务或引入更多资源。

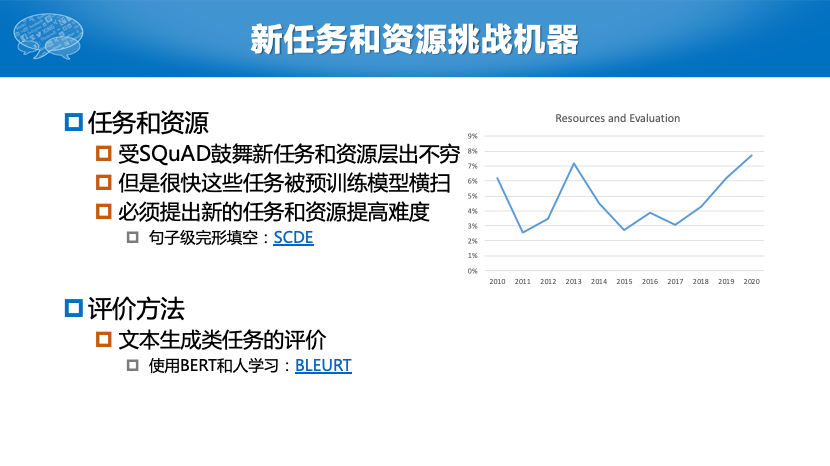

仍然是受预训练模型的影响,在很多刚被提出不久的自然语言处理任务上,机器的表现很快超过人类。因此最近有大量的研究工作试图提出对机器更具有挑战性的任务和资源,从而逼迫机器更像人一样“思考”。

几家欢乐几家愁,由于上述领域的快速崛起,更重要的是由于模型逐渐为Transformer所统一,使得机器翻译这一“老牌”自然语言处理任务受关注的程度有所降低。今年ACL的相关研究也分散到不同的翻译场景设置上。

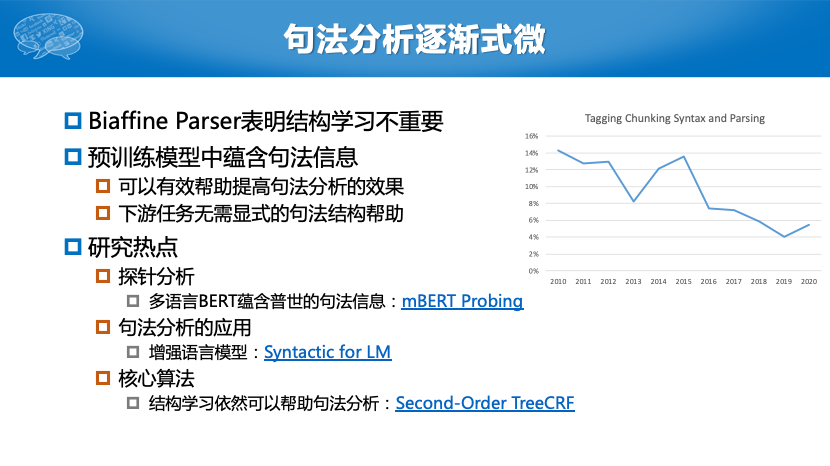

和机器翻译类似,句法分析这一曾经自然语言处理领域的当家任务也逐渐式微。其背后的原因有两个:一方面是因为Biaffine Parser的出现证明了结构学习这一自然语言处理的特色问题,对于句法分析并不重要;另一方面,预训练模型的出现使得句法分析的处境更是雪上加霜。预训练模型不但能大幅提高句法分析的效果,更重要的是其内部已经蕴含了句法结构信息,因此就无需为下游任务提供显式的句法结构了。由于这些原因,今年ACL上句法分析的热点也主要集中在了研究探针任务和句法分析的应用上了。不过苏州大学李正华老师所提出的高阶TreeCRF模型还是能进一步提升句法分析的效果,这一点非常难得。

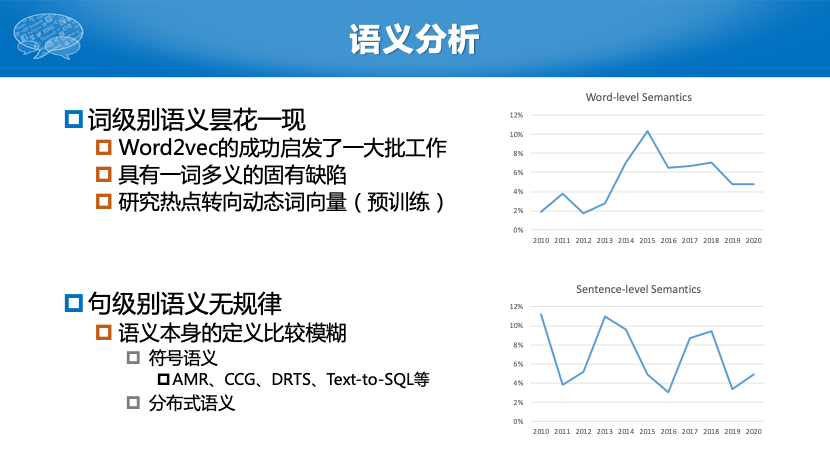

语义分析领域的情况稍显复杂,对于词级别的语义分析,当年受到Word2vec模型的启发,产生了一大批相关的研究,其影响力甚至超出了自然语言处理的范围,在知识图谱、推荐系统等领域都广受关注。而近年的预训练模型让大家将研究重点从之前这种静态词向量转移到了动态词向量等方向。至于句级别语义分析,本身的定义就比较模糊,很多任务都可以归为语义分析,如AMR、CCG Parsing等,当然它们也可以被归为结构分析(Parsing)类任务,所以趋势上有所波动。

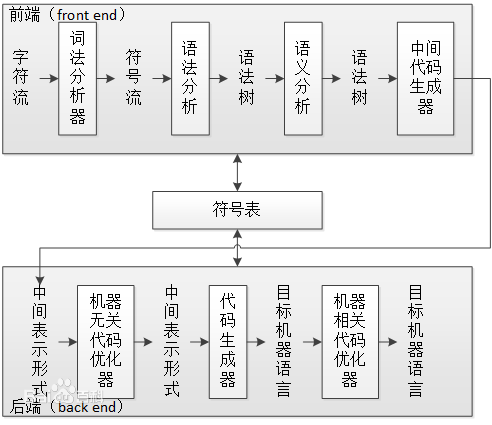

上面这些分析主要是从研究领域的趋势变化展开的,我们还可以从其它维度进行分析,来帮助我们更全面了解自然语言处理的研究。如下图所示,我们总结了今年ACL上几个热门的研究方向,如对多语言、多模态、多领域和低资源的研究,融入知识的方法,图神经网络的应用等。

4、问答系统绝地反击

随着斯坦福大学SQuAD数据集的诞生,以抽取式阅读理解为代表的问答系统近年来引起了大量的关注。但是为什么说是“绝地反击”呢?主要是因为在更久之前,问答系统就曾经是信息检索和自然语言处理领域的热门研究方向,但是受限于当时的技术手段,答案准确率并不是很高,因此该研究方向曾一度被人们所冷落。经过这几年的发展,问答系统的模型逐渐被预训练模型所统一,因此今年ACL上的相关文章更关注问答系统的各个子任务或引入更多资源。

仍然是受预训练模型的影响,在很多刚被提出不久的自然语言处理任务上,机器的表现很快超过人类。因此最近有大量的研究工作试图提出对机器更具有挑战性的任务和资源,从而逼迫机器更像人一样“思考”。

几家欢乐几家愁,由于上述领域的快速崛起,更重要的是由于模型逐渐为Transformer所统一,使得机器翻译这一“老牌”自然语言处理任务受关注的程度有所降低。今年ACL的相关研究也分散到不同的翻译场景设置上。

和机器翻译类似,句法分析这一曾经自然语言处理领域的当家任务也逐渐式微。其背后的原因有两个:一方面是因为Biaffine Parser的出现证明了结构学习这一自然语言处理的特色问题,对于句法分析并不重要;另一方面,预训练模型的出现使得句法分析的处境更是雪上加霜。预训练模型不但能大幅提高句法分析的效果,更重要的是其内部已经蕴含了句法结构信息,因此就无需为下游任务提供显式的句法结构了。由于这些原因,今年ACL上句法分析的热点也主要集中在了研究探针任务和句法分析的应用上了。不过苏州大学李正华老师所提出的高阶TreeCRF模型还是能进一步提升句法分析的效果,这一点非常难得。

语义分析领域的情况稍显复杂,对于词级别的语义分析,当年受到Word2vec模型的启发,产生了一大批相关的研究,其影响力甚至超出了自然语言处理的范围,在知识图谱、推荐系统等领域都广受关注。而近年的预训练模型让大家将研究重点从之前这种静态词向量转移到了动态词向量等方向。至于句级别语义分析,本身的定义就比较模糊,很多任务都可以归为语义分析,如AMR、CCG Parsing等,当然它们也可以被归为结构分析(Parsing)类任务,所以趋势上有所波动。

上面这些分析主要是从研究领域的趋势变化展开的,我们还可以从其它维度进行分析,来帮助我们更全面了解自然语言处理的研究。如下图所示,我们总结了今年ACL上几个热门的研究方向,如对多语言、多模态、多领域和低资源的研究,融入知识的方法,图神经网络的应用等。

AI 科技评论希望能够招聘 科技编辑/记者 一名

办公地点:北京/深圳

职务:以参与学术顶会报道、人物专访为主

工作内容:

1、参加各种人工智能学术会议,并做会议内容报道;

2、采访人工智能领域学者或研发人员;

3、关注学术领域热点事件,并及时跟踪报道。

要求:

1、热爱人工智能学术研究内容,擅长与学者或企业工程人员打交道;

2、有一定的理工科背景,对人工智能技术有所了解者更佳;

3、英语能力强(工作内容涉及大量英文资料);

4、学习能力强,对人工智能前沿技术有一定的了解,并能够逐渐形成自己的观点。

感兴趣者,可将简历发送到邮箱:cenfeng@leiphone.com

点击"阅读原文",直达“ACL 交流小组”了解更多会议信息。

4、问答系统绝地反击

4、问答系统绝地反击