SOTA实例分割算法BlendMask,超越mask-rcnn

加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

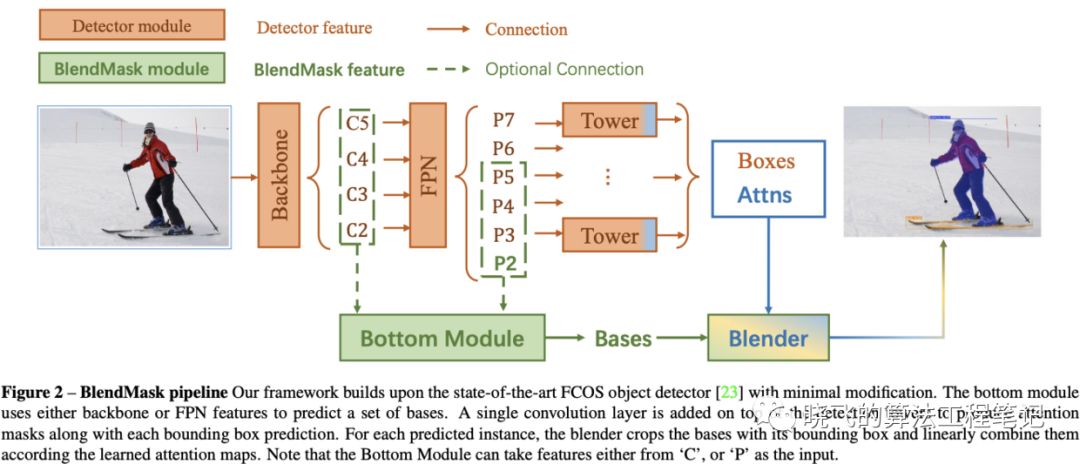

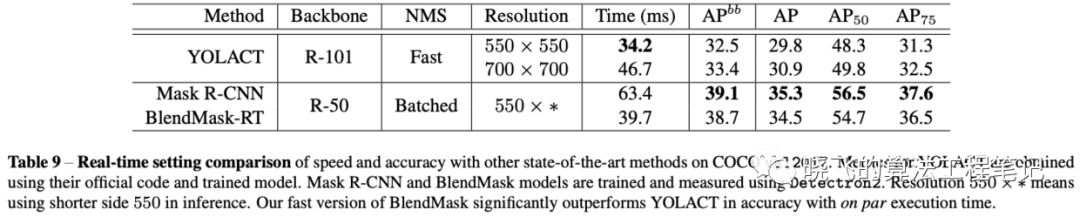

【导读】BlendMask通过更合理的blender模块融合top-level和low-level的语义信息来提取更准确的实例分割特征,该模型效果达到state-of-the-art,但结构十分精简,推理速度也不慢,精度最高能到41.3AP,实时版本BlendMask-RT性能和速度分别为34.2mAP和25FPS,并且论文的优化方法很有学习的价值,值得一读。

论文:

BlendMask: Top-Down Meets Bottom-Up for Instance Segmentation

Introduction

top-down apporach

特征和mask之间的局部一致性会丢失,论文讨论的是Deep-Mask,用fc来提出mask

冗余的特征提取,不同的bbox会重新提取一次mask

由于使用了缩小特征图的卷积,位置信息会损失

bottom-up apporach

bottom-up模型先对整图进行逐像素预测(per-pixel prediction),每个像素生成一个特征向量,然后通过一些方法来对像素进行分组。由于进行的是逐像素级预测且步长很小,局部一致性和位置信息可以很好的保存,但是依然存在以下几个问题:

严重依赖逐像素预测的质量,容易导致非最优的分割

由于mask在低维提取,对于复杂场景(类别多)的分割能力有限

需要复杂的后处理方法

hybridizing apporach

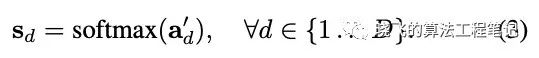

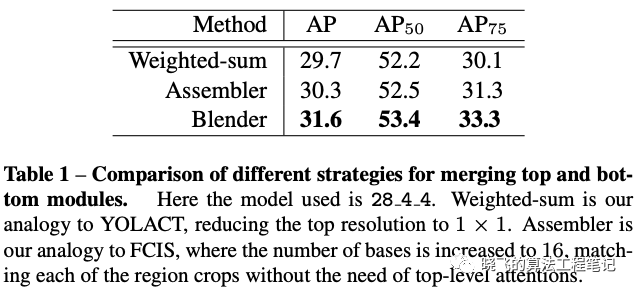

提出了proposal-based的instance mask合并方法,blender,在COCO上对比YOLACT和FCIS的合并方法分别提升了1.9和1.3mAP

基于FCOS提出简洁的算法网络BlendMask

BlendMask的推理时间不会像二阶检测器一样随着预测数量的增加而增加

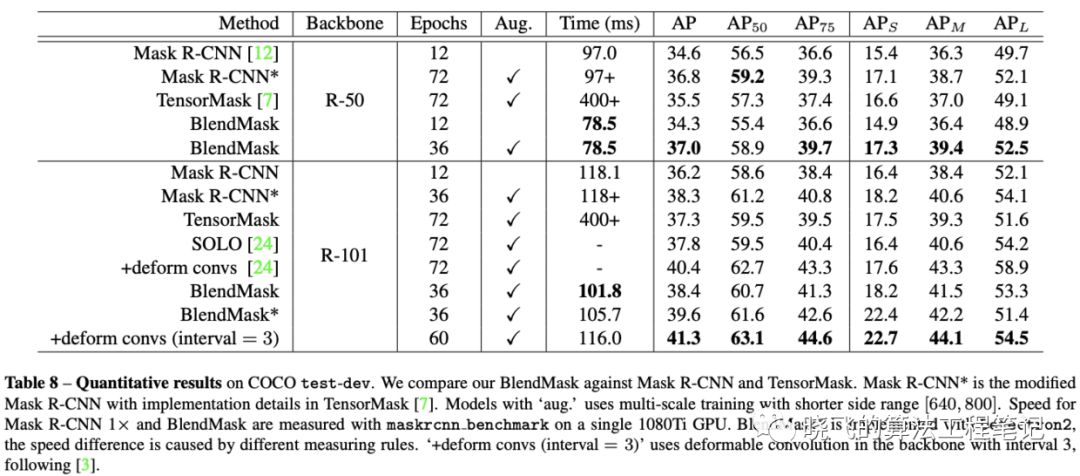

BlendMask的准确率和速度比Mask R-CNN要好,且mask mAP比最好的全卷积实例分割网络Tensor-Mask要高1.1

由于bottom模块能同时分割多种物体,BlendMask可直接用于全景分割

Mask R-CNN的mask输出固定为28X28,BlendMask的mask输出像素可以很大,且不受FPN的限制

BlendMask通用且灵活,只要一些小修改,就可以用于其它instance-level识别任务中,例如关键点检测

Our methods

Overall pipeline

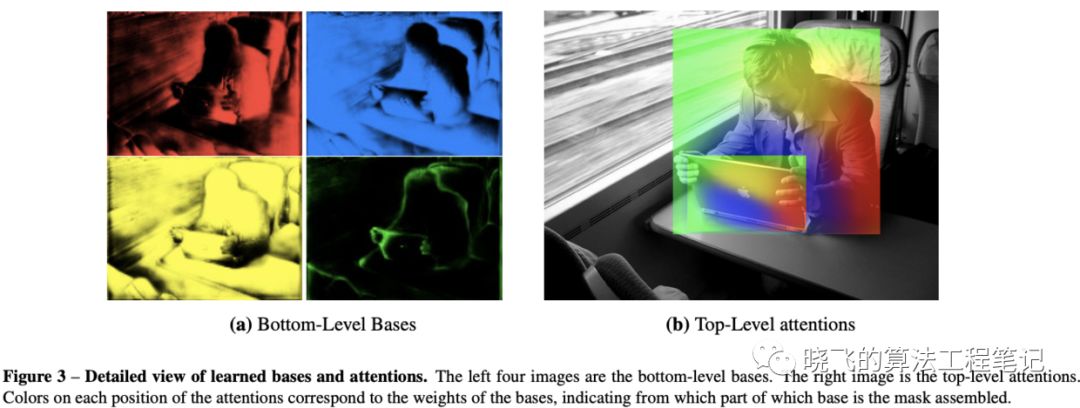

Bottom module

Top Layer

Blender module

Configurations and baselines

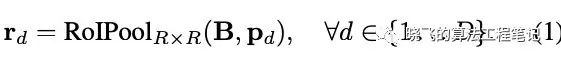

BlendMask的超参数如下:

-

, bottom-level RoI的分辨率 -

,top-level预测的分辨率 -

,基底的数量(c hannel) -

bottom模块的输入可以是骨干网络或FPN的feature -

基底的采样方法可以是最近邻或双线性池化 -

top-level attentions的插值方法可以是最近邻或双线性采样

-

像素是否在对象上(semantic masks) -

像素是否在对象的具体部位上(position-sensitive features),比如左上角,右下角

Experiment

消融实验

Merging methods: Blender vs. YOLACT vs. FCIS

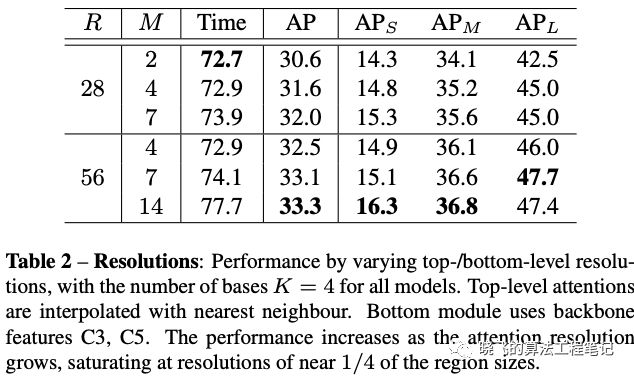

Top and bottom resolutions

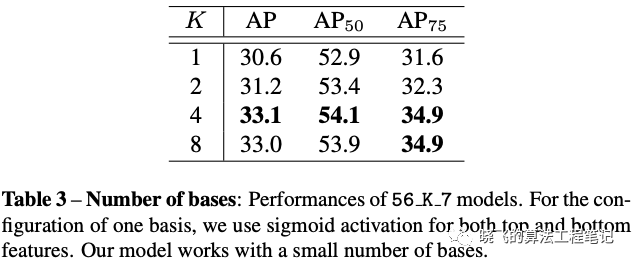

Number of bases

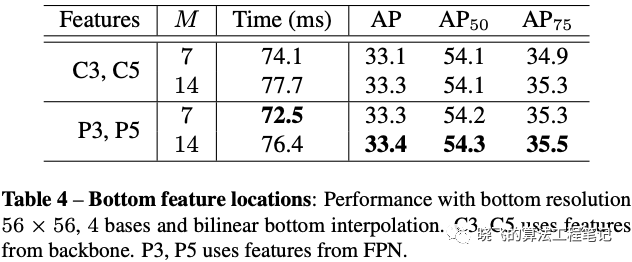

Bottom feature locations: backbone vs. FPN

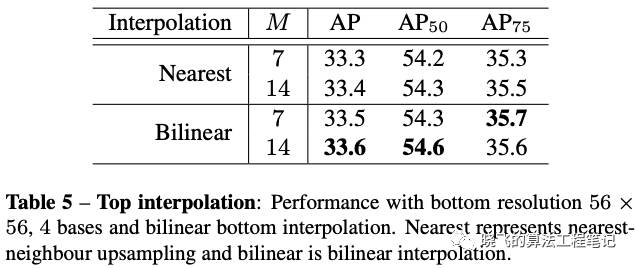

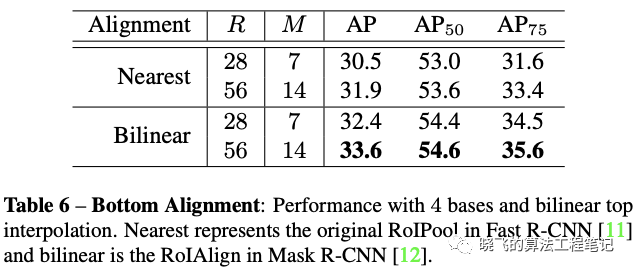

Interpolation method: nearest vs. bilinear

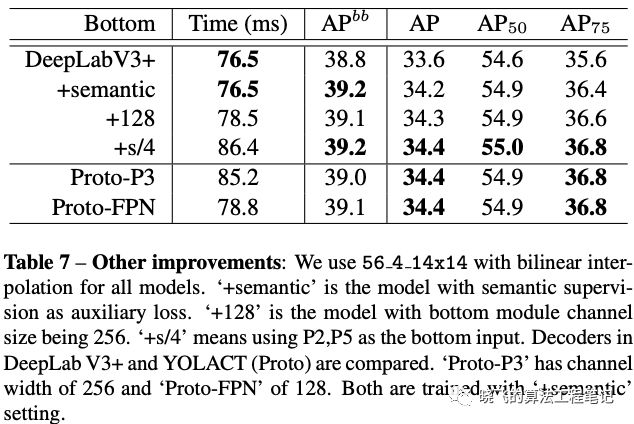

Other improvements

Main result

Quantitative results

Real-time setting

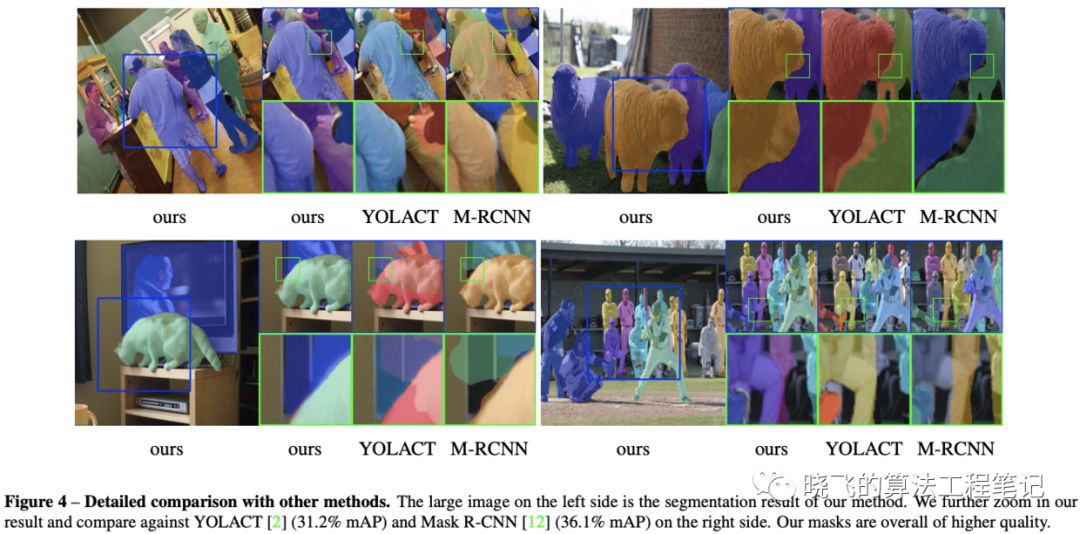

Qualitative results

Discussions

Comparison with Mask R-CNN

BlendMask的结构与Mask R-CNN类似,通过去掉position-sensitive feature map以及重复的mask特征提取来进行加速,并通过attentions指导的blender来替换原来复杂的全局特征计算。

BlendMask的另一个优点是产生了高质量的mask,而分辨率输出是不受top-level采样限制。对于Mask R-CNN增大分辨率,会增加head的计算时间,而且需要增加head的深度来提取准确的mask特征 。另外Mask R-CNN的推理时间会随着bbox的数量增加而增加,这对实时计算是不友好的 最后,blender模块是十分灵活的,因为top-level的实例attention预测只有一个卷积层,对于加到其它检测算法中几乎是无花费的。

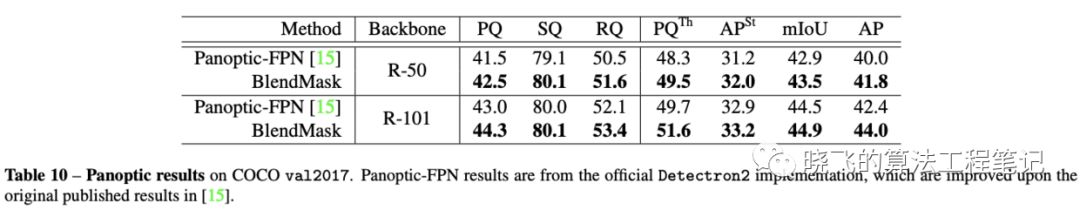

Panoptic Segmentation

总结

参考内容:

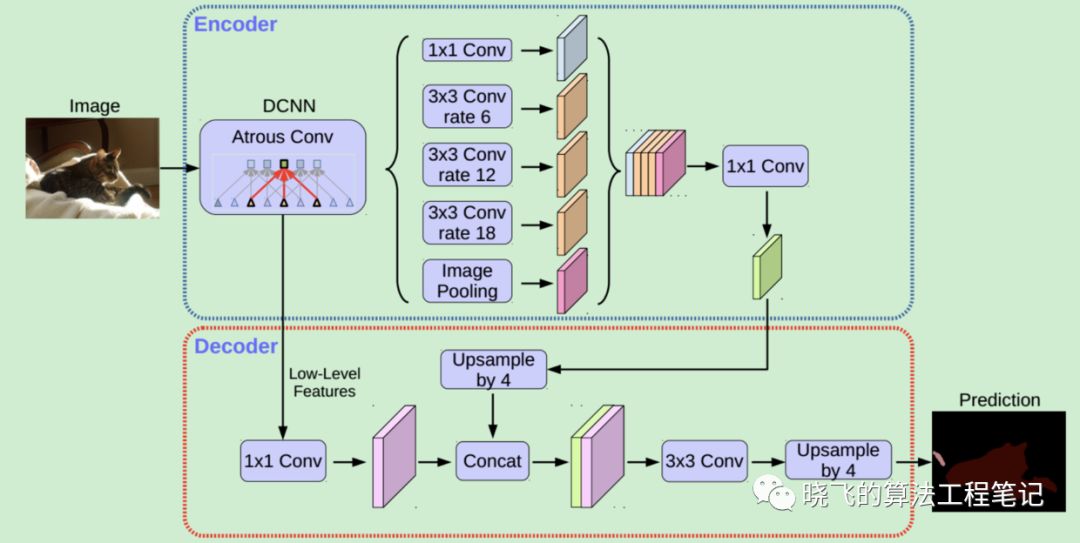

[1]论文阅读学习 - (DeeplabV3+)Encoder-Decoder with Atrous Separable Convolution

[2]加州大学提出:实时实例分割算法YOLACT,可达33 FPS/30mAP!现已开源!

[3]FCOS-一个挺不错的anchor free目标检测方法

-End-

CV细分方向交流群

添加极市小助手微信(ID : cv-mart),备注:研究方向-姓名-学校/公司-城市(如:目标检测-小极-北大-深圳),即可申请加入目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、图像分割等极市技术交流群(已经添加小助手的好友直接私信),更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

△长按添加极市小助手

△长按关注极市平台

觉得有用麻烦给个在看啦~