「炼丹必备」15个常用基准数据集含大规模中文多模态理解、医疗信息处理等场景

炼丹为数据发愁?这份复习材料包含的基准数据集涵盖了计算机视觉、自然语言处理等领域,包括了大规模中文多模态理解、中文医疗信息处理等场景。

1、首个大规模中文多模态评测基准 MUGE

MUGE(Multimodal Understanding and Generation Evaluation)是业界首个大规模中文多模态评测基准,由达摩院联合浙江大学、阿里云天池平台联合发布,中国计算机学会计算机视觉专委会(CCF-CV专委)协助推出。MUGE榜单为研究者们提供了统一的数据和评测基准,旨在促进多模态理解与生成领域的技术发展。

到目前为止,MUGE 包括:多模态理解和生成任务的基准,包括电子商务图像字幕、文本到图像生成和多模态图文检索任务,供研究人员跟踪其模型性能的公共排行榜。

官网地址:https://tianchi.aliyun.com/muge

Github:https://github.com/MUGE-2021

2、中文医疗信息处理评测基准 CBLUE

中文医疗信息处理评测基准 CBLUE(Chinese Biomedical Language Understanding Evaluation)是中国中文信息学会医疗健康与生物信息处理专业委员会在合法开放共享的理念下发起,由阿里云天池平台承办,并由医渡云(北京)技术有限公司、平安医疗科技、阿里夸克、腾讯天衍实验室、北京大学、鹏城实验室、哈尔滨工业大学(深圳)、郑州大学、同济大学、中山大学、复旦大学等开展智慧医疗研究的单位共同协办,旨在推动中文医学 NLP 技术和社区的发展。

榜单在设计上综合考虑了任务类型和任务难度两个维度,目标是建设一个任务类型覆盖广、同时也要保证任务的难度的 benchmark,因此榜单在吸收往届 CHIP/CCKS/CCL 等学术评测任务的同时也适当增加了业界数据集,业务数据集的特点是数据真实且有噪音,对模型的鲁棒性提出了更高的要求。CBLUE 评测基准 2.0 包括医学文本信息抽取(实体识别、关系抽取、事件抽取)、医学术语归一化、医学文本分类、医学句子关系判定和医疗对话理解与生成共 5 大类任务 14 个子任务。

官网地址:https://tianchi.aliyun.com/cblue

论文地址:https://arxiv.org/pdf/2106.08087.pdf

Github:https://github.com/CBLUEbenchmark/CBLUE

3、黑盒优化 Benchmark——RABBO

RABBO(Real-Aplication Black-Box Optimization benchmark)榜单由达摩院决策智能实验室倾力维护,依托于阿里云天池平台的支持,提供具有实际应用背景的黑盒优化测试问题及评测方案,旨在帮助算法研发者打磨求解真实场景问题的黑盒优化算法,为算法使用者提供各类算法特点与适用场景分析以及使用参考。

RABBO 提供了针对黑盒优化问题的数学建模和优化求解的思路,提供了黑盒优化接口规范代码、实际应用背景的测试问题、和效果评测的方案。2021 年 10 月发布的是 RABBO V1.0 版本,数据集的题目包含包含:经典题目集、金属冶炼配比优化、火星路径规划、风场微观选址。

天池地址:https://tianchi.aliyun.com/dataset/dataDetail?dataId=111953

4、人类动作识别的大规模数据集 NTU RGB+D

NTU RGB+D 是一个用于 RGB-D 人类动作识别的大规模数据集。它涉及从 40 名受试者身上收集的 60 个动作类别的 56,880 个样本。这些动作一般可分为三类。40 个日常动作(如喝水、吃饭、阅读),9 个与健康有关的动作(如打喷嚏、踉跄、跌倒),以及 11 个相互间的动作(如打拳、踢腿、拥抱)。这些动作发生在 17 个不同的场景条件下,对应 17 个视频序列(即 S001-S017)。

这些动作是用三台摄像机拍摄的,它们具有不同的水平成像视角,即 -45∘、0∘ 和 +45∘。为动作特征提供了多模式信息,包括深度图、三维骨架关节位置、RGB 帧和红外序列。性能评估是通过将 40 名受试者分成训练组和测试组的交叉测试,以及采用一台摄像机(+45∘)进行测试,另外两台摄像机进行训练的跨视角测试来进行的。

论文地址:https://arxiv.org/pdf/1604.02808v1.pdf

Github:https://github.com/shahroudy/NTURGB-D

5、大规模的分层图像数据库 ImageNet

ImageNet 数据集根据 WordNet 层次结构包含 14,197,122 个带注释的图像。自 2010 年以来,该数据集被用于 ImageNet 大规模视觉识别挑战赛 (ImageNet Large Scale Visual Recognition Challenge, ILSVRC),这是图像分类和对象检测的基准。公开发布的数据集包含一组手动注释的训练图像。还发布了一组测试图像,保留了手动注释。

ILSVRC 注释属于以下两类之一:

(1)图像级二进制标签的注释,用于表示图像中是否存在对象类,例如,“这张图像中有汽车”但“没有老虎, ”

(2)图像中对象实例周围的紧密边界框和类标签的对象级注释,例如,“有一把螺丝刀以 (20,25) 位置为中心,宽度为 50 像素,高度为 30 像素”。

官方地址:https://image-net.org/index.php

论文地址:https://ieeexplore-ieee-org.ezproxy.library.sydney.edu.au/document/5206848

天池地址:https://tianchi.aliyun.com/dataset/dataDetail?dataId=92252

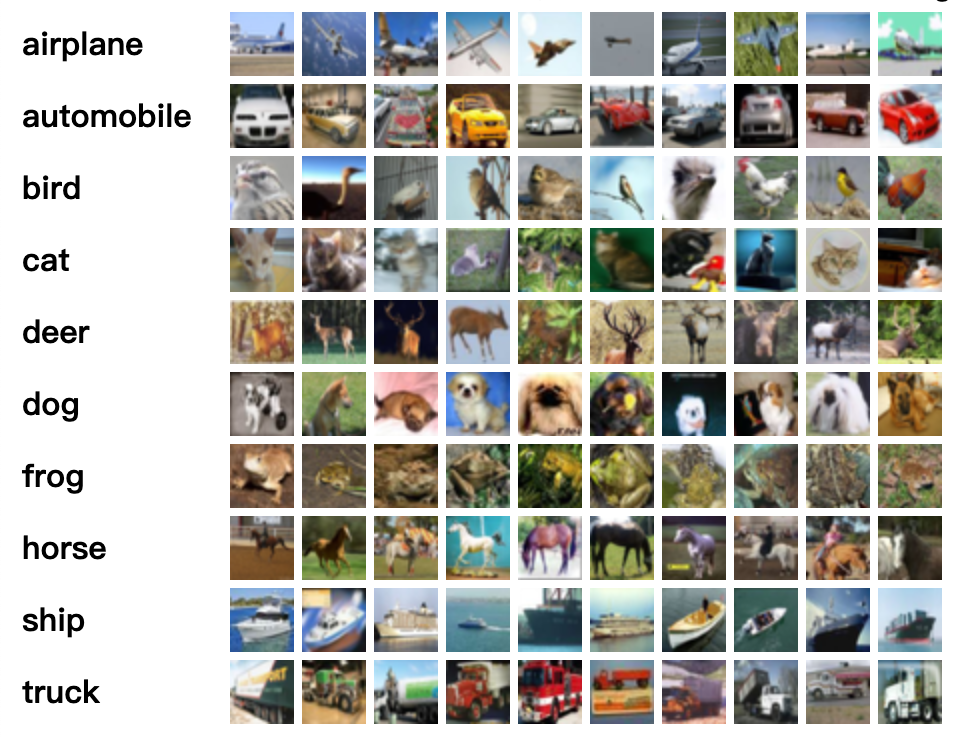

6、六千万微小图片数据集 CIFAR-10

CIFAR -10(Canadian Institute for Advanced Research, 10 classes)是 Tiny Images 数据集的子集,由 60000 张 32x32 彩色图像组成,它们由 Alex Krizhevsky、Vinod Nair 和 Geoffrey Hinton 收集。这些图像标有 10 个相互排斥的类别之一:飞机、汽车(但不是卡车或皮卡车)、鸟、猫、鹿、狗、青蛙、马、船和卡车(但不是皮卡车)。每类有 6000 张图像,每类有 5000 张训练图像和 1000 张测试图像。

官方地址:https://www.cs.toronto.edu/~kriz/cifar.html

论文地址:https://www.cs.toronto.edu/~kriz/learning-features-2009-TR.pdf

天池地址:https://tianchi.aliyun.com/dataset/dataDetail?dataId=92264

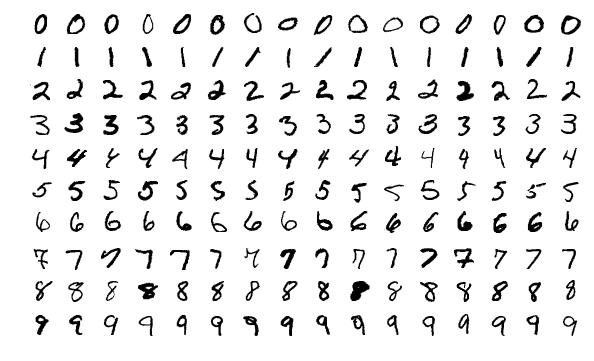

7、大型的手写数字集合 MNIST

MNIST 数据库(Modified National Institute of Standards and Technology database)是一个大型的手写数字集合。它有一个包含 60,000 个例子的训练集和一个包含 10,000 个例子的测试集。

它是更大的 NIST 特别数据库 3(由美国人口普查局雇员书写的数字)和特别数据库 1(由高中学生书写的数字)的一个子集,其中包含手写数字的单色图像。这些数字的大小已被规范化,并在一个固定尺寸的图像中居中。来自 NIST 的原始黑白(二层)图像被归一化,以适合 20x20 像素的盒子,同时保留其长宽比。

官方地址:http://yann.lecun.com/exdb/mnist

论文地址:https://arxiv.org/pdf/1102.0183.pdf

天池地址:https://tianchi.aliyun.com/dataset/dataDetail?dataId=92224

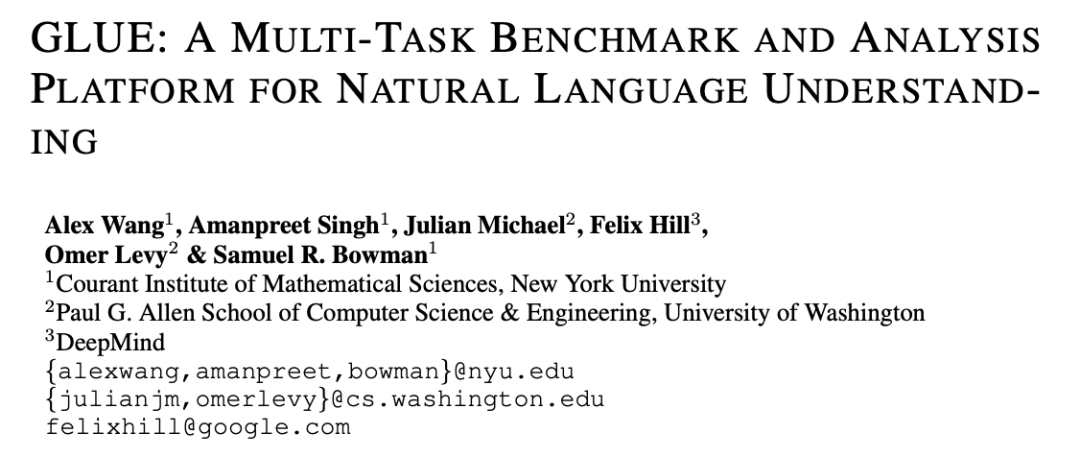

8、通用语言理解评估基准 GLUE

为了使自然语言理解(NLU)技术在实践中和作为科学研究对象发挥最大的作用,它必须是通用的:它必须能够以一种不专门针对任何一个特定任务或数据集的方式来处理语言。

为此,来自纽约大学、华盛顿大学、DeepMind 等机构的研究者提出通用语言理解评估基准(General Language Understanding Evaluation benchmark, GLUE),它是 9 个自然语言理解任务的集合,包括单句任务 CoLA 和 SST-2 ,相似性和转述任务 MRPC 、STS-B 和 QQP ,以及自然语言推理任务 MNLI、QLNLI、RTE 和 WNLI 。

官方地址:https://gluebenchmark.com

论文地址:https://arxiv.org/pdf/1804.07461v3.pdf

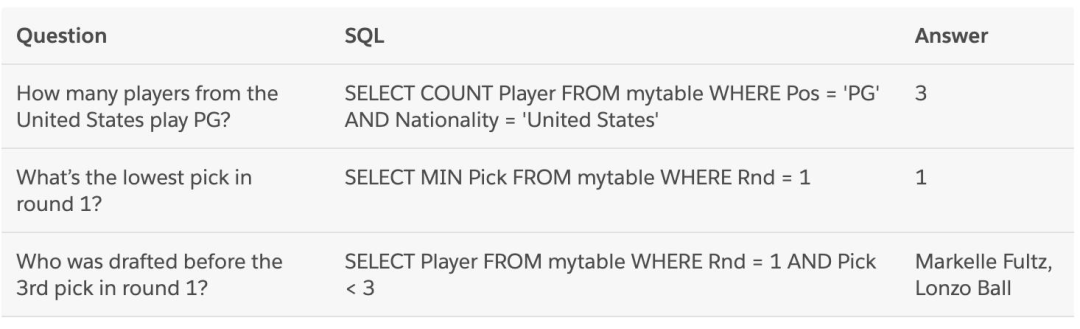

9、用于为关系数据库开发自然语言界面的大型众包数据集 WikiSQL

WikiSQL 包括一个由 87,726 个手工注释的 SQL 查询和自然语言问题对组成的语料库,由 Salesforce Research 发布。这些 SQL 查询被进一步分成训练(61297个例子)、开发(9145个例子)和测试集(17284个例子)。它可用于与关系型数据库有关的自然语言推理任务。

论文地址:https://arxiv.org/pdf/1709.00103v7.pdf

Github:https://github.com/salesforce/WikiSQL

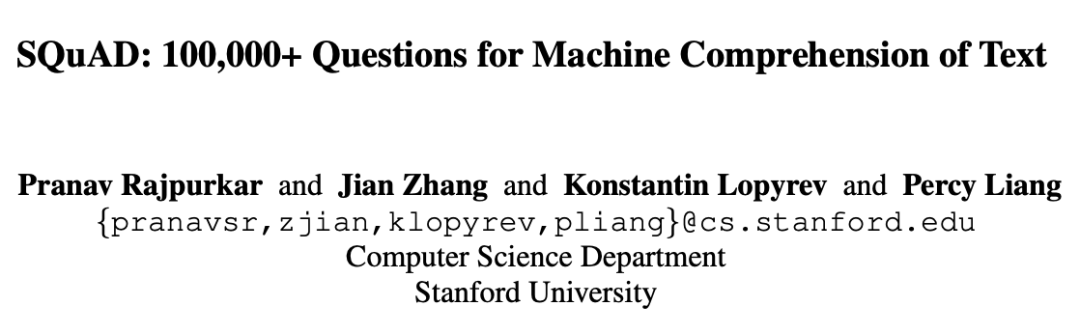

10、来自维基百科文章的问题-答案对的集合 SQuAD

Stanford Question Answering Dataset (SQuAD)是一个来自维基百科文章的问题-答案对的集合,由斯坦福大学发布。在 SQuAD 中,问题的正确答案可以是给定文本中的任何标记序列。由于问题和答案是由人类通过众包产生的,因此它比其他一些问题-答案数据集更加多样化。

SQuAD 1.1 包含了 536 篇文章的 107,785 个问题-答案对。SQuAD 2.0(开放域 SQuAD,SQuAD-Open)是最新的版本,它将 SQuAD 1.1 中的 100,000 个问题与超过 50,000 个由众包者以类似于可回答问题的形式逆向编写的不可回答的问题相结合。

官方地址:https://stanford-qa.com

论文地址:https://arxiv.org/pdf/1606.05250v3.pdf

天池地址:https://tianchi.aliyun.com/dataset/dataDetail?dataId=83061

11、大规模的人脸属性数据集 CelebA

CelebFaces Attributes Dataset (CelebA) 是一个大规模的人脸属性数据集,由香港中文大学开放提供。它包含超过 20 万张名人图像,每张图像有 40 个属性标记。该数据集中的图像涵盖了较大的姿势变化和背景杂乱。CelebA 种类多、数量多、注释丰富,包括 10,177 个身份,202,599 张人脸图像,以及 5 个人脸特征点坐标,每张图像 40 个属性标记。

该数据集可用作以下计算机视觉任务的训练和测试集:人脸属性识别、人脸识别、人脸检测、地标(或人脸部分)定位以及人脸编辑与合成。

官方地址:http://mmlab.ie.cuhk.edu.hk/projects/CelebA.html

12、行为识别数据集 UCF101

UCF101 数据集是 UCF50 的扩展,由 13,320 个视频片段组成,分为 101 个类别。这 101 个类别可分为 5 种类型(身体运动、人与人互动、人与物体互动、演奏乐器和运动)。这些视频剪辑的总长度超过 27 小时。所有视频均从 YouTube 收集,具有 25 FPS 的固定帧速率,分辨率为 320 × 240。

论文地址:https://arxiv.org/pdf/1212.0402v1.pdf

天池地址:https://tianchi.aliyun.com/dataset/dataDetail?dataId=92158

13、城市街景语义理解的大型数据库 Cityscapes

Cityscapes 是一个专注于城市街景语义理解的大型数据库,由戴姆勒研究所,马克斯•普朗克信息学研究所和达姆施塔特科技大学可视化推理工作组提供。该数据集由大约 5000 个精细标注的图像和 20000 个粗糙标注的图像组成。它为分为 8 个类别(平面、人类、车辆、建筑、物体、自然、天空和虚空)的 30 个类别提供语义、实例和密集像素注释。该数据集具备多样性,历经数月(春、夏、秋)在白天和良好的天气条件下获得,并由手动选择帧,且具有以下特征:大量动态对象、变化的场景布局和变化的背景。

Cityscapes 数据集适用于

评估视觉算法在语义城市场景理解的主要任务中的性能:像素级、实例级和全景语义标记;

支持旨在利用大量(弱)注释数据的研究,例如用于训练深度神经网络。

官方地址:https://www.cityscapes-dataset.com

论文地址:https://arxiv.org/pdf/1604.01685v2.pdf

天池地址:https://tianchi.aliyun.com/dataset/dataDetail?dataId=92279

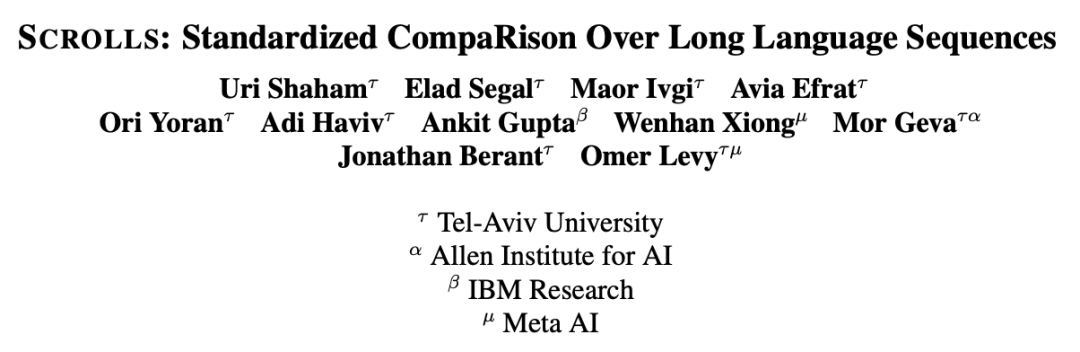

14、IBM 研究院、Meta AI 等多家机构发布新基准 SCROLLS

目前,NLP 的基准主要集中在短文本上,如句子和段落。来自 IBM 研究院、Meta AI 等多家机构发布新基准 SCROLLS (Standardized CompaRison Over Long Language Sequences)。

该条进展工作通过研究了现有的长文本数据集,并精心挑选了那些文本较长的数据集,同时优先考虑那些涉及综合输入信息的任务。SCROLLS 包含总结、问题回答和自然语言推理任务,涵盖多个领域,包括文学、科学、商业和娱乐。SCROLLS 以统一的文本到文本格式提供所有的数据集,并主持一个实时排行榜,以促进对模型架构和预训练方法的研究。

官方地址:https://www.scrolls-benchmark.com

论文地址:https://arxiv.org/abs/2201.03533v1

15、CLUE 团队发布应用在 NLP 领域的数据为中心的基准 DataCLUE

以数据为中心(Data-centric)的AI,是一种新型的AI探索方向。它的核心问题是如何通过系统化的改造你的数据(无论是输入或者标签)来提高最终效果。

DataCLUE 是一个以数据为中心的 AI 测评。它基于 CLUE benchmark,结合 Data-centric 的 AI 的典型特征,进一步将 Data-centric 的 AI 应用于 NLP 领域,融入文本领域的特定并创造性丰富和发展了 Data-centric 的 AI。在原始数据集外,它通过提供额外的高价值的数据和数据和模型分析报告(增值服务)的形式, 使得融入人类的 AI 迭代过程(Human-in-the-loop AI pipeline) 变得更加高效,并能较大幅度提升最终效果。

论文地址:https://arxiv.org/abs/2111.08647v2

Github:https://github.com/CLUEbenchmark/DataCLUE

-

「本季必追国际影响力AI工作」:共 18 题

-

「AI开发常用的Benchmark数据集」:共 15 题

-

「今年刷爆顶会Leaderboard的算法」:共 7 题

-

「AI Foundation专业知识与开发实践基础」:共 20 题

活动期间,关注「机器之心 SOTA模型」服务号,即可通过底部菜单栏进入活动。

「春卷er」10道「AI Foundation专业知识与开发实践基础」新题已解锁!

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com