发布可伸缩超网SCARLET,小米AutoML团队NAS三部曲杀青

作者丨江渚碧

学校丨武汉大学

研究方向丨智能计算

模型地址:

https://github.com/xiaomi-automl/SCARLET-NAS

One-shot路线之优劣

引入恒等变换

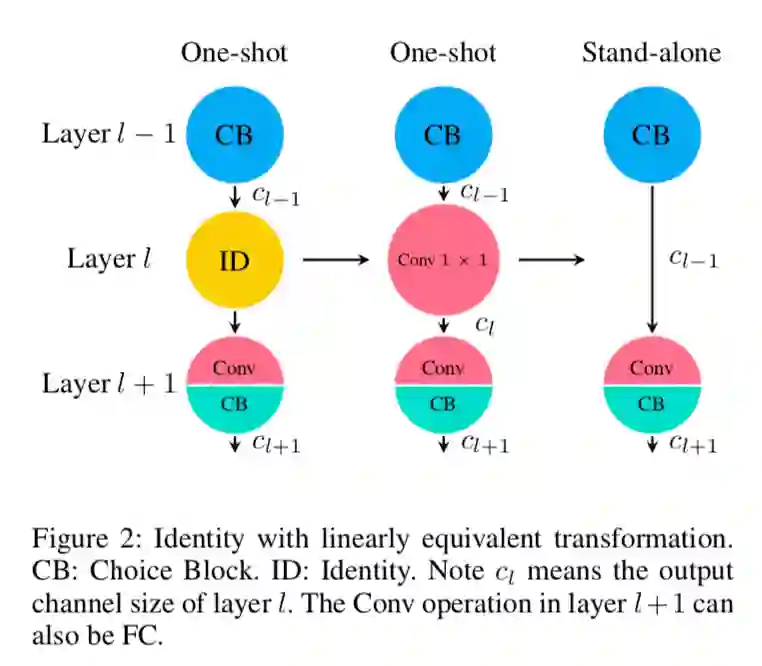

恒等变换(Identity mapping,ID)即跳接,在当前层的可选择运算模块(Choice block)中加入这个操作,可以从上一层直接越过连到当前层的下一层,从而实现层数的压缩,听上去很靠谱,但当引入 ID 后 one-shot 超网训练如何呢?

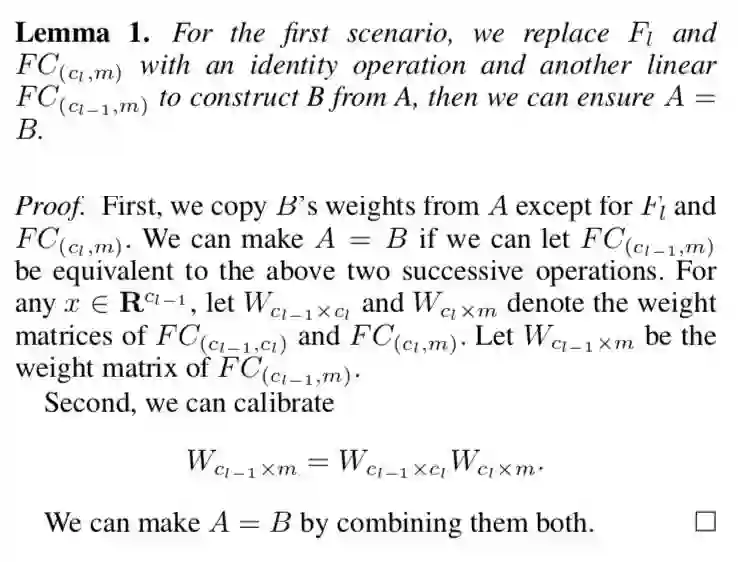

根据 SCARLET 做的实验看,单单加上 ID 就直接导致了超网训练的大幅波动,在选择了 ID 的那条路径,模型能力迅速下降,严重影响了整个超网的参数更新。

增加线性等价变换

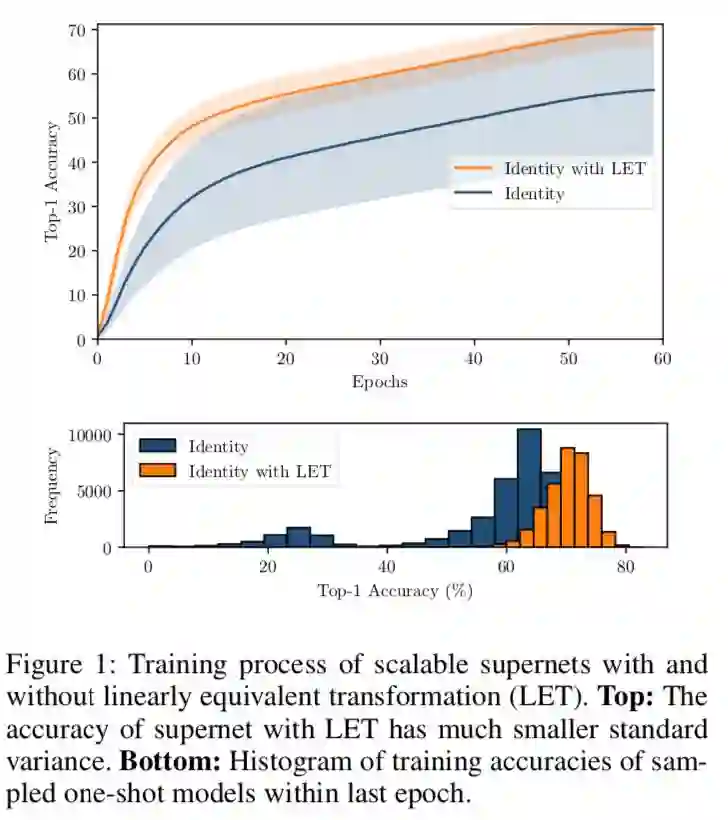

▲ Fig 3. 情形一,线性等价变换前后表征能力等价的证明

与当前最好模型对比

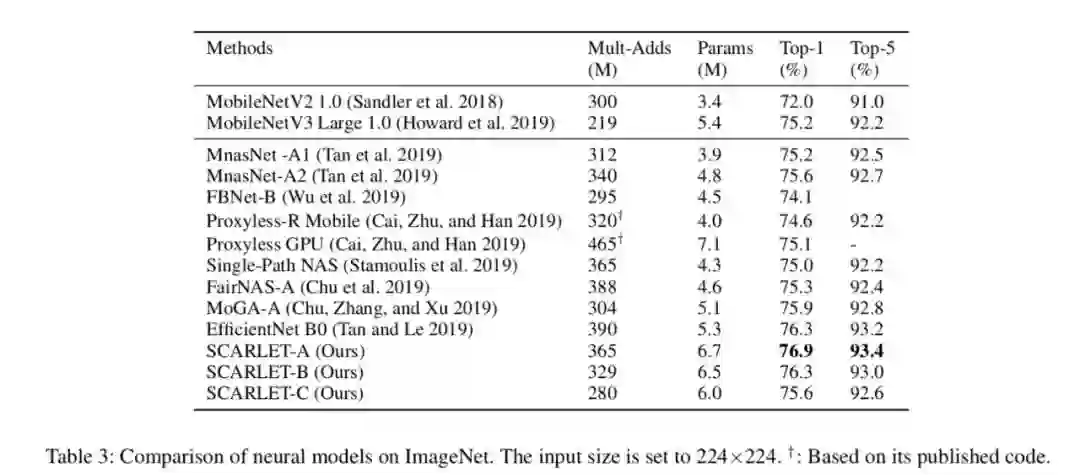

从表中看出,SCARLET 这次打的是 EfficientNet 同量级模型 B0,SCARLET-A、B 均用了明显更少的 FLOPs,大幅超过或齐平 B0。而 SCARLET-C 又是超过了自己三部曲第一部中提出的 SOTA 模型 FairNAS-A。

▲ Fig 5. 当前 SOTA 模型在 ImageNet 数据集上的对比

模型结构分析

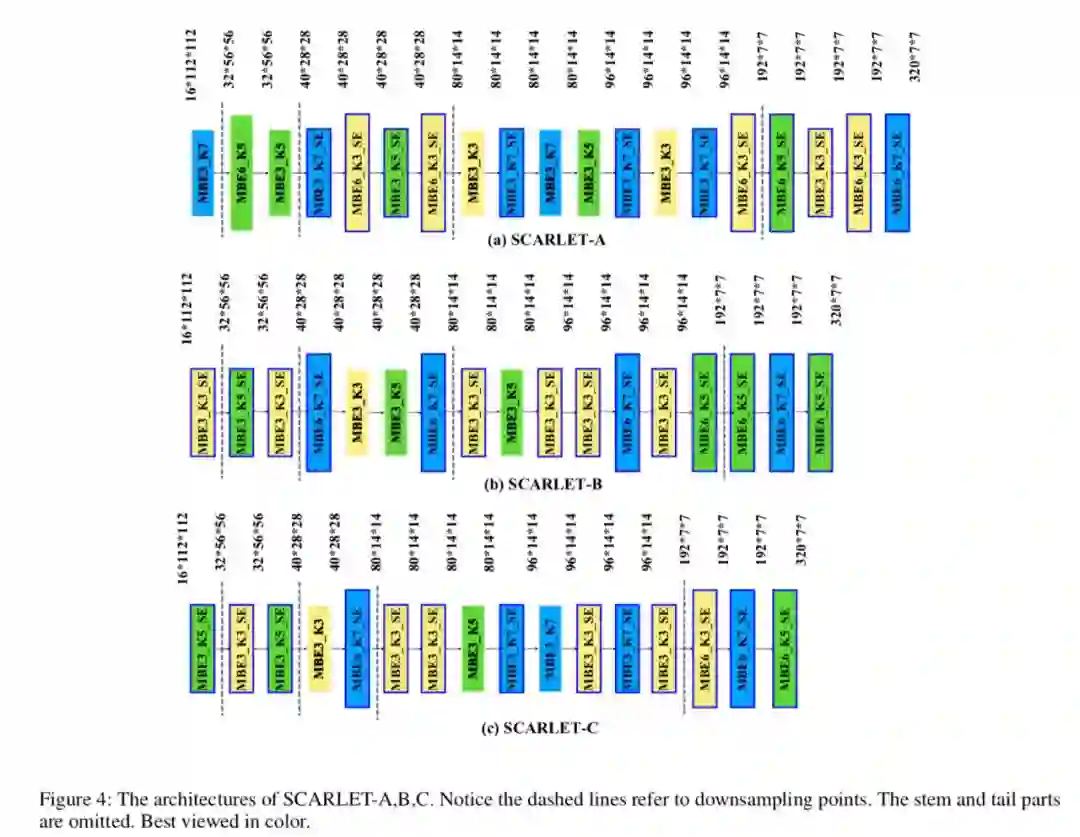

▲ Fig 6. SCARLET A,B,C 模型

与以往发布的 FairNAS 和 MoGA 模型不同,这次系列模型中有了更浅的层级,这也呼应了本次方法的要点,就是要找出浅一点但也很不错的模型,展示了超网的可伸缩性。

参考文献

Chu et al., FairNAS: Rethinking Evaluation Fairness of Weight Sharing Neural Architecture Search

https://arxiv.org/abs/1907.01845

Chu et al., MoGA: Searching Beyond MobileNetV3

https://arxiv.org/abs/1908.01314

Chu et al., ScarletNAS: Bridging the Gap Between Scalability and Fairness in Neural Architecture Search

https://arxiv.org/abs/1908.06022

Zoph et al. Learning Transferable Architectures for Scalable Image Recognition

https://arxiv.org/pdf/1707.07012

Cai et al: ProxylessNAS: Direct Neural Architecture Search on Target Task and Hardware

https://arxiv.org/abs/1812.00332

Tan et al., MnasNet: Platform-Aware Neural Architecture Search for Mobile

https://arxiv.org/abs/1807.11626

点击以下标题查看更多往期内容:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 下载论文 & 源码