【伯克利博士论文】机器学习模型泛化性什么时候良好? 从信号处理视角分析,191页pdf

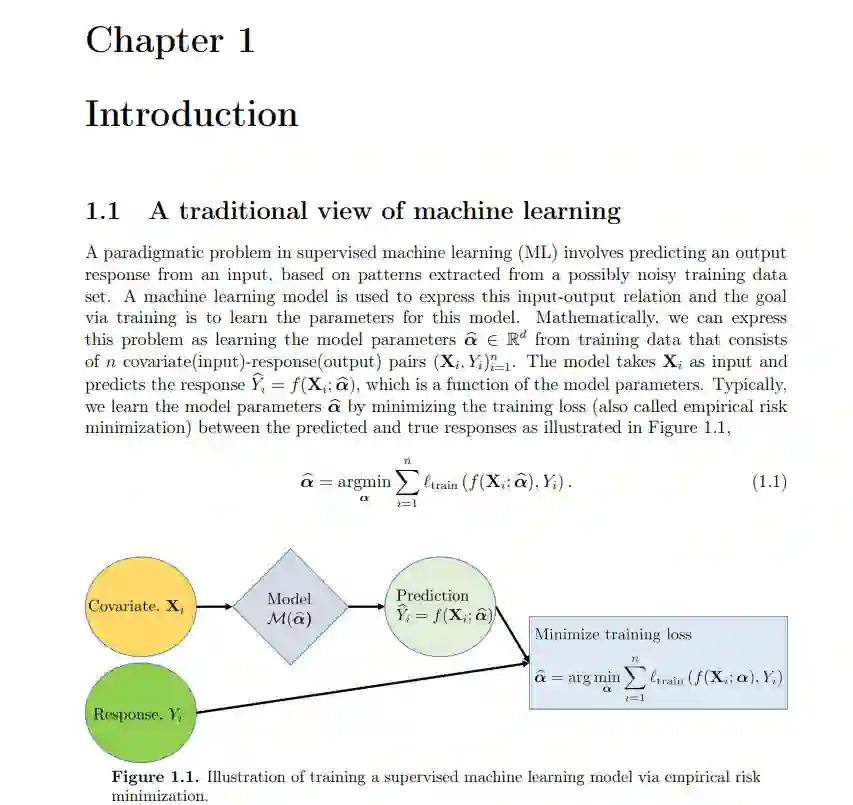

接下来,我们分析最小-ℓ2-范数插值器在高斯特征设定下的回归和二元分类问题的泛化误差。对于回归,我们插值实值标签,对于二元分类,我们插值二元标签。(事实证明,在充分的过参数化条件下,二值标签的最小范数插值与其他二值分类训练方法等价,如支持向量机或逻辑损失梯度下降法。)我们研究了一个渐近设置,其中特征的数量d与训练点的数量n成比例,且都是n, d→∞。在特征的双水平尖峰协方差模型下,证明了存在一种中间状态,在这种状态下,我们在分类任务上表现良好,但在相应的回归任务上表现不佳。然后,我们将分析扩展到多类分类设置,其中类的数量也与训练点的数量成比例,通过导出由一热编码标签的最小范数插值器引起的分类误差的渐近界。最后,为了理解我们如何学习在实践中很好地推广的模型,我们经验地研究了神经网络的应用,在硬控制问题中,最优解是未知的,线性解被证明是次优的非线性控制策略。通过智能设计神经网络架构和训练方法,利用我们对控制系统动力学的知识,我们能够更容易和鲁棒地学习性能良好的控制策略。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“ML191” 就可以获取《【伯克利博士论文】机器学习模型泛化性什么时候良好? 从信号处理视角分析,191页pdf》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年11月23日