NLP尖峰对话:京东AI总裁周伯文对话斯坦福教授Manning

新智元报道

新智元报道

编辑:张佳

【新智元导读】10月31日,北京智源人工智能研究院在国家会议中心召开北京智源大会,会议汇集几十位国际顶尖AI学者和专家,共同探讨AI最新的学术进展和产业趋势,并展示AI科研、产业的最新成果。会上,周伯文博士与Christopher Manning教授就人工智能前沿技术发展、NLP领域的产业融合等内容展开尖峰对话。快来新智元AI朋友圈与周伯文等AI大咖讨论吧~

2019年10月31日,北京智源人工智能研究院在国家会议中心召开北京智源大会(BAAI Conference),会议汇集几十位国际顶尖AI学者和专家,共同探讨AI最新的学术进展和产业趋势,并展示AI科研、产业的最新成果。科技部副部长李萌、北京市副市长殷勇出席开幕式并致辞。北京市科学技术委员会、北京市经济和信息化局、海淀区政府、朝阳区政府等部门相关领导出席了大会。

科技部副部长李萌

北京市副市长殷勇

本次大会群星闪耀,汇聚全球顶尖AI专家。包括中国科学院院士、智源研究院学术委员会主席张钹,图灵奖获得者、智源研究院学术委员会委员John E. Hopcroft,中国工程院院士、智源研究院学术委员会委员高文,加州大学伯克利分校教授、智源研究院学术委员会委员Michael I. Jordan,京东集团副总裁兼京东人工智能事业部总裁,京东人工智能研究院院长,智源-京东联合实验室主任周伯文博士,加州大学洛杉矶分校教授、智源研究院学术委员会委员朱松纯,斯坦福人工智能实验室(SAIL)负责人Christopher Manning,中国工程院院士戴琼海,清华大学类脑计算研究中心主任施路平,香港科技大学教授、IEEE Fellow杨强,伊利诺伊大学香槟分校(UIUC)计算机系教授翟成祥,哈佛大学统计系教授、美国国家科学院院士、现任清华大学丘成桐数学科学中心教授Donald B. Rubin,以及康奈尔大学计算机科学系及信息科学系教授、SVM-Light、SVM-Rank作者Thorsten Joachims等专家学者出席大会。

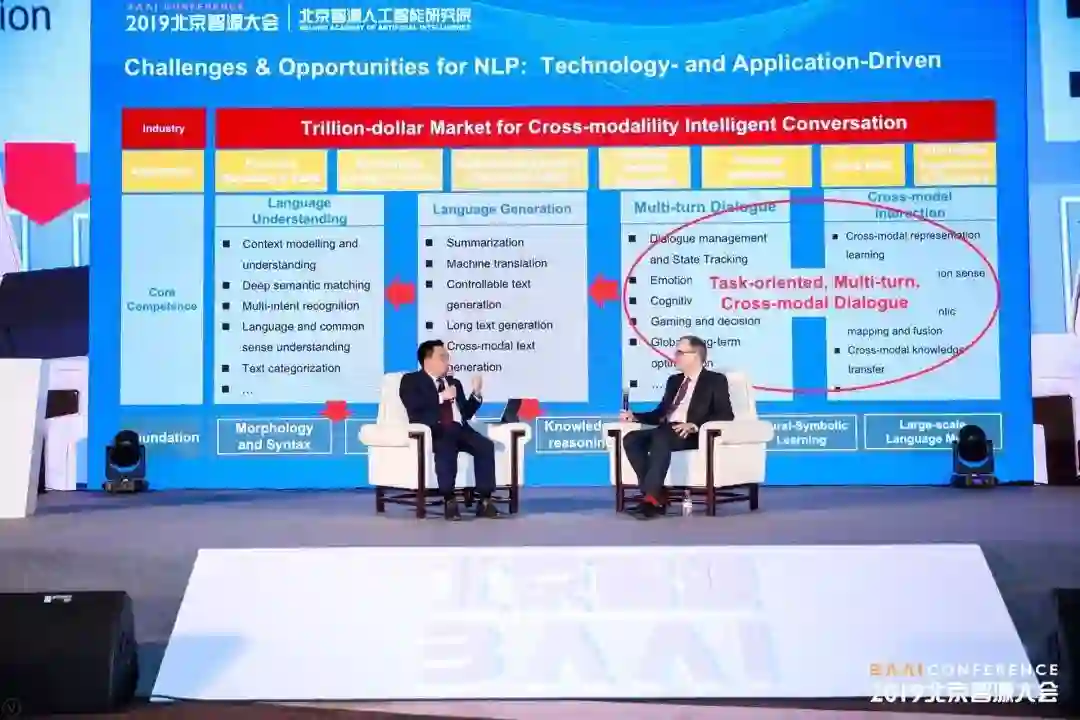

周伯文博士与Christopher Manning教授展开尖峰对话

京东人工智能事业部作为此次大会的合作伙伴,邀请到全球深度学习自然语言处理(NLP)领军人、斯坦福人工智能实验室(SAIL)负责人、斯坦福教授Christopher Manning参加,并与京东集团副总裁兼京东人工智能事业部总裁,京东人工智能研究院院长,智源-京东联合实验室主任周伯文博士在开幕式上就人工智能前沿技术发展、NLP领域的产业融合等内容展开尖峰对话。现场Christopher Manning教授还受聘成为北京智源-京东跨媒体对话智能联合实验室的专家顾问。

Christopher Manning教授受聘成为北京智源-京东跨媒体对话智能联合实验室专家顾问

以下为摘取的对话实录(翻译自现场英文对话实录):

周伯文:我们对话的第一部分会谈语义、语境和知识。我选择这三个词是因为它是来自于Christopher 2015年在《科学》杂志发表的文章。

第一个问题,Chris,在您的论文结论部分,你写到 “如果语义学、语境和知识方面真正的难题、难点得到解决的话,需要在语言学和在推理方面有一些新的突破“。现在四年多已经过去了,根据我们已知的最近的NLP进展,您对四年前的阐述,现在是否要做一些调整?

Christopher Manning:这是一个非常好的问题。我的答案是确实已经出现了一些变化,但有些没有变化。一方面,关于人工智能我的看法是,并没有取得那么大的进展,目前还没有办法使人工智能像人类那样去建模去利用知识和语境。另外一方面,要承认在过去几年当中取得了一定的进展,思维方式有了一些变化,在过去几年中我们看到,去建立新的深度学习神经网络系统,可以更好地去系统建模,这增强了我们的一些能力和知识,确实在这些方面有一些进展。

其中有一个例子,有一些传统AI人士,他们曾表示可以通过对知识和语境来建模来解决一些指代消解的问题。有一个好的关于理解语境和知识测试任务是类似于在一个行李箱当中有一个小的雕像,然后系统去推断出语言中的“它”指的是小雕像,而不是行李箱。现在基于深度学习系统已经在诸如此类任务上取得了一些突破,并且效果非常显著,我也相信在接下来的五年当中,深度学习还有很多提升空间,以及更多重大的发现。

周伯文:今天早上我和Christopher Manning在聊天时,我们都觉得2014-2015年是自然语言处理领域和深度学习结合的一个转折点。2014/2015年我在IBM Research工作,从纽约去Montreal拜访Yoshua Bengio,Yoshua和MILA的研究者们和我们交流最新的一些研究。Yoshua和他的博士后Kyunghyun Cho(他目前是NYU的教授)特别向我介绍了他们在神经机器翻译方面的一些最新的进展,第一次用最直接的编码器-解码器做翻译。我一开始的反应是,这个机器翻译模型有缺陷,因为没有明确学习对齐(alignment)词语的重排序(reordering)问题。我和他们讲了我们在统计机器翻译中,如何利用无监督学习到的SCFG去解决这个问题。Cho当时确实说他注意到他的模型在长句翻译上有很多问题,他会重新考虑重排序问题。他最后确实是找到了一个非常聪明的方法,是一个注意力模型。这个模型就是大家今天非常熟知的注意力机制,最终帮助神经机器翻译达到了业界最领先的水平(state-of-the-art)。

当我们回过头来看,注意力机制其实是一个巨大的进步。今天注意力机制不仅可以用于机器翻译来对对齐模型建模,可以用于句法分析的结构建模,还可以用于NLP中的上下文建模,等等,可以用于很多任务中,以至于Google的Transformer论文的标题都是”Attention Is All You Need”(这篇论文的第一作者Ashish曾经作为我的实习生和我在IBM Research一起工作过一个夏天,非常聪明的一个年轻人)。但是回到我们的话题语义、语境和知识,您是否同意”Attention Is All You Need”? 我个人认为注意力机制是过于复杂的,为了获得有效的注意点,需要大量的计算能力,在不同的layer,计算multi-headed attention。对于这个问题您是怎么看的?是否只需要注意力机制就足够了?还是要考虑其他的方法?

Christopher Manning:我觉得我们应该开放地探寻其他的方法。注意力机制在大量语言任务中确实被证实非常有效,所以我不会投反对票。即便在我过去的一些工作中,也充分利用了注意力机制并且获得了很好的效果。但是我不赞同只需要注意力机制,我们需要一些更复杂的计算,例如大规模的记忆力,大规模的知识,以便我们能更好的理解语言。而现有的注意力机制在这些方面做的还不够,例如BERT只能局限于长度为512或者更短的句子长度,我们需要规模更大的记忆力机制去建模语言。除此之外,结合句子结构以及语言学的层次化语义合成性也是我们需要考虑的问题,我在过去几年也有过类似的工作,例如利用树状结构来学习句子语义合成性表征等。这些都是值得尝试的不同的方向。

周伯文:如果回顾一下,您会觉得我们自然语言处理在过去十年当中最大的成果是什么?最知名的成果是什么?

Christopher Manning:在过去十年,基于深度神经网络技术,我们在自然语言处理领域取得了很多举世瞩目的成就,可以关注到很多点。我觉得现在从某种程度上来讲,它的起源超过十年了。在世纪之交的时候,有很多的同仁,他们就提出词语可以用分布式向量表征,可以用来进行预测和建模自然语言,从而避免传统建模方法的维数灾难问题。在2013年的时候,当word2vec词向量模型提出之后,立马得到了广泛的关注和应用,现在已经变成了自然语言处理领域非常基础和流行的方法。

紧随其后的突破就是用于序列建模的编码器-解码器框架(Encoder-Decoder)的提出,这一模型可以广泛用于机器翻译、文本生成、对话建模、甚至句法分析等大量的NLP任务。目前序列模型已经成为了很多NLP建模中的核心方法。近2-3年,随着Transformer+Attention模型的提出,序列模型的能力变得更加强大。

在过去18个月中,随着一系列基于上下文的词向量建模方法的提出(例如Elmo等),预训练语言模型成为一个新的突破,特别是诸如GPT-2、BERT、RoBERTa、ERNIE等强大的预训练语言模型的提出,证明自然语言理解其实可以通过从海量无监督文本中通过自学习得到,并且在一系列复杂的NLP任务中取得非常好的效果。

上面提到的都是深度神经网络在自然语言处理方面的一些突破。在语音识别领域,深度神经网络也取得了重大的突破。通过深度学习,我们可以更好的进行声学和语言的建模,从而使语音识别技术变得实用,以至于今天人们可以在各种设备上(电脑、手机)轻松的使用精准的语音识别的服务。这些都要归功于深度学习技术。

周伯文:我们知道每一个人都意识到BERT模型做出来之后,NLP会发生变化。我们会进行一些预训练的模型,然后在下游的任务上进行Fine-Tuning的分类任务,大家都觉得这是一个重大的竞争,特别是从它带来结果的角度上来看的确是一个突破。另外一方面,像张钹院士等一些杰出的研究者开始提醒我们要注意到深度学习的天花板。大家害怕仅关注深度学习,不关注NLP的一些根本问题。例如BERT出来之后,Pre-train + Fine-tuning成为了NLP任务的新范式,所有的一切NLP任务都可以简化为向量表征的学习外加下游的分类任务的模式识别。大家想一下,这是不是能更好地帮助我们达成对于语义、语境、知识以及对因果等推理学习的目标?

有很多人可能关注到最近的学术界的一些辩论,最近辩论的焦点是我们能不能利用深度学习网络模型,对因果推理进行学习呢?我觉得很多人的想法是,如果只是进行特征工程学习的话,再加上模式识别分类,可能是不足以帮助我们追寻到的最终的目标。我们需要在不同的方向有所发展,张钹院士这方面做了几次非常好的学术演讲,我认同他的观点。

在这个过程中可以深挖的还有很多,因为是非常炙手可热的辩论话题,但是我们没有任何一个人可以给予结论,所以我们再进行下一个环节的讨论。

接下来我想问Chris,您会觉得现在对于我们NLP最具有典型性、标志性的应用或技术是什么?我之所以要问这个问题,是因为您是不仅是NLP领域被应用最多的学者,您也积极活跃在其他领域。您是来自硅谷的斯坦福大学,实际上您支持了很多公司的创立,而且您有一些学生毕业后都自己在NLP和AI领域创业了,您也在一些初创公司的董事会里。因此,我觉得这是一个很好的和您讨论的话题。

标杆性技术或者应用,我先定义一下什么叫典型性呢?必须要有几个标准,其中第一个标准是当该应用取得了进步,大家都会马上会觉察到这是自然语言处理的进步。第二个条件是该技术和应用本身有很大的影响力,和进行商业化的巨大前景,能够在真实的世界当中得到大规模应用和部署,解决实际问题。这就是问您的问题,能够分享一下您的想法吗?

Christopher Manning:首先我给大家第一个是建议,第二个再给大家回答。从某种程度上来讲即便到今天,哪种技术通过多年的自然语言处理、机器学习、深度学习受益其中,然后技术解决了问题,取得了足够的进步。我会认为也许是机器翻译,在最近几年当中在我们的神经机器翻译过程中取得了很大的长足进步,所以我们看到了很喜人、非常明显的进步。比如说在之前以前是统计机器翻译,它的能力也得到了加强。好像有一些廉价的翻译系统,包括搜索引擎,都可以走进寻常百姓家庭,还有包括在2010年有全新的系统,我们将会用很多神经机器翻译和序列系统,并且把Transformer模型拿过来用。在这个过程中,发现机器翻译质量不断提高。

从质量角度来说,机器翻译是非常好的晴雨表来衡量行业中的技术发展变革。但是从它对社会产生影响的角度来讲,机器翻译影响社会的能力是有限的。比如说你在异国他乡不知道发生了什么情况,机器翻译会帮助你,而且它可能对商业产生积极影响。如果在日常生活过程当中,大多数人其实不需要机器翻译。从这个角度上来说,我会觉得有更好的答案,我们现在很多人都非常关注我们怎样能够用自然语言处理技术打造一个更好的对话的机器人呢?这种对话机器人的机制指的是你可以跟它说话,它能懂你说什么,然后给你回答、给您找到信息。比如你想买个服务,你提出一个问题它帮你搜索、帮你回答,这是更难取得进步的领域,这个领域很难取得进步。

但是我们逐渐看到越来越好的计算机对话系统,这个领域肯定在接下来会产生很大的经济方面的影响。能够有一些计算机可以非常智能,能够和人进行对话,像人的伙伴一样。

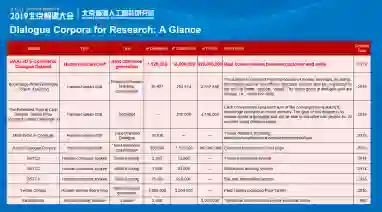

周伯文:我想展示一下我的观点,我们考虑自然语言处理的时候,其实包括了如这个PPT所示的很多层。有人会讲基础层,包括句法、语义,还有包括表征学习等等。其他人讲的是NLP的包括核心能力,括自然语言的理解,怎样生成自然语言,怎样对话,怎样去做一个多模式的推理或者互动。在这核心能力之上,可以看一下有很多的NLP应用提供给大家,而它们都会产生巨大的影响,它们的影响力对社会不容小觑。