GAN 生成对抗网络论文阅读路线图

【导读】如果你刚入门深度对抗网络,可能会遇到的第一个问题是“应该从哪篇论文开始读起呢?”

这里给出了GAN论文阅读路线图!

路线图按照下面四个准则构建而成:

从提纲到细节

从经典到前沿

从通用领域到特定领域

专注于最先进的技术

Generative Adversarial Networks – Paper Reading Road Map

作者:İdil Sülo, Middle East Technical University

编译:专知

今年夏天,我在我的实习工作中重点研究了Generative Adversarial Networks(GAN)。 起初,我对这个模型知之甚少,所以实习的最初几周进行了大量的纸质阅读。 为了帮助其他想要了解更多关于GAN技术的人,我想按照我阅读的顺序分享一些我读过的文章。

在阅读这些论文之前,如果您不熟悉这些论文,我建议您学习一些深度学习的基础知识。 我也相信其中一些论文背后的数学可能非常困难,所以如果你觉得不舒服,你可以跳过这些部分。

这是我的论文阅读路线图,我给出了一些我自己关于论文的评论:

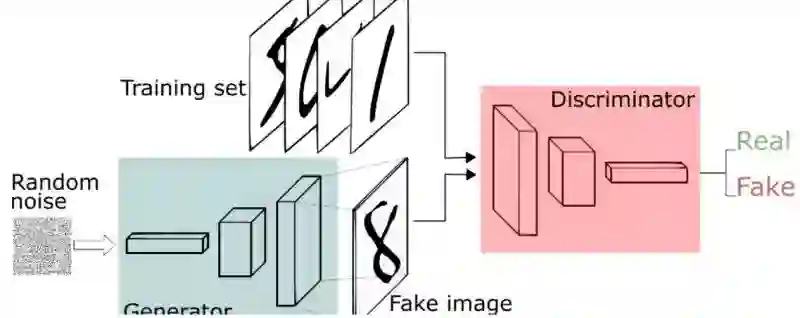

1. NIPS 2016 Tutorial: Generative Adversarial Networks

这是Ian Goodfellow的一个教程,介绍了GANS的重要性、它们的工作原理、与它们相关的研究前沿以及将GANS与其他方法结合起来最前沿的视觉模型。本教程首先介绍GANS的应用实例。然后,Ian Goodfellow对GANS和其他模型,如变分编码器进行了比较。Goodfellow后来解释了生成器和判别器是如何工作的,并且还描述了它们之间的关系。接下来,Goodfellow给出了改进GANS性能的一些技巧和窍门,以及与GANS相关的一些研究前沿。他还提及了GANS面临的问题,比如模式崩塌。最后,Goodfellow提出了一些实际操作和解决方法。

Paper link: https://arxiv.org/abs/1701.00160

2. Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks

这篇论文描述了一种使卷积GAN训练更加稳定的新型结构——深度卷积生成网络(DCGAN)。研究人员给出了这种结构的一些指导方针,例如为更深的结构移除全连接的隐藏层,为生成器和鉴别器使用 batch normalisation,在生成器中为除输出层之外的所有层使用ReLU,以及在鉴别器中的所有层使用LeakyReLU。

Paper link: https://arxiv.org/abs/1511.06434

3. Wasserstein GAN

本文提出了一种Wasserstein GAN(WGAN)来优化GANs的训练过程。借助于WGAN,作者避免了模式崩塌等问题,并提供了可以调试和超参数搜索的学习方式,使用weight clipping来进行了一个Lipschitz约束,但是将在下一篇文章中看到另一种技术,将改进这部分。

Paper link: https://arxiv.org/abs/1701.07875

4. Improved Training of Wasserstein GANs

这篇论文发现,有时WGAN可能会出现不满意的结果,如产生不好的例子,不能收敛等。这是由于上面提到的weight clipping的使用。在这个工作中,研究人员提出了一种替代weight clipping命名梯度惩罚的方法,把这种结构称为WGAN-GP,并表明这种技术的使用极大地提高了WGAN的性能。

Paper link: https://arxiv.org/abs/1704.00028

5. On the Regularization of Wasserstein GANs

为了提升GAN训练的稳定性,这篇论文提出了一种新的惩罚项来加强Lipschitz约束。他们把这种结构称为WGAN-LP,并且在他们的实验中,他们把它与上面提到的WGAN-GP进行比较。

Paper link: https://arxiv.org/abs/1709.08894

下面的论文提出了新的技术和结构,可以作为最前沿的tricks 来使生成式对抗网络的训练变得稳定。

6. Is Generator Conditioning Causally Related to GAN Performance?

本文提出了一种重要的技术Jacobian Clamping。通过该技术的帮助,研究者提供了GAN生成器的conditioning 和由这些GAN生成器表示的模型的“质量”之间存在因果关系的证据。

Paper link: https://arxiv.org/abs/1802.08768

7. Neural Photo Editing with Introspective Adversarial Networks

在这篇论文中,作者提出了感知图像编辑器(Neural Photo Editor),它是一个图像编辑界面,可以用生成神经网络的能力来对图像进行比较大的语义层面的合理修改。为了解决达到准确重建而不损失特征性质,作者提出了内省对抗式网络(Introspective Adversarial Network),该网络将GAN和VAE创新地结合在一起。通过使用基于权重分享的扩张卷积(weight-shareddilated convolutions)计算块,该模型可以有效的获得远程依赖(long-rangedependencies),并且通过正交正则化(Orthogonal Regularization)这样一个新的权重正则化方法,提升了泛化表现。作者在CeleA,SVHN和CIFAR-100数据库上验证了模型的有效性,并且产生了具有高视觉保真度的样例和重构图片。

Paper link: https://arxiv.org/abs/1609.07093

8. GANs Trained by a Two Time-Scale Update Rule Converge to a Local Nash Equilibrium

在这篇论文中, 作者引入两种基于时间尺度的跟新规则,它们被证明可以收敛到稳定的局部纳什均衡。

Paper link: https://arxiv.org/abs/1706.08500

9. Spectral Normalization for Generative Adversarial Networks

这篇文章提出一种称为spectral normalization的新的权重归一化技术,以稳定GAN鉴别器的训练。

在高维空间中,鉴别器做出的密度比例估计往往不准确,而且在训练中非常不稳定,生成器网络也难以学到目标分布的多模态结构。更糟糕的是,当生成的和目标数据分布区域不相交的时候,就存在着一个能完美区分生成的数据和目标数据的鉴别器。一旦遇到了这样的状况、训练出了这样的鉴别器,生成器的训练就基本停滞了,因为这样产生的鉴别器的关于输入的导数就成了0。这种情况让作者们思考如何引入一些新的限制,避免训练出这样的鉴别器。在这篇论文中,作者们提出了一种新的权重正则化方法,称作“spectral normalization”(光谱标准化),它可以稳定鉴别器网络的训练过程。这种正则化方法的性质很让人喜欢:(1)只需要调节Lipschitz常数一个超参数,而且想到达到令人满意的模型表现也不需要反复调试仅有的这一个参数;(2)方法的实现非常简单,额外的计算开销也很小。

Paper link: https://arxiv.org/abs/1802.05957

10. Generalization and Equilibrium in Generative Adversarial Nets (GANs)

泛化能力是衡量生成模型好坏的一个重要标准,本文指出 JS 散度、Wasserstein 距离都不能很好地衡量模型的泛化能力,为此,文中提出了一种基于 discriminator 的 neural network divergence/distance,用于衡量模型的泛化能力。此外作者还证明了 WGAN 的纯策略纳什均衡解的存在性,并提出MIX+GAN(混合策略 GAN)的训练模式,该模式在实际训练中更稳定,并且证明了混合策略纳什均衡解的存在性。

Paper link: https://arxiv.org/abs/1703.00573

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知)

后台回复“GANPAPER” 就可以获取 最新论文下载链接~

参考链接:

https://www.kdnuggets.com/2018/10/generative-adversarial-networks-paper-reading-road-map.html

-END-

专 · 知

人工智能领域26个主题知识资料全集获取与加入专知人工智能服务群: 欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知