UC伯克利拿下EMNLP最佳论文,复旦黄萱菁当选下一届程序主席

今日上午, EMNLP 2020各项大奖出炉!

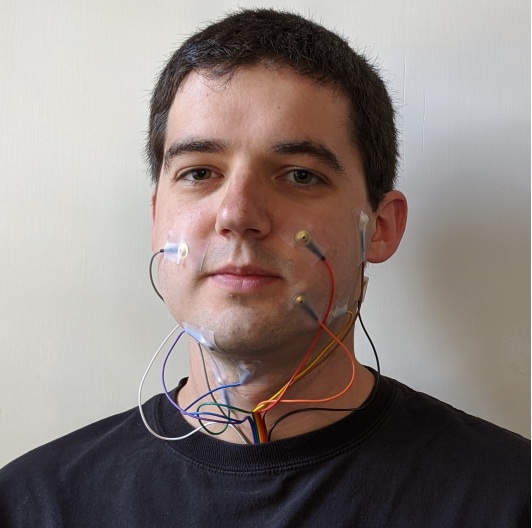

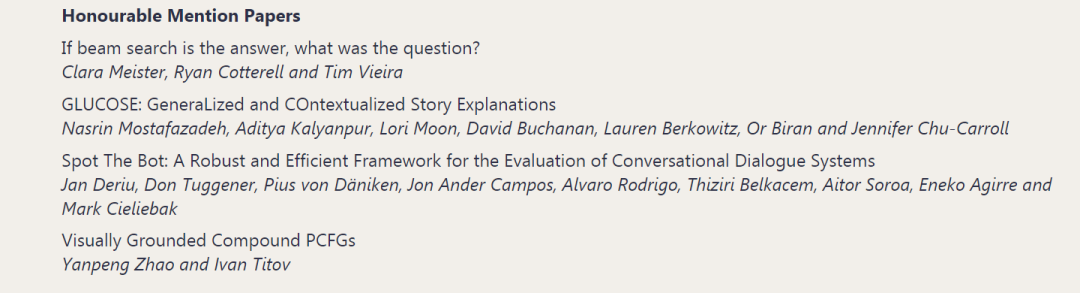

其中最佳论文奖由加州大学伯克利分校的David Gaddy、Dan Klein两人获得,爱丁堡大学华人博士生 Yanpeng Zhao 获得了最佳论文荣誉提名奖(共4篇)。

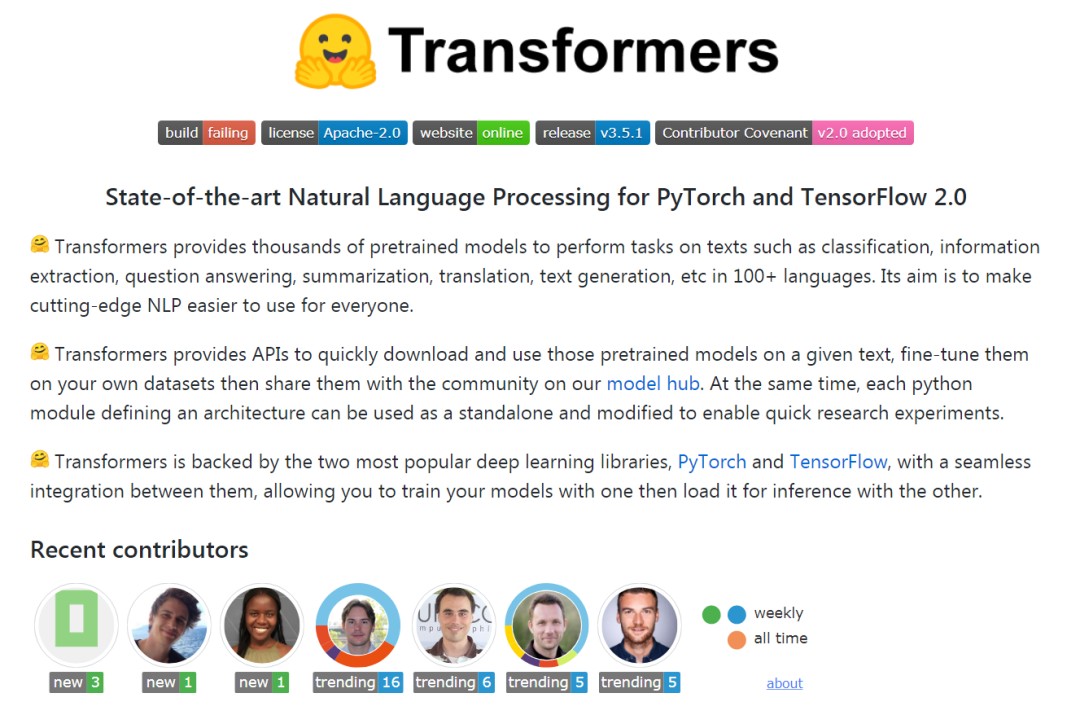

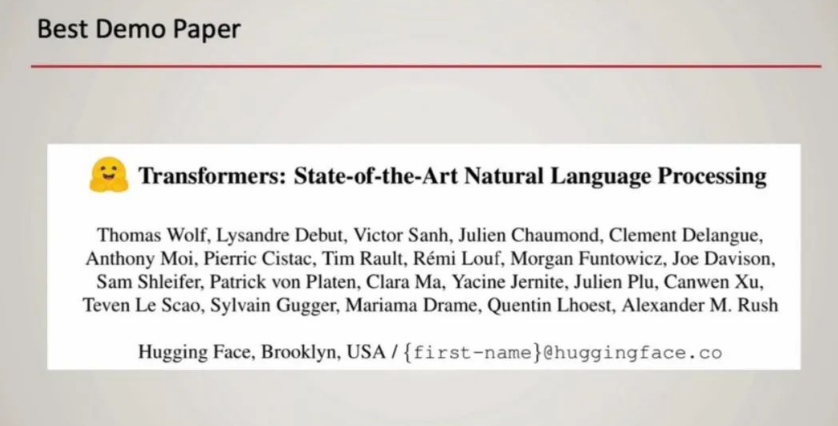

另外,本届大会的最佳 Demo 奖由大家所熟知的 Hugging Face 团队摘得。

复旦大学计算机科学学院教授黄萱菁将出任下一届大会的程序主席。

除此之外,比较遗憾的是,今年的最佳短论文暂未颁发。

作为国际语言学会(ACL)下属的 SIGDAT 小组主办的自然语言处理领域的顶级国际会议。EMNLP每年举办一次,去年则与 IJCNLP 联合在香港举办,今年由于疫情转为线上举办。

EMNLP 2020 共收到3677篇投稿,有效投稿为3359 篇,总接收论文752 篇,包括602篇长论文、150篇短论文。

从接收率看,EMNLP 2020的论文接受率创下近五年新低,为22.4%,其中长论文接收率为 24.6%,短论文接收率为16.6%。

更多关于EMNLP 2020的论文相关信息请移步“中国投稿量第二,接收率却仅有13.2% ? 十张图带你读懂EMNLP 2020开幕式!”一文。

-

论文链接:https://www.aclweb.org/anthology/2020.emnlp-main.445.pdf -

开源链接:https://github.com/dgaddy/silent_speech -

作者:David Gaddy、Dan Klein(加州大学伯克利分校)

论文链接:https://arxiv.org/pdf/2010.02650.pdf

作者:Clara Meister(苏黎世联邦理工学院)、Tim Vieira(美国约翰霍普金斯大学)、Tim Vieira(剑桥大学)

论文链接:https://arxiv.org/pdf/2009.07758.pdf

作者:Nasrin Mostafazadeh、Aditya Kalyanpur、Lori Moon、David Buchanan、Lauren Berkowitz、Or Biran、Jennifer Chu-Carroll

-

论文链接:https://arxiv.org/pdf/2010.02140v1.pdf -

作者:Jan Deriu、Don Tuggener、Pius von Daniken、Mark Cieliebak、Alvaro Rodrigo、Jon Ander Campos、Aitor Soroa、Aitor Soroa、Thiziri Belkacem

论文链接:https://arxiv.org/pdf/2009.12404.pdf

项目地址:https://github.com/zhaoyanpeng/vpcfg

作者:Yanpeng Zhao、Ivan Titov(爱丁堡大学)

-

论文链接:https://arxiv.org/pdf/1910.03771.pdf -

Transformers 库地址:https://github.com/huggingface/transformers -

作者:Hugging Face 团队

模型体系架构和模型预训练的发展推动了自然语言处理的最新进展。

Transformer体系架构有助于构建更高容量的模型,而预训练使得在大量任务中高效利用大模型容量成为可能。

Hugging Face 团队创建了Transformers开源代码库,旨在将这些NLP进步开放给更广泛的机器学习社区。

该库包含了在统一API下经过精心设计的SOTA模型的Transformer架构。

该库汇集了由社区制作并可供社区使用的精选预训练模型的集合。Transformer设计可由研究人员不断扩展,对从业人员使用而言简单易行,并且可以快速而强大的进行工业部署。

黄萱菁,复旦大学计算机科学学院教授,2008年至2009年,UMass Amherst CIIR的访问学者。她的研究兴趣包括自然语言处理、信息检索、人工智能、深度学习等。她在顶级会议上发表了数十篇论文,包括SIGIR、ACL、ICML、IJCAI、AAAI、CIKM、ISWC、EMNLP、WSDM和COLING。她曾担任NLPCC 2017、CCL 2016、SMP 2015和SMP 2014的PC联合主席......

谷歌学术主页:https://scholar.google.com/citations?user=RGsMgZA4H78C&hl=en

以下是黄萱菁团队本次EMNLP 2020主会录取论文:

点击阅读原文,直达EMNLP小组!