两日公开课:伯克利深度强化学习训练营 | 视频+PPT

千平 发自 凹非寺

量子位 出品 | 公众号 QbitAI

又有新公开课放出~

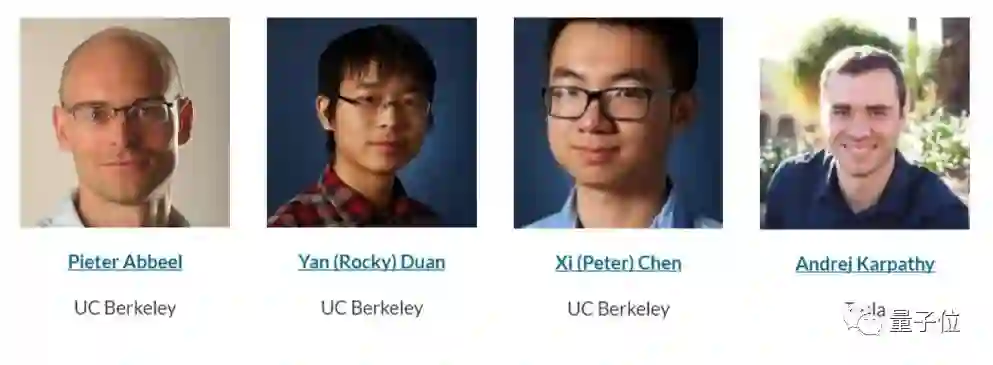

加州大学伯克利分校的Pieter Abbeel教授,最近联合他的两位博士生Yan (Rocky) Duan、Xi (Peter) Chen,以及现任特斯拉人工智能和Autopilot视觉总监Andrej Karpathy,共同发起了一个两日的深度强化学习训练营。

除此以外,还有来自DeepMind和OpenAI的客座讲师。

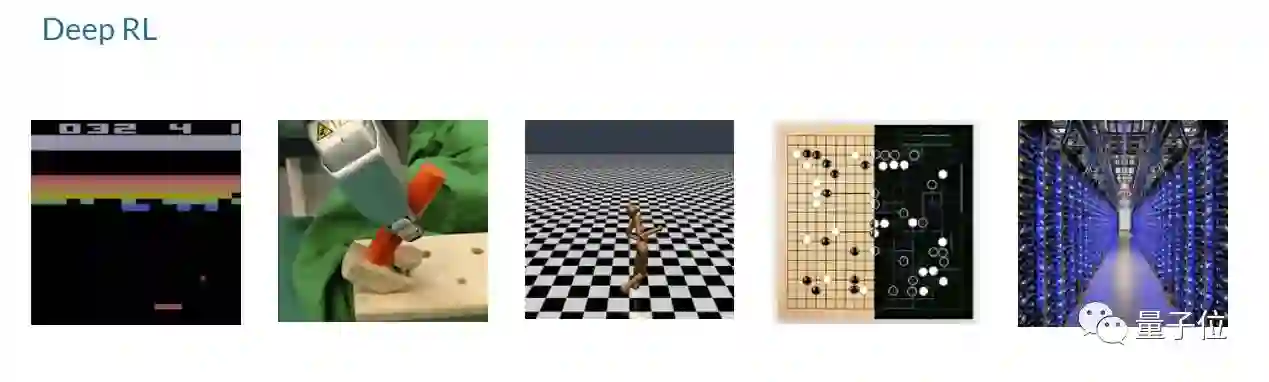

强化学习被认为是下一代人工智能系统的驱动力,在模式识别之外带来了更多的进步。例如强化学习让AI学会了玩Atari游戏,帮助AlphaGo在围棋世界称霸。所有这些都依赖于深度神经网络和强化学习之间的协同。

在这个为期两天的训练营里,将通过讲座和动手实验相结合的课程,教授深度强化学习的基础。

这个训练营的主题包括:

强化学习基础

策略梯度

Actor-Critic算法

Q-learning

进化策略

强化学习故障排除和调试策略

当前的研究

组织者希望学过这些课程之后,能帮助你了解相关的基础知识,能从头开始应用最先进的方法,能在rllab上构建高级应用程序,能够将深度强化学习应用在更多的新领域。

课程表

Core Lecture 1 Intro to MDPs and Exact Solution Methods — Pieter Abbeel

Core Lecture 2 Sample-based Approximations and Fitted Learning — Rocky Duan

Core Lecture 3 DQN + Variants — Vlad Mnih

Core Lecture 4a Policy Gradients and Actor Critic — Pieter Abbeel

Core Lecture 4b Pong from Pixels — Andrej Karpathy

Core Lecture 5 Natural Policy Gradients, TRPO, and PPO — John Schulman

Core Lecture 6 Nuts and Bolts of Deep RL Experimentation — John Schulman

Core Lecture 7 SVG, DDPG, and Stochastic Computation Graphs — John Schulman

Core Lecture 8 Derivative-free Methods — Peter Chen

Core Lecture 9 Model-based RL — Chelsea Finn

Core Lecture 10a Utilities — Pieter Abbeel

Core Lecture 10b Inverse RL — Chelsea Finn

Frontiers Lecture I: Recent Advances, Frontiers and Future of Deep RL — Vlad Mnih

Frontiers Lecture II: Recent Advances, Frontiers and Future of Deep RL — Sergey Levine

TAs Research Overviews

以上所有的课程视频和PPT,现在已经全部放出。有兴趣的同学,请前往以下网址学习:

https://sites.google.com/view/deep-rl-bootcamp/lectures

温馨提示:应该需要更科学的上网方式才能访问。

另外,这次的公开课得到了好几家赞助商的支持。其中,钻石赞助商是亚马逊,另外京东是白银赞助商。

— 完 —

加入社群

量子位AI社群9群开始招募啦,欢迎对AI感兴趣的同学,加小助手微信qbitbot3入群;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进群请加小助手微信号qbitbot3,并务必备注相应群的关键词~通过审核后我们将邀请进群。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI

վ'ᴗ' ի 追踪AI技术和产品新动态