假评论!ICLR 2019双盲评审「名存实亡」?

机器之心报道

参与:晓坤、张倩、李泽南

即将于明年 5 月举行的 ICLR 2019 大会在几天前已经结束了论文投稿,本次大会共接收到了近 1600 篇论文,数量相较今年的 1000 篇提升了近 60%。在双盲评审期间,人们可以在 Openreview 平台上看到所有论文内容。

大会论文的投稿被放在公开平台上,以匿名方式供所有人审阅,这看起来是一件能够推动学术交流的好事。然而,这几天 ICLR 的论文评审又出了一些岔子。

假评论

一篇 9 月 28 号提交到 Openreview 上,也就是参与 ICLR 2019 双盲评审的论文引起了评论区的非正面交锋。

这篇论文的主题是带噪声标签数据的深度网络训练,作者提出了一种新的训练方法。

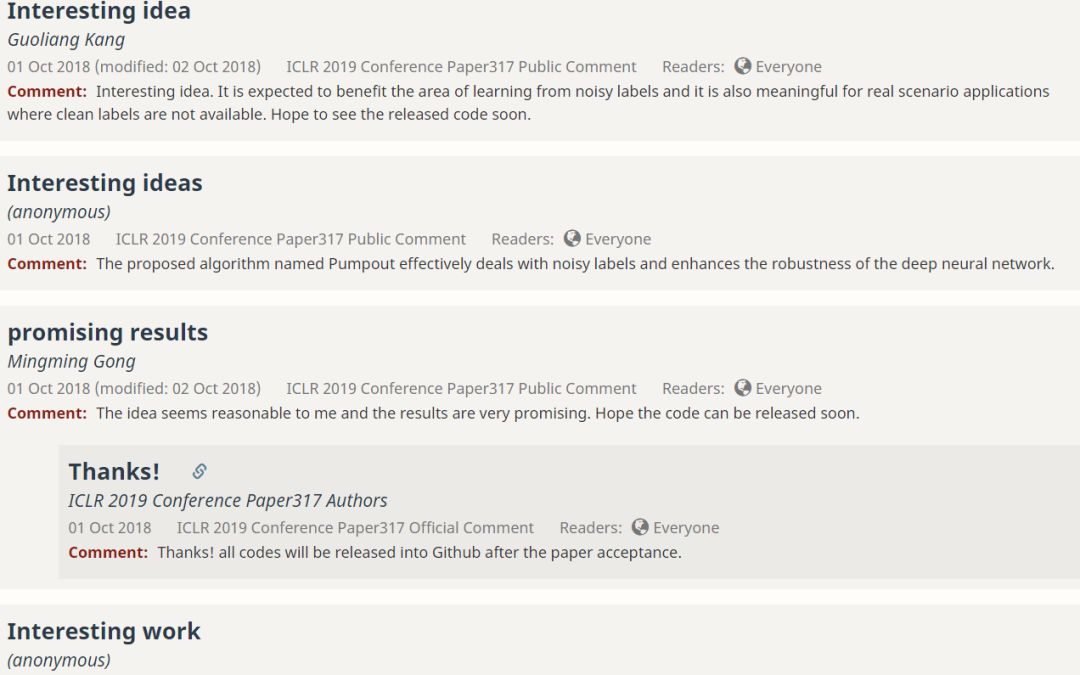

刚开始评论区出现了一些未匿名的评论,赞其使用的方法简单、合理,很巧妙地利用了噪声数据的信息。作者也给出了积极的回应。

之后接连出现了或匿名或非匿名的刷屏式好评,大致都是「interesting」或「promising」之类的评价,并期待代码开源。作者回应在论文接收后会放出代码。

水军既视感。

有网友 X(匿名)就不爽了,直接指出:你能不能停止刷虚假评论!

目前 ICLR2019 的论文只有少数几篇有评论,而你的已经有了 7 个评论,并且全都是在线的积极反馈。我不需要说得更明白了吧?快停下吧,这么做对你没什么好处。

但之后刷屏式的评论仍然继续出现,网友 X 只好敬佩地说道:非常 amazing 的自动评论生成方法,未来是否会从多样性方向优化?期待代码开源。。。

尽管之后也出现了针对论文内容提出的具体问题和文献对比,但并没有看到深入的讨论。目前该论文已经累积了 16 篇评论,当然也包括了 X 的贡献,论文作者尚未正面回应 X 的攻击。

论文:Pumpout: A Meta Approach for Robustly Training Deep Neural Networks with Noisy Labels

地址:https://openreview.net/forum?id=HyG1_j0cYQ¬eId=B1lSK22yqX

对于此事,Reddit 上的网友议论纷纷,有严肃的,有困惑的,也有吃瓜的。

网友 barrynyle 指出:

在真正的评论面世之前发布可见的评论是一个可怕的想法,有很多方式可以对评审员造成影响。

论文的好评(如果是真的,一定会有影响,如关于热门论文 BigGAN 的评论)

在对手论文下发布刻薄、详细的评论(如果别人的论文和你的类似,你必须发现甚至连评审者都没发现的缺陷,这样他们就不会忽视你的评论)

在对手论文下发布看起来过于浮夸的评论使之看起来像在作弊

这些评论并不总是与论文相关,很多人似乎在用这种方法增加自己论文的引用频率,评审员很难屏蔽这些评论。

网友 Captain_Price_777 针对「你必须发现甚至连评审者都没发现的缺陷」提出了自己的疑问:

指出论文的缺点难道不是好事?

网友 ucwdan 回应道:

我认为这其中的不同在于,正式的评审员需要同时看到论文的亮点和缺点,但竞争者可能仅会反馈论文的缺点。正式评审员可能会在真正仔细读过论文前先看到这些负面评价,从而带来先入之见。

综合各方观点,客观来说:这是好事也是坏事。当然指出论文的缺点是必须的,但是过早的反馈可能会使评审过程变得相当不公平。评审员由于自身经验关系,不可能做到完美的公正。而无论是虚假的吹捧或真实的指摘,作为先入之见,最后都会让评审员留下对论文的负面印象。

除此之外,也有网友对「在论文被接收后会开源复现代码」表示不理解,这简直就是在说:论文接收前,不给你复现的机会。

网友 novatig 是过来人:

我必须承认我也做过同样的事……我的代码已经公布在 GitHub 上,但我在论文中表示,我要在论文评审程序结束之后再放出代码,因为添加一个链接会破坏双盲审的公正。事实上,这就是一些 NIPS 项目负责人教我的处理双盲审开源代码的方式。

还有人开起了玩笑:

昨晚我读了这篇 Pumpout 的论文。每次醒来我都感到精力充沛。我的视力更清楚了。我集中注意力的时间可以更长。我的毛发都很通透。。。

呼吁用 AI 来审论文。。。额,正好是我最近提交的研究。

并不严谨的「双盲评审」

被很多期刊和学术会议使用的双盲评审制度经常被人们诟病不够公平,那么相对公开的制度又如何?在 ICLR 2019 大会的官网上,我们能够看到本次会议论文提交的规则。其中明确表示:允许论文提交者自行宣传已提交的论文。

论文提交规则链接:https://iclr.cc/Conferences/2019/CallForPapers

和去年差不多,论文提交是双盲的,即论文作者和评审者都看不到彼此的名字。但我们还是要将论文放到 OpenReview 上,允许大众评论并使评论对所有人可见。评审者发布的评论还是可匿名的。如果有人要在评审期间引用一篇论文,OpenReview 将提供 BibTeX 入口,这个入口不包含作者姓名,但会给出标题、年限和 url。评审结束之后才会公布作者的信息。尽管 ICLR 是双盲的,但也不会禁止作者在 arXiv 或其他公共平台上发表自己的论文。

这实际上让盲审规则变得形同虚设。对于一些隶属著名公司、机构的投稿人来说,他们完全可以在 arXiv 上发布带有署名的论文版本,并在社交网络上开展相应的宣传。事实上人们都已在这么做了。

另一方面,OpenReview 是一个允许用户自由注册账号的平台。理论上论文作者可以请「水军」为自己的论文刷好评,从而影响大众对于研究的看法。在大会双盲评审期间,人们对于论文的评论还可以保持匿名。

ICLR 并不是唯一允许同时在其他平台上传非匿名预印版论文的大会,NIPS 等人工智能顶会的论文提交规程里也有类似的条款。相比之下,ACL 就比较严格了。在 ACL 2018 的官网上我们能看到如下叙述:

重要提示

ACL 2018 采用了新的提交、审核与引用规定。违反任何此类规定的提交内容将在未经审核的情况下被拒绝。其中最重要的是论文匿名期,自 2018 年 1 月 22 日始适用于 ACL 2018。

在匿名期内,不能让普通社区(例如,通过预印本服务器)在线获得你的论文的非匿名版本。

在匿名期间,不可以更新非匿名版本,不能在社交媒体上宣传,也不要采取其他会进一步损害匿名双盲审的行动。

提前出炉的「最佳论文」

如前所述,根据 ICLR 的规则,学者在评审期间可以宣传自己的论文。前几天引起人们关注的 BigGAN 就在大会论文提交截止之后被放在了 arXiv 上,让人们知晓了论文作者——原来是英国 Heriot-Watt 大学和 DeepMind 出品。这篇论文的作者也很快在 Reddit 上开贴,开始接受人们的提问。

没错,DeepMind。

论文链接:https://arxiv.org/abs/1809.11096

在这项研究中,作者成功地将 GAN 生成图像和真实图像之间的保真度和多样性 gap 大幅降低。其提出的改进方法大幅改善了类条件 GAN 的性能。当在 128x128 分辨率的 ImageNet 上训练时,本文提出的模型—BigGAN—可以达到 166.3 的 Inception 分数(IS),以及 9.6 的 Frechet Inception 距离(FID),而之前的最佳 IS 和 FID 仅为 52.52 和 18.65。

而在论文被提交上 arXiv 之前,BigGAN 的论文已经在 Reddit、知乎和推特上引发了一轮关注热潮,并引起了 Oriol Vinyals、Ian Goodfellow 等学者的关注。AI 研究者们对于该论文中的模型训练方法赞誉有加,而更多人的眼球则被生成对抗网络创作出的逼真图像吸引。

很难想象这些图片都是由 BigGAN 人工智能自动生成的。

除了少数极具突破性的研究以外,目前「过于热闹」的情况,对于论文本身或许只能带来负面的影响,而让一些好事者从中获益。正如网友引用美剧「权力的游戏」之中的台词所形容的:CHAOS IS A LADDER,这一季的 ICLR 大戏已经开演了。

机器之心《全球500强上市公司人工智能战略适应性报告》重磅发布。17个行业,140家上市公司,纵览500强落地人工智能的成与败。