动态 | AI界最具「研值」奖:十大学霸奖学金获奖名单出炉(附学术分享)

AI 科技评论按:1 月 22 日,号称业界「研值」最高的百度奖学金 2017 年度颁奖典礼在百度科技园隆重举行。AI 科技评论作为合作媒体也受邀参加了颁奖仪式,共同见证了 10 位「AI 界耀眼新星」的诞生。

百度奖学金计划是为了发掘、支持和鼓励最优秀的华人学生去解决人工智能学科领域当中最有价值的技术问题,促进中国人工智能的世界前沿站位,培养中国人工智能领域的未来储备精英技术人才。因此本次的十位获奖选手无疑都来自 AI 领域,研究方向涵盖了当今最热门的计算机视觉,自然语言处理,机器学习,大数据挖掘等相关细分方向。以下是十位选手的简单介绍。

陈师哲,计算机视觉领域,主攻「多模态情感识别」和「视频内容自然语言描述」,在国际顶会期刊发表相关论文十余篇。

王奕森,机器学习/语音领域,主攻树类机器学习模型,尤其是随机森林模型相关的基础理论和应用。

张飚,自然语言处理领域,主攻机器翻译中的长时记忆模型,提出了创新型的新模型方案。

胡志挺,自然语言处理领域,主攻自然语言处理以及机器学习方向的基础理论,尤其在知识和神经网络方法相结合的方向上有独到的见解。

林衍凯,自然语言处理领域,主攻知识表示学习,知识获取,知识应用方向,代表性的研究和成果有 TransR 和 PTransE,NRE 和 MNER 等。

王小龙,计算机视觉领域,硕士期间主要做 DPM 的检测工作,博士从事预测学习(predictive learning)工作,发表的论文多次被国际顶会收录,目前发表 17 篇论文,10 篇一作,570 个引用。

王云鹤,计算机视觉领域,主攻神经网络加速压缩方面的研究。他提出了利用离散余弦变换来提升卷积神经网络预测过程的预测速度,该方法极具创新性和实用性。

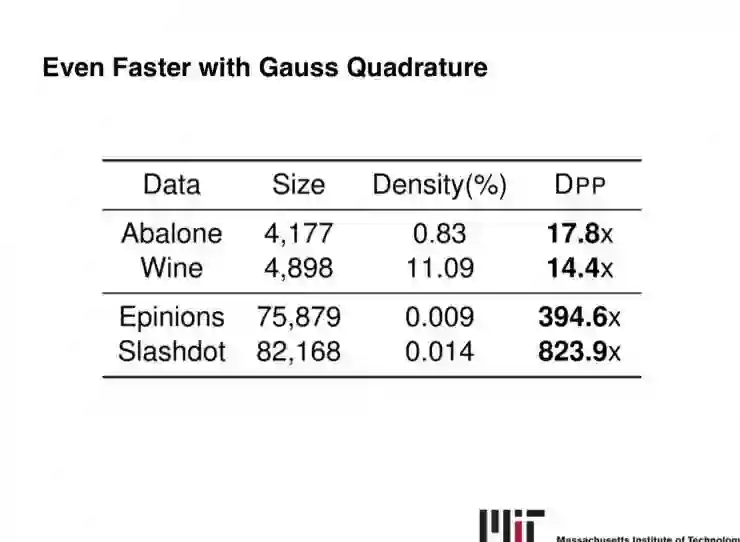

李成涛,机器学习领域,主攻多样性采样方面的研究,他和导师共同研究使用马尔科夫链进行采样,并且运用数值计算的技术(Gauss Quadrature),极大地提升了采样效率。

吴昊,数据挖掘领域,主攻利用数据挖掘、机器学习与深度学习解决轨迹序列建模以及预测问题。其研究的方法在地图大数据轨迹挖掘、地图新路径挖掘,以及基于大数据人流分析具有非常重要的意义。

朱鎔,数据挖掘领域,主攻多层图的挖掘算法, 包括 Top-K 可靠搜索,SimRank 相似性,Top-K 稠密子图挖掘等问题。目前发表一作的顶级期刊和会议文章五篇(TKDE/KAIS/ICDE/ICDM)。

AI 科技评论了解到,本次的初选评选标准主要参考选手们的学术成绩,包括在国际顶级学术会议和期刊上的总发文数,以及一作和非一作的的各自占比。以上这些选手能够脱颖而出,除了学术成绩不俗、答辩环节征服评委外,最最重要的还有他们研究成果的工程转化能力。这一点在颁奖现场也得到了百度技术委员会主席吴华教授的认可。「相比往届的百度奖学金获奖选手们,这届百度奖学金的选手更注重把研究与实际应用场景相结合,并取得了优秀的成绩。我们希望,这些顶尖的人才能够在未来继续用他们的科研成果去推动人工智能的进步。」百度技术委员会主席,同时担任本次奖学金评审组组长吴华教授在颁奖现场如是说。

颁奖典礼结束后,为了能使大家更直接地感受获奖选手的学术风采。活动方邀请了三位获奖者林衍凯、李成涛、王云鹤进行了简要的学术分享,同时也邀请了两位往届获奖者李纪为、黄岩前来为「新秀们」助阵。他们五位学术青年共同为大家分享了目前对话系统、深度学习与知识图谱等领域的最新研究成果。

第一位分享的嘉宾是斯坦福毕业生李纪为,分享主题是:教会机器谈话。

大家好,很开心今天能回到这里,再次重新回到百度,我觉得非常开心!以前是做对话的,今天就为大家分享我一两年前的工作。教会机器像人类一样交谈,需要解决两个问题。一个是如何让机器产生比较有意思并且有信息的内容。另一个是如何保持机器具有一致性,让它说话不自相矛盾。

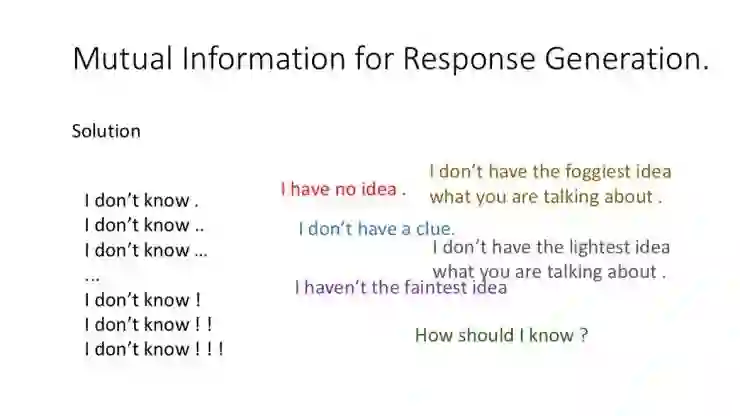

之前的这个模型,由于训练数据集里有很多无聊的回复,结果就是模型每次都会产生这种无聊的对话,比如说「我不知道」,「呵呵」之类的。但是光禁止机器回答这类无聊的问题是不够的,机器还会产生同类,同样意思的其他语句变种,例如下面这张图。

所以要解决这个问题首先要通过人对机器之前说的话,来猜到机器的回复是什么。机器通过人回复的话,来猜到人之前问的话是什么。

第二个问题如何让机器对话保持一致性,大家的想法是让每一个人用一个向量来代替,所以当你问一个人一百个问题的时候,他会用同一个向量做抵扣。也就是说它会用同一个向量来去让这一百个问题的回答产生一致。

第二位分享嘉宾是林衍凯,分享主题是:知识表示与知识提取。

我是做偏知识图谱方向的,前两年主要在做知识的表示还有它的抽取。知识图谱,可能大家比较熟悉,就是把一些实体关系组成一个图谱。今天主要介绍两方面,第一方面是知识表示,第二方面是知识获取。

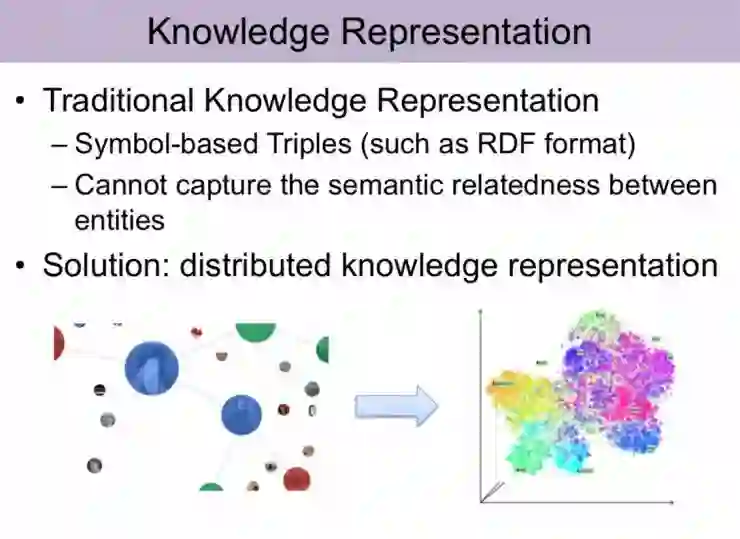

知识表示其实就是将知识图谱里面的实体对应为一个空间中的向量,传统的知识图谱是以一种三元组形式去展现的,现有知识表示方法在模型复杂度较小的情况下,效果是非常好的。我们主要工作有两点,就是去解决现知识表示方法存在的一些问题。第一个它无法去对知识图谱中的复杂关系进行建模。第二个,它无法针对知识图谱内部的关系路径去做建模。

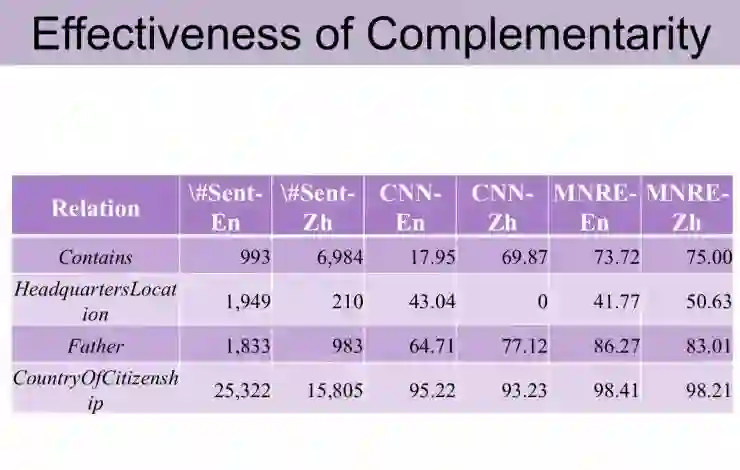

第二部分工作是关于知识抽取。我主要做的是文本关系抽取方面的工作。我们提出了多元的关系抽取系统,无论是在中文数据下或者在英文数据下,它抽取效果都比原始的有了非常大的提高。

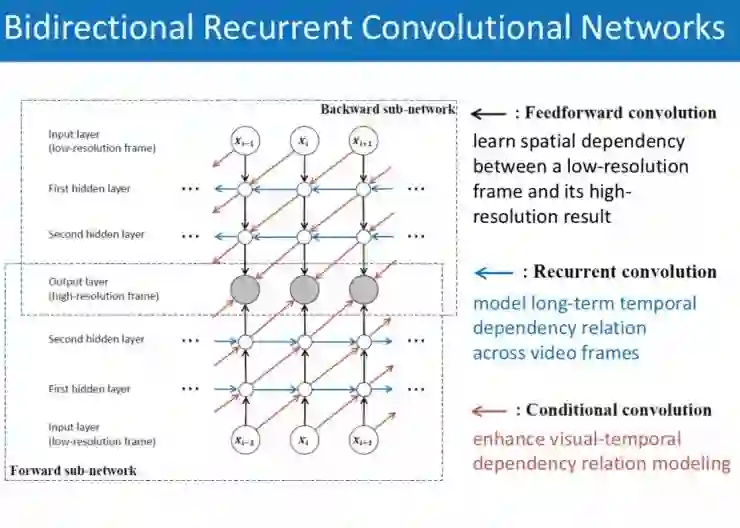

第三位分享嘉宾是黄岩,分享主题为:用双向循环神经网络处理超分辨率视频。

再来介绍一下循环卷积网络,它其实是一个全卷积的循环网络。以上图为例,对于传统的全连接深度神经网络,把它进行全卷积化,即把所有的全连接都替换成卷积操作,就得到我们经常使用的卷积网络。沿着时间方向展开,深度神经网络就变成一个循环网络。而我所介绍的循环卷积网络本质上是一个全卷积的循环网络。这种网络在参数量上有巨大优势,传统循环网络的参数量大概是在百万甚至千万左右,循环卷积网络基本上只有一两万左右,因此测试速度会得极大的提升。

应用循环卷积网络到视频超分辨率上,可以在保持视觉内容空间结构信息的同时极大提升模型的测试速度,并且卷积操作使得我们可以处理任意尺度的视频帧。

第四位分享嘉宾为李成涛,分享主题是 :关于多样性采样相关的理论、实践及应用。

我的研究主要是关于多样性采样方面的,具体来讲就是在一个数据集中采样出一些具有代表性的,没有冗余信息的一些样本来代表整个数据集,比如一本书的梗概,一段视频的剪辑等等,简言之就是从大量信息中提取「干货」。

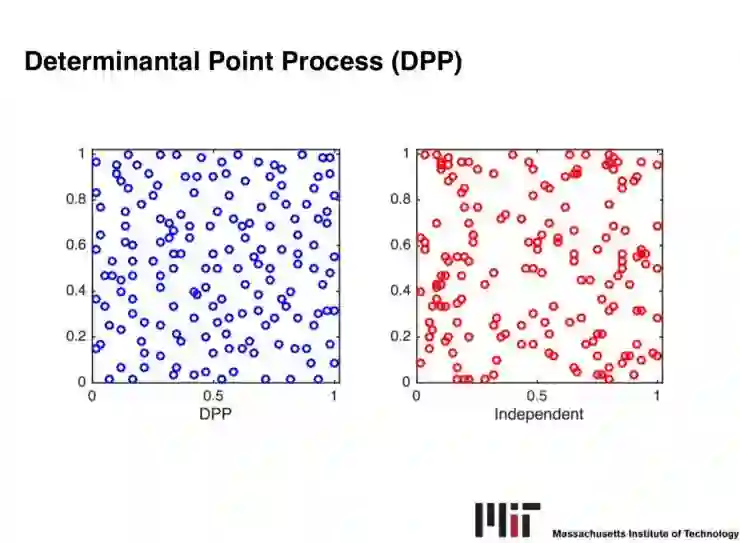

通过多样性采样,我们可以极大地减少处理数据的时间,在很短的时间内获得较多的信息。我之前做过一些多样性采样的理论工作,主要是关于如何提升多样性采样的效率的。比如我们研究的一个比较典型的多样性采样的概率分布,Determinantal Point Process。它的采样过程非常耗时,我和导师研究后通过使用马尔科夫链进行采样,在理论上证明了它的采样效率要高于原本的方法,并且运用数值计算的技术(Gauss Quadrature),极大地提升了采样效率。

多样性采样还是有非常大的应用前景的。现在是一个信息爆炸时代,如何在更短的时间内处理更多的信息一直是一个非常重要的课题。我觉得多样性采样在这里面会充当非常重要的角色。很多我们可能不敢想象的事情,可能都会因为多样性采样儿变成现实,比如一小时看完一本书,一分钟看完一部电影电影等等。

最后一位分享嘉宾是王云鹤,分享主题为:关于深度神经网络的压缩方面的研究。

我在神经网络加速压缩方面做了深入研究,提出利用离散余弦变换将卷积神经网络预测过程中的卷积计算从空间域转换为频率域,在准确度只有轻微下降的前提下,预测速度大幅度提升、模型消耗的存储大幅度降低。该方法极具创新性和实用性。

深度卷积神经网络压缩这个课题非常具有应用前景,因为深度学习模型在大多数任务(例如图像识别、图像超分辨率等)上的精度已经达到了落地需求,但是它们的线上速度和内存消耗还没有达到落地需求。

然而,越来越多的实际应用需要用到这些深度学习模型,例如手机、智能摄像头、无人车等。所以如何设计更轻便、更高精度的深度神经网络仍旧是一个亟需解决的问题。

————— 新人福利 —————

关注AI 科技评论,回复 1 获取

【数百 G 神经网络 / AI / 大数据资源,教程,论文】

————— AI 科技评论招人了 —————

AI 科技评论期待你的加入,和我们一起见证未来!

现诚招学术编辑、学术兼职、学术外翻

详情请点击招聘启事

————— 给爱学习的你的福利 —————

AI科技评论年度巨献

扫码或点击阅读原文

特辑限时早鸟优惠中

▼▼▼

————————————————————