CVPR2019 | 牛津大学提出端到端传感器VIO融合方案

点击上方“计算机视觉life”,选择“星标”

快速获得最新干货

论文地址:https://arxiv.org/abs/1903.01534

代码:https://github.com/changhao-chen/selective_sensor_fusion.git(即将开源)

来源:牛津大学

论文名称:Selective Sensor Fusion for Neural Visual-Inertial Odometry

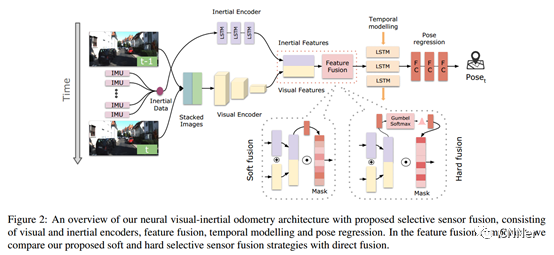

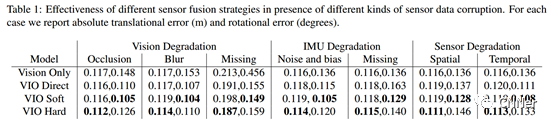

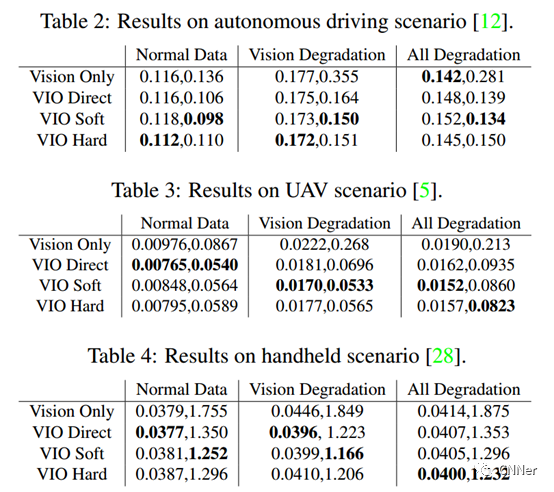

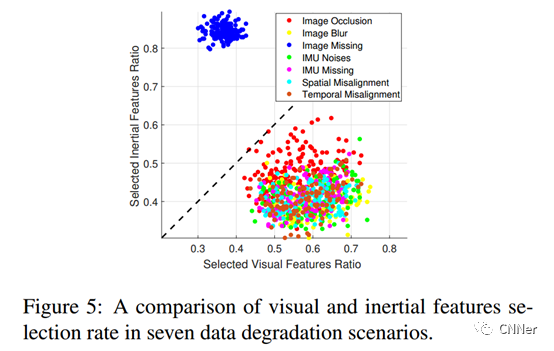

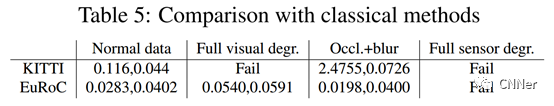

原文作者:Changhao Chen

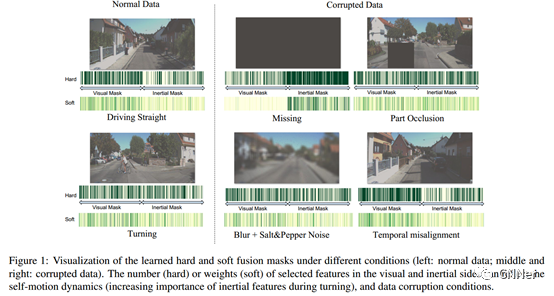

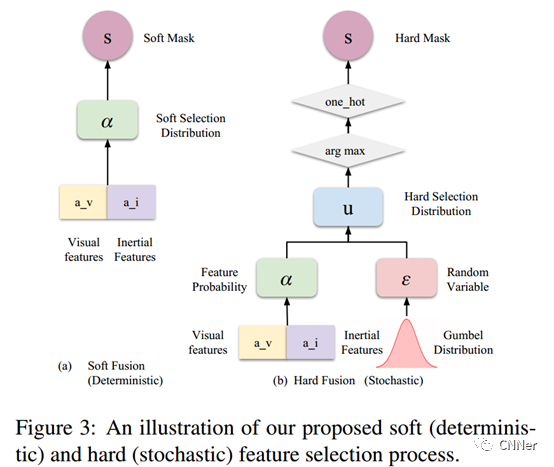

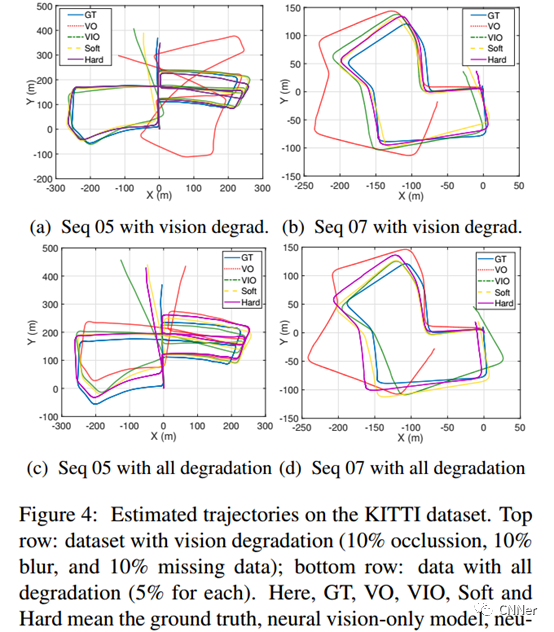

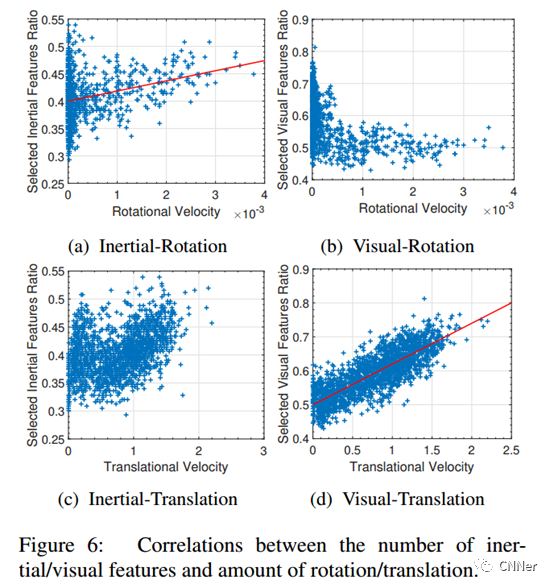

视觉惯性里程计(VIO)的深度学习方法已经被证明是成功的,但它们很少专注于整合稳健的融合策略来处理不完善的输入感觉数据。本文提出了一种新颖的端对端选择性传感器融合框架,用于单目VIO,融合单目图像和IMU,以此来估计轨迹,同时提高对实际问题的鲁棒性,如数据丢失和损坏或传感器同步不良。特别地,本文提出了两种基于不同掩蔽策略的融合模式:确定软性融合和随机硬融合,并与以前提出的直接融合基线进行比较。在测试期间,网络能够有选择地处理可用传感器模式的特征,并且在一定比例上产生轨迹。我们对公共自动驾驶,微型飞行器(MAV)和手持VIO数据集的性能进行了深入调查。结果证明了特别是在存在损坏的数据的情况下,融合策略比直接融合具有更好的性能。此外,本文通过可视化不同场景中的掩蔽层和不同的数据损坏来研究融合网络的可解释性,揭示了融合网络与不完美的传感输入数据之间的有趣相关性。

下面是论文具体框架结构以及实验结果:

声明:文章来自于网络,仅用于学习分享,版权归原作者所有,侵权请加上文微信联系删除。

从0到1学习SLAM,戳↓

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

投稿、合作也欢迎联系:simiter@126.com

长按关注计算机视觉life

PS:公众号最近更改了推送规则,不再按时间顺序推送,而是根据智能推荐算法有选择性向用户推送,有可能以后你无法看到计算机视觉life的文章推送了。

解决方法是看完文章后,顺手点下文末右下角的“在看” ,系统会认为我们的文章合你口味,以后发文章就会第一时间推送到你面前的,比心~