ICCV19 NEUARCH Workshop 个人总结

点击上方“CVer”,选择加"星标"或“置顶”

重磅干货,第一时间送达

作者:熊森特

https://zhuanlan.zhihu.com/p/89007308

本文已由作者授权,未经允许,不得二次转载

ICCV'19 NEUARCH workshop 于2019年10月28日召开,其全称是 Neural Architects Workshop: What have we learned and where are we going? 内容上包含了近年在神经网络架构领域上的最新进展。Barret Zoph,Ross Girshick 等(对我)耳熟能详的大牛也给出了精彩的综述性报告。

参加NEUARCH workshop一是出于个人研究兴趣,二是有一篇文章的 poster 要在这里展示。从学习到的内容来看确实是不虚此行。

这篇文章主要是我个人参加这个 workshop 得到的一些心得体会,行文中难免有疏漏之处,请见谅 🙏

Neural Architecture Search and Beyond (Barret Zoph)

这个报告是 NAS 的领军人物 Barret Zoph 个人对 NAS 做的综述,回顾了 NAS 技术发展的 motivation,NAS 的框架和典型应用,NAS 的性能问题以及 NAS 在数据增强问题上的扩展。

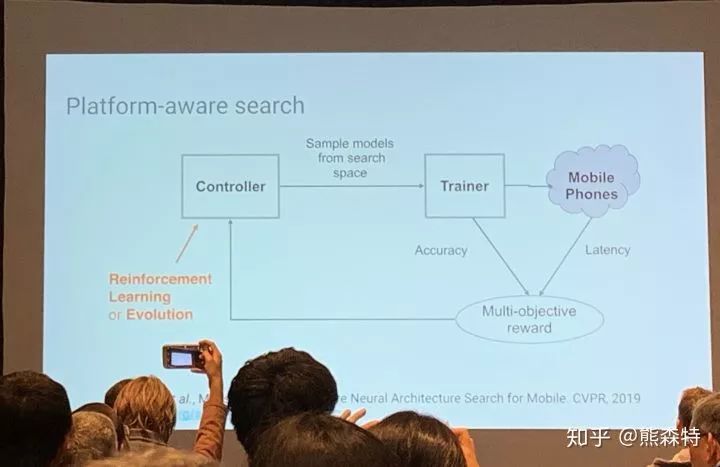

个人感觉比较有趣的是他描述的、用控制器-反馈函数来理解 NAS 设计的视角:控制器可以是 RNN+RL 或者进化算法,反馈函数基于搜索到的网络架构的性能——包括但不限于识别准确度,延迟 (MnasNet),能耗,甚至移动应用安装包的大小(在 MobileNet V3 的设计中提到)——给出进一步搜索的反馈。

(因为 poster session 太累,上午后续的两个 talk 没有仔细听,这里略过了)

Oral Presentation

下午的 session 以三篇 workshop 论文的 oral presentation 开始:

《Understanding the Effects of Pre-Training for Object Detectors via Eigenspectrum》

https://arxiv.org/abs/1909.04021

在听这篇报告时我没有读论文,大意是通过分析 feature map 的 eigenvalue 的分布来理解 object detector 的训练过程,提供了一个与 Rethinking ImageNet Pre-training 不同的视角。

《GCNet: Non-local Networks Meet Squeeze-Excitation Networks and Beyond》

https://arxiv.org/abs/1904.11492

这一篇拿到了 workshop 的 best paper,是对 Non-Local Neural Networks (NLNet)的改进:NLNet 的 attention 机制依经验分析是对 global context 无效的,而使用这篇文章提出的 global context block 既可以有效提取全局信息,又降低了计算成本。

《4-Connected Shift Residual Networks》

https://arxiv.org/abs/1910.09931

这是一篇很有意思的文章:与其使用计算量大的 spatial convolution 来提取 spatial correlation,不如直接在 spatial 维度上做平移、并利用 point-wise convolution 来同时提取 spatial 和 depth correlation。从结果来看,基于 shift 的 ResNet-101 模型的准确度没有多大的损失,但参数量和 FLOP 都有显著下降。

不过现场也有人提问:基于 shift 的 ResNet 的真实运算速度如何?shift 操作虽然相比于卷积减少了很多参数和计算量,但是采用 shift 能否取得真实的加速效果则取决于它的实现能否快过 cuDNN(默认运行环境是GPU)。作者诚恳的表示目前真实运算速度并不快,未来会实现定制的 CUDA kernel。

无独有偶,会议第三天我在 TSM: Temporal Shift Module for Efficient Video Understanding 中也注意到了(沿时域的) shift 操作,作者给出的实现方案是使用 TVM 来编译。不知道这种做法应用在4-shift ResNet 上效果如何?

Capsule Architecture (Sara Sabour)

Sara 介绍了 Capsule Network 在计算机视觉领域的应用,内容上基本涵盖了 Stacked Capsule Autoencoders 的内容。

为什么 capsule 架构对计算机视觉应用有用?Sara 的观点是:capsule 可以 model 物体 part 之间的关系,而这些 part 之间的几何关系是建立 viewpoint-invariant 的 object recognition 模型的关键。对我来说都是很新颖的观点。

From Architecting Networks to Architecting Network Generators (Ross Girshick)

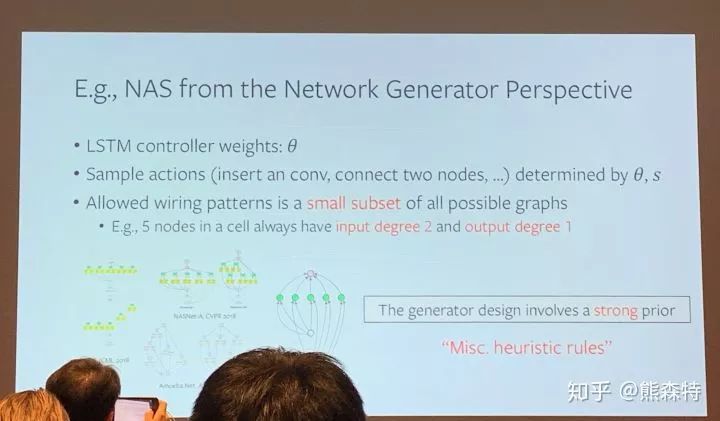

Ross 的 talk 给我的启发是最多的。核心观点是:与其设计单一的网络架构,更重要的是设计网络架构的生成器(generator)。这个想法与 NAS 和 Saining 最新的 Exploring Randomly Wired Neural Networks for Image Recognition 有密切的联系。

首先,Ross 提到,我们在衡量网络性能的时候,已经从 point estimation,即训练评估单一网络架构(如 AlexNet);过渡到 curve estimation,即衡量一组主体架构相同、但调整了深度等参数的网络(如 ResNet)。未来我们可能会倾向于 distribution estimation,即网络生成器可生成的网络的性能的分布。这样做有利于我们通过性能的 landscape 来理解网络架构设计的 通用原则。

网络生成器的形式很简单,本质上是从一组参数 θ 到一个网络架构(计算图)的映射 g(θ)。这个映射可能是 deterministic 或 stochastic 的(g(θ) 的结果是一个概率分布的 sample)。

Randomly wired network 自然是一个 stochastic network generator。它的思想源头可以追溯到早期神经网络设计原则(Turing's Connectionism),ResNet 和 DenseNet 的设计,Connectivity Learning (MaskConnect),以及基于图论的网络设计(Deep Expander Networks)。至于具体 randomly wired network 是如何生成的,在原始的文章中有详细的描述,在这里不加赘述。

在 Q&A 环节,一位听众提出了一个我曾经也很疑惑的问题:一个网络架构之所以表现好,到底是因为它的连接关系上有可以解释的优点,还是因为它只是更容易被优化?Ross 的观点是,这两者其实是密不可分的。这个观点我十分认同:在深度学习理论尚未完善的前提下,将优化视为架构的一部分、优化配置的参数空间视为架构的搜索空间的一部分(参见Neural Optimizer Search with Reinforcement Learning),可能是最为实用稳妥的做法。

结语

神经网络架构在不断的演进,一是随着对特定任务理解的加深,我们可以改善神经网络的建模的方式;二是通过 NAS,或更通用的术语,network generator,在现有的深度学习“理论”的基础上,进一步扩宽网络架构的边界。

对我个人的研究领域来说,最重要的可能是,在设计新的压缩、量化、编译器优化、加速器优化的策略时,要不断检查这种策略是否能经过 curve 乃至 distribution estimation 的考验。

重磅!CVer学术交流群已成立

扫码添加CVer助手,可申请加入CVer-目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪&去雾&去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索等群。一定要备注:研究方向+地点+学校/公司+昵称(如目标检测+上海+上交+卡卡)

▲长按加群

▲长按关注我们

麻烦给我一个在看!