这次,黄仁勋厨房真是假的!英伟达40000帧渲染奇幻厨房

新智元报道

新智元报道

编辑:桃子 小咸鱼

【新智元导读】11月GTC大会上,除了老黄本人,厨房都是假的。从大理石柜台,到新古典主义壁龛烤箱,再到标志性的抹刀花束,没有一件是真的物品。没想到英伟达的技术还是骗过了我们的眼睛。

11月GTC大会上,除了老黄本人,厨房都是假的!

其实他背后真实的数字模型是这样子的:

落日余晖,光与影的变幻。

问题是,你看到的东西没有一个是真的!!!

假亦真时真亦假,你还敢相信自己的眼睛吗?

真CEO,「假」厨房

英伟达官方透露,从10月30日开始,视频团队在英伟达硅谷总部的2间会议室里仅用了4天时间就录下了老黄的全程演讲内容。

通过Omniverse平台,英伟达团队创建了黄仁勋演讲背后的动态虚拟环境——数字厨房。

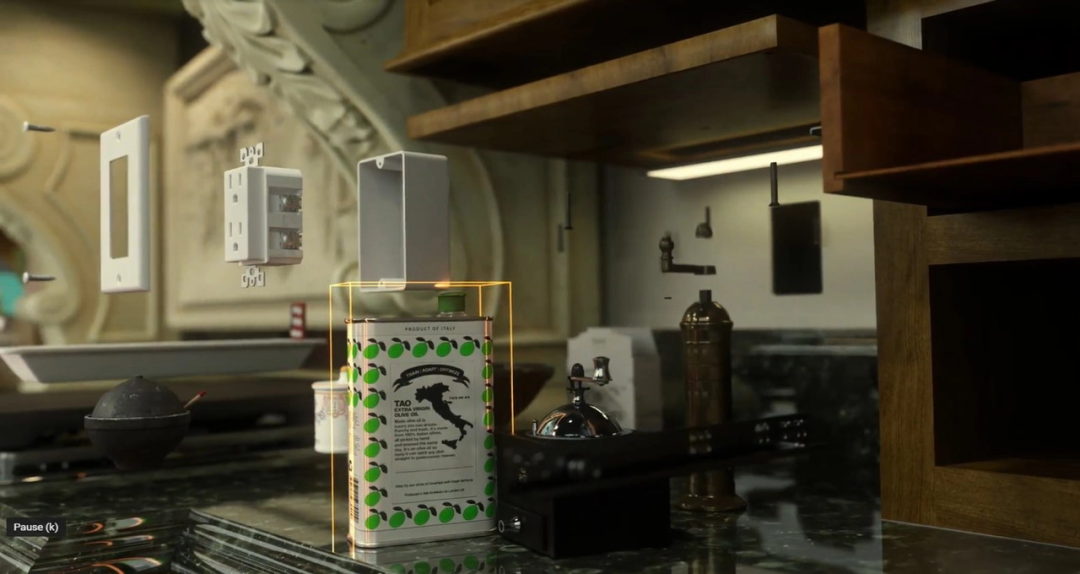

从大理石柜台,到新古典主义壁龛烤箱,再到标志性的抹刀「花束」,黄仁勋厨房成了充满奇幻的地方。

在这个这个「假」厨房里,英伟达还特地加入了一些彩蛋。

比如右下角有一瓶据说是带着自家logo的橄榄油,还有左边的厨具也被换掉了。

仔细观察,老黄肩膀上的光线随着转身也跟着移动,根本无法看出破绽,完美地与虚拟世界相融合。

那么,数字厨房是如何实现的呢?

第一步,英伟达团队拍摄了老黄厨房的高分辨率图像,之后便以此素材作为构建虚拟场景的主要参考。

就像老黄家中的什么橄榄油啊,盐盒品牌,橱柜的螺丝等等,工作人员都是费了很大功夫去研究厨房里所有东西的详细参考资料。

第二步,由8位英伟达艺术家和 10 位自由创作者组成的团队使用Omniverse构建了过场动画。

他们分别在不同软件中制作,最后通过Omniverse Connectors将所有模型和数据整合在一起。

在厨房场景中,一共出现了57个独特3D模型和6240个对象,它们的建模工作都是在Autodesk 3ds Max、Autodesk Maya 和 Pixologic Zbrush中完成的。

8位艺术家们使用 Adobe Substance Painter 和 PS 制作纹理,动画则是在 Maya 中完成的。

最后,团队工作人员使用 Nuke 进行场景合成,而剪辑则使用 DaVinci Resolve 完成。

当然了,后期渲染肯定也是少不了的。

借助Omniverse Farm工具,艺术家团队能够轻松地为 GTC 批量渲染4万帧,总计4TB的内容。

其实,除了老黄的厨房,视频中每次转场的背景也是虚拟环境,包括数据中心和英伟达在硅谷的园区。

这样看来,貌似还真发现了一点破绽。

黄仁勋背后的树叶被风吹的左右飘摇,但他本人的头发丝依旧纹丝不动。

不信?你来仔细鉴别。

(GTC大会:https://www.youtube.com/watch?v=I3QMhJ-Mrb0)

全能Omniverse

大会上,黄仁勋宣布了人工智能Omniverse平台重大更新,其中包括一些令人振奋的新功能。

对于Omniverse平台功能更新共有4个:

Showroom是一个包含演示和示例应用程序,展示了Omniverse核心技术。

Farm一个系统层,用于协调跨多个系统、工作站、服务器和虚拟化批作业处理,可以用于批量渲染,AI合成数据生成或分布式计算。

据介绍,英伟达团队制作虚拟厨房也是为了进一步开发 Omniverse Farm和跨多个团队的 Shot Manager 扩展的机会。

Omniverse AR可以将将图形串流到手机或者AR眼镜。Omniverse VR是英伟达首款全帧交互式光线追踪VR。

Omniverse平台具有很强大的构建虚拟环境的能力,但是,如果觉得用Omniverse只能搭环境,那可真是小看它了。

为了帮助开发者利用Omniverse创建具有「智慧」的虚拟人,Omniverse还开放了一个新功能:Omniverse Avatar。

Omniverse Avatar

Omniverse Avatar汇集了语音AI、计算机视觉、自然语言理解、推荐引擎、Avatar动画和图形等等一系列技术,获得了令人惊叹的效果。

在11月的GTC 2021大会上,黄仁勋重磅发布了可以与人进行流畅交流的虚拟形象Toy-Me,看上去就是一个卡通玩偶版的黄仁勋。

黄仁勋表示,「这个虚拟形象是基于目前训练的最大语言模型的语言处理打造,包括声音也是用我自己的语音进行合成,还可以看到实时基于光线追踪的精美图像。」

这个 Toy-Me 有多厉害?

在演示中,来自不同领域的3位科学家分别让虚拟形象回答有关气候变化、天文学以及生物蛋白质合成等方面的问题,难度还不低。

不过,这个可爱的小CEO回答得行云流水。

由此可见,Omniverse Avatar为快速创建人工智能助手打开了大门,这些虚拟助手几乎可以为任何行业轻松定制。

它们可以帮助人们处理数十亿的日常客户服务互动,包括餐厅订单、银行交易、个人预约和预订等等。

除了Toy-Me,英伟达还基于Omniverse Avatar打造了两个虚拟助手,一个是蛋壳公仔Tokkio,一个是Maxine。

蛋壳公仔Tokkio是一个餐厅客服虚拟助手,能够与顾客交谈并理解他们的意图。

比如,Tokkio可以同时和两个顾客进行交谈并理解他们要点什么。

Tokkio还被集成在了Nvidia Drive Concierge中,可以用语音唤醒,执行一些自然语音命令,比如打电话预订。

司机还可以用它实现自动停车,只用动动嘴皮就好。

而Maxine为虚拟会议和视频内容创作应用提供了最先进的语音转录和音频生成工具。

在演示中,一个女人在嘈杂的咖啡馆里通过视频通话说着英语,但是背景噪音却一点也听不见。

更妙的是,当她说话时,她的语音会被实时转录并翻译成法语、德语、西班牙语和中文,声音和语调都还是她本人的。

这些神奇的功能都要依赖Omniverse Avatar的助力。

她的化身背后,是英伟达的Video2Face、Audio2Face、2D和3D AI驱动的面部动画和渲染技术。

就在4月份的GTC大会,黄仁勋曾以14秒的假身现身演讲。

视频中,随着镜头逐渐拉远,老黄也开始被「分解」,一波特效完成之后,老黄也消失了。

老黄假身进行的数据采样也是通过这几项技术实现。

虚拟人的面部动作只需要导入纯音频后,Audio2Face能根据语音内容自动生成。

还有,Face-Vid2Vid可以让模型看起来更真实。只需一张照片,对应覆盖在CG模型上就可以了得到一个「栩栩如生」的脸了。

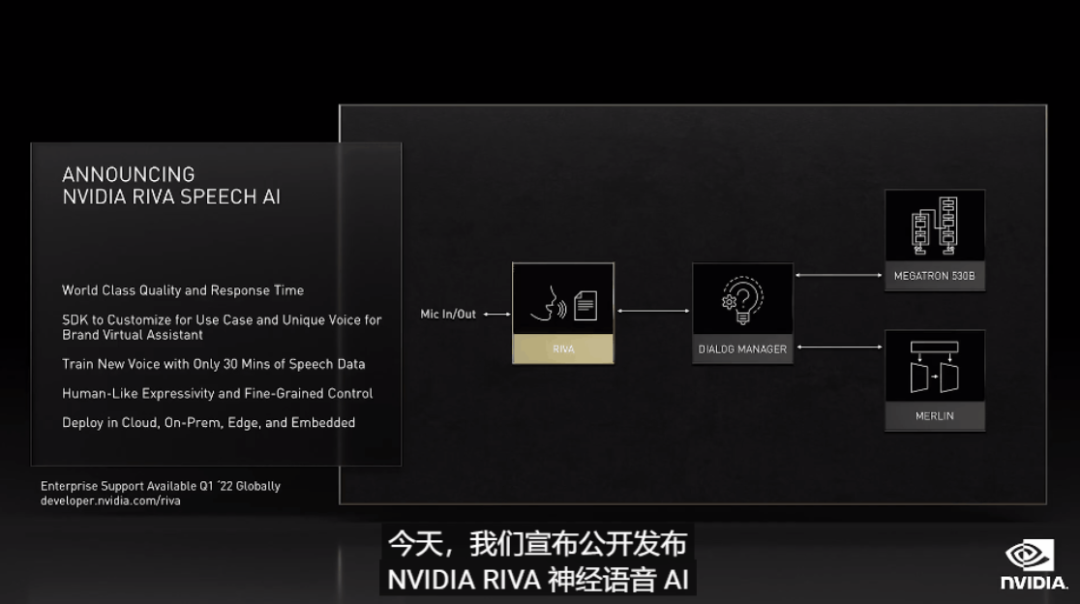

Omniverse Avatar的语音识别基于英伟达Riva,这是一个软件开发工具包,可以识别多种语言的语音。Riva还可以利用文本到语音生成功能生成类似人类的语音。

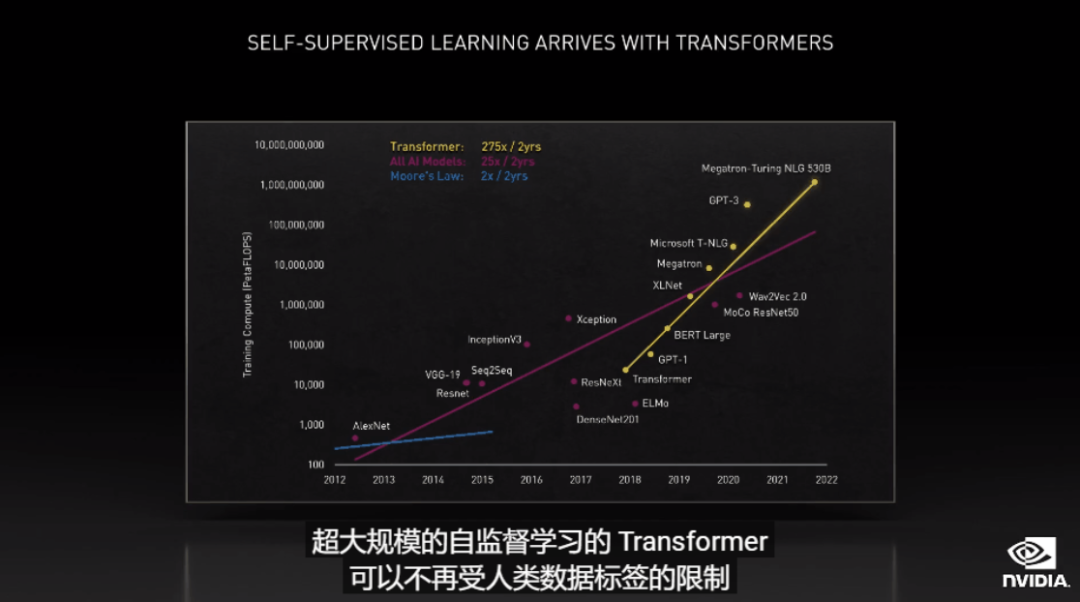

Omniverse Avatar的自然语言理解能力是基于Megatron 530B大型语言模型,可以识别、理解和生成人类语言。

Megatron 530B预训练模型在各种自然语言任务如:完形填空、阅读理解、常识推理、自然语言推理、词义消歧中纷纷实现SOTA。

除了可以回答问题、总结长而复杂的故事,Megatron还可以在没有经过专门训练的领域处理相应的问题。

Omniverse Avatar的推荐引擎由NVIDIA Merlin提供,该框架允许企业建立能够处理大量数据的深度学习推荐系统,以提出更智能的建议。

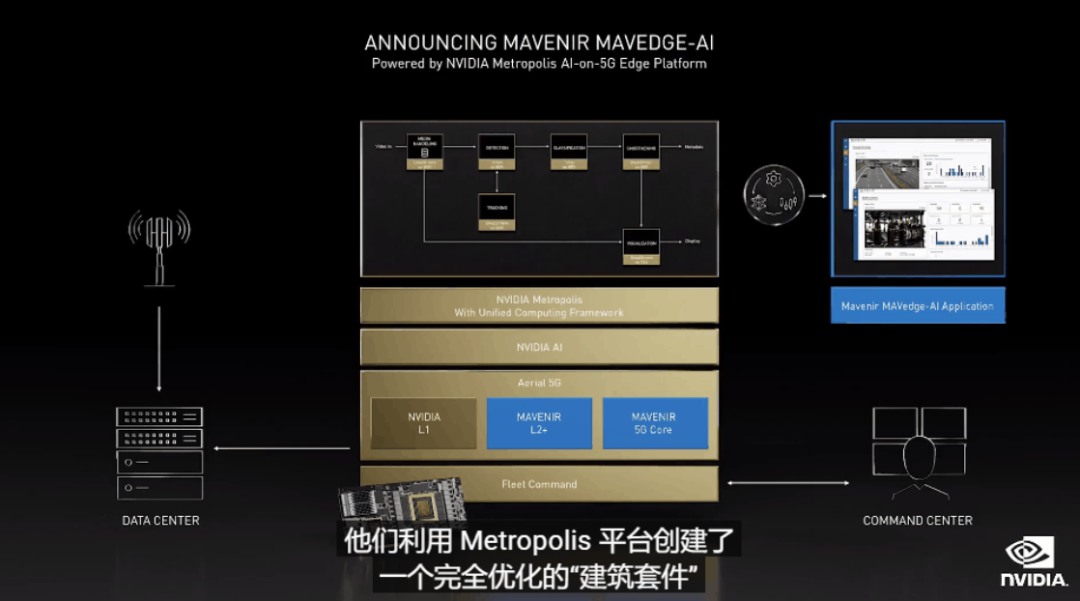

Avatar的感知能力则是由NVIDIA Metropolis提供,这是一个用于视频分析的计算机视觉框架。

所有这些技术都被整合到一个应用程序中,并使用英伟达统一计算框架进行实时处理。

这些技能可以被打包为可扩展、可定制的微服务,并由NVIDIA Fleet Command进行安全地部署、管理和编排。

利用这些工具,英伟达正在谱写一个可以影响数万亿美元的市场的故事,而所有的这些都建立在Omniverse之上。

参考资料:

「哈利波特小魔杖」在家体验幻影移形!大淘宝技术3D建模只需拍一圈