上证信息-文因互联(联合)发布:知识提取在上市公司信息披露中的应用

课题组:上证信息-文因互联(联合)课题组

课题主办人:上海证券交易所信息公司 赵伟 何曾樑

课题承接单位:北京文因互联科技有限公司

文因互联:张强 王丛 李卫东 丁海星 张梦迪 马新磊

上证信息:王辉 赵伟 何曾樑 王海菲 李炜 陈春燕 奚超

信息披露是资本市场的重要组成部分,是资本市场法律法规的核心内容之一,也是对市场参与者权益的有利保障。

以上市公司信息披露为例,随着市场监管的全面深化以及上市公司数量的逐年增长,各类投资者,尤其是中小投资者,面临着海量公告信息处理能力不足的困难。

对海量公告信息制作摘要或提取有意义的结构化信息,一方面可以提高投资者的信息获取能力,同时也为市场监管及企业研究提供了基础数据支持。

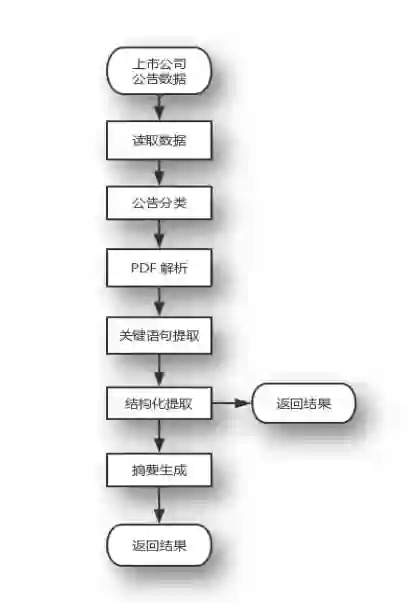

本文介绍了一种用于上市公司信息披露自动摘要的方法,本方法使用深度学习与知识规则的混合算法,首先将文档划分为句子,将句子进行标注后通过LSTM模型训练计算出关键语句,再将输出句子经过规则系统提取,从而得到一篇公告的重要实体与关系,最后重组为摘要。本方法在几类高频、重要的上市公司公告中进行了结构化提取与摘要生成的测试,并取得理想结果。本文认为这种方法可以低成本、可迁移地部分解决公司公告的知识提取问题。

特别鸣谢

上证所信息网络有限公司

文章节选自上海证券交易所与上交所技术出版的《2017证券信息技术研究发展中心研究报告》内部刊物。

(一)研究背景

在我国证券市场上,信息披露是一种法规要求,各种信息披露义务人“应当真实、准确、完整、及时地披露信息”。以上市公司为例,信息披露能够使市场及时掌握公司的运营情况,评估未来盈利水平和风险情况,从而做出投资决策。

上市公司的公告信息披露由各信息披露义务人在指定的信息披露网站发布,主要为PDF格式。以沪市上市公司为例,2016年全年披露了123732篇公告,2017年共158977篇,并且随着上市公司数量的增加这一数字将会逐年增加。每年3月底、4月底、8月底、10月底为定期报告披露高峰期,最多的一天(2017年4月28日)发布了3571篇公告。这不但为证券交易所的合规检查带来了压力,也给投资者带来了极大的信息负载,尤其是对中小投资者。

随着上市公司数量日益增多,将公告以行之有效的方式让阅读者“读薄”的工作刻不容缓,其中通过自然语言处理、知识图谱、深度学习等技术将公告信息结构化提取或许是关键所在。

目前,沪深两所上市公司的信息披露内容中,部分定期公告及临时公告已经利用XBRL技术将信息结构化,其中主要包括公司半年报与年报中的基本信息、股本结构、以及资产负债表、利润表、现金流量表财务报表及附注,这些信息在上市公司撰写公告时,便通过特殊工具进行了采集[1],之后便可以直接将这些信息结构化存储和利用。然而,已经格式化处理的公告仅占全部公告的一部分,加之信息披露的要求逐年变化,对公告信息的完整格式化仍然是个挑战。中小投资者通常使用市场信息供应商来获取信息,而这些信息供应商由于关注点的不同,所提供的数据在时效性、完整性、准确性上,也有很大的提升空间。

上市公司信息披露的种类繁多,如上交所将上市公司公告分为35大类,376个小类(上海证券交易所,2013)。目前上海证券交易所制作并免费对市场发布部分公告的摘要信息,但由于制作维护成本较高,不易扩展,并难以应对公告数量的井喷。

本项工作的初始目的是为了上交所的公告制作小组提供合适的自动化处理工具,减轻公告高峰期的运行压力,降低人工采编风险,控制可能增加的成本;在此基础上,考虑为周边系统甚至公众提供通用的公告自动抽取服务。

本项工作通过LSTM深度学习网络,首先将不同类别公告的关键语句抽取出来,抽取过程仅需公告制作小组业务专家对少量公告进行标注,期间通过Dropout等方法提供模型泛化能力。关键语句抽取后,再通过规则方法进行细粒度提取,从而将公告结构化。结构化提取与摘要生成是知识提取的两种展示形式,本工作在9类高频公告中分别对两者进行了充分测试,均取得了较为理想的结果。

研究重点和难点

本项目的初始设计目的是为了公告制作小组提供高质量的自动化处理工具。面对公告摘要这特殊类型文本,公告制作小组制定了较高的准确性要求,以至于传统(新闻)文本摘要无法完全满足准确率需要。本课题需要探索深度学习与知识提取的结合,以平衡开发成本与准确率的矛盾。这项工作的探索不仅为扩展更多公告类型奠定基础,也为其他类型文本处理带来宝贵经验。

对于不同格式的文档,文本的获取是第一步。PDF格式是目前信息披露的法定格式。PDF解析是解决公告分析的前提条件,而由于PDF转换过程中所带来的信息丢失,噪音干扰,段落结构破坏,表格结构破坏会严重影响后续分析,于是PDF解析是本课题第一个难点。对于可获取的其他格式文本,如Word或TXT,内容获取较易,没有加以特别对待;而对部分由图片转换的PDF,由于涉及到图像识别等其他专项技术,未在本项工作中加以覆盖。

深度学习模型需要平衡模型的准确率和泛化能力,同样不能采用过于复杂的模型降低运算速度,所以深度学习模型的合理搭建是第二个难点。

事件提取是信息提取研究中最具有挑战性的任务之一,如何能够在保证泛化能力的情况下更准确的进行事件元素信息的提取是第三个难点。

最后的难点是深度学习模型与知识提取的混合工程架构,要考虑如何能更快让开发人员扩展,非常考验工程设计者的架构能力。

(二)预备知识

2.1 自动文本摘要任务

文本摘要(Document/TextSummarization)是自然语言处理(NLP,NaturalLanguage Processing)中的一个比较难的问题。

按照不同的数据源,可以大致分为1)新闻摘要,2)一般论文摘要,3)综述论文摘要等几个类型。

新闻摘要要求编辑能够从新闻事件中提取出最关键的信息点,然后重新组织语言进行描述。

一般论文的摘要要求作者先表述清楚问题,对前人工作中不完善的地方进行总结,然后用更凝练的语言描述自己的工作。

综述性质的论文要求作者通读大量相关领域的工作,用最概括性的语言将每份工作的贡献、创新点写出来,并对每份工作的优缺点进行比较。

自动文本摘要是指“一段从一份或多份文本中提取出来的文字,它包含了原文本中的重要信息,其长度不超过或远少于原文本的一半。自动文本摘要旨在通过机器自动输出简洁、流畅、保留关键信息的摘要”(Radev,Hovy,McKeown,2002)。

本质上,文本摘要是一种信息过滤,输出的文本比输入的文本少很多,但却包含了主要的信息,有点类似主成分分析(PCA)。从某种意义上,文本摘要与推荐系统的功能类似,都是为了提取出用户感兴趣的内容,只是使用的方法有很大不同。

按照文档数量,文本摘要可以分为单文档摘要与多文档摘要,前者是后者的基础,但后者不只是前者结果的简单叠加。前者经常应用于新闻信息的过滤,而后者,在搜索引擎中有很大的潜力,难度也随之加大。在单文档摘要系统中,一般都采取基于抽取的方法。

而对于多文档而言,由于在同一个主题中的不同文档中不可避免地存在信息交叠和信息差异,因此如何避免信息冗余,同时反映出来自不同文档的信息差异是多文档文摘中的首要目标,而要实现这个目标通常以为着要在句子层以下做工作,如对句子进行压缩,合并,切分等。另外,单文档的输出句子一般是按照句子在原文中出现的顺序排列,而在多文档摘要中,大多采用时间顺序排列句子,如何准确的得到每个句子的时间信息,也是多文档摘要需要解决的一个问题。

本课题根据业务需要,主要聚焦在单文档摘要的处理上。针对单个文档,对其中的内容进行抽取,并针对用户或者应用需求,将文中最重要的内容以压缩的形式呈现给用户。常见的单文档摘要技术包括基于特征的方法(文档摘要中常用的文章特征包括词频、特定段落、段落的特定句子等)、基于词汇链的方法和基于图排序的方法。

自动文本摘要有非常多的应用场景,如自动报告生成、新闻标题生成、搜索结果预览等。此外,自动文本摘要也可以为下游任务提供支持。尽管对自动文本摘要有庞大的需求,这个领域的发展却比较缓慢。对计算机而言,生成摘要是一件很有挑战性的任务,要求计算机在阅读原文本后理解其内容,并根据轻重缓急对内容进行取舍,裁剪和拼接内容,最后生成流畅的短文本。因此,自动文本摘要需要依靠自然语言处理/理解的相关理论,是近几年来的重要研究方向之一。

自动文本摘要通常可分为两类,分别是抽取式(Extractive)和生成式(Abstractive)。抽取式摘要判断原文本中重要的句子,抽取这些句子成为一篇摘要。

而生成式方法则应用先进的自然语言处理的算法,通过转述、同义替换、句子缩写等技术,生成更凝练简洁的摘要。比起抽取式,生成式更接近人进行摘要的过程。历史上,抽取式的效果通常优于生成式。伴随深度神经网络的兴起和研究,基于神经网络的生成式文本摘要得到快速发展,并取得了不错的成绩。

一般来说,自动文摘过程包括三个基本步骤:

1.文本分析过程:对原文进行分析处理,识别出冗余信息;

2.文本内容的选取和泛化过程:从文档中辨认重要信息,通过摘录或概括的方法压缩文本,或者通过计算分析的方法形成文摘表示;

3.文摘的转换和生成过程:实现对原文内容的重组或者根据内部表示生成文摘,并确保文摘的连贯性

文摘的输出形式依据文摘的用途和用户需求确定。不同的系统所采用的具体实现方法不同,因此在不同的系统中,上述几个模块所处理的问题和采用的方法也有所差异。

2.2 摘要评估

评估一篇摘要的质量是一件比较困难的任务,“一千个读者,有一千个哈姆雷特”,对于一篇摘要而言,很难说有标准答案。不同的人理解一篇文档会有很大的不同,基于人工评价的方法有类似于评价开放的文科辨析题目答案一样,需要从答案中寻找一些所谓的要点,计算要点的覆盖率,打分。

人工评价结果在很大程度上都是可信的,因为人可以推理、复述并使用世界知识将具有类似意思但形式不同的文本单元关联起来,更加灵活,但是时间成本高,效率低。

不同于很多拥有客观评判标准的任务,摘要的评判一定程度上依赖主观判断。即使在摘要任务中,有关于语法正确性、语言流畅性、关键信息完整度等标准,每个人对摘要的优劣都有自己的准绳。

自上世纪九十年代末开始,一些会议或组织开始致力于制定摘要评价的标准,他们也会参与评价一些自动文本摘要。比较著名的会议或组织包括SUMMAC,DUC(DocumentUnderstanding Conference),TAC(TextAnalysis Conference)等。

目前,评估自动文本摘要质量主要有两种分类方法。

第一种分类:人工评价方法和自动评价方法。这两类评价方法都需要完成以下三点:

决定原始文本最重要的、需要保留的部分;

在自动文本摘要中识别出1中的部分;

基于语法和连贯性(Coherence)评价摘要的可读性(Readability)。

评估一篇摘要的好坏,最简单的方法就是邀请若干专家根据标准进行人工评定。这种方法比较接近人的阅读感受,但是耗时耗力,无法用于对大规模自动文本摘要数据的评价,和自动文本摘要的应用场景并不符合。因此,文本摘要研究团队积极地研究自动评价方法。为了更高效地评估自动文本摘要,可以选定一个或若干指标(Metrics),基于这些指标比较生成的摘要和参考摘要(人工撰写,被认为是正确的摘要)进行自动评价。

第二种分类文摘自动评估方法大致分为两类:内部评价方法和外部评价方法。

一类称作内部评价方法,与文摘系统的目的相关,它通过直接分析摘要的质量来评价文摘系统;第二类称作外部评价方法,它是一种间接的评价方法,与系统的功能相对应,将文摘应用于某一个特定的任务中,根据摘要功能对特定任务的效果来评价自动文摘系统的性能,如对于信息检索任务而言,可以对比采用摘要进行检索与采用原文进行检索的准确率差异,通过文摘对检索系统的效果来评价文摘系统的性能。

内部评价方法按信息的覆盖面和正确率来评价文摘的质量,一般采用将系统结果与“理想摘要”相比较的方法。这种评价方法来源于信息抽取技术。在信息抽取评测中,将原文的关键要点抽取出来,然后与人工抽取的内容相比较,计算其召回率,准确率,冗余率和偏差率等几个指标。这种内部评价方法存在的主要困难是“理想摘要”的获得问题。

本课题研究中,公告信息披露这一问题场景对摘要信息的准确性有严格要求,生成式摘要技术不适用于本场景,本文主要介绍基于关键句选取、信息抽取和摘要模板生成式自动文本摘要。

2.3 LSTM序列标注模型

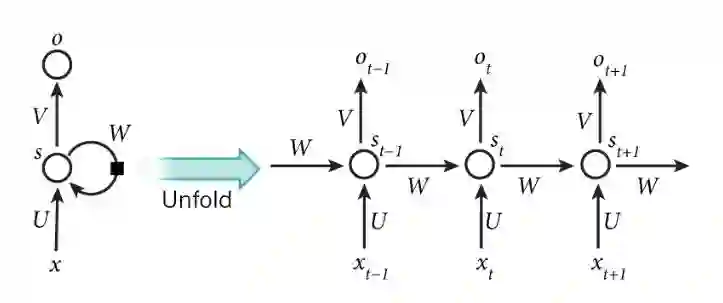

在自然语言理解中,一句话的前后顺序有着极其重要的语义信息,所以研究者在处理文本应用中大多采用 LSTM 模型。LSTM 模型是一种特殊的循环神经网络(Recurrent Neural Network,RNN) 。RNN(Graves,2012)适合解决时间序列的输入输出问题,而自然语言恰好是一个序列标注问题,在传统神经网络模型中,是从输入层到隐含层再到输出层,层与层之间是全连接的,每层之间的节点是无连接的。但是这种普通的神经网络对于很多问题却无能无力。例如,在之前的语言模型的例子中,要预测句子的下一个单词是什么,一般需要用到前面的单词,而一个句子中前后单词并不是独立的。RNN已经被在实践中证明对NLP是非常成功的。如词向量表达、语句合法性检查、词性标注等。

下图便可以直观的理解RNN网络结构:

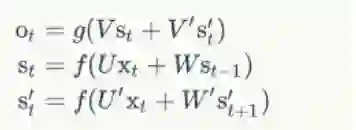

可以把x理解为自然语言句子中逐个单词的词向量,其中隐藏层St=f(Uxt+Wst−1),Wst-1便是前一个单词所携带的语义信息。由于每一层的St都会向后一直传递,所以理论上St能够捕获到前面每一层发生的事情。然而随着层数加深,RNN最终会计算成W的连乘积形式,如果初始梯度过大或过小,便会导致连乘积很大或趋近于0,进而无法有效学习,也就是梯度爆炸和梯度消失。

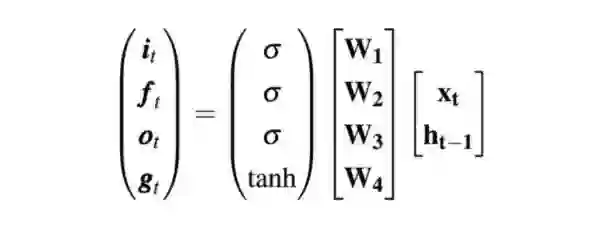

长短期记忆网络(Long Short-Term Memory,LSTM)是一种 RNN 特殊的类型,通过学习长期依赖信来避梯度爆炸和梯度消失问题。所有RNN 都具有一种循环神经网络模块的链式的形式。在标准的 RNN 中,这个循环模块只有一个非常简单的结构,例如一个 tanh 层。LSTM同样具有这样的循环模块,但更复杂,其核心是记忆单元(memory cell)。记忆单元在每一步里记住相关信息并忘掉无关信息。这样,重要的相关信息可以一直留存,从而其梯度不会变的太小。形式上来看,记忆单元可以用以下两个公式来定义:

ct = ft ⊙ ct−1 + it ⊙ gt (1)

ht = ot ⊙ tanh(ct ) (2)

其中⊙ 是Hadamard乘积,在上面公式里表示对两个向量里相同维度分别相乘的到一个新向量。

公式(1)是说,当前的记忆单元 ct 的状态是以下两个因素之和:

上一步的记忆单元 ct −1 ,其权重为 ft (遗忘门forget gate的当前状态)

新信息 gt ,其权重为 it (输入门,input gate的当前状态)

遗忘门控制有多少上一步的记忆单元信息流入当前记忆单元,而输入门控制有多少新信息流入当前的记忆单元。

公式(2)是说当前的隐层状态 ht 是从当前记忆单元得到的,其又由输出门(output gate)ot 来控制。LSTM的循环模块里的输入门 it 、遗忘门 ft 、输出门 ot ,以及需要新输入的信息 gt 可以用以下公式简洁地表示:

在序列问题中,不仅仅是上文对当前词有影响,下文也是,也就发展出了双向LSTM(Bidirectional Long Short-Term Memory),即正向LSTM捕获了上文的特征信息,而反向LSTM捕获了下文的特征信息,通常情况下双向LSTM的表现都会比单向LSTM要好。

2.4 命名实体识别

命名实体识别是信息提取、问答系统、句法分析、机器翻译、面向Semantic Web的元数据标注等应用领域的重要基础工具,在自然语言处理技术走向实用化的过程中占有重要地位。一般来说,命名实体识别的任务就是识别出待处理文本中三大类(实体类、时间类和数字类)、七小类(人名、机构名、地名、时间、日期、货币和百分比)命名实体。

命名实体大多数具有以下的特点:

各类命名实体的数量众多:根据对人民日报1998年1月的语料库(共计2,305,896字)进行的统计,共有人名19,965个,而这些人名大多属于未登录词。

命名实体的构成规律复杂:例如由于人名的构成规则各异,中文人名识别又可以细分为中国人名识别、日本人名识别和音译人名识别等;此外机构名的组成方式也最为复杂,机构名的种类繁多,各有独特的命名方式,用词也相当广泛,只有结尾用词相对集中。

嵌套情况复杂:一个命名实体经常和一些词组合成一个嵌套的命名实体,人名中嵌套着地名,地名中也经常嵌套着人名。嵌套的现象在机构名中最为明显,机构名不仅嵌套了大量的地名,而且还嵌套了相当数量的机构名。互相嵌套的现象大大制约了复杂命名实体的识别,也注定了各类命名实体的识别并不是孤立的,而是互相交织在一起的。

长度不确定:与其他类型的命名实体相比,长度和边界难以确定使得机构名更难识别。中国人名一般二至三字,最多不过四字,常用地名也多为二至四字。但是机构名长度变化范围极大,少到只有两个字的简称,多达几十字的全称。在实际语料中,由十个以上词构成的机构名占了相当一部分比例。

英语中的命名实体具有比较明显的形式标志(即实体中的每个词的第一个字母要大写),所以实体边界识别相对容易,任务的重点是确定实体的类别。和英语相比,汉语命名实体识别任务更加复杂,而且相对于实体类别标注子任务,实体边界的识别更加困难。

命名实体识别由3个问题组成:1.识别出文本中的命名实体;2.确定该实体的类型;3.对于多个实体表示同一事物时,选择其中的一个实体作为该组实体的代表。主要有如下的几种方法进行处理。

2.5 基于规则和词典的方法

基于规则的方法,多采用语言学专家手工构造规则模板,选用特征包括统计信息、标点符号、关键字、指示词和方向词、位置词(如尾字)、中心词等方法,以模式和字符串相匹配为主要手段,这类系统大多依赖于知识库和词典的建立。

基于规则和词典的方法是命名实体识别中最早使用的方法,一般而言,当提取的规则能比较精确地反映语言现象时,基于规则的方法性能要优于基于统计的方法。但是这些规则往往依赖于具体语言、领域和文本风格,编制过程耗时且难以涵盖所有的语言现象,容易产生错误,系统可移植性不好,对于不同的系统需要语言学专家重新书写规则。基于规则的方法的另外一个缺点是代价大,存在系统建设周期长、移植性差而且需要建立不同领域知识库作为辅助以提高系统识别能力等问题。

2.6 基于统计的方法

基于统计机器学习的方法主要包括:隐马尔可夫模型(HiddenMarkovMode,HMM)、最大熵(MaxmiumEntropy,ME)、支持向量机(Support VectorMachine,SVM)、条件随机场(ConditionalRandom Fields,CRF)等。

在这4种学习方法中,最大熵模型结构紧凑,具有较好的通用性,主要缺点是训练时间复杂性非常高,有时甚至导致训练代价难以承受,另外由于需要明确的归一化计算,导致开销比较大。而条件随机场为命名实体识别提供了一个特征灵活、

全局最优的标注框架,但同时存在收敛速度慢、训练时间长的问题。一般说来,最大熵和支持向量机在正确率上要比隐马尔可夫模型高一些,但是隐马尔可夫模型在训练和识别时的速度要快一些,主要是由于在利用Viterbi算法求解命名实体类别序列的效率较高。隐马尔可夫模型更适用于一些对实时性有要求以及像信息检索这样需要处理大量文本的应用,如短文本命名实体识别。

基于统计的方法对特征选取要求较高,需要从文本中选择对该项任务有影响的各种特征,并将这些特征加入到特征向量中。依据特定命名实体识别所面临的主要困难和所表现出的特性,考虑选择能有效反映该类实体特性的特征集合。主要做法是通过对训练语料所包含的语言信息进行统计和分析,从训练语料中挖掘出特征。有关特征可以分为具体的单词特征、上下文特征、词典及词性特征、停用词特征、核心词特征以及语义特征等。

基于统计的方法对语料库的依赖也比较大,而可以用来建设和评估命名实体识别系统的大规模通用语料库又比较少。

2.7 混合方法

自然语言处理并不完全是一个随机过程,单独使用基于统计的方法使状态搜索空间非常庞大,必须借助规则知识提前进行过滤修剪处理。目前几乎没有单纯使用统计模型而不使用规则知识的命名实体识别系统,在很多情况下是使用混合方法:

统计学习方法之间或内部层叠融合。

规则、词典和机器学习方法之间的融合,其核心是融合方法技术。

在基于统计的学习方法中引入部分规则,将机器学习和人工知识结合起来。

将各类模型、算法结合起来,将前一级模型的结果作为下一级的训练数据,并用这些训练数据对模型进行训练,得到下一级模型。

这种方法在具体实现过程中需要考虑怎样高效地将两种方法结合起来,采用什么样的融合技术。由于命名实体识别在很大程度上依赖于分类技术。

2.8 知识提取

知识提取(KnowledgeExtraction)研究如何根据给定本体从无语义标注的信息中识别并抽取与本体匹配的事实知识。该技术既可以抽取出事实知识用于构建基于知识的服务,也能够为语义 Web 的实现提供必要的语义内容。因此知识抽取技术对于充分利用现有数据是非常必要的。

知识提取按照数据源类型可分类两类。

结构化提取:在已经结构化的数据集中,如在Freebase、Wikidata等知识库中进行近一步的实体分类或关联挖掘,通常采用本体推理的方法实现。

非结构化(半结构化)提取:数据以纯文本或者少量结构信息(如表格)的形式展现,需要提取关键实体(如人名,公司名),以及实体间关系(如张三-就职-A公司)。由于公告信息均是PDF文本信息,部分附带表格,故属于第二类。此类工作,一般通过NLP的句法分析,专家领域词表,正则系统,以及前沿的深度学习网络混合构建实现。

对非结构化文档的知识抽取:由于非结构化文档数据丰富,对该类文档的知识抽取一直是知识抽取领域的研究重点。这类文档具有一定的模式,因此可以利用信息抽取(Information Extraction, IE)技术抽取其中的知识(或信息)。

按照应用领域又可划分为通用领域知识提取与专业领域知识提取。前者通常在海量文本中进行自动挖掘,实体识别被抽象为序列标注问题(Sequence Labelling),其中CRF算法(条件随机场)被证明比较稳定有效。它结合了最大熵与隐马尔科夫模型的特点,是一种无向图模型,它将句子(也就是词序列)的每个词打上一个标记,一般在词的左右开一个小窗口,根据窗口里面的词和待标注词语来实现实体提取,最后通过特征组合决定归为哪类实体。

在最近的研究中(Huang,Xu,Yu,2015),又探索出通过DNN(深度神经网络)的方法,以及将CRF与LSTM结合的BILSTM-CRF算法,准确率与召回率会有小许提高。实体关系的抽取传统采用依存关系分析的方法(Dependency Parsing),也就是句子的语法树分析,它将句子进行词性标注(POSTagging),实体识别,构建语法树,便自然构成了SPO(Subject-Predicate-Object)的三元组关系。有最新研究将关系提取抽象为知识表示学习,将句子映射到实数向量空间表示,如TransE算法(Bordes,Usunier,Garcia-Duran,Weston,Yakhnenko,2013),把实体向量化到空间,问题便表达为三元组距离的损失函数,在向量空间中优化S+P=O,即最小化S+P=O。专业领域的知识提取通常由于语料不充足或表达特殊,一般的通用算法难以直接有效应用,这是由于一般分词算法的基础词库都采用通用词库,经常把专业词错分,所以通常需要先维护一个领域词典。领域词典的构建有很多方式,一般采用先通过词性标注,TF-IDF等传统方法首先进行标注,在结合领域知识对词表进行调整。在构建好领域词典后,实体识别中可以优先采用专业词典,学习过程也可以赋予更高权重。

目前在具体工业应用中,知识提取算法主要受限于语料,所以在有丰富语料的场景中会有显著效果,如文本搜索,机器翻译,机器人问答等。在专业领域中,还不存在“一本万利”的方法,算法效果需要长时间的语料标注积累。

(三)摘要系统设计

本节首先分析公告的数据特征,进而给出算法框架与具体算法说明。

3.1 问题分析

算法按顺序可分为如下几个关键步骤。1、公告分类;2、公告PDF解析;3、基于LSTM的关键语句提取;4、基于规则的结构化提取。

由于上市公司公告类别必须按照官方要求发布,所以公告分类可以仅通过标题划分,仅需维护一些简单的特征组合即可,在此不做赘述。

通过对A股各类型公告的分析,按照知识提取的难度可分为三类,难度逐步增大。

3.1.1 基于语句的基本摘要

某一句话即包含全部关键信息。例如:业绩预告公告。“预计2016年实现归属于上市公司股东的净利润600万元—800万元,且2016年末归属于母公司的净资产为正数。”此类摘要,可以直接通过深度学习模型提取,便有较高准确率,结构化提取可以进一步规则解析。

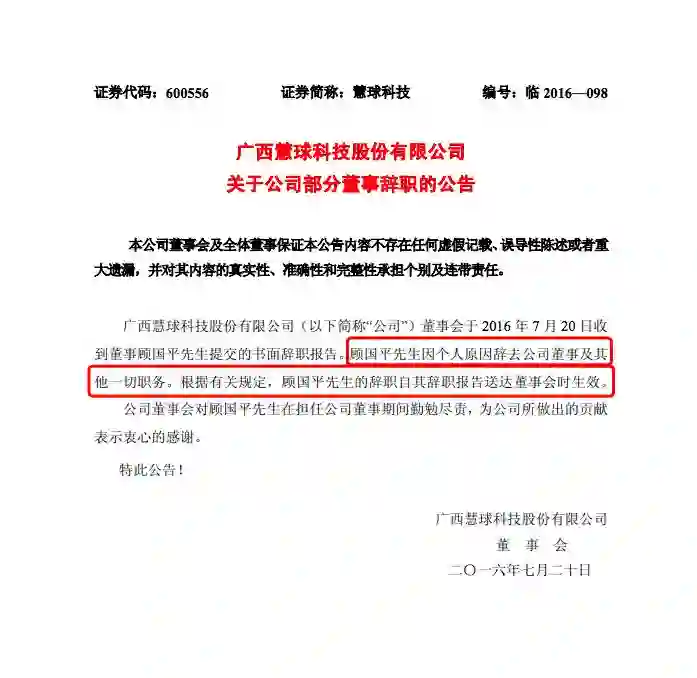

下面是董事辞职公告的例子:

摘要为:“因个人原因,郑敏先生辞去公司第八届董事会董事及董事会专门委员会委员职务,辞职后不再担任公司任何职务。”

3.1.2 基于关键信息的简单摘要

关键信息在文本多个位置,但结构雷同。例如:董事会决议公告。“武汉祥龙电业股份有限公司第九届董事会第二次会议于2017年2月21日召开,会议审议通过《关于公司控股子公司签署工程合同暨关联交易的议案》、《关于公司控股子公司开展委托理财业务暨关联交易的议案》。”议案名在文章多个位置,但均在某段最左或单独作为一行,特征周围有书名号,数字序号,或通过、否决等标志。这类公告,同样可以采用深度学习,但准确率会有一定损失。

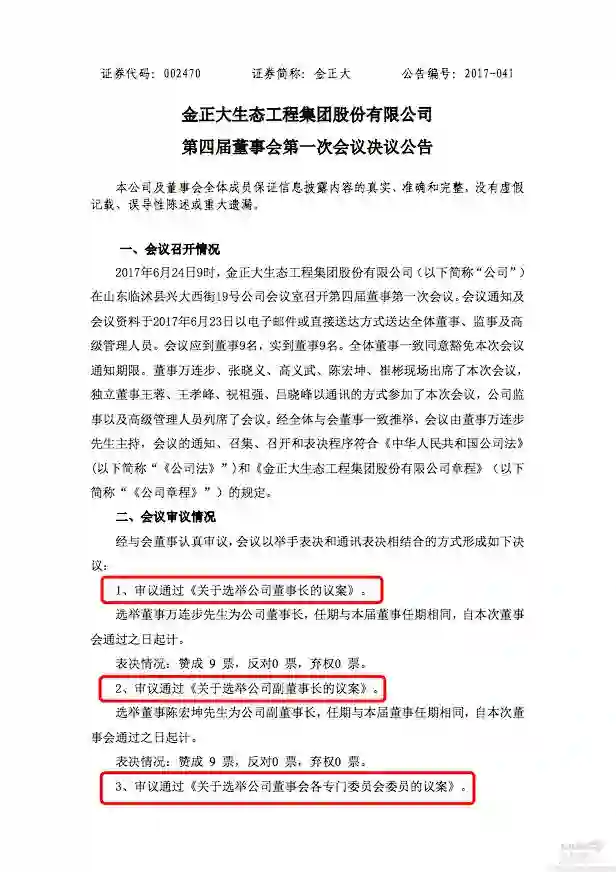

下面是董事会决议的例子:

摘要为:“金正大生态工程集团股份有限公司第四届董事会第一次会议于近日召开,会议审议通过《关于选举公司董事长的议案》、《关于选举公司副董事长的议案》、《关于选举公司董事会各专门委员 会委员的议案》、《关于参与认购集合资金信托 计划并对控股子公司进行增资的议案》等事项。”

3.1.3 基于关键信息的复杂摘要

信息在多个位置,并且表述复杂,较为随意。例如:对外担保公告。“为满足项目建设资金需求,公司全资子公司XXX有限公司拟向XXX信托有限责任公司申请14亿元信托贷款,期限2年,公司为其提供全额全程连带责任担保。”其中担保原因表述不统一,担保对象有子公司、分公司,其他公司等多种方式,担保金额与期限有时会附带累计担保信息。对此类公告,目前认为只能采用严格的规则系统开发。

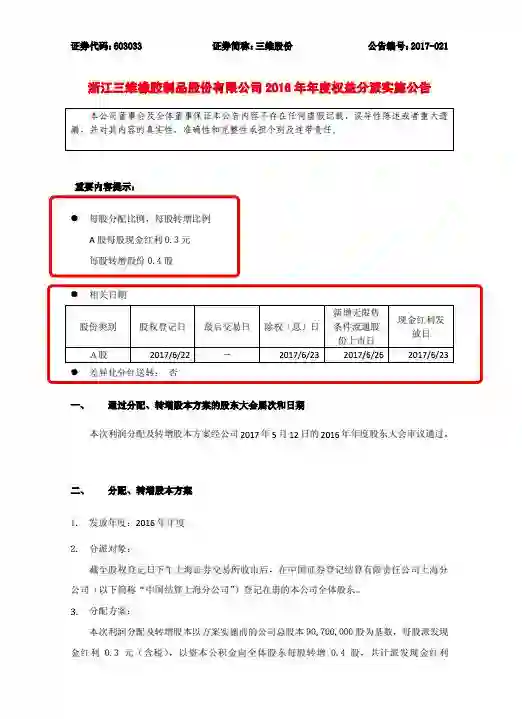

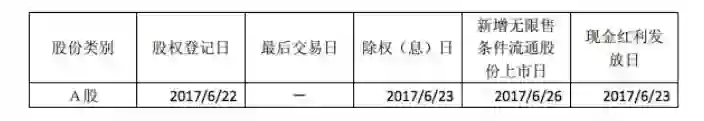

下面是权益分派公告的例子:

摘要为:“浙江三维橡胶制品股份有限公司实施2016年年度权益分派方案为:A股每股派发现金红利0.3元(含税),以资本公积金向全体股东每股转增0.4股。股权登记日:2017/6/22。除权(息)日:2017/6/23。新增无限售条件流通股份上市日:2017/6/26。现金红利发放日:2017/6/23。”

3.2 PDF语法解析

目前较为成熟的PDF转换TXT工具有基于Python的Pdfminer与基于Java的Pdfbox,两者解析效果类似,在此本工作选用Apache旗下的Pdfbox,因为其源码维护更加活跃,并且提供了下面的功能:文本的提取,即在PDF文件里面把文本内容提取出来;合并和拆分PDF文档,可以把几个PDF合并成一个PDF文件,也可以把一个PDF文件拆分成多个PDF文件;PDF的校验,根据PDF/AISO 标准校验PDF文档;打印PDF,通过Java的API去打印PDF文件;把PDF转换成图片,把PDF文件转换成图片;创建PDF文件;PDF签名。PDF表格提取目前并没有非常有效的处理工具,对此本工作进行了自主开发。

目前开源的PDF解析工具主要存在如下几个方面问题。

1、没有明确的段落信息,小标题与段落可能会连在一起转换成TXT文本,这样会导致后续的断句出现错误。

2、没有篇章结构解析,无法按照树状结构表示文本,而篇章标题可成为LSTM训练的一个有效特征。

3、处理表格时无法识别合并单元格的情况,直接转换出的表格是一个单元一个词,遇到空格等标志时导致程序无法对应行列信息。

对此本工作在Pdfbox解析后进行了修正:

1、通过标注<PAT>,<UAD> 序号等PDF携带的特征将文本放进神经网络中训练,可以得到大于99%的分段准确率。

2、篇章结构主要通过规则系统,识别PDF的章节特征,通常PDF篇章标题采用不同的序号与加大加粗字体表示。

3、Pdfbox可以将表格还原为带有坐标位置信息的XML文件,这样可以判断横竖线链接,用于锁定表格。在表格处理中还要注意一些特殊情况,如有些表格会跨页,并且在PDF中页眉页脚带有横线;又或者有些表格的分割线为双横线;这些情况都需要做进一步特殊处理。表格识别本质是一个连通图问题,将表格每一个单元抽象成一个图结点,向四个方向游走,如果不遇到横竖线拦截则扩展单元,反之建立新节点。

表格提取在公告处理中主要作用于特定信息提取,如财务报表,供应商与客户表,业务构成表等等。如财务报表信息,表格提取仅仅作用于还原表格结构,但具体结构化还需要两项工作。

一是实体对齐,如财务报表中的指标对齐,比如“资产总计=总资产”。

二是表格定位,即如何判定某一张表是五大供应商表还是五大客户表,这些需要通过表格的上下文判断,其中篇章结构的解析会对此有辅助定位功能。

利用PDF转换工具可以从绝大部分上市公司公告中提取到有效文本。对于可获取的其他格式文本,如Word或TXT,文本内容获取较易,本课题没有加以特别对待;而对部分由图片转换的PDF,由于涉及到图像识别等其他专项技术,未在本课题中加以覆盖。

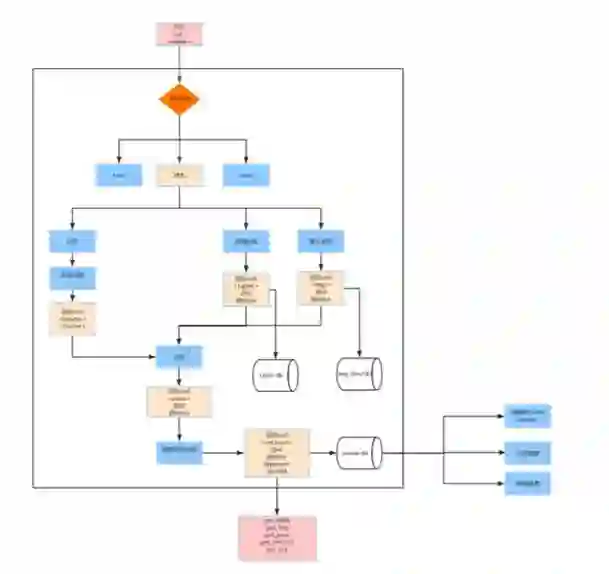

整个PDFBox的处理流程如下图所示:

PDF进过PDFBox处理生成想要的中间xml格式表示文件

分页模块对PDF进行逐页处理,将页眉页脚分别进行标注。

图片提取模块对PDF中的图片文件进行必要处理,保存到相应的媒体库中。

表格处理模块对PDF中存在的表格信息进行提取,一方面要对存在合并单元格的表格进行处理,另外一方面还要对跨页的表格进行处理。还原表格的语法结构,为后期对表格的语义处理提供必要支持。

3.3 基于LSTM的关键句抽取

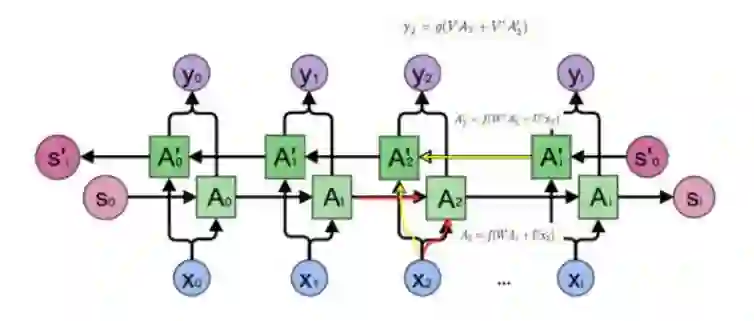

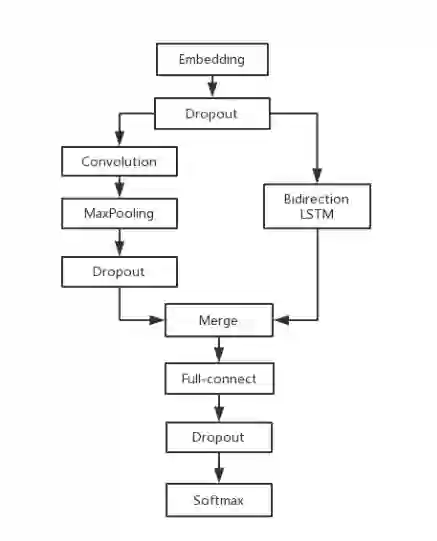

本项工作采用的是双向LSTM,其网络结构如下图所示:双向卷积神经网络的隐藏层要保存两个值, A 参与正向计算, A’ 参与反向计算。最终的输出值 y 取决于 A 和 A’:

即正向计算时,隐藏层的 st 与 st-1 有关;反向计算时,隐藏层的 st 与 st+1 有关:

因为首要目的是识别关键语句,然而很多语句经常会以被动形式表述,为了能同样捕捉到这些信息,需要将句子倒序化,简单来讲仅需分词后将序列倒排即可,不必通过依存句法分析器(Dependency Parser)解析。

此外为了加强模型的泛化能力,可以将部分结点进行熔断(Dropout)处理。

举例来讲,“公司ABC拟向XYZ公司申请1亿元贷款”,通过熔断到序列中的一些结点后,可以泛化为“公司ABC__XYZ公司申请1亿元贷款”,随机的熔断部分数据会加强模型泛化性。

卷积(Convolution)和最大池化(Maxpooling)则是CNN的卷积网络结构,这里只用CNN对原文的词向量以某一长度的过滤卷积抽象,最后对原句子的表示还是使用LSTM,由于使用了抽象的含义向量,在实际效果优于仅仅LSTM的结构。

本工作经过实践,总结出下图所示的模型。每类公告在训练前需要先进行标注,标注过程即在句子上进行分类。实践中可以先通过正则表达式进行粗筛,再进一步人工过滤。这部分工作使用了Tensorflow与Keras框架,在PDF转化为TXT之后,拆分成句子并进行向量化,如下图搭建模型并调节参数后,便训练出关键语句提取模型。

3.4 基于知识的摘要信息抽取

3.4.1 实体提取

由于前两步流程仅仅获得了包含关键信息的句子,深度学习也难以高准确率的识别结构化信息,所以需要通过自然语言处理与规则系统来进一步提取。本文主要关注的信息抽取点有:公告标题、公司全称、公司简称、日期时间、会议名称、决议事项、业绩预测事件等,大体可分为实体和事件类两种信息抽取任务。

命名实体识别(Named Entity Recognition),简称“实体识别”,是自然语言处理的核心工作之一(Nadeau,Sekine,2007)。实体识别的主要任务是识别文本中具有特定意义的实体,包括人名、地名、机构名、时间信息和专有名词等。主要工作包括两部分:1.实体边界识别;2.确定实体类别。

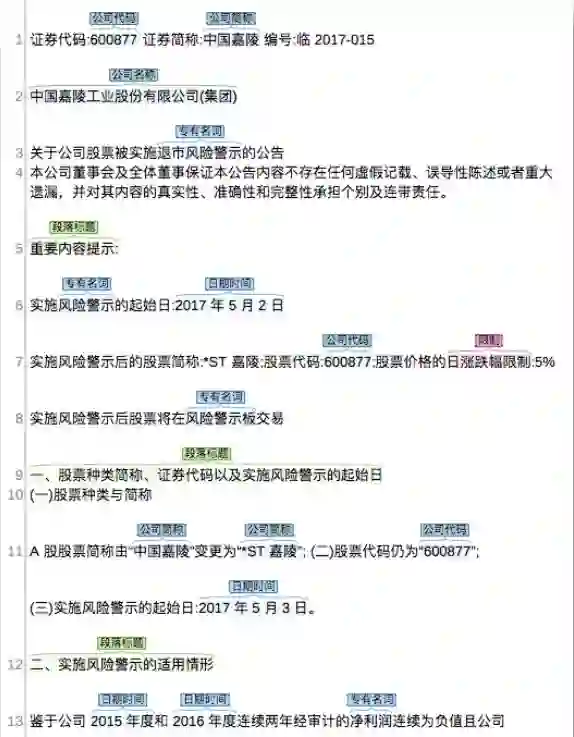

为在一份“特别处理”公告上运行实体识别模块的处理后的可视化结果。

这里的公司简称,公司名称,公司代码,日期时间,标题,段落标题,地址,人物,电话,电子邮件,时间区段,限制条件,指代,专有名词的识别是基于如下的处理实现的:

基于字典匹配的实体识别。

基于公告页眉内容的时候识别:从“证券代码:600877 证券简称:中国嘉陵 编号:临 20170015”的页眉结构中,我们可以提取到公司代码和公司简称实体。

基于表格内容的实体识别:

3.4.2 事件提取

事件提取(Event Extraction)的研究(Hogenboom,Frasincar, Kaymak et al 2011)是多学科发展和应用的需要,具有深远的理论意义和广泛的应用价值。它涉及到自然语言处理、数据挖掘、机器学习、数据库等多个学科的技术和方法,在自动文摘,信息检索等领域均有着广泛的应用。因此,事件抽取技术的研究具有重要的现实意义。

事件提取的主要工作分为事件类型识别以及事件元素与语义角色识别。

事件类型识别:事件类别识别是指从文本中检测出事件句,并依据一定的特征判断其所归属的类别。不难看出,事件类别识别是典型的分类问题,其重点在于事件句的检测和事件句的分类。现有的检测事件句的方法主要是基于触发词的方法。在这类方法中,将每个词作为一个实例来训练并判断是否为触发词的机器学习模型,但引入了大量的反例,导致正反例严重不平衡。为了解决了上述问题,一种基于局部特征选择和正负特征相结合的事件检测与分类方法,取得了不错的识别效果(谭红叶,2008)。

事件元素识别与语义角色标注(Semantic Role Labeling, SRL)任务有一定的相似性。所谓语义角色标注,是根据一个句中的动词(谓词)与相关各类短语等句子成分之间的语义关系,而赋予这些句子成分的语义角色信息,如施事、受事、工具或附加语等。事件元素识别是事件抽取中又一核心任务。该任务主要从众多命名实体(Entity)、时间表达式(Time Expression)和属性值(Value)中识别出真正的事件元素,并给予其准确的角色标注。

国外学者对事件抽取技术的研究开展的较早,理论研究比较成熟,且有一些事件抽取的原型系统出现。国内对事件抽取技术的研究相对贫乏,仍处于起步阶段,但也取得了一定的成果。综合来看,事件抽取的方法大体上分为两大类:模式匹配方法和机器学习方法。下面就两种方法分别详细介绍。

一、模式匹配法

模式匹配法是指对于某种类型事件的识别和抽取是在一些模式的指导下进行的,采用各种模式匹配算法将待抽取的事件和已知的模式进行匹配。

可见,模式匹配方法由两个基本步骤组成:模式选取和事件抽取。尽管不同的基于模式匹配的事件抽取系统有这样或那样的差异,但总的来讲,基于模式匹配的事件抽取方法准确率较高,且接近人的思维方式,知识表示直观、自然,便于推理。然而,这种方法往往依赖于具体语言,具体领域及文本格式,可移植性差,编制过程费时费力且容易产生错误,需要富有经验的语言学家才能完成;并且抽取的模式不可能涵盖所有的事件类型,当从一种语料转移到另一种语料时,为保证不损失性能,往往还需要花费很多工作在模式的重新获取上,因此性价比不高。

二、机器学习法

机器学习方法建立在统计模型基础之上,它是将事件抽取看作分类问题,主要是选择合适的特征并使用合适的分类器来完成。根据抽取模型中所采用的不同激励源,现有的方法主要可分为3大类:

事件元素激励:最大熵分类器,用于事件元素的识别。该方法实现了2个领域中的抽取任务,分别是半结构化的讲座通告(Seminar Announcement)和自由文本的人事管理(Management Succession)。该方法存在着一定的局限性,因为文本中存在着很多非事件元素的词,所以构建分类器时将引人太多的反例,导致正反例严重不平衡,影响抽取的效果。

触发词激励:2006 David Ahn结合MegaMTimbl 两种方法分别实现了事件抽取中事件类和元素的识别。在 Ahn 的方法中,最重要的一个步骤就是判断句子中的每个词是否是最能描述某个事件发生的触发词,如果是,则将其归为正例,并用一个多类分类器对其进行分类,获得其所属的事件类别,从而得出其所含的事件元素类型,用于构建识别每一类事件元素的分类器。此类方法是目前比较主流的事件抽取方法,将每个词作为一个实例进行训练,然后判断是否为触发词,但同样引入了大量的反例,导致正反例严重不平衡;并且,事件类别的多元分类以及为每类事件元素单独构造多元分类器时在语料规模较小的时候存在着一定的数据稀疏问题。

事件实例激励:是一种基于事件实例激励的抽取模型,充分利用事件和非事件实例的有代表性的特征,构造二元分类器过滤掉非事件的句子,然后来用多知识融合的方法表示候选的事件实例,利用支持向量机采用多元分类的方法自动识别候选事件实例所属的事件类别,实现事件提取任务。

综上所述,从国内外研究现状来看,比较流行的事件抽取方法是基于触发词激励的研究。但这类方法所面临的最大问题是必须先对文本中的所有词进行判断以确定其是否是事件触发词,然后再根据相关的信息判断事件的类型。但实际上文本中非触发词的那些词所占的比例很大,如果对所有词进行分类判断不仅增加计算的负担,更重要的是引入太多的反例,造成正反例的严重不平衡。遗憾的是,目前还没有高效的算法对非触发词能够进行有效的过滤,因此,基于触发词激励的事件抽取技术的研究巳陷入了瓶颈。

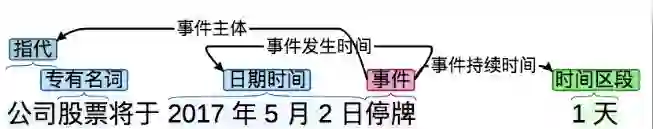

在本课题实现中,事件由事件触发词(Trigger)和描述事件结构的元素(Argument)构成。描述事件的结构包括事件发生的主体、施体、时间、地点等一系列元素。下图为一份“特别处理”公告上运行事件提取模块的处理结果。

根据以上任务分类,需要针对性的进行领域词典扩充,对此本工作将各公告首页中的全称-简称对应表、各财务报表的财务制表字段,高管人名等都加入领域词典。对于各个句子,通过词性标注(POS Tagging)与依存关系分析(Dependency Parsing)后便可提取出简单的实体与关系,比如对外担保公告中的“担保对象”、“担保金额”等。然而如“担保原因”这类语句并没有明确统一的表述方式,对此采用规则方法尽量穷尽可能性。这部分工作与传统方法并无明显差异,故不做赘述。

根据应用需求不同,知识提取的结果可以是结构化实体,也可以是摘要。摘要一方面可以通过结构化数据配合模板组合而成,也可以通过深度学习算法直接训练。本工作对两种方式都进行了尝试,模板组合方式可以高准确率的保证信息准确,但难以保持原文的行文方式;而深度学习方法直接捕捉原文进行组合,准确率有所不足,两者孰优孰劣需要考虑具体应用场景而定。

3.5 算法流程

上市公司信息披露自动摘要系统的算法流程如下:

PDF解析

系统自动识别PDF内标题,并根据标题进行分类

按段落和句子进行切分

关键句提取

实体或事件提取

摘要模板的生成

每类摘要标注50-100份即可,如果效果不足,可以通过模型测试界面进行观测与改进。

(四)公告摘要制作流程及改进

本项工作的初始目的是为了公告制作小组提供合适的自动化处理工具,改进流程,降低风险,提高效率。公告制作小组的摘要内容制作流程是整个生产流程中的微小一环,包含三个步骤:

1.摘要采编;

2.摘要一审;

3.摘要二审及发布。

本工作在生产环境搭建了自动摘要微服务,为公告采编系统提供服务。在新的流程下,自动摘要服务取代了原有的摘要采编工作,自动生成的摘要仍通过人工审核后发布。

根据统计,按照原有流程,摘要采编这道工序的时间从20秒至184秒不等,平均约为54秒;按照改进后的流程,自动摘要服务可在数秒之内完成摘要采编(含数据请求及返回的时间),单一工序效率提升了十倍有余。

这在公告发布高峰期带来的工作量节约是相当可观的。根据实际使用情况来看,自动摘要服务给出的摘要正确率在可接受范围内,并有继续优化完善的空间。这也给我们对其他手工工作密集的工作程序改进带来了新思路。

4.2 基于知识的信息抽取

本课题共针对9类高频公告的开展了实验,分别对结构化提取与摘要生成进行了测试。9类公告的选取主要考虑几个方面:

1、临时公告,保证数据量大,并且是高频、重要公告;

2、公告关键信息明确,可以被结构化(反例:澄清公告等便没有结构化的必要);

3、公告类别覆盖能“某一句话包含全部关键信息的”与“关键信息出现在多处需要聚合的”。

9类公告的摘要示例及所需要抽取的信息点的分析如下:

4.2.1 股东大会/董事会决议公告

公告摘要示例:

(600390)“*ST 金瑞”公布第六届董事会第二十六次会议决议公告

金瑞新材料科技股份有限公司第六届董事会第二十六次会议于 2016 年 6 月 18 日召开,会议审议通过《关于公司发行股份购买资产暨关联交易方案的 议案》、《关于公司本次重组配套融资方案的议案》、《<金瑞新材料科技股份有 限公司发行股份购买资产并募集配套资金暨关联交易报告书(草案)>及其摘要的议案》等事项。

仅供参考,请查阅当日公告全文。

(600289)“亿阳信通”公布 2015 年年度股东大会决议公告

亿阳信通股份有限公司 2015 年年度股东大会于 2016 年 6 月 20 日召开, 会议审议通过公司 2015 年年度报告及摘要、公司 2015 年度利润分配预案、 公司续聘 2016 年度财务审计机构和内控审计机构的议案等事项。

仅供参考,请查阅当日公告全文。

对应信息点:

公司全称(实体)

公司简称(实体)

公司代码(实体)

股东大会名称(实体)

股东大会召开时间(实体)

通过的审议项(实体)

4.2.2 召开股东大会通知公告

公告摘要示例:

(600707)“彩虹股份”公布关于召开 2017 年第三次临时股东大会的通知

彩虹显示器件股份有限公司董事会决定于 2017 年 10 月 25 日 14 点 00 分召 开 2017 年第三次临时股东大会,审议关于对外投资的议案。

网络投票系统:上海证券交易所网络投票系统;

交易系统投票时间:2017 年 10 月 25 日 9:15-9:25,9:30-11:30, 13:00-15:00;

互联网投票平台投票时间:2017 年 10 月 25 日 9:15-15:00。仅供参考,请查阅当日公告全文。

(603027)“千禾味业”公布关于召开 2017 年第二次临时股东大会的通知

千禾味业食品股份有限公司董事会决定于 2017 年 10 月 25 日 10 点 00 分召 开 2017 年第二次临时股东大会,审议《关于公司<2017 年限制性股票激励计划 (草案修订稿)>及其摘要的议案》、《关于公司<2017 年限制性股票激励计划实 施考核管理办法(草案修订稿)>的议案》、《关于修订<公司章程>的议案》等事 项。

表决方式:现场投票和网络投票相结合; 网络投票系统:上海证券交易所网络投票系统; 交易系统投票时间:2017 年 10 月 25 日 9:15-9:25,9:30-11:30,13:00-15:00;

互联网投票平台投票时间:2017 年 10 月 25 日 9:15-15:00。仅供参考,请查阅当日公告全文。

对应信息点:

公司全称(实体)

公司简称(实体)

公司代码(实体)

股东大会名称(实体)

股东大会召开时间(日期)

待审议项(实体)

表决方式(实体)

网络投票系统类型(实体)

交易系统投票时间(日期)

互联网投票平台投票时间(日期)

4.2.3 利润分配实施公告

公告摘要示例:

(600072)“钢构工程”公布关于 2015 年度利润分配的实施公告

中船钢构工程股份有限公司实施 2015 年度利润分配方案为:每 10 股派发 现金 0.15 元(含税)。

股权登记日:2016 年 6 月 24 日 除息日:2016年6月27日 现金红利发放日:2016 年 6 月 27 日仅供参考,请查阅当日公告全文。

(600323)“瀚蓝环境”公布关于 2011 年公司债券 2016 年本息兑付和摘牌公告

南海发展股份有限公司 2011 年公司债券(简称“PR 发展债”)将于 2016 年 7 月 7 日开始支付:5 年期债券“PR 发展债”之本金的 70%;5 年期债券“PR 发 展债”自2015年7月7日至2016年7月6日的利息。

兑付债权登记日:2016 年 7 月 4 日 债券停牌起始日:2016 年 7 月 5 日 兑付资金发放日:2016 年 7 月 7 日 债券摘牌日:2016年7月7日仅供参考,请查阅当日公告全文。

对应信息点:

公司全称(实体)

公司简称(实体)

公司代码(实体)

利润分配方案名称(实体)

A股每股现金红利(数字)

股权登记日每股转增股份(数字)

除权(息)日(日期)

新增无限售条件流通股份上市日(日期)

现金红利发放日(日期)

公司债券简称(实体)

兑付债权登记日(日期)

兑付资金发放日(日期)

债券摘牌日(日期)

4.2.4 业绩预测公告

公告摘要示例:

(600602)“云赛智联”公布 2016 年半年度业绩预增公告

经云赛智联股份有限公司财务部门初步测算,预计 2016 年半年度实现 归属于上市公司股东的净利润与上年同期(法定披露数据)相比,将增加 95% 以上。

仅供参考,请查阅当日公告全文。

对应信息点:

公司全称(实体)

公司简称(实体)

公司代码(实体)

业绩预测描述(句子)

4.2.5 停、复牌公告

公告摘要示例:

(600767)“运盛医疗”公布重大事项停牌公告

运盛(上海)医疗科技股份有限公司收到第一大股东上海九川投资(集团)有限公司通知,九川集团正在筹划涉及公司的重大事项,该事项可能对

公司的控股权造成重大影响,该事项存在较大不确定性。

经公司申请,公司股票自 2016 年 6 月 14 日起停牌。仅供参考,请查阅当日公告全文。

(603788)“宁波高发”公布关于筹划非公开发行股票事项复牌的公告

鉴于宁波高发汽车控制系统股份有限公司董事会已审议通过非公开发行 股票相关事项,经向上海证券交易所申请,本公司股票于 2016 年 6 月 15 日 复牌。

仅供参考,请查阅当日公告全文。

对应信息点:

公司全称(实体)

公司简称(实体)

公司代码(实体)

停复牌原因描述(句子)

停牌时间(日期)

复牌时间(日期)

4.2.6 新股/限售股上市公告

公告摘要示例:

(603085)“天成自控”公布首次公开发行限售股上市流通公告

浙江天成自控股份有限公司本次限售股上市流通数量为 3,750,000 股;上 市流通日期为2016年6月30日。

仅供参考,请查阅当日公告全文。

对应信息点:

公司全称(实体)

公司简称(实体)

公司代码(实体)

上市日期(日期)

限售股上市流通数量(数字)

4.2.7 风险警示公告

公告摘要示例:

(600381)“青海春天”公布关于公司股票实施其他风险警示暨股票复牌 的公告

根据相关规定,青海春天药用资源科技股份有限公司股票将于 2016 年 6 月 28 日继续停牌 1 天,6 月 29 日起复牌并实施其他风险警示,实施其他风 险警示后股票价格的日涨跌幅限制为 5%,将在风险警示板交易。实施其他风 险警示后的股票简称:ST 春天,股票代码:600381。

仅供参考,请查阅当日公告全文。

对应信息点:

公司全称(实体)

公司简称(实体)

公司代码(实体)

风险警示描述(句子)

实施其他风险警示后股票价格的日涨跌幅限制(数字)

4.2.8 终止上市公告

公告摘要示例:

(600087)“*ST 长油”公布关于股票终止上市的公告

2014 年 4 月 11 日,中国长江航运集团南京油运股份有限公司收到上海 证券交易所自律监管决定书[2014]161 号《关于终止中国长江航运集团南京 油运股份有限公司股票上市交易的决定》,上海证券交易所决定终止公司股 票上市交易。

仅供参考,请查阅当日公告全文。

对应信息点:

公司全称(实体)

公司简称(实体)

公司代码(实体)

自律监管决定书(实体)

终止上市执行描述(句子)

4.2.9 融资融券公告

公告摘要示例:

(601107)“四川成渝”公开发行 2016 年公司债券(第一期)发行公告(面 向公众投资者)

四川成渝高速公路股份有限公司面向公众投资者公开发行面值不超过 10 亿元(含 10 亿元)的公司债券已获得中国证券监督管理委员会证监许可 [2015]1484 号文核准。

四川成渝高速公路股份有限公司 2016 年公司债券(第一期)基础发行 规模为人民币 5 亿元,可超额配售不超过 5 亿元。请投资者仔细阅读公告 全文。仅供参考,请查阅当日公告全文。

对应信息点:

公司全称(实体)

公司简称(实体)

公司代码(实体)

发行类型(实体)

发行面值(数字)

发行规模(数字)

获批文件号(实体)

4.3 实验结果评测

对结构化提取测试主要观察提取的实体是否准确并全面,摘要的准确率则与公告制作小组制作的人工摘要通过edit-distance方法直接对比,摘要的实现力求与官方要求一致。

在模型开发过程中,公告种类和数量循序增加,本课题期间,系统经过了15个版本的迭代。前4、5个版本准确率的提升非常明显,通过深度学习结合统计的方式,准确率快速提升到75%的区域。伴随着测试数据多样性的增加,在6版本到14版本迭代的过程中,准确率出现了波动,通过对异常情况进行分析,提升统计学习的泛化能力,同时对异常情况进行规则整理,最终准确率获得了提升。

本文在3000+公告数据集上对系统的最终效果进行了回测分析,在其中222篇有人工标注摘要结果的公告数据上进行了准确率分析。测试结果如表1所示,可以看到,无论是结构化提取准确率,还是摘要生成准确率(评估值),都比较令人满意。

以下为九类公告的准确率统计:

(注:摘要准确率:由公告制作小组对摘要文本描述进行人工评测)

(五)研究总结

5.1 成果落地

依据本研究课题,我们设计并实现了自动公告摘要系统,以微服务的方式为周边系统服务,提供了单篇公告测试页面和批量摘要生成API。该系统目前已经上线运行,服务于公告制作小组,有效降低了部分摘要的制作时间,降低了风险,提升了效率。

5.2 总结展望

本文介绍了上市公司公告专业领域的知识抽取工作,采用了深度学习与传统规则方法的混合算法流程,并以9类高频公告作为测试集,均达到了理想可用的效果。

未来工作可以围绕几方面开展:

一、扩展现有模型的应用范围。目前仅对沪市的9类高频公告进行了处理,可以考虑从几个方面扩展应用范围:1)其他类别公告;2)历史公告;3)其他市场公告。

二、扩展现有自动摘要系统的输入格式。目前仅考虑了覆盖绝大部分公告披露的PDF格式,可以考虑增加其他格式的文件输入,如Word、TXT、HTML等。

三、进一步探索新方法以加强现有算法的不足。目前方法处理的公告仍相对简单,如澄清公告、重大资产重组公告里面有更复杂更不规范的自然语言描述,这些特点都会使得深度学习无效,以及规则方法变得更加复杂。对于解决这类特殊问题,目前仍缺乏基本语料的储备。对此可以考虑通过大规模新闻语料进行迁移学习,即如何将通用领域的学习模型迁移到专业领域上。

四、在结构化数据的基础上进行数据挖掘与产品化尝试。比如,可以围绕一家上市公司的经营情况自动生成“重大里程碑”,而这些数据均通过在不同类别公告的知识提取完成。还可以将人事变动公告进行解析,构成人物图谱,通过社交网络的分析方式查看管理层之间关系。此外,可以将直接反映公司经营情况的公告直接与股价挂钩,观察某一公司或某一行业发布的公告与其股价的关系。

(六)参考文献

中国证监会,2007,《上市公司信息披露办法》。

上海证券交易所,2013,《上海证券交易所信息披露公告类别索引》。

谭红叶,2008,《中文事件抽取关键技术研究》,哈尔滨工业大学。

Ahn D, The stages of event extraction. InProceedings of the Workshop on Annotating and Reasoning about Time and Events,pages 1–8. Association for Computational Linguistics 2006.

Bengio Y, Simard P, Frasconi P LearningLong-Term Dependencies with Gradient Descent is Difficult IEEE TRANSACTIONS ONNEUREAL NETWORKS VOL 5. NO.2 1994.

Bordes A, Usunier N, Garcia-Duran A, et al.Translating embeddings for modeling multi-relational data[C]. Advances inneural information processing systems. 2013: 2787-2795.

Cho K, Bahdanau D, Learning PhraseRepresentations using RNN Encoder–Decoder for Statistical Machine Translation. arXiv: 1406.1078v3 2014.

Gers, Schmidhuber, Recurrent Nets that Timeand Count,2000, 10.1109/IJCNN.2000.861302.

GravesA, Supervised sequence labelling with recurrent neural networks[M]. Heidelberg:Springer, 2012.

Graves A, Generating Sequences with RecurrentNeural Networks. arXiv:1308.0850, 2013.

Hochreiter S, Schmidhuber J. Long short-termmemory[J]. Neural computation, 1997, 9(8): 1735-1780.

Hogenboom F, Frasincar F, Kaymak U, et al. Anoverview of event extraction from text[C]//Workshop on Detection,Representation, and Exploitation of Events in the Semantic Web (DeRiVE 2011) atTenth International Semantic Web Conference (ISWC 2011). 2011, 779: 48-57.

Huang Z, Xu W, Yu K. Bidirectional LSTM-CRFmodels for sequence tagging[J]. arXiv preprint arXiv:1508.01991, 2015.

Nadeau D, Sekine S, A survey of named entityrecognition and classification[J]. Lingvisticae Investigationes, 2007, 30(1):3-26.

Radev D R, Hovy E, McKeown K. Introduction tothe special issue on summarization[J]. Computational linguistics, 2002, 28(4):399-408.

拓展阅读:

加入我们

如果你还不熟悉文因互联:文因互联是位于北京的智能金融创业公司。技术团队来自MIT、RPI、IBM、Samsung等知名大学和公司,深耕人工智能十余年,是知识图谱领域的领军团队。我们用人工智能技术解决交易所、银行、券商等面临的投资研究、自动化监管、投资顾问等问题。经过两轮融资,财务健康,目前市场拓展顺利,也建立了良好的行业口碑。

以下招聘岗位职责描述仅供参考,请不要让它们限制住你的想象和勇气。

前端工程师

【岗位职责】

1. 负责与产品需求和设计团队、开发架构团队密切配合,完成前端框架设计和技术实现方案

2. 负责按照各类需求文档和设计文档,完成前端代码开发

3. 负责创建用户友好、符合标准的跨浏览器应用

4. 遵循并参与项目开发规范和开发流程

【优先考虑】

1. 精通 HTML5、CSS3、ES6 等 Web 前端开发技术

2. 熟悉 JavaScript 面向对象编程、函数式编程及其相关设计模式

3. 熟悉 React /Vue技术栈,了解 Redux/Vuex 或基于它们二次开发的状态管理框架

4. 熟悉 webpack、Babel、npm/Yarn 等现代前端开发工具

NLP工程师

【岗位职责】

1. 信息抽取、文本摘要、自动问答等方面的研发以及语言资源/知识库维护

2. 金融知识图谱构建

3. 客户项目开发

【优先考虑】

1. 有自然语言处理经验,熟悉分词、实体识别等NLP基本模块(知道基本原理,并且使用过某个相关库)

2. 有Python项目开发经验,熟悉collections标准库下的数据结构

3. 可以完全在linux下工作

4. 有git开发项目经验,并能描述自己的workflow

5. 良好的沟通能力,一定的学习能力

【加分项】

1. 遵循良好的代码风格(如Google Style或PEP8)。

2. 有全周期项目开发经验加分。有开源项目、个人微博、博客证明自己者优先

3. 熟悉机器学习、深度学习,有使用深度学习在NLP中的应用经验,熟悉至少一种开源库,如tensorflow。

商务经理

【岗位职责】

1. 完成年度商务指标和相应营销工作

2. 完成所在区域金融客户的跟踪推进工作。包括拜访区域内各主要银行、券商等金融机构、发展维护渠道合作伙伴关系

3. 组织协调公司资源,完成与客户签约相关的招投标、谈判、签约、收款及售后客户关系工作

4.维护本地金融客户日常关系,收集反馈客户对公司产品和服务等方面的意见

【优先考虑】

1. 统招本科及以上学历,特别优秀者可放宽,专业、工作经验不限。

2. 喜欢与客户交流沟通,能适度出差

3. 具有良好的自我学习能力与团队合作精神,有强烈责任感。

4.对金融、银行、证券等业务熟悉的优先,有计算机专业背景的优先。

数据标注实习生

【岗位职责】

1. 使用标注工具,针对文本数据进行归类、整理、标注。

2. 学习标注规则,及时反馈标注质量及进度。

3. (如有编程能力)协助编写数据清理和处理代码。

【优先考虑】

1. 本科或硕士在校生优先,专业不限。

2. 对数据敏感,细致踏实;有较强的沟通能力。

3. 每周出勤时间不少于3天,最好能连续实习两个月。

【加分项】(非必须项):

1. 有一定的编程能力,熟悉 Python。

2. 有数据标注和校验经验。

3. 有语言学、自然语言处理或金融、财会背景。

是人才我们都不想错过,欢迎你过来一起聊聊。公司博客是 http://blog.memect.cn/ 主页是 http://memect.cn/

简历投递地址:hr@memect.co 等着你来!

添加微信群小助手微信号 wenyinai42,附上姓名、所属机构、部门及职位,审核后小助手会邀请您入群。

文因商务合作

请另联系微信号:wenyinba