不要再把图灵测试当作AI领域黄金标准了!

之后很多年,图灵测试一直是用来测验人工智能系统的“黄金标准”。然而随着技术的发展,越来越多的人发现:图灵测试似乎并不是唯一标准。近日,Reddit 论坛上有人贴出了一篇 2014 年的文章,并对图灵测试的可靠性提出了质疑,这一话题引发了不小的讨论。

InfoQ 将这篇文章以及一些论坛讨论中的观点整理了出来,供读者思考,如果你有任何想法,欢迎在评论区与我们交流。

更多优质内容请关注微信公众号“AI 前线”(ID:ai-front)

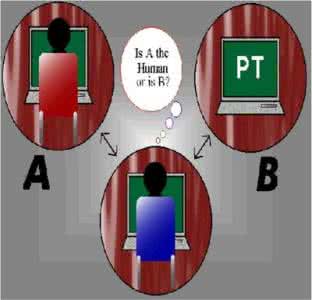

60 多年前,艾伦·图灵发表了一篇论文。他在论文中提出了一个具体的方法,来代替“机器能思考吗”这个问题。图灵给出的方法是客厅游戏的形式,在游戏中,裁判分别与计算机和人进行基于文本的对话,然后裁判需要猜测哪个是人,哪个是计算机。他称之为“模仿游戏”。而自此之后,这个游戏被错误地解读为测试计算机是否具备智能的科学测试,简称为“图灵测试”。

很多人以为这个经典的问题——“机器能思考吗?”,是图灵提出的问题。实际上这不仅不是图灵提出的,而且还是他曾经批判过的一个公开讨论问题:

我提议大家思考一下这个问题,“机器能思考吗?”。要回答这个问题,我们首先需要给出“机器”和“思考”的定义。如果通过它们的常见用法来定义这些词语,我们可能会用统计调查的方式得出这个问题的答案。显然,这是荒谬的。因此我没有尝试给出一个定义,而是提出了另一个问题:

“是否存在一台想象中的机器能够在模仿游戏中表现良好?”

原来那个“机器能思考吗?”的问题在我认为没有什么意义,不值得讨论。

图灵的动机在整个论文中都很明显:这个问题一直处在无休止的讨论和否定中(到今天仍然如此)。由于这对领域的发展没有帮助,图灵建议我们采取更加务实和建设性的立场。他以模仿游戏的概念为指导,来反驳顽固派反对机器智能的论据,并鼓励他的同行们不要让那些反对意见妨碍自己的发展。

我并不知道正确的答案是什么,但我想这些方法都应该试试。

我们目光所及,只是不远的前方,但是可以看到,那里有许多工作需要我们去做。

也许该论文中最富有洞察力的部分是图灵给出的示例问题。图灵特意挑选了数学、诗歌和象棋,以代表当时的人们认为需要智能的技能。直到 1997 年计算机深蓝(DeepBlue)在国际象棋中取得了胜利,国际象棋不再作为智能的代表。如果这个测试是为了证明计算机具有智能,那么为什么下面的答案是错误的?

问:请给我写一首关于第四桥的十四行诗。答:别把我算上。我从不写诗。问:70764 加上 34957 等于多少?答:(停顿约 30 秒,然后回答)105621。问:你下棋吗?答:是的。问:我的国王(K)在 K1,没有其他棋子。你只有国王在 K6,车在 R1。该你了,你怎么走?答:(停顿 15 秒后)车走到 R8,将军。

对于诗歌问题,想象中的计算机也可以写一首十四行诗,证明自己是有智能的。相反,它回避了这个问题,这什么也证明不了。

数学问题的结果应该是 105721,而不是 105621。图灵用它来反驳“机器不能犯错误”这一尴尬而常见的论点,即机器只遵循预先编程的指令而不考虑其他的。

(带模仿游戏程序的)机器并没有准备对算术问题给出正确的答案。它会故意算错,来迷惑裁判。

不过,国际象棋的答案也不算错。棋局上有两个国王和一个车的时候,计算机把车走到国王所在的行。但是一个孩子就可以给出这个答案,因为这是唯一有意义的下法。

这些回答错过了每一个让机器看起来有智能的机会。有人认为机器装聋作哑就代表了智能,但是不能否认这与智能测试的目的直接冲突。它不仅没有证明机器在各个方面都与“人类的智能”相匹配,反而证明在这些方面机器都不具有智能。显然,模仿游戏并不是为了展示智能。

第一个常见的对图灵测试的错误理解是,计算机应该假扮成一个女人,按照图灵最初设计的模仿游戏,一个男人必须假装成一个女人:

需要由三个人来玩这个游戏,一个男人(A)、一个女人(B)和一个询问人。如果用一个机器来担任 A 的角色,会发生什么情况?

图灵把计算机的行为和它的对手的行为都称为“man”。性别与此无关,因为这个问题只关乎智能。

如果一个机器扮演模仿游戏中 A 的角色,人扮演 B 的角色,这台机器能不能在模仿游戏中表现良好?

第二个错误理解是,图灵为测试指定了一个基准:

如果我先就这个问题阐述一下自己的看法,读者可能会觉得问题会更简单一点。

我认为 50 年内,能够对计算机编程,让计算机在模仿游戏中很顺利,一般的提问者在 5 分钟提问后,能准确鉴别的概率不超过 70%。

我现在谈谈与我的看法相对立的观点。

5 分钟的提问,然后(100%-70%=)30% 的概率将计算机误认为是人;许多人认为这些是测试的基准,因为这是论文中提到的唯一数字。而人们通常认为天才所说的一切都是事实,这种英雄崇拜又进一步加强了这种想法。

其他人则认为对于一个有意义的测试来说,图灵设定的标准太低,把他的话作为“预测”置之不理。然而,当时的 AI 还不能作为任何预测的依据,而图灵也并不认为自己是预言家。在后来的 BBC 采访中,图灵说一个机器想玩好模仿游戏的话,还需要“至少 100 年”,而早些时候他说的是 50 年。但人们不能因为这些“预测”不准确而指责他。

不管是哪种说法,5 分钟和 70/30% 的概率都被认为是图灵个人的信念。是他的主张、他的期望、他的希望,而不是测试的规则。他厌倦了人们说做不到,所以他只是说可以。

在基准问题上,还应注意的是,计算机最多有 50% 的机会获胜,即正常情况下的随机概率:如果计算机和相比之下的人类都表现的很完美,那么裁判仍然有 50% 的概率随机猜测一个结果。裁判必须做出选择,这一点在最初的游戏设计中很明显。在男人和女人之间,以及在人类和计算机之间,都是如此,否则将破坏询问的目标:

游戏的目标是询问人判断出外面的哪个人是男人,哪个是女人。

男人装成女人能有多像?我估计成功的概率不超过 50%。

不仅完成游戏的规则取决于人们的解释,还有游戏的进行方式。图灵是一个精确科学的人,他对论文中的其他论点都进行了详细描述,甚至计算必要的数字存储空间,他会如此含糊地定义一个科学测试吗?我们发现图灵主要把他的提议称为“游戏”和“实验”,但很少称之为“测试”。他没有提到“通过”,而且他解释说这不是尝试的重点:

有人可能会问,“为什么不直接拿一台机器进行这个实验?”——对这个问题简要的回答是,我们并不是要问现在的计算机中有没有机器能够通过实验,而是要问:是否存在一台想象中的机器能够通过游戏。

事实证明,是否通过测试毫无意义:是的,一些聊天机器人已经通过了游戏,最著名的是 2014 年的 尤金·古斯曼,甚至 Cleverbot 也通过了观众投票。但是有哪个智能程序通过了吗?没有。虽然没有人能在什么是智能上达成一致,但包括创造者在内的所有人都同意,那些通过的机器既不是智能,也不是在思考;它们主要是依靠关键词触发的反应才通过了游戏。

尽管图灵确实把游戏想象成一场智慧之战,但最终它的评判标准不是 AI 有多“聪明”,而是它多像“人”。事实上,人类的缺点、情感和怪癖反而成就了人类的特点,而不是他们在交谈中体现的聪明才智,因此,一个高度智能、理性的 AI 在这个游戏中反而会表现得很不好。

最后,图灵测试是行为假设,从表面得出结论,和中世纪的医生一样。按照同样的逻辑,如果计算机温度很高,而且发出咳嗽声,人们可能会认为计算机患流感了。显然,这不是一个令人满意的分析。我们可以根据计算机可以做数学题、下棋或者进行对话这一事实,继续猜测计算机是否具有智能,或者等计算机通过测试时,我们可以做任何人都做的事情:问“它是如何做到的?”,然后自己决定这个过程是否智能。任何问题都不如这个问题更科学或更有洞察力。

“图灵测试”不是一个合格的智能测试,而且它的目的也不是测试智能,那么该如何看待它呢?我个人认为图灵测试仍然适用于展示机器交谈技能的发展,随着社交机器人的兴起,这一挑战将变得越来越重要。并且,重要的是,令公众保持知情权,以平息由于人工智能的发展日益加剧的不安情绪。除此之外,我认为大家应该不再专注于解读“图灵测试”,而是继续努力,把图灵所梦想的人工智能变为现实。

最后,请大家想想图灵的希望:

不过,我相信,在本世纪末,由于词汇的用法会有较大的变化,普遍的学术见解也会改变,那时人们将能基于确定的共识来谈论机器思维。

Reddit 论坛上,一些网友对这一话题进行了讨论,部分整理如下:

网友 A:

我刚把这篇文章贴在其他地方,但是我不介意多发一遍:图灵测试不应该付诸实践。

文章链接:

https://artistdetective.wordpress.com/2014/09/05/the-turing-test/

图灵测试在专业人工智能领域几乎没有可信度,因为它与制造有用的人工智能是完全不同的两码事。

网友 B:

在我看来,图灵测试似乎只适用于所有拥有人类情感、感官和经验的机器人。比如为社交而设计的系统需要通过测试。

而用于其他目的的人工智能不需要通过图灵测试。比如无人车,只要听我的指挥,别撞车就行了,我又不需要和它建立情感联系。

但话又说回来,狗也曾担任警卫和狩猎助手,你可以与它们建立情感联系。也许拥有一辆像狗一样让人头晕目眩的汽车会很有趣,因为它可能会想在旅途中到处走走,和你聊天,但它仍然会给人一种智能汽车的感觉。不过跟养狗不同,它不用训练、不用喂食。

网友 C:

图灵测试更多的是一种思维实验,而不是真正的测试。它通常被认为是一个充分的(但不是必要的)测试,以确保人工智能至少具有人类水平的智能。有时这也与感觉有关。一个想法是,如果你不能从行为上把它与人类区分开来,你可能不应该在其他方面歧视它(比如说它并不真的会思考)。

你很少听说人工智能的一个原因是,相对较少的人工智能工作是试图构建(感知的)人类水平的智能。如果您正在构建一个扑克机器人或人脸识别器,图灵测试是不适用的。

在 AGI 专业人员中,图灵测试更经常出现。然而,它有很多问题。首先,这是一个二进制测试,如果你想测量 AGI 的进展,它是没有用处的;其次,没有人认为通过图灵测试对 AGI 是必要的,例如,说谎和误导可能不是我们希望 AGI 做的事情;第三,一个严重的问题是,通过图灵测试是否足以证明 AGI 具有人类的智力水平,因为评判标准实在太容易受到误导。

话虽如此,如果一个人工智能系统能永远误导我,让我误以为它是人类,我愿意接受它总体上是智能的,我想我的大多数同事也会这么认为。

网友 D:

我不认为图灵测试是足够有效的,因为它可以通过回放许多记录的人类聊天对话文本的最佳匹配,以及一些一致性检查来解决。

Deepmind 声称他们想建立 AGI,但我不相信他们。他们只是在游戏和医疗领域有所进展。DARPA(国防高级研究计划局)有两个向机器教授常识的项目,第一个项目是与现实世界互动;第二个项目试图从维基百科中提取常识。我相信后者能更快得到一些成果,但不可能维持太久。DARPA 需要两个相互竞争的项目来建立一场激励竞赛,以防止他们胡扯和伪造进展。由于第一个项目耗时较长,结果只取决于 DARPA 将投入多少时间和金钱。

我相信图灵测试,但是因为它是二进制的,所以不能用来衡量进度。这确实是个问题。

为了防止撒谎和误导,我觉得图灵测试可以排除一些对机器毫无意义的话题,比如食物、疾病和性。参与者还应该被限制为健康、成年、具有平均智商、母语水平良好和具有合作精神等等条件,这样就不可能出现另一个尤金·古斯特曼 (Eugene Goostman)。

编者注:尤金·古斯特曼(英文:Eugene Goostman),是一个人工智能聊天机器人,其形象定位是一名十三岁的乌克兰男孩,科研人员尽可能地使其个性和认知水平更加合理可信、并为用户所接受。

尤金·古斯特曼完成了一连串的图灵测试,2001 年、2005 年和 2008 年的罗布纳人工智能测试竞赛(Loebner Prize)中荣获亚军。2012 年 6 月 23 日,古斯特曼在位于米尔顿凯恩斯的布莱切利公园举行的纪念图灵百年诞辰的图灵测试竞赛中获胜。这次竞赛主要有 5 台机器人、25 名人类和三十名评委参与,是有史以来规模最大的一次竞赛。经过一系列的五分钟对话后,29% 的评委相信古斯特曼拥有人工智能。

参考链接:

https://www.reddit.com/r/artificial/comments/cpyb9i/is_the_turing_test_still_the_gold_standard_of_ai/

https://artistdetective.wordpress.com/2014/09/05/the-turing-test/

今日荐文

点击下方图片即可阅读

马云:AI聪明,但人类有智慧!马斯克:自作聪明是人类最大的问题

AICon全球人工智能与机器学习技术大会将于11月在北京举行,这里不仅有硅谷、BAT、独角兽们的AI技术案例解析,还有颜水成、贾扬清、崔宝秋等大咖现场经验分享。包含机器学习、计算机视觉、搜索推荐、智能金融、AI+产业、AI芯片、NLP、知识图谱等13+热门技术专场,干货十足,欢迎点击“阅读原文”查看详情,也可联系小姐姐:18514549229(同微信)。

你也「在看」吗?👇