Keras 作者 Francois Chollet:这些年,AI 未解决任何基本问题

新智元报道

新智元报道

来源:图灵 TOPIA

作者:刘静 编辑:李尔客

【新智元导读】谷歌 AI 研究员 Francois Chollet 的一番言论又一次引发了人工智能领域的激烈讨论:AI 领域这些年的研究其实毫无进展?!

AI 领域这些年的研究其实毫无进展?!

谷歌 AI 研究员 Francois Chollet 的一番言论又一次引发了人工智能领域的激烈讨论。

Francois Chollet 是深度学习框架 “Keras” 的作者,也是 AI 圈最热衷于活跃在社交网络的科学家之一。

近期他发表了一条推文,称 “最近读了不少 1950 年到 2010 年 AI 相关的老论文。 有意思的是,很多东西都没过时,基本问题并没变,也没有得出确切的答案。”

随后他又补充道:“虽然解决方案不断推陈出新,但就其根本局限性而言,今天跟 1997 年甚至是 1973 年相比,并没什么大的变化。”

此言一出,便又引发了国内外学者的广泛讨论和共鸣。

清华大学计算机系教授马少平和刘知远表达了一致的观点。 @马少平 THU “非常赞同,AI 的很多问题并没有解决。”

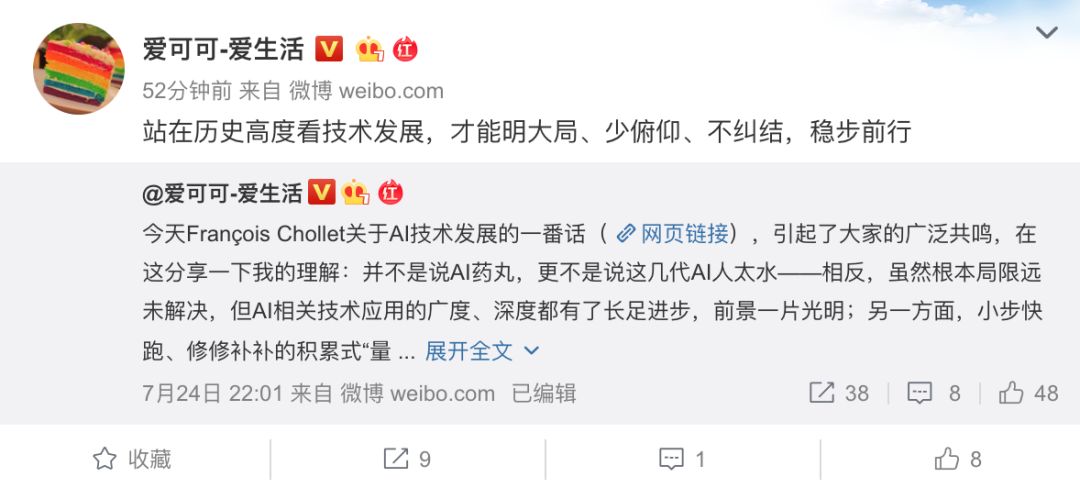

知名互联网资讯博主 @ 爱可可 - 爱生活也对此给出了自己的解读,他认为 Francois Chollet 的这番话并不是说 AI 药丸,更不是说这几代 AI 人太水。

“相反,虽然根本局限远未解决,但 AI 相关技术应用的广度、深度都有了长足进步,前景一片光明;另一方面,小步快跑、修修补补的积累式 “量变”,解决不了现有技术框架的本质问题,就像蒸汽机技术从诞生到不断进步、完善掀起伟大的工业变革,但其根本问题还需要新能源这样的新思路解决一样,当代 AI 研究者,不必拘泥于现有技术框架,应该多多思考基本问题,勇于探索新思路,争取早日达成 AI 技术质的飞跃。”

他随后也进一步表示 “站在历史高度看技术发展,才能明大局、少俯仰、不纠结,稳步前行”

对此,你的看法呢?

François Chollet 的那些网红语录

其实这已经不是 François Chollet 第一次语出惊人,此前他也发表过很多关于人工智能领域的看法,图灵君将其做了整理,供大家参考、思考。

“记住一点很重要,人工智能的最新进展都是在解决特定任务,而不是开发更通用的能力(如通用智能)。对这些任务的解决,并没体现出人类解决它们时用到的能力。在 “能执行一项任务” 和 “拥有一项能力” 之间,存在关键差别 —— 特别是泛化能力(无需进一步人工干预的情况下能够执行所有相关类型任务)和开放性(找出需要处理的新任务)—— 认为 “我用智力完成了 X(例如乘法和加法),因此,要是开发出一台能完成 X(例如乘法和加法)的机器,就表示它具有相同的智力。” ,这是一种非常拟人化的认知谬误。穿过玉米地的小道儿,和道路建设公司干的事,完全不可同日而语。”

“AI 难题不仅是计算机科学问题,更是数学、认知科学和哲学问题。”

“我们都很清楚这样一个事实:在线内容的可信度,往往与 “哗众” 程度成反比。标题党往往不可信;谎言可以完全无视事实约束、无限优化到让人欲罢不能。众包内容平台对 “吸睛”(参与) 的商业模式 (对 “头条” 内容大力推广、扩散、加强) 的依赖,直接损害了其信息的总体可信度。另一方面,依赖于提供 * 有用 * 信息 (如搜索) 的商业模式,往往会偏向于提供更可靠的信息。 ”

“看到深度学习能干这能干那,就认为 “是时候进军通用智能 (AGI) 了”,基本上等同于看了些魔术,就想 “哇,魔术是真的!是时候弄个魔术公司,用魔法创造无限价值”。魔术,和所有成功的深度学习方案一样,本质都是工程:只做一件事,在特定环境下,通过努力不断完善。 永远没有免费的午餐。”

“成千上万的深度学习论文,讲的其实是 “将特定任务的先验,硬编码进神经网络结构,相比缺少先验的情况,会更有效”,写出来往往是 “网络结构 XYZ 为 [通用任务类别] 提供了更优异的性能”。用更多、更高质量的数据进行训练,或在结构或预处理过程中注入任务信息,几乎总是能 “换” 来更好的性能。 然而,这并不代表所采用技术真正的泛化能力 (而这才是唯一的关键)。其实,很大一部分论文,都可以写成:“通过将更多任务信息注入到训练过程,我们在该特定任务上取得了更好的表现”。一个极端例子,是在样本符合特定 “模板” 的合成数据集 (如 BABI) 上,手动将模板硬编码到神经网络结构中。可以想见,当拟合目标就是解决方案模板时,用梯度下降拟合参数化模型,就能达到最佳效果。 显然,卷积网络就是如此 (其假设可推广到所有可视化数据,所以确实有效)”

“你不必全知全能,也不必各种 “正统” 背景加身 —— 有当然更好,甚至不必读博。只有一点是必要的:不断学习。保持好奇、坚持阅读,别因为太忙而 “顾不上” 学习,更别因为无知而狂妄自大。 ”

“工程师 (或研究人员) 用 X 解决 Y 时,九成是觉得 “对 X 有点了解”,而不是 “讲道理,这种场景用 X 解决是合适的”。

Derek Wise:至少对研究,还有第三种可能性,就是你真的了解且热爱 X 技术,因此到处找可能是 X 的好应用的问题,Y 是看似相当不错的一个。 (当然,并不意味着 X 是 Y 的 * 最佳 * 方案) ”

更多阅读:

华为 200 万年薪应届博士大起底!8 位天才少年学校专业详解