迄今为止,这一 NLP 开源基础技术平台在 GitHub 上共获得了 2.5k 的 Star 量,760 多个 Fork 数量,被包括清华大学、北京大学、CMU 等国内外众多大学及科研机构在内的 600 余家研究单位签署协议使用。

![]()

LTP 的全称为「Language Technology Platform」,是哈工大社会计算与信息检索研究中心(HIT-SCIR)历时多年研发的一整套高效、高精度的中文自然语言处理开源基础技术平台

。

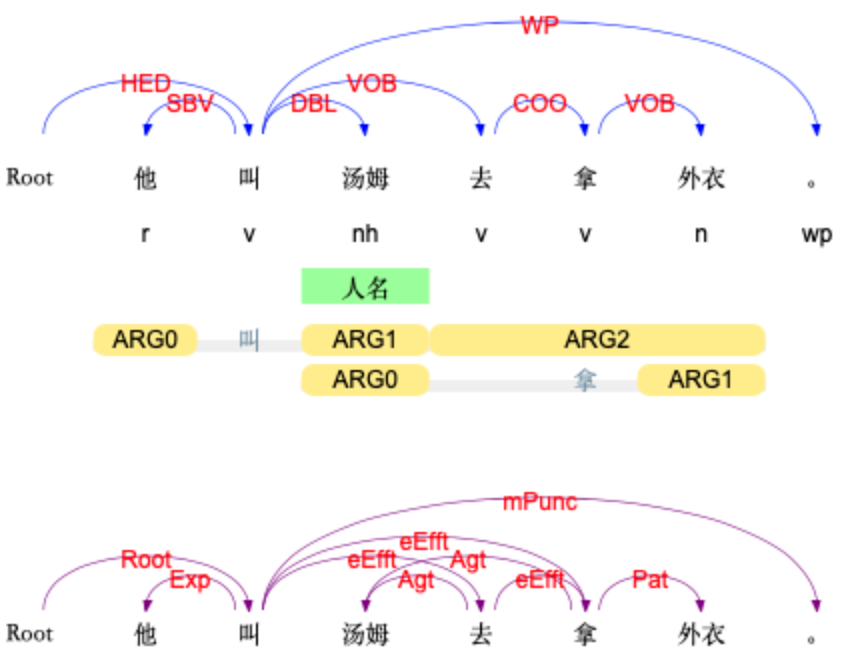

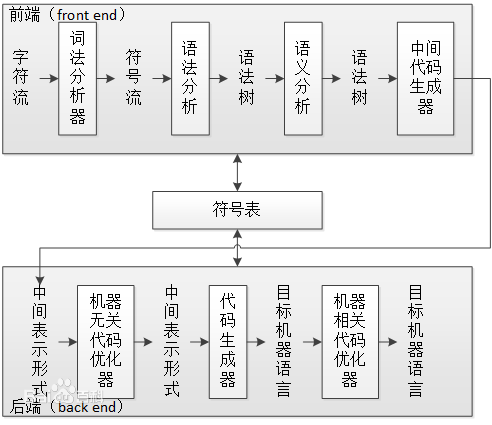

该平台集词法分析(分词、词性标注、命名实体识别)、句法分析(依存句法分析)和语义分析(语义角色标注、语义依存分析)等多项自然语言处理技术于一体。其中句法分析、语义分析等多项关键技术多次在 CoNLL 国际评测中获得了第 1 名。此外,平台还荣获了 2010 年中国中文信息学会科学技术一等奖、2016 年黑龙江省科技进步一等奖。

目前,

LTP 已被包括清华大学、北京大学、CMU 等国内外众多大学及科研机构在内的 600 余家研究单位签署协议使用,同时向百度、腾讯、华为、讯飞等多家知名公司收费授权

。

在 GitHub 上,这一项目的星标数量已经达到 2.5k,Fork 数 750 多个。有效解决了自然语言处理技术入行门槛高,准确率、效率偏低,缺少共享数据和程序资源,重复开发现象严重,结果可视化差,错误分析困难,较难真正支持各类应用研究等众多问题。

![]()

项目地址:https://github.com/HIT-SCIR/ltp

近日,哈工大 SCIR 本科生冯云龙等同学在

车万翔

教授指导下,对 LTP 进行了新一轮的全面升级,并推出了 LTP 4.0 版本。此次升级的主要改进为:

基于多任务学习框架进行统一学习,使得全部六项任务可以共享语义信息,达到了知识迁移的效果。既有效提升了系统的运行效率,又极大缩小了模型的占用空间

基于预训练模型进行统一的表示 ,有效提升了各项任务的准确率

基于教师退火模型蒸馏出单一的多任务模型,进一步提高了系统的准确率

基于 PyTorch 框架开发,提供了原生的 Python 调用接口,通过 pip 包管理系统一键安装,极大提高了系统的易用性。

下表列出了新旧版 LTP 在精度、效率和模型大小方面的对比:

![]()

为了模型的小巧易用,本次发布的版本基于哈工大讯飞联合实验室发布的中文 ELECTRA Small 预训练模型。后续将陆续发布基于不同预训练模型的版本,为使用的开发者提供更多准确率和效率平衡点的选择。

此处速度数据在人民日报命名实体测试数据上获得,速度计算方式均为所有任务顺序执行的结果。另外,语义角色标注与语义依存新旧版采用的语料不相同,因此无法直接比较(新版语义依存使用 SemEval 2016 语料,语义角色标注使用 CTB 语料)。

新版 LTP 采用原生 Python 实现,仅需运行 pip install ltp 即可安装使用。调用方式:

from ltp import LTP

ltp = LTP() # 默认自动下载并加载 Small 模型

segment, hidden = ltp.seg(["他叫汤姆去拿外衣。"])

pos = ltp.pos(hidden)

ner = ltp.ner(hidden)

srl = ltp.srl(hidden)

dep = ltp.dep(hidden)

sdp = ltp.sdp(hidden)

更多项目信息,可访问 http://ltp.ai/。

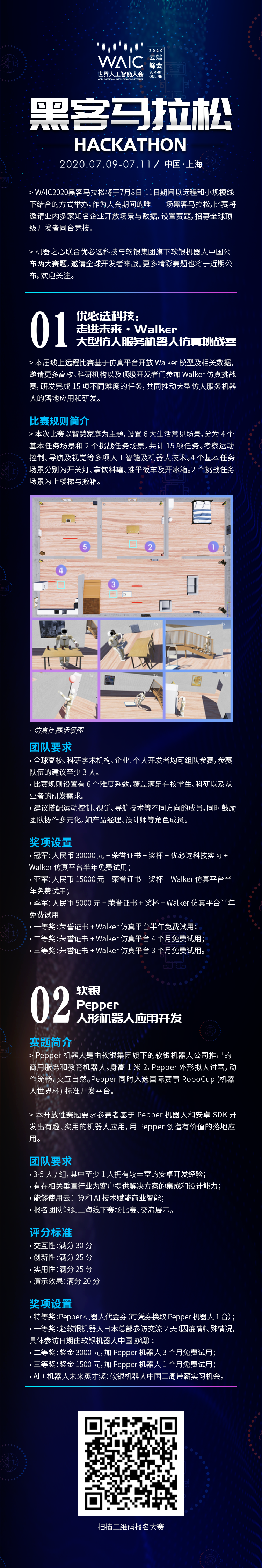

世界人工智能大会线上活动(WAIC)是由上海市政府打造的国际顶级人工智能会议。为进一步促进人工智能技术与产业相融合,推动开发者技术生态建设,WAIC 2020年黑客马拉松将于7月9日-11日期间举办。

机器之心联合优必选科技与软银机器人公布两大赛题,邀请全球开发者来战。更多精彩赛题将于近期公布,欢迎关注。

![]()