黑白照片修复亦可「如假包换」,华人学者提出实例感知着色新方法

选自arXiv

参与:Racoon、蛋酱、小舟

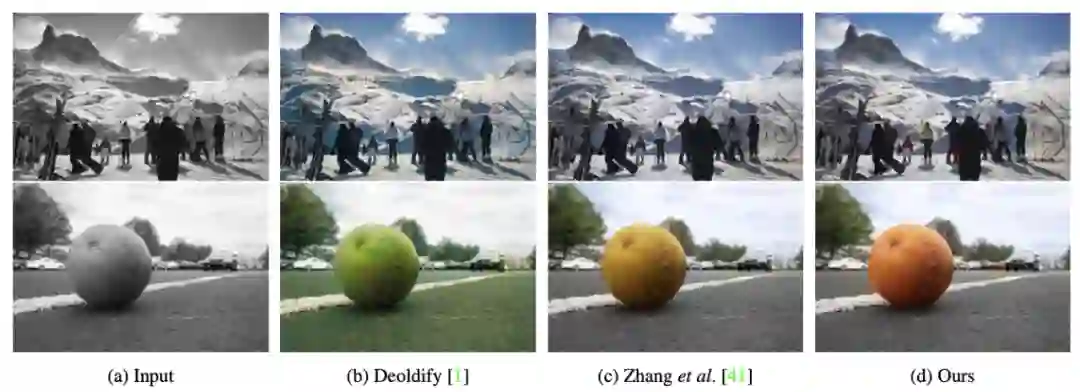

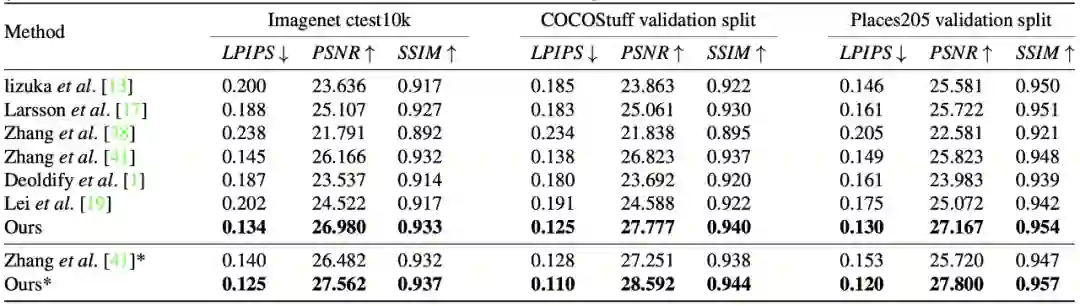

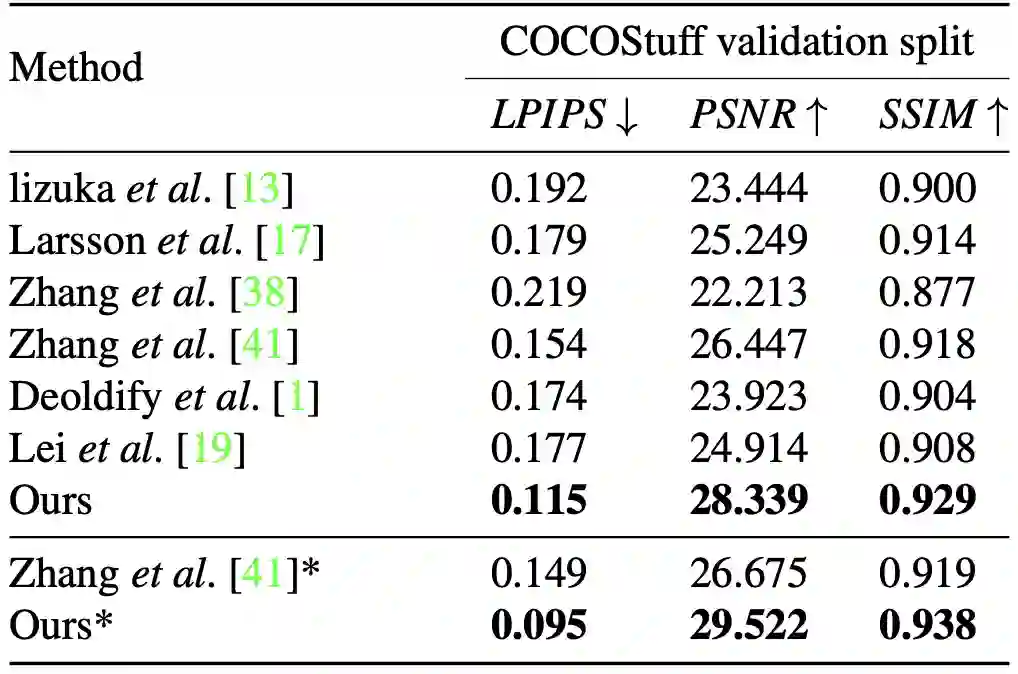

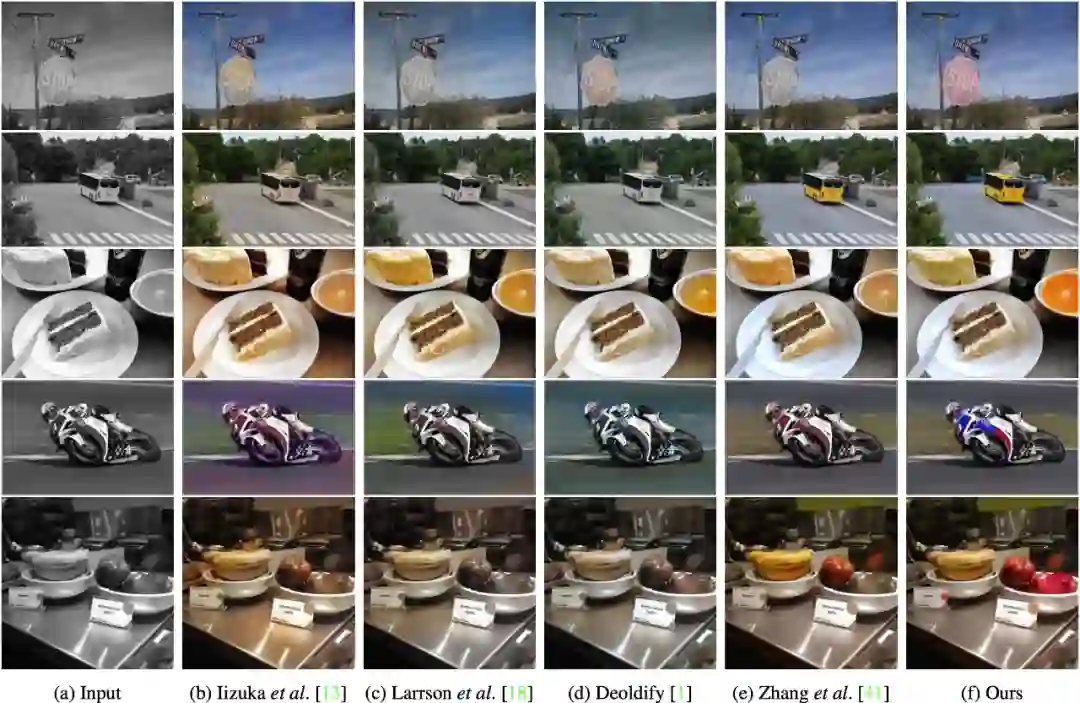

为黑白照片上色不难,但难在如何实现「以假乱真」。在这篇 CVPR 2020 论文中,研究者提出了一种全新的图像着色方法,通过检测出灰度图像中的不同目标,再对图像进行着色,使预测出的彩色图片更加接近真实色彩。

论文地址:https://arxiv.org/abs/2005.10825

GitHub 地址:https://github.com/ericsujw/InstColorization

Colab 地址:https://colab.research.google.com/github/ericsujw/InstColorization/blob/master/InstColorization.ipynb

作为输入,以端到端的方式预测其丢失的在 CIE L∗a∗b∗色彩空间中的两个色彩通道

作为输入,以端到端的方式预测其丢失的在 CIE L∗a∗b∗色彩空间中的两个色彩通道

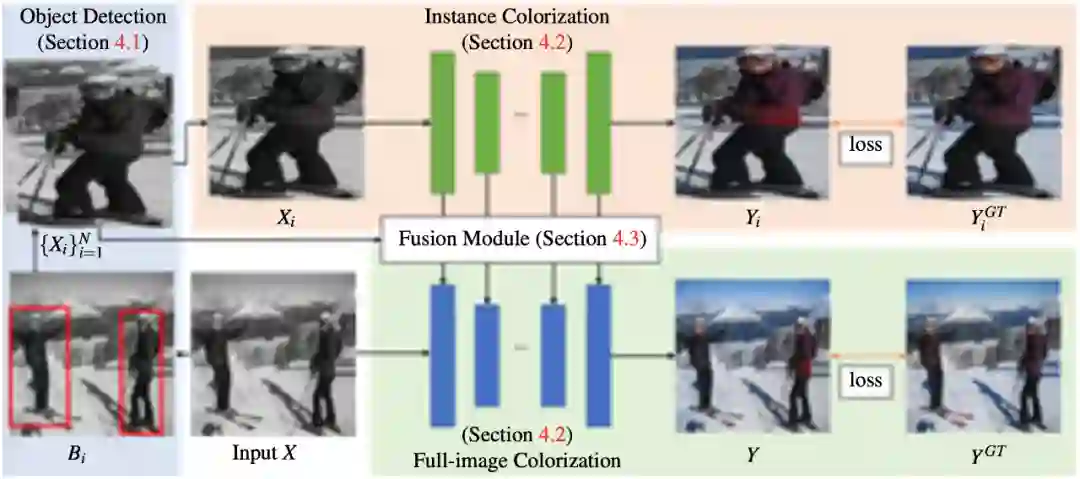

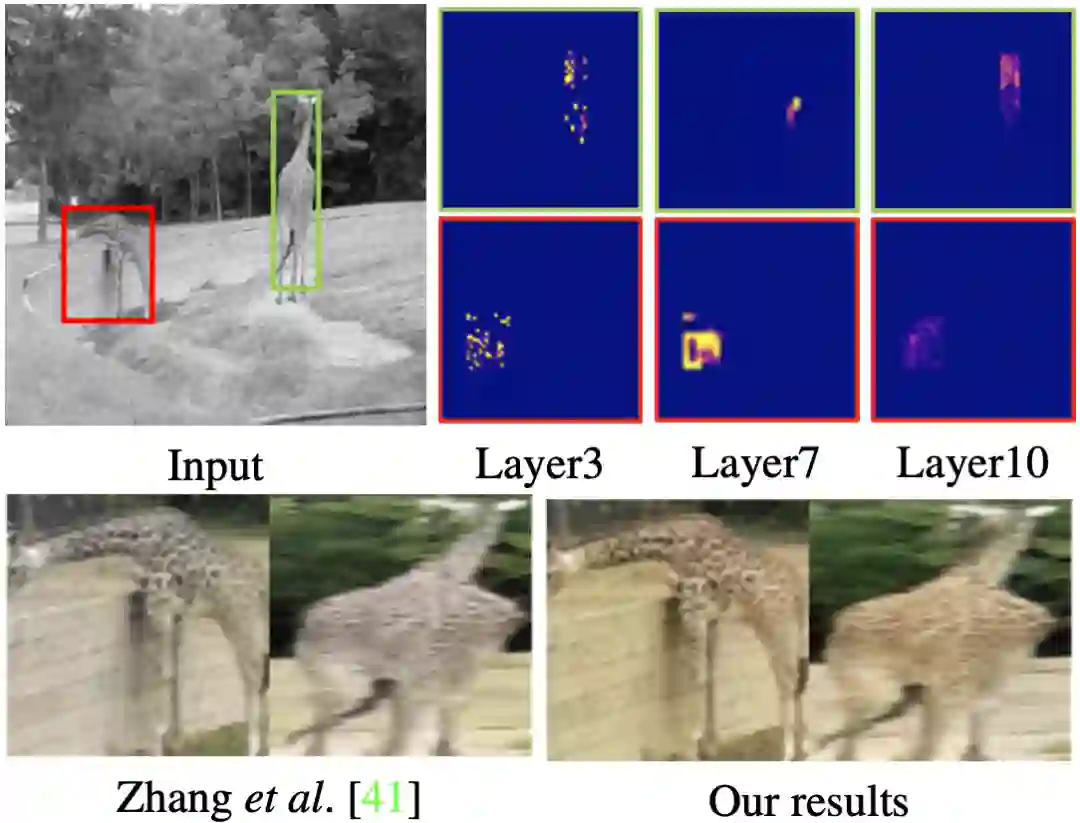

。使用检测到的边界框从原灰度图中裁剪出不同物体,将裁剪后的图像调整大小后产生一系列实例图像

。使用检测到的边界框从原灰度图中裁剪出不同物体,将裁剪后的图像调整大小后产生一系列实例图像

。接着,将每个实例图像 X_i 与灰度图像 X 分别输入到实例着色网络(instance colorization network)与全图着色网络(full-image colorization network)中。两个网络使用相同的结构,但网络权值各不相同。

。接着,将每个实例图像 X_i 与灰度图像 X 分别输入到实例着色网络(instance colorization network)与全图着色网络(full-image colorization network)中。两个网络使用相同的结构,但网络权值各不相同。

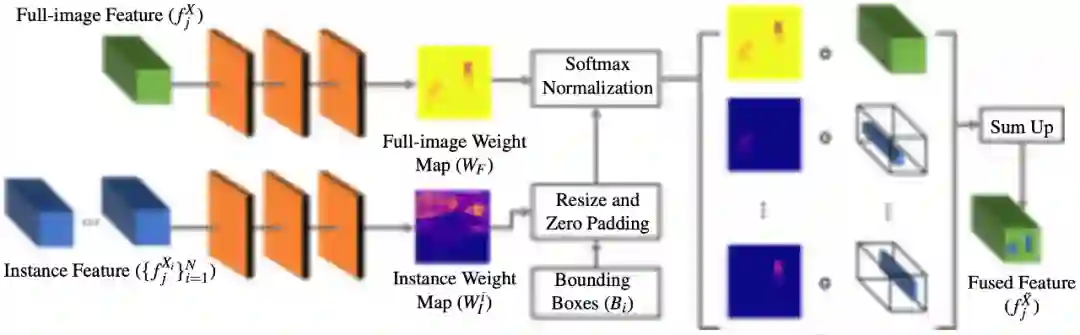

与全图特征 f^X_j 相融合。融合后的全图特征之后被输入下一层网络中。重复以上过程直到最后一层,并获得预测的彩色图像 Y。研究者首先训练了全图网络,之后训练实例网络,最后冻结以上两个网络来训练特征融合模块。

与全图特征 f^X_j 相融合。融合后的全图特征之后被输入下一层网络中。重复以上过程直到最后一层,并获得预测的彩色图像 Y。研究者首先训练了全图网络,之后训练实例网络,最后冻结以上两个网络来训练特征融合模块。

登录查看更多

相关内容

Arxiv

3+阅读 · 2018年8月2日