不是所有问题都适合用神经网络去搞!

文 | YukiRain@知乎

不是所有问题都适合用神经网络预测,YukiRain总结了以下几种不适合用神经网络做预测的场景:

-

小样本情况,无论是低维还是高维,不如SVM和贝叶斯模型 -

低维数据,大样本量,不如各种ensemble类算法 -

以上主要问题在于过拟合,传统机器学习算法大部分对过拟合都有比较合理的解决方案,而神经网络基本只靠heuristic。dropout虽然在Bayesian deep learning里面有不错的意义,但只依靠dropout来做inference实践上未免有点单薄 -

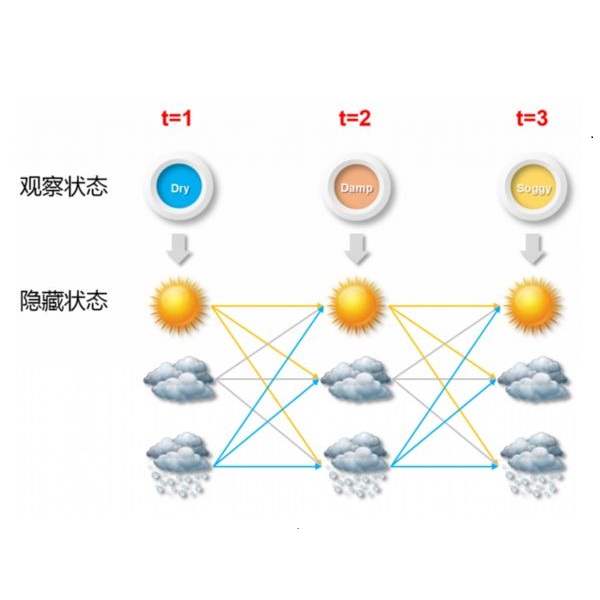

低维时序数据,小样本量,大部分情况下比不过HMM,ARIMA一类的,比如语音识别里至今CNN没有比HMM效果好多少 -

三维的图像数据,神经网络参数量太大,虽然有不少文章voxel based cnn,我目前还没有复现过效果比较好的模型 -

上面的三维数据,有一种做法是多视角赤极投影,然后用LSTM去学,然而实数空间不存在一个SO(3)群到S2群的连续映射,因为二者不同构,所以即使你做出实验效果,也有可能是某种过拟合的结果 -

神经网络容易受到对抗样本的攻击,攻击很容易,防御十分困难,目前为止的大部分防御措施都被指出存在漏洞 -

不规则数据,比如说graph signal或者point cloud,虽然有不少文章都尝试graph signal上做卷积,但是目前为止,应用在复杂数据集上效果欠佳,而且数学研究者的工作与CS研究者的工作还有着巨大的隔阂 -

有一些文章用神经网络做图像去噪,这类的文章,凡声称自己是“盲”去噪,不加任何正则项先验项的,有一大部分连自己到底想做到什么样的目标都说不清。

后台回复关键词【入群】

加入卖萌屋NLP/IR/Rec与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!

![]()

登录查看更多

相关内容

人工神经网络(Artificial Neural Network,即ANN ),是20世纪80 年代以来人工智能领域兴起的研究热点。它从信息处理角度对人脑神经元网络进行抽象, 建立某种简单模型,按不同的连接方式组成不同的网络。在工程与学术界也常直接简称为神经网络或类神经网络。神经网络是一种运算模型,由大量的节点(或称神经元)之间相互联接构成。每个节点代表一种特定的输出函数,称为激励函数(activation function)。每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重,这相当于人工神经网络的记忆。网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

最近十多年来,人工神经网络的研究工作不断深入,已经取得了很大的进展,其在模式识别、智能机器人、自动控制、预测估计、生物、医学、经济等领域已成功地解决了许多现代计算机难以解决的实际问题,表现出了良好的智能特性。

Arxiv

0+阅读 · 2022年4月19日

Arxiv

0+阅读 · 2022年4月15日

后台回复关键词【

后台回复关键词【