语音云平台为什么要做全栈?

点击上方“黑智”,选择“置顶公众号”

黑智专注AI落地,探讨AI商业价值

更多创业内容请访问http://www.iheima.com/scope/79

(点击图片参加2019人工智能产业独角兽评选)

本文大概

5000

字

读完共需

10

分钟

导读:2012年,我们曾经很天真地认为只要我们把语音识别做好就可以了。很多人也跟我讲,你们就专注去做语音识别,把语音识别做到业界No.1。如果当时我们听了这个建议,云知声现在已经挂了。

文:文姜

语音技术是巨头开启的赛道。

创业公司看到机会,开始投身于此,比如云知声。2009年、2010年,苹果、Google开始在语音上发力,并先后推出了产品Siri和Google Now。

2011年,云知声董事长兼CTO梁家恩、COO康恒两人认真研究过Siri后,发现凭借自己的技术能力,可以做出比Siri和Google Now更好的产品,而且更具中文优势。再加上政府、金融对语音需求日益壮大。他们便谋划创业。这是云知声创立之前的故事。

今年3月底,梁家恩站在台上感慨,“成立七年,到今天为止,云知声才有底气说要开一场真正好的发布会。”据悉,这是云知声第一次举办了open day,向外界展示自身的技术和在产业里的实践。

他的话道出在巨头赛道里创业的艰难与紧迫,窗口期有限,每一个抉择都事关生死。云知声CEO黄伟在一次分享中提到,“在市场里,创业公司要么占一个垂直领域,要么在技术链条上下苦工。前者,或许你的技术宽度不够宽,但是在场景里面扎得足够深,你可以活。后者,十八般武艺你都会,你可能活得更久一点。”

以下是云知声的技术探索,也是7年学习 “十八般武艺”的阶段性展示。7年,云知声从语音识别技术切入,拓展到语义、对话,从对话拓展到针对具体场景的服务,从语言识别的单一技术到构建了全栈的技术闭环。

阿法狗战胜李世石后,AI概念被炒得火热。所有不被人们熟悉、理解的计算技术,现在被通被称为AI。

梁家恩认为,“真AI和伪AI公司不仅在技术实力上的差距,还体现在对产业问题的态度上。AI是一种技术,假如它不跟产业结合的话,是一种纯粹的炫技。

梁家恩在云知声open day演讲

在产业里,还有太多的问题没有得到有效解决,我们在技术端还有非常大的挑战 。AI重要的是解决产业的实际问题,只有把利用AI技术解决掉问题,我们才说这个产业的春天真正的到来,否则的话就是一个泡沫的阶段。”

如何利用技术切入产业场景上,云知声给出了两个关键词,第一是全栈,第二是硬核。“全栈让我们关注用户价值和应用问题,硬核帮助我们破解产业难题。”

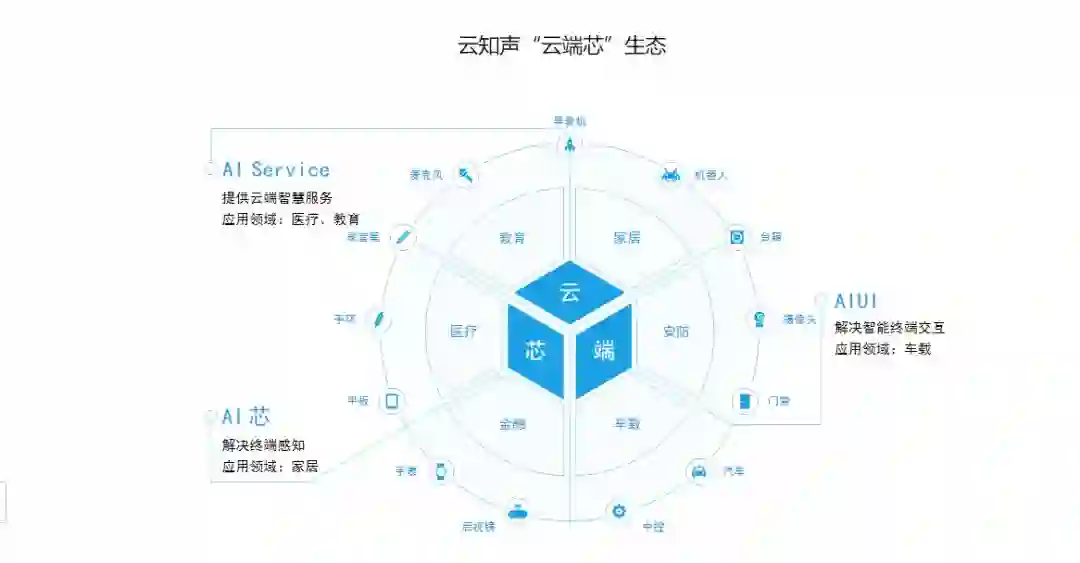

“全栈”也意味着,掌握语音识别全链条的技术,从前端、后端到芯片端。“打通一个完整的产业闭环,把感知和表达的技术,真正跟认知结合,把底层打通。”

做语音云平台,也必然要求云知声要做全栈的技术。语言平台的核心技术链条很长,它包括麦克风阵列、语音识别、自然语言处理、语音合成等,但行业的产品大多需要全链条的技术。

技术链条长就意味着当平台某一项技术不能满足开发者的需求时,开发者需要单独开发全链条技术。

例如说,某个用户说一句话,怎么去除噪音,怎么识别、理解这句话,理解后又如何做聚合,这是一个闭环。用户用的是整个交互链条,如果这个闭环缺失了某一部分是需要开发者自己单独开发的,因此,开发者对平台选择显得格外谨慎。

云知声是从语音交互起家的,迄今为止云知声的技术图谱已经超过了语音能力范围,包括感知和认知和表达能力,视觉和听觉、降噪和语音识别、对话管理系统、行业智能系统、人脸和语音合成。

全栈意味着技术全,能够形成闭环;硬核技术才是全栈的基础,没有硬核的技术,产业的问题还是不能解决。

截止到目前,云知声的硬核 AI 技术覆盖了语音感知与表达、语言与知识计算、AIoT 芯片落地,以及超算平台与图像、翻译拓展等多个维度。

全栈和硬核是云知声过去七年打造的技术闭环。在过去七年,云知声陆续在教育、医疗、家居等领域落地,这也说明了行业的需求是真实存在的,问题在于AI企业是否能找到自己的核心场景,用技术解决行业问题。

这套全栈技术闭环的起点是语音识别,是云知声的核心技术。

2012年9月,云知声发布了基于传统统计模型的第一代语音识别引擎,准确率为85%。同年12月,云知声又上线了业内第一家搭载DNN(深度神经网络)的云平台,将准确率提升到91%。

在语音识别技术的基础上,要实现物联网语言交互入口的功能,语言识别技术是不够的,语音交互才是未来,而人机对话的交互系统则是更难的技术进阶。

云知声AI labs资深专家刘升平说,“我们预测在未来,机器的智能水平能够超过人类。但现状是,现在的人工智能,我们会更乐意称呼其为人工智障,云知声不希望做成人工智障的批发制造者”

刘升平认为,目前人机对话系统的问题主要有三个:

1、每次交互都要唤醒:反人类

2、只理解模板化单句:对语境无感

3、只会闲聊,知识贫乏:没文化

云知声从2013年开始做语音交互系统,对于这3个问题,云知声提出了流式对话、语用计算和知性会话的解决方案。

流式对话

“在315晚会上,报道上说有很多机器人打骚扰电话,那么怎么样检测它是不是机器人打电话呢,只要不能打断它的,都是机器人。”刘升平介绍道。

云知声提出流式对话特征是,免唤醒进行多次交互,且用户能够随时打断。

实现流式对话需要机器能够进行智能断句,需要机器能够识别主人的声音,并且需要机器对于语音的定位和理解。

刘升平认为,只有对声音的进行特征选取,利用语言和语义的深度结合,才能实现流式对话。

语用计算

语用计算意味着在理解一句话的含义时,从语用的角度理解,而不是直接从语境的角度理解,要结合更丰富的语义,去真实的理解这句话真正的含义。

举例来说,当人说的话语是“太冷了”,它的语义即字面意思是“温度有点低”,但从语用的角度即在特定语境中所传递的会话意义可以是,“把空调温度调高两度?打开暖气?关闭门窗?来一个温暖的拥抱?”

语用是要将语义和语境结合。语境指人们用语言进行交际时的具体环境,包括语言语境和非语言语境。在人机对话下的语境可分为物理语境、言语语境、知识语境。

“我们说的话是冰山上面的一角,理解一句话的含义,不能只看当前信息的输入,而是要看冰山下面各种各样的语境输入。”刘升平说。

知性会话

知性会话的基本思想就是把知识图谱用到知性对话里面去,通过实体链接技术,融合多源知识,实现跨领域,跨交互形式的多轮对话,让知识图谱全程的参与整个对话过程,包括聊天、问答,都由知识图谱来支撑,让机器表现的像一个专家。

云知声希望把人机对话系统做的越来越聪明,越来越接近人类的水平,云知声下一步的目标是多模态的互动和个性化的体验。

刘升平透露,云知声近期的目标是在垂直领域特定场景下,通过图灵测试。

如果说后端的语音交互让机器能够听懂人类、读懂人类,实现真正的无障碍沟通,那么前端的信号处理,则是让机器准确清晰的接收到人类发出的信号。

2011年发生了两件事,一个是微软把DNN,用于ASR;另外一个是苹果把DNN用于Siri。一个是语音识别的突破,另一个是产品的应用,它让广大用户知道语音识别是什么。亚马逊在2014年推出了智能音箱Echo,搭载了7个麦克风,这是从近场切换到远场的分水岭。

此后,国外、国内大公司都在做智能音箱,语音交互成了新的流量入口。云知声从近场识别起步,但在物联网时代,语言识别落地的场景决定了远场的语言识别成了云知声必须突破的技术。

云知声从近场到远场的技术突破都碰到了哪些问题?

近场,是指在0.5米的位置,安静条件下进行录制。云知声刚开始做远场时,云知声在不同的场景之下,不同的干扰之下,录制了对应的近场和远场,但无论是唤醒还是识别,都有非常大的下降,近场到远场,从可用状态下降到不可用状态。

将近场应用变成远场应用,它的关键点就是前端信号处理,把干扰噪音去掉,留下干净的声音,送到机器,保证机器识别。

解决远场语音识别的关键点——前端信号处理,前端信号处理需要解决三个问题,回声、混响、噪声。云知声在面对这三个问题时,利用回声消除技术、混响抑制技术、空域滤波技术,使得远场从不可用变为可用。

谈到前端信号处理的未来,云知声AI labs的专家关海欣认为:第一,DSP技术和DL技术需要融合。第二,从单体麦克风到分布式的前端麦克风。

2015年,在做终端批量产品时,云知声发现用通用芯片做AI的规模化的成本非常高,只能用在相对高端的产品上,使用通用芯片去落地低端、大规模的产品是不可能的。

云知声副总裁李霄寒说,“我们之所以需要做AI芯片,是因为我们觉得算力和成本是有矛盾的,在原有的架构下是不可化解的。唯一的解决办法就是AI芯片。”

人工智能的每一阶段都和芯片有着紧密的联系。

1956年的达特茅斯会议是人工智能元年,芯片的计算能力限制了人工智能的发展;20世纪的80年代中期到90年代,CPU的发展推动了对算法实践的产生了巨大影响;2009年前后,GPU被用来做深度学习算法训练;2016年阿尔法狗采用TPU架构用人工智能芯片做数据的训练。

每次芯片计算能力的进步,都推动着人工智能水平的提升。

李霄寒认为“在未来AI芯片可以分成两类,一类是服务端芯片,经过大规模的数据处理做训练,用来形成AI模型的,这部分以寒武纪为代表;另一类是云知声正在做的边缘侧芯片。”

云知声认为边缘侧的AI芯片在物联网人工智能落地具有核心的位置。

物联网时代是建立在云计算上的,云平台相当于人的大脑,在云端集成了人工智能的能力,是物联网的神经中枢。那么终端的设备,该如何去承接云端人工智能的能力?

云端的能力跟终端的用户连接需要一个载体。李霄寒认为这个载体过去是手机,但在未来的物联网时代,这个载体可能是开关、插座或者音箱,所有的设备都有可能,对于这些设备来说,承接云端的能力的方案就是AI芯片。

云知声在2015年我们正式启动研发AI芯片。“我们认为这条路是对的,这是一个趋势的问题,而不是战略的问题。”

那么,AI芯片与传统的CPU和SOC,在设计上有什么不同呢?

云知声在AI芯片的实践中发现,AI芯片和传统芯片的区别和挑战分为四方面。

1、端侧AI芯片更要求基于场景。

传统的芯片面向的是通用场景,设计者并不知道芯片上会运行什么应用,有可能是游戏,有可能是图像处理软件,不需要考虑不同的需求,把芯片设计的足够强大就可以了。

但物联网时代端侧的AI芯片需要考虑场景,不同场景下的芯片需求是不一样的。例如在电视上的芯片和风扇上用的芯片不一样,电视的芯片要比风扇的芯片更加强大,需要视频解析。

李霄寒认为在物联网的场景下,云知声要基于场景,针对具体的应用,着眼AI算法、芯片的应用,去设计新的芯片。

2、冯诺依曼内存墙限制了运算效率

在物联网时代,处理AI算法会有巨大的需求,芯片需要处理的数据非常多。传统的冯诺依曼内存墙的芯片结构限制了系统的运算效率。拉紧计算单位和存储单位的距离,让它们尽可能的接近是业内的共识。

李霄寒认为这样还不够,还需要让这个墙变的更加的矮。

3、低功耗的需求。

做芯片的人实际上是在功耗、性能、面积三个里面取一个平衡。传统芯片在服务端有低功耗的需求,在边缘侧低功耗需求只会更加旺盛。

掌握了算法和应用场景之后,云知声在面对低功耗需求时,在芯片设计上做了一个考量。在传统的芯片设计时,一般会更加考虑更灵活的控制功耗,当芯片在工作的时候全力以赴的打开,不工作的时候就关闭。但是在AI物联网时代下,先要从应用层面考虑。

李霄寒举例,在AI芯片上,可以设计一个基本单元,用2%的算力做动静检测,没有动静的,把98%的功能关掉;当芯片认为有动静之后,再做活体检测,通过初步的判断,仍有90%的芯片面积是休眠的;接下来再检测声音是不是唤醒词,这个需要20%的算力,只有用户真正在说唤醒词,整个芯片才会激活。

这是云知声熟悉场景、算法后,对芯片设计的影响。

4、安全

安全是一个永恒的话题。云知声考虑的安全包含两个方面。

一是作为算法的提供商,云知声不希望其软件放在芯片上卖出后,被人拷贝,因此云知声的芯片代码会做加密处理,。二是代码的完整性,在物联网时代,所有设备都可以联网,意味着在一个开放的环境下任何人都可以访问你的芯片。

这四点是云知声在做芯片时的思考。

创业公司到底是单点突破还是越做越多?云知声选择了后者。

云知声的全栈+硬核的技术闭环实际上是在一步步的落地实践中发展而来的。

2012年成立,云知声从语音识别赛道切入,沿着语音识别技术做进一步“语言交互”;在落地到具体场景时,发现近场识别不够,便开发远场识别技术;在落地场景下,发现通用芯片不能满足AIoT的落地需求,便自主研制AI芯片。

“2012年,我们曾经很天真地认为只要我们把语音识别做好就可以了。很多人也跟我讲,你们就专注去做语音识别,把语音识别做到业界No.1。如果当时我们听了这个建议,云知声现在已经挂了。”黄伟说。

*本文系黑智原创,作者文姜。黑智,关注AI落地与AI商业价值。

黑智专访

驭势科技 | 搜狗 王小川 | 云知声 黄伟 | 格灵深瞳 赵勇 |出门问问李志飞Roboteam Yossi Wolf | 小鱼在家 宋晨枫 | 奇点机智 林德康 | Rokid Misa | 瑞为智能 詹东晖 | 极限元智能科技 雷臻 | 乂学教育 栗浩洋 | 暴风科技 冯鑫 | 销售易 史彦泽 | 普强信息 何国涛 | 真机智能 刘智勇 | 纳人 姜海峰 | 众趣科技 高翔 | 深之蓝 魏建仓 | 扩博智能 严治庆 | 视见医疗 王峰 | 拍拍赚科技 汤劲武 | 图森未来 陈默 | 智齿客服 徐懿 | 甘来 曹文斌 | ROOBO 刘颖博 | 银河水滴 黄永祯 | 知盛数据 王晓梅 | 所问数据 颜鹏 | 趣链 李伟 |云脑科技 张本宇 | 品友互动 黄晓南 | 擎朗智能 李通 | 百分点 苏萌 | 飞步科技 何晓飞 | 物灵科技 顾嘉唯 | 臻迪科技 郑卫锋 | 极米科技 钟波 | 蓝箭航天 张昌武 | Roadstar.ai 佟显乔 | e换电 黄嘉曦 | 智芯原动 崔凯 | 悉见科技 刘洋 | 宽凳科技 刘骏 | 创新奇智 徐辉 | 狮桥集团 万钧 | 亿方云 程远 | 阅面科技 赵京雷 | 深兰科技 陈海波 | 高仙机器人 程昊天 |飞步科技 何晓飞 | 京东 宋春正 | 华云数据 许广彬 | 澎思科技 马原

投资人说

云启资本 黄榆镔 | 松禾远望资本 程浩 | 英诺天使基金 李竹 | 线性资本 王淮 | 九合创投 王啸 | 纪源资本 肖鸿达 | 戈壁创投 徐晨 | 百度风投 刘维 | 明势资本 黄明明 | 蓝图创投 候东 | 蓝驰创投 陈维广| 隐山资本 董中浪